Nvidia DGX Spark im Test: Nvidia DGX Spark im KI-Einsatz

3/6KI-Anforderungen und Benchmarking

ComputerBase entwickelt keine KI-Anwendungen, eigene Praxiserfahrungen, um DGX Spark auf zielgerichtet auf die Probe zu stellen, existieren also nicht. Doch selbst wenn, haben die letzten Wochen gezeigt, dass selbst unter „KI-Experten“ ganz unterschiedliche Meinungen zu DGX Spark vertreten werden – auch und gerade wenn es um den Vergleich mit AMD Strix Halo alias Ryzen AI Max 300 oder dem Mac Studio geht.

Denn selten wie in diesem Fall lautet die Antwort auf die Frage, was DGX Spark leistet und ob sich der Griff zum „KI-Supercomputer“ lohnt: Das kommt ganz darauf an. Folgende Aspekte sind im Zuge der Evaluierung zu bedenken:

- Welche KI-Anwendung wird gefahren?

- Auf welcher Plattform wird sie gefahren?

- In welchem Datenformat ist das Modell quantifiziert?

- Wie ist das Modell konfiguriert (Context Length)?

- Welche Aufgaben werden an das Modell gestellt (Token Size)?

- Und gibt es nur eine Instanz, oder mehrere parallel?

Zum letzten Aspekt hat erst in dieser Woche Alex Ziskind, der DGX Spark zuletzt eher kritisch sah, einen weiteren Test veröffentlicht, indem DGX Spark bei Dutzenden parallelen Zugriffen auf ein Large Language Model die Konkurrenz in den Schatten stellen konnte. Aber was wählt der, der beide Anwendungsfälle nutzt?

I reran the DGX Spark tests and the tables have turned. This is how it's supposed to be used (NEW VIDEO linked below) pic.twitter.com/895c8a54I6

— Alex Ziskind (@digitalix) January 20, 2026

Die Leistung von DGX Spark in LLMs

Auch ComputerBase hat DGX Spark in Form des Asus Ascent GX10 mit Strix Halo in Form des (immer noch instabilen) Beeling GTR9 Pro verglichen – allerdings nur in LM Studio mit drei verschiedenen LLMs. Dabei gilt es zusätzlich zu bedenken: Die Ergebnisse schwanken durchaus von Lauf zu Lauf. Es galt zwei Aufgaben zu bewältigen:

Die Leistung mit einem kurzen Prompt

Die erste an das jeweilige Modell gestellte Aufgabe war ein kompakter Prompt, alle drei Modelle konnten die Aufgabe mit der Standard Context Length annehmen:

Wie viele Lego-Steine (2x4 noppen) benötigt es um den Eifelturm in Originalgröße nachzubauen? Bitte beachte dabei, dass auch nur die Struktur, die im Original aus Metall vorliegt, nachgebaut werden soll und nicht das theoretische Gesamtvolumen.

Bei den Tokens per Second liegt einmal Strix Halo deutlich vorne, zweimal ist es knapp. Anders rum kann DGX Spark einmal deutlich schneller den ersten Token liefern, die anderen beiden Male geht es knapper zu.

Die Leistung mit einem langen Prompt

Der zweite Prompt war länger, llama 3.3 wollte ihn erst nach manueller Anpassung der Context Length entgegennehmen, was den Speicherbedarf des Modelles auf 70 GB anhob – auf DGX Spark kein Problem. Dem Modell mitgegeben wurde das Gedicht „Das Lied von der Glocke“ von Friedrich Schiller mit anschließender Aufgabe:

Kannst du mir das Gedicht kompakt in einem neuen Gedicht mit nur 20 Versen zusammenfassen?

In diesem Fall kann sich DGX Spark nicht bei den Tokens per Second, was eher ein Maß für die Speicherbandbreite darstellt, gegen Strix Halo behaupten, doch aber deutlich bei der Time to First Token von Strix Halo absetzen.

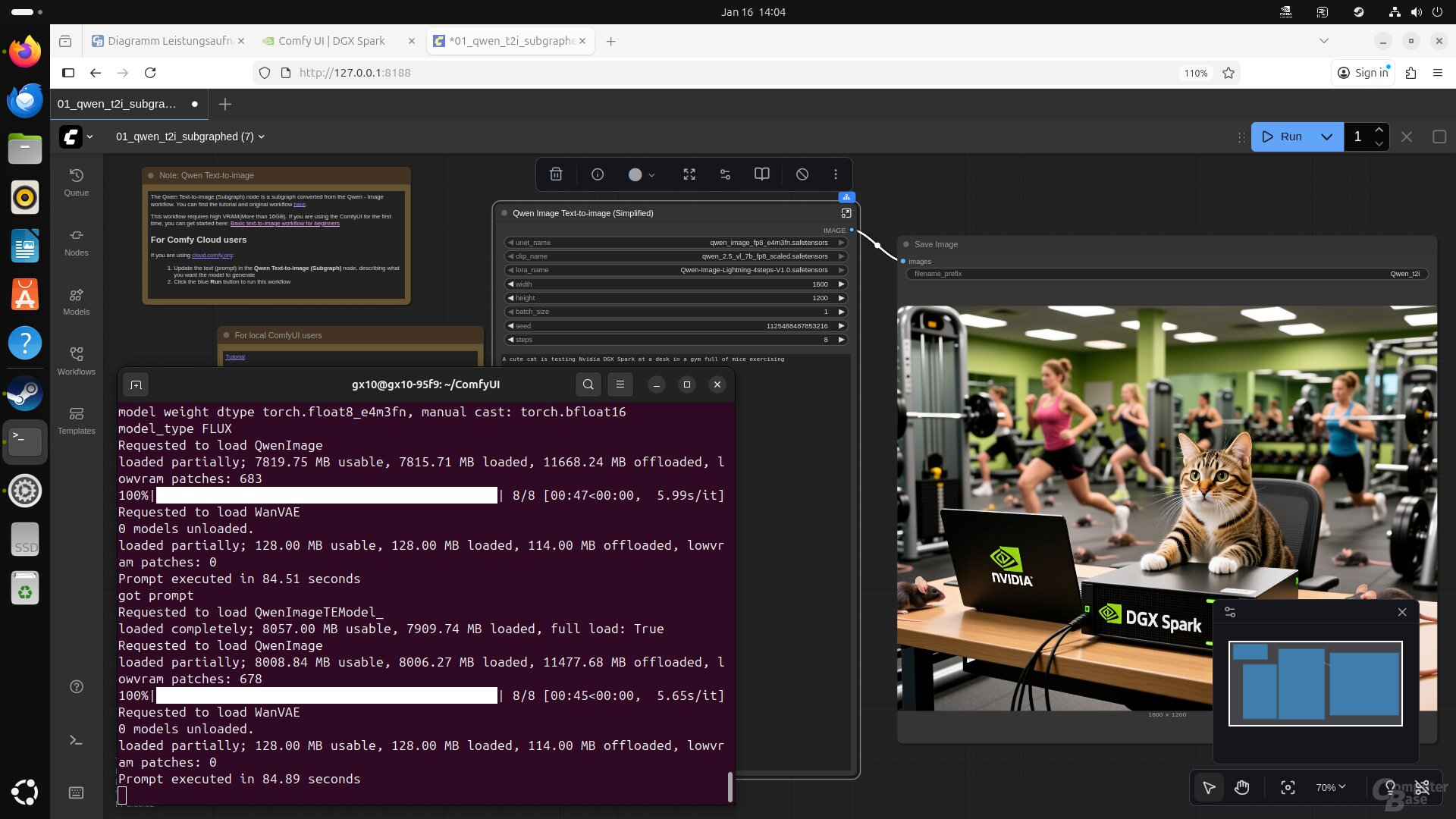

Genutzt hat ComputerBase den DGX Spark auch zur Bildgenerierung mittels ComfyUI, dessen Installation als Playbook vorliegt. Der Vergleich auf Strix Halo wurde in diesem Fall nicht gezogen, die Installation und Optimierung auf dieser Plattform ist derzeit noch mit viel Aufwand verbunden.

Interessenten sollten testen

So oder so sind die eigenen Anforderungen an ein System, auf dem KI entwickelt wird, derart divers, dass insbesondere das Angebot von Asus, den Ascent GX10 drei Tage kostenlos per Remote-Access testen zu können, für viele Interessenten respektive „Bestands-Entwickler“ ein sehr verlockendes sein dürfte. Denn so lassen sich ganz konkret die eigenen beziehungsweise die in Zukunft auf DGX Spark geplanten Workflows schon vor dem Kauf auf ihre Performance testen.