Hi Leute,

ich bin seit kurzem dabei, mein Local Streaming Setup zum Spielen einzurichten. Fürs Erste läuft es ganz gut, allerdings habe ich immer wieder beim Spielen das Problem, dass sich das Spiel (nicht nur die Steuerung) leicht "verwaschen" anfühlt. Es scheint sich hier nicht nur um Input Lag zu handeln. Mehr Details weiter unten. Hier erst einmal mein Setup/Einstellungen:

A. Setup:

B. Einstellungen:

C. Beobachtungen / Problem:

Problembeschreibung:

Ich spiele Horizon Forbidden West auf sehr hohen Einstellungen. Das Spiel fühlt sich teils "verwaschen" an, obwohl es konstant 90+ Frames läuft. Es ist hierbei nicht unbedingt von Input Lag die Rede, sondern das Problem besteht auch, wenn ich die Spielfigur z. B. durchgehend bewege oder die Kamera durchgehend drehe. Es wirkt dabei , als liefe das Spiel minimal in Zeitlupe. Dabei kommt aber nicht zu Rucklern. Das Problem tritt zu etwa 20% der Spielzeit auf. Es wurde bereits mit mehreren Einstellungen am Host/Client experimentiert. Unter den genannten (siehe oben) läuft derzeit am besten.

Beobachtung 1: PC-Test

Das Spiel läuft direkt am PC absolut flüssig. Das Problem tritt dort nicht auf.

Beobachtung 2: Performance-Overlay

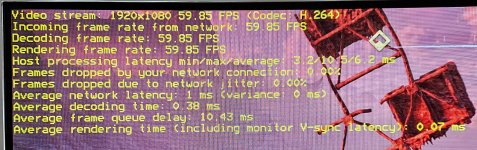

Die Daten zeigen, dass der Stream SUPER stabil läuft. (siehe Anhang). Ich habe das Overlay etwa 1,5 Std. beim Spielen im Auge behalten und die Daten blieben absolut stabil. Am Ende gab es keine verlorenen Frames (weder durch Jitter, noch Connection). Der "Frame queue delay" variierte befand sich meist zwischen 5ms und 10ms mit Spitzen um 0ms und 20ms. Ein Zusammenhang mit dem Auftreten des Problems konnte jedoch absolut nicht festgestellt werden. Alle anderen Werte liefen konstant wie abgebildet.

Beobachtung 3: Anderes Spiel

Destiny 2 lief ebenfalls auf höchsten Einstellungen in 1080p absolut flüssig. Kein schwammiges Erlebnis (auch nicht temporär). Man muss hier jedoch sagen, dass das Spiel auch noch einmal mit deutlich mehr FPS läuft (etwa 200 FPS im Schnitt).

Beobachtung 4: Steam-Overlay (HOST)

Das Overlay zeigte, dass keine der Host-Komponenten am Limit ist (siehe Anhang).

(Anmerkung: Das Bild stammt nach einer Videosequenz und ich hab etwas an den Settings rumgespielt, deshalb sind die Frames hier im Low bei 87. Im normalen Spielbetrieb läuft es, wie beschrieben, mit 90-140 Frames. Am PC ebenfalls absolut flüssig, keine Probleme.)

D. Zusammenfassung:

Fragen:

Horizon Forbidden West ist ein ziemlich forderndes Grafikspiel auf hohen Einstellungen. Kann es sein, dass die GPU meines Client-PCs (Core i5‑7400T, integriert) einfach überfordert ist. Die Dekodierungszeit scheint in Ordnung zu sein. Hakt es vielleicht trotzdem an der grafischen Wiedergabe? Woran könnte es noch liegen?

Würde mich über Hilfe SEHR freuen!

Lieben Dank im Voraus!

Peter

ich bin seit kurzem dabei, mein Local Streaming Setup zum Spielen einzurichten. Fürs Erste läuft es ganz gut, allerdings habe ich immer wieder beim Spielen das Problem, dass sich das Spiel (nicht nur die Steuerung) leicht "verwaschen" anfühlt. Es scheint sich hier nicht nur um Input Lag zu handeln. Mehr Details weiter unten. Hier erst einmal mein Setup/Einstellungen:

A. Setup:

Host:

- Mainboard: MSI B550 A-Pro

- Prozessor: AMD Ryzen 5 5600X, 3.70 – 4.60 GHz

- RAM: 32GB Crucial Ballistix, DDR4-3200, CL16-18-18-36

- Grafikkarte: PowerColor Hellhound Radeon RX 9070 XT

- SSD: Crucial MX500, 1 TB

- Fujitsu Esprimo Q556CPU

- Prozessor: Intel Core i5‑7400T

- GPU: integriert

- RAM: 16 GB DDR4

- Grafikkarte: Intel HD Graphics 630

- SSD: 256 GB

- Gerät: LG 55EG910V

- Auflösung:1920 x 1080

- Hertz: 60 Hz

- Router: Fritz!Box 6660 Cable

- Beide PCs sind direkt per Ethernet verbunden (Kabel)

B. Einstellungen:

Apollo:

- Double refresh rate for Virtual Display: ON

- Ansonsten Standard-Einstlelungen

- Auflösung und Hz entsprechend TV eingestellt

- VSync + Frame Pacing ON

- Force hardware encoding ON

- Video Codec: H.264

- Unlock Bitrate Limit ON

- Bitrate: 500 MBit

- VSync OFF

- AMD Anti-Lag OFF

C. Beobachtungen / Problem:

Problembeschreibung:

Ich spiele Horizon Forbidden West auf sehr hohen Einstellungen. Das Spiel fühlt sich teils "verwaschen" an, obwohl es konstant 90+ Frames läuft. Es ist hierbei nicht unbedingt von Input Lag die Rede, sondern das Problem besteht auch, wenn ich die Spielfigur z. B. durchgehend bewege oder die Kamera durchgehend drehe. Es wirkt dabei , als liefe das Spiel minimal in Zeitlupe. Dabei kommt aber nicht zu Rucklern. Das Problem tritt zu etwa 20% der Spielzeit auf. Es wurde bereits mit mehreren Einstellungen am Host/Client experimentiert. Unter den genannten (siehe oben) läuft derzeit am besten.

Beobachtung 1: PC-Test

Das Spiel läuft direkt am PC absolut flüssig. Das Problem tritt dort nicht auf.

Beobachtung 2: Performance-Overlay

Die Daten zeigen, dass der Stream SUPER stabil läuft. (siehe Anhang). Ich habe das Overlay etwa 1,5 Std. beim Spielen im Auge behalten und die Daten blieben absolut stabil. Am Ende gab es keine verlorenen Frames (weder durch Jitter, noch Connection). Der "Frame queue delay" variierte befand sich meist zwischen 5ms und 10ms mit Spitzen um 0ms und 20ms. Ein Zusammenhang mit dem Auftreten des Problems konnte jedoch absolut nicht festgestellt werden. Alle anderen Werte liefen konstant wie abgebildet.

Beobachtung 3: Anderes Spiel

Destiny 2 lief ebenfalls auf höchsten Einstellungen in 1080p absolut flüssig. Kein schwammiges Erlebnis (auch nicht temporär). Man muss hier jedoch sagen, dass das Spiel auch noch einmal mit deutlich mehr FPS läuft (etwa 200 FPS im Schnitt).

Beobachtung 4: Steam-Overlay (HOST)

Das Overlay zeigte, dass keine der Host-Komponenten am Limit ist (siehe Anhang).

(Anmerkung: Das Bild stammt nach einer Videosequenz und ich hab etwas an den Settings rumgespielt, deshalb sind die Frames hier im Low bei 87. Im normalen Spielbetrieb läuft es, wie beschrieben, mit 90-140 Frames. Am PC ebenfalls absolut flüssig, keine Probleme.)

D. Zusammenfassung:

- Das Spiel läuft am, PC absolut flüssig/ohne genanntes Probleme. Das Steam-Overlay bestätigt dies.

- Der Stream läuft stabil.

- Ein Vergleichsspiel (Destiny 2) läuft im Stream absolut flüssig.

- Am Fernseher kann es eigentlich auch nicht liegen, sonst bestünde das Problem auch bei anderen Spielen.

Fragen:

Horizon Forbidden West ist ein ziemlich forderndes Grafikspiel auf hohen Einstellungen. Kann es sein, dass die GPU meines Client-PCs (Core i5‑7400T, integriert) einfach überfordert ist. Die Dekodierungszeit scheint in Ordnung zu sein. Hakt es vielleicht trotzdem an der grafischen Wiedergabe? Woran könnte es noch liegen?

Würde mich über Hilfe SEHR freuen!

Lieben Dank im Voraus!

Peter

Anhänge

Zuletzt bearbeitet: