Spawnie112

Lieutenant

- Registriert

- Okt. 2014

- Beiträge

- 582

Hallo,

ich versuche meinen Backups eine gewisse Robustheit anzueignen.

Daher möchte ich Wiederherstellungsdateien erzeugen.

Bislang deckte sich der Wiederherstellungsgrad in Prozent grob dem was an Speicher veranschlagt wird.

Das hat bei den Video-Dateien vom Camcorder gut geklappt.

Nun wären die Bilder dran gewesen, grob geschätzt 25% Handy-JPGs und 75% Nikon RAWs.

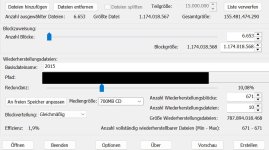

Dort eskaliert das aber völlig. Ein Ordner mit 150GB Bildern soll Wiederherstellungsfiles in der Größe von 1,5TB benötigen bei 30% Wiederherstellbarkeit? Die Effizienz liegt eigentlich auch immer in den hohen 90er% und dort auf einmal zw. 1-7%?

Kann ich da was umkonfigurieren oder gibts ein anderes Tool?

ich versuche meinen Backups eine gewisse Robustheit anzueignen.

Daher möchte ich Wiederherstellungsdateien erzeugen.

Bislang deckte sich der Wiederherstellungsgrad in Prozent grob dem was an Speicher veranschlagt wird.

Das hat bei den Video-Dateien vom Camcorder gut geklappt.

Nun wären die Bilder dran gewesen, grob geschätzt 25% Handy-JPGs und 75% Nikon RAWs.

Dort eskaliert das aber völlig. Ein Ordner mit 150GB Bildern soll Wiederherstellungsfiles in der Größe von 1,5TB benötigen bei 30% Wiederherstellbarkeit? Die Effizienz liegt eigentlich auch immer in den hohen 90er% und dort auf einmal zw. 1-7%?

Kann ich da was umkonfigurieren oder gibts ein anderes Tool?