Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Neues Modell für ChatGPT: Bringt GPT-5.2 die Trendwende für OpenAI?

- Ersteller Andy

- Erstellt am

- Zur News: Neues Modell für ChatGPT: Bringt GPT-5.2 die Trendwende für OpenAI?

herby53

Lt. Commander

- Registriert

- Juli 2005

- Beiträge

- 1.631

@Salamimander

Was machst du denn alles mit ChatGPT?

Perplexity ist mehr eine Suchmaschine oder?

Ich nutze ChatGPT meistens für die Programmierung, wo ich mich wenig auskenne. Perplexity habe ich über einen Gutschein für wenig Geld aber zur Programmierung ist das nicht brauchbar. Und wenn ich irgendwas suche nutze ich klassisch Google.

Also wenn du ChatGPT mehr für Recherche verwendest hast, dann könnte Perplexity tatsächlich besser sein.

Was machst du denn alles mit ChatGPT?

Perplexity ist mehr eine Suchmaschine oder?

Ich nutze ChatGPT meistens für die Programmierung, wo ich mich wenig auskenne. Perplexity habe ich über einen Gutschein für wenig Geld aber zur Programmierung ist das nicht brauchbar. Und wenn ich irgendwas suche nutze ich klassisch Google.

Also wenn du ChatGPT mehr für Recherche verwendest hast, dann könnte Perplexity tatsächlich besser sein.

Salamimander

Rear Admiral

- Registriert

- Okt. 2019

- Beiträge

- 5.195

@herby53

Perplexity ist doch nicht nur eine Suche, dort kannst du auch GPT auswählen. Aber halt auch Gemini, xAI usw… Fuer die Entwicklung ist es aber wirklich (trotz selben Modell) irgendwie schlechter. Frag mich nicht warum

Und ich nutzte es für alles mögliche. Muss aber auch sagen, dass sobald ich technische Infos suche, bei Gemini lande. Für akademisches nutze ich die perplexity deep search in Verbindung mit quellen Einschränkungen.

Perplexity ist doch nicht nur eine Suche, dort kannst du auch GPT auswählen. Aber halt auch Gemini, xAI usw… Fuer die Entwicklung ist es aber wirklich (trotz selben Modell) irgendwie schlechter. Frag mich nicht warum

Und ich nutzte es für alles mögliche. Muss aber auch sagen, dass sobald ich technische Infos suche, bei Gemini lande. Für akademisches nutze ich die perplexity deep search in Verbindung mit quellen Einschränkungen.

Salamimander

Rear Admiral

- Registriert

- Okt. 2019

- Beiträge

- 5.195

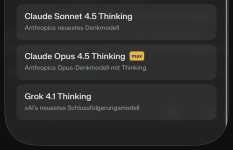

Wenn du bei perplexity zahlst (davon rede ich ja hier), dann nein, diverse pro Modelle:

Ich habe mich aber mal belesen und ich glaube ich teste mal openrouter + Open webUI als RAG und UI davor. Dazu noch searxng und ich habe mein eigenes perplexity (nur Datenschutzfreundlicher)

(nur Datenschutzfreundlicher)

Ich habe mich aber mal belesen und ich glaube ich teste mal openrouter + Open webUI als RAG und UI davor. Dazu noch searxng und ich habe mein eigenes perplexity

Anhänge

DeusExMachina

Lieutenant

- Registriert

- Jan. 2008

- Beiträge

- 551

lynx007 schrieb:Also pures Random. Wie kniffel... zb wollte ich nen QR Code codiert haben... Bing sagte nur macht er nciht. Grok sagte macht er ... aber es verlinkte auf ne cryptoseite, nicht die URL die QR code eigentlich wäre.... Deshalb copier ich gerne auch die Antworten und lass sie gegenprüfen. AI 4 oder 6 oder 8 augen prinzipAber AI bleibt halt immer noch eine Wundertüte. Wie so eine Praline wo du nicht weißt was sich drinnen befindert bis du reinbeist.

Bitte?

Wieso benutzt du dafür ein llm basierendes Programm?

Dafür gibt es einfache verlässliche Generatoren.

Da muss man dich nicht noch die Ressourcen von mehreren LLM verpulvern und denen helfen noch mehr Menschen krank zu machen.

Chibi88

Lt. Commander

- Registriert

- Dez. 2007

- Beiträge

- 1.330

Blaexe schrieb:Ein sehr wichtiger Punkt fehlt hier, was dann schon ein Gschmäckle hat:

Für GPT5.2 gibt es die "Thinking Stufen" Low, Medium, High und xHigh. Die Benchmarks sind mit xHigh erstellt.

Also normaler ChatGPT Nutzer mit Abo hat man aber nur Low (Standard) und Medium (Extended Thinking) zur Verfügung.

Mit dem sehr teuren GPT Pro Abo dann noch zusätzlich High.

Die Intelligenz die man mit dem Abo bekommt entspricht also nicht der von den Benchmarks. Mit Gemini 3.0 Pro kriegt dagegen jeder die beworbene Intelligenz.

Echt? Was, wenn ich bei der prompt und dem free model "denke gründlich nach" anstoße und somit den Modus trigger? Low, medium oder high?

- Registriert

- Okt. 2012

- Beiträge

- 7.693

Mehr gibt's dazu eigentlich nicht zu sagen.

Hab vergessen das man bei der aktuellen Generation TikTok präziser sein muss. Selbstverständlich war das nicht die Frage sondern eine Metapher für das Verhalten der KI.calluna schrieb:Seltsam, denn ich bekomme diese korrekte Antwort auf deine Frage:

Ein Wetterbericht kann sogar SIRI und die ist dumm wie Brot.

GTR schrieb:Hab vergessen das man bei der aktuellen Generation TikTok präziser sein muss.

Ich kann keine Metaphorik in deinem Post erkennen. Was du meinst, ist wohl eher das Stilelement der Übertreibung - aber mit Blick auf den Rest deines Posts hat es auf mich wie eine ernst gemeinte Tatsachenbehauptung gewirkt.

Unter Einstellungen "individualisierung" bei individuelle Anweisungen einfach reinschreiben "Komme direkt auf den Punkt".Rollkragen schrieb:Nun ja, ich bin zunehmend genervt von ChatGPT, trotz Abo. Die Antworttexte werden immer länger (hallozinieren), was sich jedoch nicht inhaltlich in relevanten Fakten niederschlägt, sondern schlicht in „Masse“. Dazu kommen Wiederholungen. Wenn ich anweise, keine Wiederholungen, kurze, prägnante und fachlich relevante Texte, kommt oft als Erstes die Floskel: "Hier eine kurze, fachlich fundierte Antwort“ gefolgt von einem extrem langen Text ohne viel Inhalt.

Gemini macht das ein wenig besser. Ich gebe mittlerweile bestimmte Fragestellungen einmal bei ChatGPT und dann bei Gemini ein. Letzteres ist häufiger kürzer, sachlicher und liefert gute Quellennachweise. Es würde mich auch nicht wundern, wenn Gemini langfristig ChatGPT den Rang abläuft, zumal Alphabet deutlich andere finanzielle Ressourcen besitzt.

Seit dem nur kurze Antworten ohne viele blabla

Vielleicht kann ChatGPT diese Fragen beantworten...Averomoe schrieb:Okay aber für was bitte stehen denn nun diese Prozente? Was muss geschehen, um 100% zu erreichen? Warum Prozent und nicht Punkte oder von mir aus Gummibärchen?

lynx007

Rear Admiral

- Registriert

- Feb. 2011

- Beiträge

- 5.424

DeusExMachina schrieb:Bitte?

Wieso benutzt du dafür ein llm basierendes Programm?

Dafür gibt es einfache verlässliche Generatoren.

Da muss man dich nicht noch die Ressourcen von mehreren LLM verpulvern und denen helfen noch mehr Menschen krank zu machen.

Da komm ich nicht mit? meinst du den QR Code?

DeusExMachina

Lieutenant

- Registriert

- Jan. 2008

- Beiträge

- 551

Ja

Ähnliche Themen

- Antworten

- 38

- Aufrufe

- 4.857