end0fseven

Lt. Commander

- Registriert

- Feb. 2017

- Beiträge

- 1.851

Hallo Zusammen

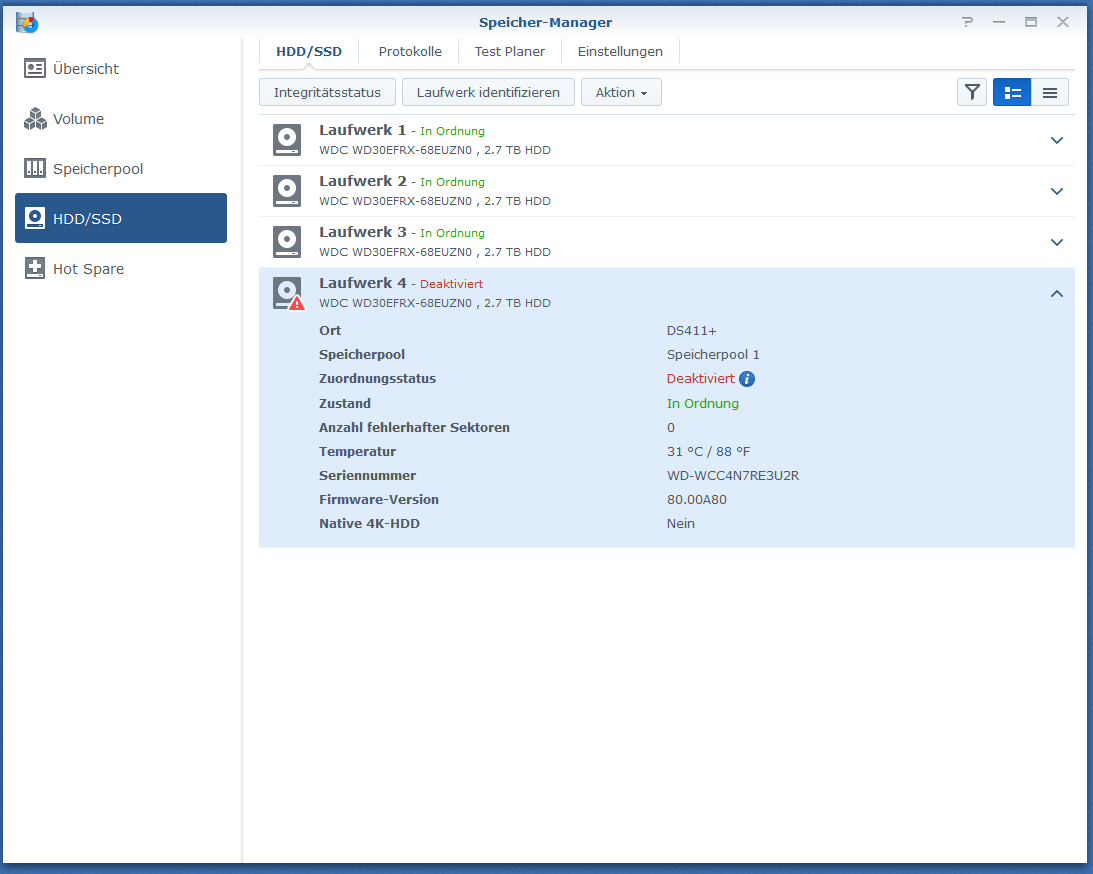

Ich stehe gerade vor einer kleinen herausvorderung. Ich besitze jetzt seit gut 4 Jahren eine Synology DS411+ (2GB RAM) mit 4x3TB Festplatten.

Jetzt hat vor zwei Tagen eine Festplatte den Dienst aufgegeben. (Weit über 33`000 Betriebsstunde). Das komische, die SMART Werte und Fehlerhaften Sektoren sind immer noch auf 0.

Wie dem auch sei. Backups werden Regelmässig von den Wichtigsten Dingen auf eine Externe HDD gemacht.

Das ding ist, die Platte haben scheinbar alle das gleiche Fabrikationsdatum (gleiche Charge), also ist es logisch, das die anderen ggf. bald den Geist aufgeben.

Jedoch habe ich für mich überlegt, brauche ich noch 4 Festplatten? Ich belege von den 8TB Speicher gerademal 2.1TB.

Das andere, dass NAS ist auch nicht mehr das neuste, macht es hier sinn langsam auf ein neues Modell zu gehen, oder halt in diesem Modell anstelle 4 halt nur noch 2 Festplatten zu verbauen?

Welche Festplatten könnt ihr mir da empfehlen?

Auf dem NAS ist Docker mit einem Teamspeak Server und ein VPN Dienst aktiviert.

Vielen Dank

End0fSeven

Ich stehe gerade vor einer kleinen herausvorderung. Ich besitze jetzt seit gut 4 Jahren eine Synology DS411+ (2GB RAM) mit 4x3TB Festplatten.

Jetzt hat vor zwei Tagen eine Festplatte den Dienst aufgegeben. (Weit über 33`000 Betriebsstunde). Das komische, die SMART Werte und Fehlerhaften Sektoren sind immer noch auf 0.

Wie dem auch sei. Backups werden Regelmässig von den Wichtigsten Dingen auf eine Externe HDD gemacht.

Das ding ist, die Platte haben scheinbar alle das gleiche Fabrikationsdatum (gleiche Charge), also ist es logisch, das die anderen ggf. bald den Geist aufgeben.

Jedoch habe ich für mich überlegt, brauche ich noch 4 Festplatten? Ich belege von den 8TB Speicher gerademal 2.1TB.

Das andere, dass NAS ist auch nicht mehr das neuste, macht es hier sinn langsam auf ein neues Modell zu gehen, oder halt in diesem Modell anstelle 4 halt nur noch 2 Festplatten zu verbauen?

Welche Festplatten könnt ihr mir da empfehlen?

Auf dem NAS ist Docker mit einem Teamspeak Server und ein VPN Dienst aktiviert.

Vielen Dank

End0fSeven