x.treme

Captain

- Registriert

- Sep. 2008

- Beiträge

- 3.316

Hallo zusammen,

ich nutze Proxmox nun schon seit einem halben Jahr und bin eigentlich ziemlich happy.

Bzgl. des Storage habe ich mich für einen ZFS-Pool auf meiner SSD entschieden, da dies wohl die einzige Lösung ist, um den Speicher auf dem die virtuellen Disks gehosted sind zu verschlüsseln.

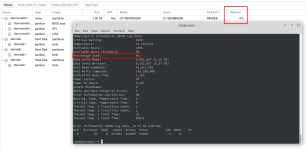

Problem: Meine SSD hat nun einen Wearout von 94% (sie war neu gekauft).

Ich könnte die SSD natürlich nun ersetzen, aber das wäre auf Dauer ein wenig zu teuer ...

Habt ihr ähnliche Probleme bzgl. Wearout bzw. wie geht ihr hiermit um? Gibt es eine Alternative zu ZFS wenn man seinen Disk Image Storage verschlüsseln will?

ich nutze Proxmox nun schon seit einem halben Jahr und bin eigentlich ziemlich happy.

Bzgl. des Storage habe ich mich für einen ZFS-Pool auf meiner SSD entschieden, da dies wohl die einzige Lösung ist, um den Speicher auf dem die virtuellen Disks gehosted sind zu verschlüsseln.

Problem: Meine SSD hat nun einen Wearout von 94% (sie war neu gekauft).

Ich könnte die SSD natürlich nun ersetzen, aber das wäre auf Dauer ein wenig zu teuer ...

Habt ihr ähnliche Probleme bzgl. Wearout bzw. wie geht ihr hiermit um? Gibt es eine Alternative zu ZFS wenn man seinen Disk Image Storage verschlüsseln will?