Hab bei mir mittlerweile die AMD-Treiber unter Linux ans Laufen bekommen. Gar nicht mal so einfach, wenn die Dependencies allesamt streiken. Anyway, Stable Diffusion Web UI rendert mit der 6900XT jetzt stabil in wenigen Sekunden. Werde damit auch mal ein wenig rumprobieren.

Bisher habe ich nur mit Midjourney gearbeitet und dort auch mal ein Abo gemacht, um einige Stunden fast Rendering mit allen Parametern zu bekommen. Das Problem sehe ich bei MJ allerdings darin, dass die normale Engine immer extrem gezeichnet nach Digital Art aussieht. Das ist zwar super, wenn man durchpolierte digitale Artworks generieren möchte. Sobald es in Richtung Photorealismus geht, wird es aber ziemlich schnell eng. Man kann mit den Promts zwar noch einiges drehen. Im Wesentlichen bleibt dieser künstliche Look aber immer erhalten, was vor allem bei Gesichtern schon sehr einschränkt. --test und --testp sind da schon wesentlich besser und geben mit den richtigen Prompts zusammen stellenweise auch tatsächlich photorealistische Ergebnisse aus.

detailed skin, high-res photography style, natural colors, 8k --upbeta --test bzw.

--testp

Allerdings kann man mit den beiden kein High Quality laufen lassen und so Dinge wie --aspect sind ebenfalls broken. Ist halt alles noch nicht gänzlich ausgereift. Davon abgesehen hatte ich die heute und gestern zwischendurch immer mal wieder Downtimes beim Bot. Schon irgendwie bitter, wenn man Premium-Kunde mit zeitlich begrenztem Guthaben ist.

Was die Quali der Bilder mit Stable Diffusion betrifft, kann ich noch nicht viel sagen. Dass man das Ganze auch lokal auf der eigenen Hardware laufen lassen kann, ist aber schon mal ein dicker Pluspunkt. Die Einstellungsmöglichkeiten und Parameter sind bei solch offenen Plattformen auch wesentlich umfangreicher.

Werde mal versuchen, ein promts zu finden, die vergleichbar gute Ergebnisse liefern.

PS: Achja, zum schnellen Reworken von Gesichtern lohnt sich ein Blick auf:

https://arc.tencent.com/en/ai-demos/faceRestoration

Scheint z.B. bei dem Elfen-Beispiel aber nicht so gut zu funktionieren, weil wohl einfach zu wenig Anhaltspunkte für die AI (stark verwaschene Haut) vorhanden sind.

EDIT:

Photorealistische Portraits scheinen in Stable Diffusion auch nicht so einfach zu sein. Man muss ihm schon sehr viele Prompts an die Hand geben und auch einige Punkt ausschließen, damit man kein überbelichtetes oder überkontrastiertes Bild mit gezeichnetem Look bekommt. Beispiel:

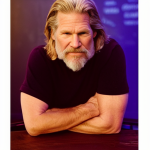

A portrait of Jeff Bridges sitting in a late night sports bar. Natural colors. Detailed face, detailed skin, detailed texture, detailed cloth, crisp, high detail, very detailed, hyper detailed, high-res, 4k, 8k, 8k texture, super resolution, ultra detailed, fine texture skin, fine texture face, photo, restoration. Mild contrast, natural contrast, natural light, good lighting. Hands.

Negativ:

drawn, hdr, overexposed, oversaturation

Settings: 60 Steps, DDIM, Scale 7, 4081700472, Restore faces an (links) und aus (rechts)

Wirkt zwar alles etwas retouschiert und zusammengeschnitten. Für KI-Verhältnisse aber durchaus ordentlich.

Das obige ist mit Abstand aber auch mein bester Anlauf. Der Durchschnitt hatte immer arge Probleme mit den Händen, deplatzierten Details, falschen Schatten, etc.

Die Gesamtkomposition mit allen Objekten, deren perspektiver Krümmung und dem Übergang von Vordergrund zu Hintergrund (insb. Schärfeverlauf) bekommt Midjourney jedenfalls schon mal merklich authentischer hin. Photorealismus ist da mit guten Prompts auch machbar.

A portrait of Jeff Bridges sitting in a late night sports bar. Natural colors. Detailed face, detailed skin, detailed texture, detailed cloth, high detail, very detailed, fine texture face, photo. natural light, good lighting. Hands. Photographic, photo, photorealistic, ISO, mm, aperture. --testp --upbeta

Leider erlaubt --testp keine Negativ-Promts, sonst hätte ich noch HDR rausgenommen.