G3cko schrieb:

Intel hängt keine 10 Jahre hinterher. Sie müssten nur eine CPU mit extra Cache bringen.

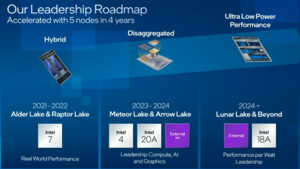

Intel zeigt ja auch bereits erste "Demos" mit entsprechenden Chiplets. Es wird bei Intel sicher noch etwas dauern, aber 10 Jahre ist AMD hier nicht voraus.

ArrakisSand schrieb:

So ein billig in 2D angebundener L4 Cache, kann es nicht mit dem 3D V-Cache von AMD aufnehmen.

… Wenn man keine Ahnung, sollte man lieber nichts schreiben, statt allen zu zeigen, dass man keine Ahnung hat.

Ein gut angebundener L4-Cache an der richtigen Stelle, muss einem aufgesetzten L3-Cache nicht wirklich unterlegen sein, wenn die Cache-Stufen vorher auch entsprechend ausgelegt wurden. Der primäre Nachteil eines L4-Caches gegenüber dem aufgesetzten L3-Cache wäre eine gewisse Latenzsteigerung. Die Latenz wäre in dem Fall aber IMMER noch weit niedriger als zum RAM und würde auch wesentlich weniger Energie benötigen.

Dazu bietet ein L4-Cache in diesem Zusammenhang einen Vorteil, den AMD aktuell mit ihrer Art des 3D-Caches nicht hat: Der L4 steht allen "CPU"-Tiles zur Verfügung und kann so ggf. den Umweg über den RAM minimieren/eliminieren.

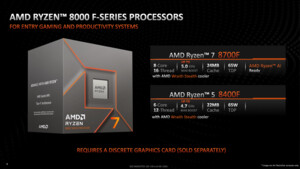

AMD muss bei den "Consumer-CPUs" aktuell zwischen CCD 0 und CCD 1 unterscheiden, nur ein CCD hat bei den "oberen" Prozessoren die entsprechenden Boost des 3D-Cache. Ein L4 im IOD würde allen CCDs den Cache zur Verfügung stellen.

Dazu kommt, dass Intel mit Meteor-Lake und bereits bei Saphire-Rapids entsprechend am Die-to-Die-Interconnect gearbeitet hat und die Prozessoren sehr nah zusammen kommen - ähnlich dem M1 Ultra/M2 Ultra und damit die Latenzen noch mal ein Stück anders sind, als bei AMD von CCD zu IOD zu CCD.

Was du also als "billig" angebundender L4 bezeichnest, hat Vorzüge, die der 3D-Cache nicht hat und umgekehrt. Am Ende - und das hat Broadwell gezeigt - es aber entscheinder, dass man sich den Weg aus der CPU zum RAM spart, weil hier die meiste Energie benötigt wird und auch die meiste Zeit draufgeht. Wenn Intel den L2-Cache - was sich ja andeutet - noch mal erhöht, den L3-Cache auch noch mal etwas und dann 64 MiB bis 128 MiB als L4 davor schaltet, dann kann das eine verdammt gute Sache werden.

t3chn0 schrieb:

Intel ist AMD im Hybrid Ansatz deutlich voraus und hat einen deutlich besseren Hardware Scheduler.

Ja und Nein. Der Hardware-Scheduler bei Intel ist zwar tolles Marketing, aber im weiten nicht so gut, wie hier einige tun und auch getan wird.

Der Hardware-Scheduler bei Intel arbeitet in Win 10 und Win 11 aktuell auch erst mal nach der Regel: 1. P-Kerne, dann E-Kerne, dann SMT auf den P-Kernen. Natürlich wird dann der Code "überwacht" und dann Empfehlungen gegeben, aber von einem wirklich guten und vorausschauenden Thread-Director kann man hier nicht sprechen. Man analysiert Speicherzugriffe und versucht daraus dann auch zu schließen, wo der Thread am besten ist.

Bei Meteor-Lake dreht Intel die Regel erst mal um, damit erst die E-Kerne im IOD und dann die anderen dran kommen. Aktuell ist es nämlich so, dass die e-Kerne meistens raus fallen, selbst wenn der Prozess dafür geeignet wäre.

Hier ist auch nicht wirklich Intel oder AMD gefragt, sondern MS und Linux, die entsprechend auch die Möglichkeiten bieten, dass man bestimmte Prozesse alleine anhand einfacher Daten auf die P und E-Kerne schieben könnten.