Quidproquo77 schrieb:

Diese Behauptung triffst du auf welcher Grundlage?

Die Behaupunt stelle ich auf Grundlagen von sehr vielen Spielen auf, die ich "bis" Juli zwangsweise mit FSR spielen musste und nun auch mit DLSS und FSR spielen konnte. Egal ob jetzt Cyberpunk 2077, Starfield, Diablo 4, aktuell Ratchet & Clank oder Baldurgs Gate 3 und ein paar andere Spiele.

Mir selbst fallen in keinem dieser Spiele

beim spielen "qualiative" Unterschiede auf. Ich stelle Unterschiede fest, dieses sind allerdings eher subtiler Natur. Mal wird ein Detail bei DLSS genauer heraus gearbeitet und geht bei FSR unter oder umgekehrt. Genauso ist mal eine Oberfläche verwaschener mit DLSS oder FSR, mal eine Kante etwas unsauberer mit der einen oder andere Technik.

Da man sich jedoch je nach Spiel auf ganz andere Sachen konzentiert, gehen diese Unterschiede unter und geraden so schnell aus dem Fokus. Und

Fokus ist hier das Stichwort. Darauf gehe ich später ein.

Quidproquo77 schrieb:

Qualität auf einem UWQHD oder QHD Monitor mit FSR ist besser als die Auflösung zu reduzieren, aber auch für Laien sofort erkennbar schlechter als DLSS Q.

Müssen wir argumenativ direkt auf Strohmänner zurückgreifen? Na, ich wäre ja mal gespannt, ob du deine Aussage - so wie du es von mir verlangst - auch belegen kannst. Gerade mit den "Laien" dürfte das ziemlich kompliziert werden.

Es gibt in diesem ganzen Zusammenhang nämlich ein paar Probleme - und deswegen schreibe ich aktuell auch primär aus meiner eigenen Sichtweise. Die Qualität des finalen Bildes hängt von ein paar mehr Faktoren ab, als nur DLSS und FSR und viele dieser Faktoren sind dazu noch höchst subjektiver Natur und/oder hängen auch von der verwendeten Ausrüstung ab.

Wenn ich hier einen Blindtest in Cyberpunk 2077 mit 5 Kolleg*innen mache - und das sind Laien - dann fällt keinem bei einem Test auf, ob nun DLSS oder FSR aktiviert ist, wenn ich sie spielen lasse, da da dann die Aufmerksamkeit ganz wo anders ist.

Quidproquo77 schrieb:

Du kannst mir gerne einen Test oder einen Vergleich zeigen, der deine Sicht bestätigt, mir ist keiner bekannt.

DevPandi schrieb:

Gewisse Sachen fallen dann beim Innehalten auf - etwas verwaschener Texturen, etwas verlorene Details.

DevPandi schrieb:

Am Ende ist auch die Bildqualität immer etwas, was man subjektiv bewertet und man kann [eine] andere Meinung haben.

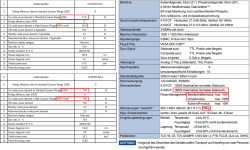

Bisher gibt es nur einen umfassenden Test zum Thema FSR vs DLSS von Hardware Unboxed. Ansonsten gibt es eine Vielzahl von Tests - auch auf CB - und wie das Fazit hier ausfällt, wenn FSR "sauber" implementiert wurde, hat

@Wolfgang schön formuliert im

Test zu Avatar: "Vor allem in 3.840 × 2.160 erzeugt FSR mit diesen Eigenschaften am Ende aber ein erstaunlich stabiles Bild, das dem von Nvidia DLSS nur verhältnismäßig gering unterlegen ist."

Ich schreibe in meinen Beiträgen im übrigen nicht umsonst davon, dass ich bei Spielen immer sowohl FSR als auch DLSS teste. Es kommt sehr oft darauf an, ob DLSS/FSR nur als Check-Point im Lastenheft stand und abgestrichen wurde, oder ob es wirklich sauber implementiert wurde.

Und damit kommen wir jetzt zu meinem entscheidenden Punkt: Ich habe nicht umsonst die ganze Zeit davon geschrieben, dass für mich am Ende die Entscheidung zwischen DLSS und FSR darin besteht, welche der beiden Techniken für mich im Spiel die störrernden Artefakte beim Spielen erzeuge.

Quidproquo77 schrieb:

Artefakte einer gefühlt niedrigeren Auflösung, sprich Kantenflimmern und Bildinstabilität stechen sofort ins Auge. Ghosting von feinen, kleinen Objekten muss man mit schnellen Drehungen provozieren bzw. suchen.

Ich habe nach diesem Satz durchaus überlegt, ob ich auf dich weiter eingehen werde an dieser Stelle oder einfach nicht.

Auf der einen Seite bauscht du hier argumentativ Kantenfilmmern und Bildinstabilität auf, weil das einem sofort ins Auge stechen würden, gleichzeitig spielst du die Probleme des Ghostin massiv herunter, in dem du behauptest, dass man es provozieren muss und es ja nur feine und kleine Objekte wären.

Du misst hier mit Zweierleimaß und damit erübrigt sich eigentlich jegliche Diskussion, weil es nur darum geht, das du recht hast.

Beim Kantenflimmern - und hier nehme ich jetzt direkt bezug auf die von dir verlinkten Videos und deine folgende Aussage:

Quidproquo77 schrieb:

Wirf mal einen Blick auf die großen 3 Palmen von der Mitte leicht links , ich denke das sehen 99,9%.

Der

Fokus beim spielen ist entscheidend, ob Kantenflimmern, Bildinstablitäten oder Ghosting störend sind oder nicht, nicht unbedingt deren Existenz.

Ich glaube nicht, dass ich

beim Spielen - ich müsste mal Avatar anschmeisen und die Szene da mal mit FSR und DLSS nach stellen - darauf achte, ob irgendwelche Palmen im "Hintergrund" bei mir so im Fokus liegen, dass ich das mitbekomme. Ob ich jetzt auf die Palmen geachtet hätte, wenn du nicht explizit diese erwähnt hast, kann ich jetzt nicht mehr sagen.

Für mich relevant ist bei DLSS und FSR, wie das Bild in

meinem Fokusbereich aussieht und ob es da zu Artefakten kommt. Der Fokus liegt in der Regel - nicht nur bei mir - eher in der Bildschirmmitte. Und dann ist es egal, ob wir von Kantenflimmern, Bildinstabilität oder Ghosting sprechen. Ich empfand lange Zeit das Ghosting bei DLSS in Cyberpunk 2077 - das hat sich gebessert - der Hauptfigur beim Motorradfahren und Co sehr störend, es hat mich regelrecht irritiert. Da habe ich lieber FSR2 verwendet, weil es das nicht hatte.

Genauso nutze ich jetzt lieber DLSS, weil es mit den feinen Texturen von Klamotten auf Haut besser zurecht kommt, als FSR. Letzteres neigt dazu es zu verschlucken. Wobei beide besser sind als "Nativ".

Es ist mir dabei aber egal, ob irgendwo oben eine Kante flimmert, die nicht in einem Fokus ist oder ein Zaun Links im Bild auf den ich nicht achte, Währebnd das Auto, dass ich fahre, sehr wohl in meinem Fokus liegt und mich Ghosting dann stören würde.

Und damit kommen wir zurück zum Punkt Subjektivität: Ich bin nicht du, du bist nicht ich, ich bin nicht Wolfgang oder der Herr von Hardware Unboxed und Co. Wir alle haben unsere eigenen Präferenzen und reagieren unterschiedlich auf die verschiedenen Artefakte. Dazu legen wir alle auch den Fokus vermutlich anders und was für Hardware Unboxed ein "klarer" Sieg für DLSS sein kann, muss für mich kein klarere Sieg sein, weil ich vielleicht einen ganz andere Fokus lege.

Ich reagiere total empfindlich auf Ghosting und wenn DLSS bei einem Spiel in meinem Fokusfeld Ghosting erzeugt, dann ist für mich DLSS an der Stelle klar die schlechtere Lösung und erzeugt auch das schlechtere Bild. Wenn FSR bei einem Gesicht in meinem Fokus Kanntenflimern oder andere Artefakte erzeugt, die DLSS nicht erzeugt, dann erzeugt für mich FSR das klar schlechtere Bild. Vollkommen unabhängig, ob du oder Hardware Unboxed oder ein anders Community Mitglied DLSS oder FSR besser findet - allgemein - oder es in euren Augen in Spiel X weit überlegen ist.

Und genau das ist der entscheiden Knackpunkt: Für "mich" muss am Ende beim spielen das Bild stimmen und natürlich gilt das auch für dich. Wenn für mich in Titel A FSR das bessere Bild erzeugt, dann kann für dich in Titel A dennoch DLSS das bessere Bild erzeugen.

Das ist kein Widerspruch, sondern hängt von unseren Präferenzen ab und worauf wie empfindlicher reagieren.

Daher ist diese Diskussion in der Regel auch vollkommen hinfällig. Es wird hier - gerade von deiner Seite - zu sehr versucht "Recht" zu haben - auch der Verweis auf einen vernünftigen Monitor, wenn ich jetzt schreibe, dass ich eine Brille trage, kommt dann der verweis, dass ich wegen meiner Augen das eh nicht erkennen kann?

Es geht hier nicht um "Recht" haben, es geht alleine um das subjektive Empfinden, was sich für einen am Ende besser anfühlt. Ich hasse Süßkartoffel Pommes, ich kann die nicht ausstehen und finde die grauslig. Da Stellen sich mir die Nackenhaare auf. Das bedeutet aber nicht, dass du die auch grauslig finden musst, du kannst die sogar als die besten leckersten Pommes der Welt sehen. Dann ist das so.

Caramelito schrieb:

Beim SPIELEN an sich, fällt es mir nicht auf, ob ich DLSS oder FSR nutze, auch in QHD nicht, weil ich BEIM SPIELEN nicht rumstehe und Screenshots und Vergleiche mache. Vor allem bei Shootern oder Rennspielen.

Solang man Spaß beim Spielen hat und man glücklich ist, ist alles erreicht, egal ob DLSS oder FSR oder XeSS.

Ich mach mir jetzt leckere Korketten, für die Mitbewohner gibts Süßkartoffelpommes und alle sind Glücklich!