Vega – der fallende Adler

- Einleitung

- Einführung GCN

- HBM

- Einführung Vega

- Vega Mobile aka iGPU

- RDNA2 und der L3 Cache

- Testsystem (@PCIe 4x 3.0)

- Die Karten

- Benchmarks

- abschließende Worte

Einleitung

Wir schreiben das Jahr 2023. Nvidia hat zuletzt Karten der Ada Lovelace Generation in den Verkauf gebracht und auch AMD war nicht untätig. So ist bereits die dritte Generation der RDNA-Architektur im Handel gelandet.

Hier stellt sich die Frage, was ehemalige High End Karten mit der veralteten GCN-Generation noch leisten können und wie sie sich gegen die kleinste RDNA2 Karte auf dem Markt behaupten.

Preislich liegen die Probanden zurzeit alle bei ca. 130€.

Einführung GCN

GCN wurde am 09. Januar 2012 eingeführt, also vor 11 Jahren. CB intern zählt die Architektur damit eher als Youngtimer, denn als Retro-Hardware.

Während die vorhergehende Technik noch auf VLIW (Very long instruction word, VLIW, Wikipedia) basiert, die eine hohe Leistung bei gleichzeitig verringerter Komplexität verspricht, führte AMD mit GCN eine RISC Variante ein (Reduced Instruction Set Computer, RISC, Wikipedia). Hierbei erhöhte sich aber, wie schon gesagt, die Transistorzahl der einzelnen Chips, so wie möglicherweise die Anzahl von Anweisungen. Im Gegenzug versprach man sich eine schnellere Abarbeitung der einzelnen, verkürzten Befehle, da eine einfachere Pipeline genutzt wurde, die wiederum schneller arbeitet als in den Tera Scale GPUs.

Dadurch und in Verbindung mit einer erhöhten Auslastung, wird der gesamte Chip beschleunigt.

Zur Einführung wurde DirectX 11 unterstützt.

Im September 2014 führte AMD die dritte Generation der GCN ein. Anfangs noch als Radeon R 285 mit dem Tonga Chip, kam im Juli 2015 dann die hier getestete R9 Fury auf den Markt.

AMD verstand es vorzüglich, vier unterschiedliche GPU-Generationen unter einem Label zu bringen. So nutzte man bei der R200 Reihe Tera Scale, sowie GCN 1 – 3. Bei der R300 Serie, zu der die Fury gehört, war es immer noch GCN 1 – 3.

Die Fury glänze vor allem mit dem neuen Speicher:

HBM

Während nVidia mit 3,5 GHz schnellen Speicher, an einem 384 Bit Interface auf 337 GB/s kam, glänzte AMDs Karte mit 500 MHz, einem 4096 Bit SI und gigantischen 512 GB/s.

Im GDDRX Feld brauchte man in Santa Clara bis zur GeForce RTX 2080 Super und Ti, um in diesen Bereich zu gelangen. Die Kanadier dagegen konnten erst mit der RX 6800 wieder in diesen Gefilden fischen.

Zusätzlich verbrauchte das Speicherinterface genauso viel Fläche, wie ein 256 Bit Interface, der Vorgänger R200 Serie nutzte aber noch 512 Bit, um eine hohe Bandbreite zu erreichen. Ein weiterer Vorteil war das Stapeln von Chips, um die Speicherdichte zu erhöhen, was beim Konkurrenzprodukt nicht möglich war. Hinzu kam, dass die GDDR-Technologie mit steigendem Takt immer ineffizienter wurde und der aktuelle GDDR6 kam ganze 3 Jahre nach der Fury auf den Markt.

AMD schätzte, das 15-20% der 250W Boardpower einer R9 290X im Speicher verschwindet, das sind nicht zu unterschätzende 40-50W, die man mit Hilfe von HBM auf 15W drückte. So viel, wie die U-Prozessoren für gewöhnlich nutzen.

Die Vorteile lagen also klar auf der Hand.

Nachteil des HBM war sein Preis, so wie die Tatsache, dass er vorerst auf 4 GB limitiert war.

Wobei ein CB-Test gezeigt hat, dass die Karte hervorragend mit ihrer Begrenzung zurechtkommt und leistungstechnisch vor der R9 390 mit 8GB liegt.

Die HBM-Technologie wurde noch im Crossover Produkt intel Core i7 8705G/06G/09G u. 8809G genutzt, verschwand aber auch hier schnell vom (Consumer) Markt.

Einführung Vega

Im Jahr 2017 plante AMD den Rundumschlag mit der Vega Architektur:

- High Performance Gaming

- GPU Computing

- Mobile

Was kann da schief gehen…

Vega war so etwas wie die Eierlegende Wollmichsau. Gamer, wie auch High Performance Computing sollten bedient werden und gleichzeitig war Vega der GPU-Part in AMDs APUs.

Gerade letzteres war erfolgreich, was den Geschwindigkeitsvorsprung gegenüber dem Dauerrivalen intel betraf. Erst Iris Xe konnte der alternden GCN-Architektur das Wasser reichen.

Vega 56 und 64 dagegen hatten es schwer, gegen den Kalifornischen Widersacher nVidia.

Die 56 war auf Augenhöhe mit der GTX 1070, während die 64 sich der 1080 geschlagen geben musste. Kein schlechtes Ergebnis, aber der erste Platz im Duell hat nun mal mehr Strahlkraft.

Der arabische Name für den Stern Vega, fallender Adler, passt hier also ganz gut.

Vor allem die groß angekündigten Primitive Shader (AMD Vega: Primitive Shader müssen vom Spiel unterstützt werden - ComputerBase) waren anfangs nicht verfügbar und mussten später auch explizit vom Game unterstützt werden. Einfach loslegen war nicht.

Dabei lag ihr Vorteil auf der Hand, wie z.B. der deutlich vorgezogene Z-Tiefen Test, der verhindert, das unnötige Pixel gerendert werden. Sicherlich, diese Technik existiert nicht erst seit Vega in den Radeons, aber die Primitive Shader ersetzte die bisherigen, getrennten Vertex und Geometry Shader.

Neben dem Verwerfen der Geometrie können sie noch Shadow Maps und Partikeleffekte berechnen, so wie zu einer Leistungssteigerung im VR-Bereich beitragen.

Eine weitere Neuerung war der Draw Stream Binning Rasterizer, auch bekannt als Tile Based Renderer, wie in den Kyro Chips genutzt. Der Vorteil ist, dass diese Kacheln so wenig Speicherplatz belegen, dass sie in den 4MB L2 Cache der GPU passen. Hier wird ebenfalls ein Z-Buffer Test durchgeführt, wobei die Ergebnisse mit den Kacheln mitwandern. Der größte Effekt kommt zu Stande, weil man nicht in den Grafikspeicher zurückschreiben muss, und so massiv Bandbreite einspart. Gerade bei den APUs ein nicht zu vernachlässigender Wert.

Vega mobile

Dies ist der APU-Ableger der 5. GCN-Stufe, der zusammen mit den Zen Kernen eine bärenstarke Kombi präsentiert.

Während AMD jahrelang eine gute iGPU, im Gegenzug aber miserable CPU-Kerne lieferte, war es bei intel das genaue Gegenteil.

@Gorasuhl Meinung zu den Bulldozer Kernen:

Selbst nach diversen Microcode - und BIOS Updates haben die nicht ansatzweise ihre angepriesene Leistung erreicht.

Der FX8150 war das schlimmste was ich mir bisher ins Haus geholt hatte.

Erst Ryzen beendete diese Leistungs-Dominanz, wenn auch mit geringer Marktdurchdringung, und Vega wurde zum Dauerläufer unter den iGPUs. Immerhin 6 Generationen an APUs sind mit dieser Lösung ausgestattet, wobei sich der Takt von 1,1 auf bis zu 2 GHz steigerte. Die CUs dagegen blieben relativ stabil. Leistungssprünge gab es nur durch optimierte Fertigung und in Verbindung mit LPDDR4.

Fun Fact: in der DDR wurde ein Betriebssystem, mit dem Namen Wega entwickelt (WEGA (Betriebssystem) – Wikipedia)

RDNA2

Während RDNA die dominierende GCN-Architektur beerdigte, kam mit der 2. Gen endlich Ray Tracing in Hardware auch bei AMD an.

Wenn man bedenkt, wie lange es diese Technik bereits gibt, war es ein beschwerlicher Weg dahin. Software existierte min. seit den 80er Jahren des letzten Jahrtausends.

Hier kam aber nicht das typische Henne-Ei Problem zum Tragen, es fehlte auch schlicht an freier Rechenkraft für die Berechnungen. Sicherlich einer der Gründe, warum Larrabee so nie erschien.

Aber wie bei den Shadern*, steht mit jeder neuen Generation zusätzliche Leistung bereit.

*Fun Fact: bereits die erste Radeon hätte Shader unterstützen können. Durch eine Änderung der Dx8 Spezifikation war es aber nur noch über eine Emulation möglich.

In der Radeon Ark Demo sollen diese noch zum Einsatz gekommen sein: HD60fps - ATI Radeon 7500 Techdemo Radeon's Ark (Ruby's first appearance) (Year 2000) - YouTube

Der größte Vorteil dieser Karten ist, das selbst die kleine RX 6400 mit 50W TDP bereits Raytracing unterstützt. Bei nVidia geht es erst mit der RTX 3050 los, bei intel wiederum mit der teureren Arc A380.

Nach Veröffentlichung der Radeon VII, mit 16 GB HBM, verschwand diese Technik aus dem Consumer Bereich. Denn der schon erwähnte GDDR6 löste nach 10 Jahren die GDDR5 Technologie ab und ist seitdem die vorherrschende Technik zur Speicheranbindung.

Im Gegenzug führte AMD den Infinity Cache mit RDNA2 ein, der half, Speicherzugriffe zu vermindern und so die virtuelle Speicherbandbreite zu erhöhen. Intel hatte diverse male einen L4 Cache genutzt, um gerade die iGPU zu beschleunigen (Haswell und Kaby Lake z.B.) und auch für AMD war diese Technik nicht neu, nutzte doch bereits die XBox 360 GPU 10MB eDRAM.

ATi Radeon 7500 Mobility -> AMD C-50 -> Pentium P6100 -> rechts oben die XBox GPU

Die kleinste Navi Karte hat davon noch 16 MB auf dem Chip, was max. bis FullHD reicht.

Man muss dieser GPU aber zugutehalten, das sie als reiner Notebookchip mit 50W TDP entworfen wurde. Ob AMD nicht genügend Notebooks absetzen konnte und somit eine Zweitverwertung erfolgte? Möglich.

Die letzte Steam Hardware Umfrage zeigt ja, dass unter den Top 10 die Hälfte Einsteiger Karten sind und selbst die Vega 8 liegt noch vor der GeForce 3080 Ti.

Testsysteme

Desktop

- intel Core i3 10105 (4C/8T, max. 4,4 GHz, UHD-630)

- 24 GB DDR4 @2.133

- OS: Kingston SNVS M2 NVMe 256 GB

- Games:

- intel P660 512 GB NVMe

- Sandisk 480 GB SATA

- Asus Prime B560M-A

- Endorfy Gehäuse u. AiO

- Grafikkarten:

- ASRock Radeon RX 6400

- Sapphire Nitro R9 Fury

- Power Color Red Devil Radeon RX Vega

- hp15s-eq0355ng

- Ryzen 5 3500U (4C/8T @3C/6T, max. 3,6 GHz)

- Radeon Vega 8 (300 - 1.200 MHz, 2GB)

- 2x 8 GB DDR4 @2.400

- Samsung OEM NVMe SSD 512 GB

Die Karten

Vega 56 -> R9 Fury -> RX 6400 -> intel DG1

Benchmarks

Kommen wir zu den Benchmarks. Diese sind so weit gestreut, wie möglich, da gerade die Vega 8 und die RX 6400 keine Performance Wunder sind, aber trotzdem ihre Daseinsberechtigung bei älteren Games haben.

Sämtliche Karten liefen nur im PCIe 4x Slot, ich wollte am Gehäuse jetzt nicht noch die zwei Slotblenden rausbrechen und ein Kabel neu verlegen, seht mir das bitte nach.

Final Fantasy XIV wurde nur in 1280x720 getestet, da hier der Monitor begrenzt. FullHD ist zwar möglich, aber dann sehe ich das Ergebnis nicht und sobald ich das Fenster verschiebe, schließt es sich.

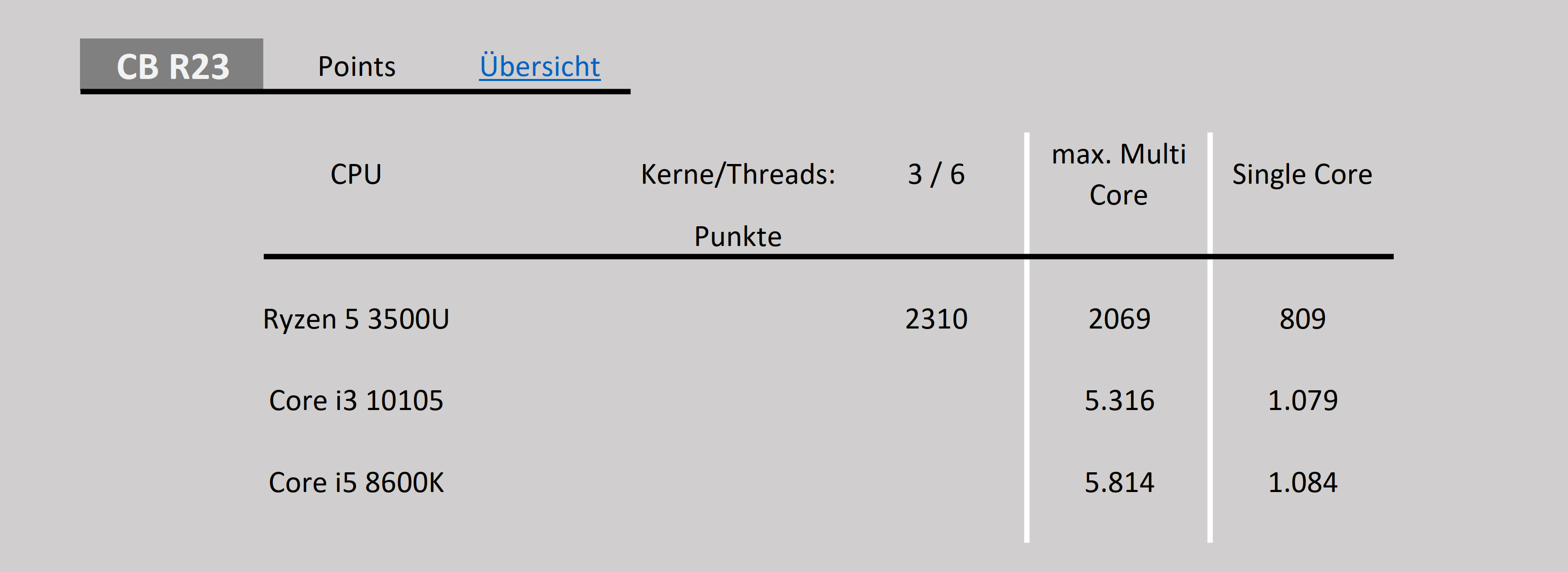

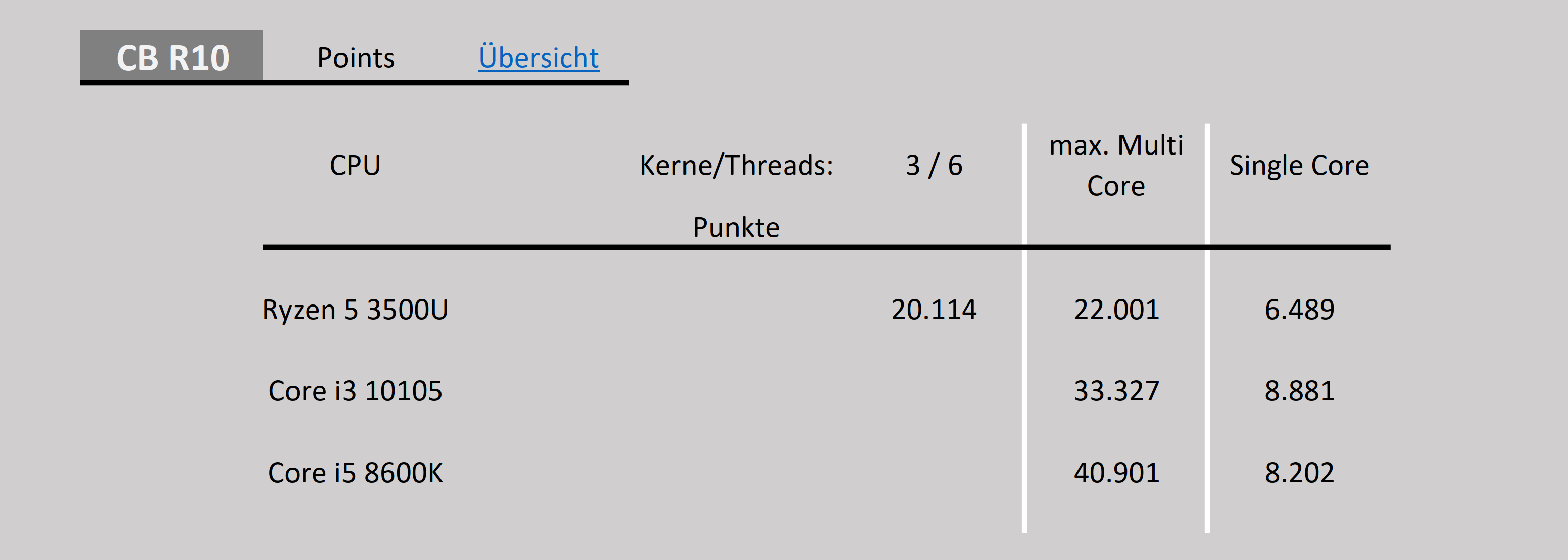

Benchmarks CPU

- Cinebench R10

- Cinebench R23

- Square

- Final Fantasy XIV

- Final Fantasy XV

- UL/Futuremark

- 3DMark (Dx 11 u. 12)

- 3DMark 03 (Dx 7, 8 u. 9),

- 3DMark 06 (Dx 9)

- 3DMark 11 (Dx 11)

- Unigine

- Superposition

- Superposition (alt)

- Heaven

- Sanctuary

- Tropics

- Geeks 3D

- Furmark

- Tessmark (Tesselation)

- Luxmark (CPU und/oder GPU)

- PLA Benchmark aus China (Unreal Engine 3, Dx11)

- GTA V (Dx 10 u. 11)

- Crytek

- Neon Noir (Raytracing über CPU)

Crysis Original

- Car Mechanic Simulator 2018

- Batman

Cinebench

abschließende Worte

Wie nicht anders zu erwarten, setzt sich die Vega an die Leistungsspitze. Trotz der modernen Fertigung und die Auslegung als Mobile GPU wird die kleine RX 6400 geschlagen.

Diese beißt sich auch an der alten Fury noch die Zähne aus, nur im 3DMark 06, bei 1280x1024 überholt sie und in GTA V kommt sie wenigstens in Schlagdistanz. Wenn man davon ausgeht, dass die RX 6500 XT 20% schneller ist, reicht selbst diese nicht. Erst die RX 6600 dürfte problemlos an der Fury vorbeiziehen.

Vega mobile bildet das absolute Schlusslicht. Aber die U-Prozessoren sind nun mal auf Sparsamkeit getrimmt.

Bei einigen Tests wurde eine GeForce RTX 3070 und eine intel DG1 als Vergleich mit herangezogen.

Weitere Benchmarkergbnisse verschiedener Grafikkarten Generationen:

GPU Generationen Benchmarks

Benchmarks, die jetzt noch unvollständig sind, werden nach und nach eingetragen. Genauso wie Download Quellen der einzelnen Benchmarks, sofern sie nicht hier im Downloadbereich gefunden werden.

Danke an @kryzs und @Hexxxer76 für das (flüchtige 😜 ) gegenlesen

Zuletzt bearbeitet:

(Benchmarks aktualisiert)