Man muss halt einfach bei den Fakten bleiben. Ein 14900KS mit PT ist schlechter als ein 12700K mit PT. Denn auch mit PT ist die angelegte Spannung zu hoch und führt zu höheren Taktratendrosselungen als bei einem 12700K, welcher von Werk aus allgemein ne niedrige Spannungskurve hat.

Klar hat er mehr Kerne als der 12700K. Diesen Vorteil kann er allerdings nicht nutzen, da er mit seinen mehr Kernen schneller im PT von 95W landet als ein 12700K, 12900K, 13600K, 13700K usw.

Dadurch sinkt der Takt aller Kerne ab. (Außer man nutzt nur Anwendungen welche den Fokus auf single und dualcore legen)

Und für 100% der spiele ist es irrelevant, ob ich 8P cores und 8E cores habe, oder ob 8P Cores und 16 E Cores.

Kein Spiel ist darauf ausgelegt auf 24C/32T zu skalieren. Und bis es dazu kommt ist diese Plattform eh massivst veraltet.

Zuallererst wird die Workload von games eh erst auf die 8P Cores gelagert. Die E cores sind nur support falls das game mit noch mehr Kernen skalieren kann oder für Hintergrundanwendungen. 8E cores als support + Hintergrundanwendungen sind aber mehr als genug. Zumal ein E-Core grob die Leistung eines 10700K cores hat. Da braucht kein Mensch für gaming 16E-Cores im Hintergrund. Sie erhöhen dadurch nur Leistungsaufnahme und Temperatur, ohne die Performance zu verbessern.

Fürs reine aktuelle gaming reicht jede aktuelle cpu zwischen 8 und 16 Kernen vollkommen aus. Alles darüber sieht aufm papier besser aus, aber ingame zeigt sich der nachteil dann, da die CPU sich selbst immer wieder drosselt.

Der Sinn solcher Cpus mit vielen E cores liegt eher im Bereich für Homeserver oder Produktive Arbeiten.

@derfernseher Aktuell fallen dir keine niedrigen Taktraten auf, da du im GPU Limit bist. Dadurch kommt die cpu erst gar nicht dazu, so viel leisten zu müssen. Das ganze ändert sich aber schlagartig, wenn du nur noch 1080p oder 1440p nutzt. Du wirst maximal im Cpu limit landen und deine cpu kann nicht mehr leisten, da sie beschnitten ist auf 95W. Sobald du das PT aber öffnest, hast du nen massiven verbrauch der in keinster Weise effizient noch gerechtfertigt ist.

Aktuell hast du einen 14900KS, welcher unterfordert ist, aufgrund des Gpu limits.

Du hättest selbige Framerates mit einer deutlich günstigeren CPU erreicht. Das ist einfach ein fakt.

Desweiteren ist ein PT alleine, nur Leistungspotenzialverschwendung.

Er könnte mit den richtigen Spannungseinstellungen und taktratenreduzierung im kleinen Maß, trotz PT viel mehr leisten, sofern er mal gefordert wird und die gpu nicht der limitierende Faktor ist.

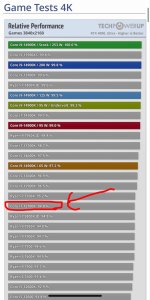

Mein 13700K ist im benchmark beim Multithreading wenn man die gleiche threadzahl von 24T vergleicht sogar schneller, als ein stock 14900KS, obwohl ich aktuell nur ein All core boost auf 5.4Ghz 1,15v und LLC6 habe und damit 300mhz niedriger als der KS im allcore takte (aber die 5,7ghz hält der KS auch nicht konstant und deswegen leistet er dann weniger). Wenn man es zu den kompletten 32T des KS vergleicht ist er wiederum langsamer als der KS. Logischerweise, da ihm ja 8 E cores fehlen.

Allein dadurch, dass er sich sich aber weder durch Leistungsaufnahme, noch Temperatur selbst drosselt überholt er aber den KS im direkten vergleich mit der gleichen Threadanzahl.

Der KS hat einfach eine zu hohe V-curve. Und zu viele "nutzlose kerne". In single-dualcore Anwendung ist der KS wieder schneller als mein 13er, da ich den nur bis 5,8GHz boosten lasse, da alles andere ineffiziente Spannungserhöhungen erfordern würde.