Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test AMD Ryzen Threadripper 7960X im Test: Der 24-Kern-Einsteiger im Workload- und Spiele-Benchmark

Blaze1987

Lt. Commander

- Registriert

- Sep. 2008

- Beiträge

- 1.056

@Wechhe @incurable @Dark Soul :

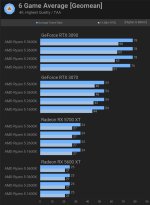

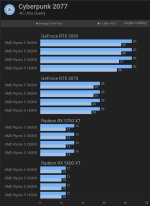

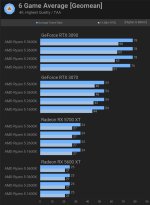

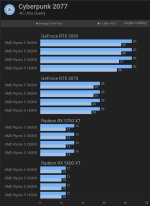

Fallls es für euch noch interessant sein sollte CPU Leistung @ 4K...

Interessant sind halt hier die 4K Benches für GPU limitierende Spiele.

Als Beispiel Cyberpunk @ RT und God of War.

Konsolen Ports / CPU limitierende Spiele sind auch dabei und dort bringt eine neue CPU natürlich was.

https://www.techpowerup.com/review/amd-ryzen-7-7800x3d/22.html (leider nur aktuelle CPUs / keine IPC oder PPC Benches - Min. FPS.)

Ansonsten sind keine IPC / PPC Benchmarks für Spiele (ausser PC - Games Hardware) zu finden, wo der CPU Takt & Ram Takt normalisiert wurde für einen guten Vergleich (auch Ram Takt und Bios / OS Settings).

Jedoch auch hier auf 720p, wo die Spiele halt immer im CPU Limit sind... Sinnlos.

https://www.pcgameshardware.de/CPU-...00X-Zen-3-Alder-Lake-IPC-Vergleich-1397753/2/

Reine 4K Benches:

https://www.anandtech.com/show/1874...0x3d-review-amd-s-fastest-gaming-processor/10

Reine 4K Benches mit m.E. die eindeutigsten GPU Limit Benches:

https://www.techspot.com/article/2201-four-years-of-ryzen-5-gpu-scaling/

1080P Benches (somit auch wieder im CPU Limit) by TechSpot:

https://www.techspot.com/article/2143-ryzen-5000-ipc-performance/

Im Hardwareluxx Forum gab es nur mal einen Vergleich bis Zen 3 für die IPC (keine Spiele!): https://www.hardwareluxx.de/community/threads/ipc-getestet-ryzen-haswell-e-und-co.1196016/page-3

Guru 3D aktuellere CPU Single Core IPC Chart @ 3,5 GHz (keine Spiele!): https://www.guru3d.com/review/intel-core-i7-13700k-review/page-8/

Ansonsten biete ich gerne an, dass ich meine CPUs im BIOS auf 3 GHz fest konfiguriere und falls es jemanden interessiert, der kann eine aktuelle Intel / Ryzen CPU genauso auf 3 GHz fest einstellen und den RAM Takt ggfls. auf 2133 MHz.

Dann könnte wir halbwegs vergleichen, wenn jeder einen Port Royale Durchlauf ausführt mit einer 4090 FE (Werkszustand).

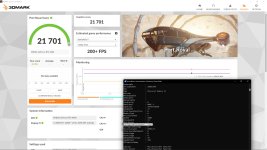

Ansonsten wie versprochen ein paar Benches:

Port Royale 4090 FE Referenz Score: 255496: https://www.gamestar.de/artikel/nvidia-geforce-rtx-4090-test,3385407.html

Mir fehlen daher ein wenig mehr als 6000 Points zur Referenz 4090 FE (was auch immer das dann in Min FPS wären).

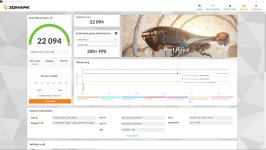

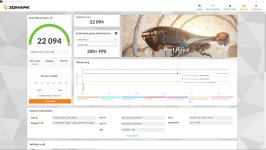

3DMark Port Royal 4090 FE UV

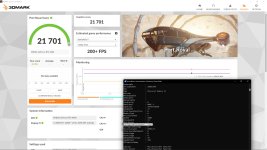

3DMark Port Royal 4090 FE Factory Default:

CineBench R23 MC (BIOS Default / Windows Balanced Energy Profile)

CineBench R23 SC (BIOS Default / Windows Balanced Energy Profile)

3DMark CPU Profile

Mehr kann ich vorerst nicht anbieten, falls überhaupt ehrliches Interesse bestehen sollte für einen IPC / PPC Vergleich.

Ansonsten, falls jemand Ready or Not besitzt, dort könnten wir mal mit identischen Grafikeinstellungen testen, unabhängig der IPC, wieviel mir (oder auch anderen) mit älteren CPUs für Min. FPS fehlen via Demo File (identischer Replay File) + CapFrameX Record...

Interessant fande ich bezüglich IPC Wikipedia (geht leider nur bis zum Jahr 2021 - keine Spiele!): https://en.wikipedia.org/wiki/Instructions_per_second

Fallls es für euch noch interessant sein sollte CPU Leistung @ 4K...

Interessant sind halt hier die 4K Benches für GPU limitierende Spiele.

Als Beispiel Cyberpunk @ RT und God of War.

Konsolen Ports / CPU limitierende Spiele sind auch dabei und dort bringt eine neue CPU natürlich was.

https://www.techpowerup.com/review/amd-ryzen-7-7800x3d/22.html (leider nur aktuelle CPUs / keine IPC oder PPC Benches - Min. FPS.)

Ansonsten sind keine IPC / PPC Benchmarks für Spiele (ausser PC - Games Hardware) zu finden, wo der CPU Takt & Ram Takt normalisiert wurde für einen guten Vergleich (auch Ram Takt und Bios / OS Settings).

Jedoch auch hier auf 720p, wo die Spiele halt immer im CPU Limit sind... Sinnlos.

https://www.pcgameshardware.de/CPU-...00X-Zen-3-Alder-Lake-IPC-Vergleich-1397753/2/

Reine 4K Benches:

https://www.anandtech.com/show/1874...0x3d-review-amd-s-fastest-gaming-processor/10

Reine 4K Benches mit m.E. die eindeutigsten GPU Limit Benches:

https://www.techspot.com/article/2201-four-years-of-ryzen-5-gpu-scaling/

1080P Benches (somit auch wieder im CPU Limit) by TechSpot:

https://www.techspot.com/article/2143-ryzen-5000-ipc-performance/

Im Hardwareluxx Forum gab es nur mal einen Vergleich bis Zen 3 für die IPC (keine Spiele!): https://www.hardwareluxx.de/community/threads/ipc-getestet-ryzen-haswell-e-und-co.1196016/page-3

Guru 3D aktuellere CPU Single Core IPC Chart @ 3,5 GHz (keine Spiele!): https://www.guru3d.com/review/intel-core-i7-13700k-review/page-8/

Ansonsten biete ich gerne an, dass ich meine CPUs im BIOS auf 3 GHz fest konfiguriere und falls es jemanden interessiert, der kann eine aktuelle Intel / Ryzen CPU genauso auf 3 GHz fest einstellen und den RAM Takt ggfls. auf 2133 MHz.

Dann könnte wir halbwegs vergleichen, wenn jeder einen Port Royale Durchlauf ausführt mit einer 4090 FE (Werkszustand).

Ansonsten wie versprochen ein paar Benches:

Port Royale 4090 FE Referenz Score: 255496: https://www.gamestar.de/artikel/nvidia-geforce-rtx-4090-test,3385407.html

Mir fehlen daher ein wenig mehr als 6000 Points zur Referenz 4090 FE (was auch immer das dann in Min FPS wären).

3DMark Port Royal 4090 FE UV

3DMark Port Royal 4090 FE Factory Default:

CineBench R23 MC (BIOS Default / Windows Balanced Energy Profile)

CineBench R23 SC (BIOS Default / Windows Balanced Energy Profile)

3DMark CPU Profile

Mehr kann ich vorerst nicht anbieten, falls überhaupt ehrliches Interesse bestehen sollte für einen IPC / PPC Vergleich.

Ansonsten, falls jemand Ready or Not besitzt, dort könnten wir mal mit identischen Grafikeinstellungen testen, unabhängig der IPC, wieviel mir (oder auch anderen) mit älteren CPUs für Min. FPS fehlen via Demo File (identischer Replay File) + CapFrameX Record...

Interessant fande ich bezüglich IPC Wikipedia (geht leider nur bis zum Jahr 2021 - keine Spiele!): https://en.wikipedia.org/wiki/Instructions_per_second

Timeline of instructions per second[edit]

| Processor / System | Dhrystone MIPS or MIPS, and frequency | D instructions per clock cycle | D instructions per clock cycle per core | Year | Source |

|---|---|---|---|---|---|

| AMD Ryzen Threadripper 3990X (64 core) | 2,356,230 MIPS at 4.35 GHz | 541.66 | 8.46 | 2020 | [102] |

| Silicon Recognition ZISC 78 | 8,600 MIPS at 33 MHz | 260.6 | 260.6 | 2000 | [63] |

| AMD Ryzen 9 3950X (16-core) | 749,070 MIPS at 4.6 GHz | 162.84 | 10.18 | 2019 | [101] |

| Intel Core i7 6950X (10-core) | 320,440 MIPS at 3.5 GHz | 91.55 | 9.16 | 2016 | [95] |

| Intel Core i9-9900K (8-core) | 412,090 MIPS at 4.7 GHz | 87.68 | 10.96 | 2018 | [101] |

| Intel Core i7 5960X (8-core) | 298,190 MIPS at 3.5 GHz | 85.2 | 10.65 | 2014 | [93] |

| AMD Ryzen 7 1800X (8-core) | 304,510 MIPS at 3.7 GHz | 82.3 | 10.29 | 2017 | [99] |

| Intel Core i5-11600K (6-core) | 346,350 MIPS at 4.92 GHz | 57.72 | 11.73 | 2021 | [103] |

| Intel Core i7-3960X (6-core) | 176,170 MIPS at 3.3 GHz | 53.38 | 8.89 | 2011 | [90] |

| Intel Core i7 Extreme Edition 980X (6-core) | 147,600 MIPS at 3.33 GHz | 44.7 | 7.46 | 2010 | [84] |

| Intel Core i7-8086K (6-core) | 221,720 MIPS at 5.0 GHz | 44.34 | 7.39 | 2018 | [100] |

| Namco System 21 (Galaxian³) (96-processor) | 1,660.386 MIPS at 40 MHz | 41.51 | 0.432 | 1990 | [46] |

| Intel Core i7 2600K (4-core) | 117,160 MIPS at 3.4 GHz | 34.45 | 8.61 | 2011 | [89] |

| Intel Core i7 4770K (4-core) | 133,740 MIPS at 3.9 GHz | 34.29 | 8.57 | 2013 | [88][91][92] |

| Sega Naomi Multiboard (32-processor) | 6,400 MIPS at 200 MHz | 32 | 1 | 1999 | [61] |

| Intel Core i7 875K | 92,100 MIPS at 2.93 GHz | 31.4 | 7.85 | 2011 | [80] |

| Intel Core i7 920 (4-core) | 82,300 MIPS at 2.93 GHz | 28.089 | 7.022 | 2008 | [80] |

| Intel Core i7 3770K (4-core) | 106,924 MIPS at 3.9 GHz | 27.4 | 6.9 | 2012 | [88] |

| ARM Cortex A73 (4-core) | 71,120 MIPS at 2.8 GHz | 25.4 | 6.35 | 2016 | |

| AMD FX-8150 (8-core) | 90,749 MIPS at 3.6 GHz | 25.2 | 3.15 | 2011 | [88] |

| Intel Core i5-2500K (4-core) | 83,000 MIPS at 3.3 GHz | 25.152 | 6.288 | 2011 | [87] |

| AMD Phenom II X6 1100T | 78,440 MIPS at 3.3 GHz | 23.7 | 3.9 | 2010 | [80] |

| AMD FX-8350 (8-core) | 97,125 MIPS at 4.2 GHz | 23.1 | 2.9 | 2012 | [88][91] |

| AMD FX-9590 (8-core) | 115,625 MIPS at 5.0 GHz | 23.1 | 2.9 | 2012 | [80] |

| Namco Magic Edge Hornet Simulator (36-processor) | 2,880 MIPS at 150 MHz | 19.2 | 0.533 | 1993 | [49] |

| Intel Core 2 Extreme QX9770 (4-core) | 59,455 MIPS at 3.2 GHz | 18.6 | 4.6 | 2008 | [76] |

| Intel Core 2 Extreme QX6700 (4-core) | 49,161 MIPS at 2.66 GHz | 18.4 | 4.6 | 2006 | [76] |

| SGI Onyx RealityEngine2 (36-processor) | 2,640 MIPS at 150 MHz | 17.6 | 0.489 | 1993 | [52] |

| AMD Phenom II X4 940 Black Edition | 42,820 MIPS at 3.0 GHz | 14.3 | 3.5 | 2009 | [83] |

| Nvidia Tegra 3 (Quad core Cortex-A9) | 13,800 MIPS at 1.5 GHz | 9.2 | 2.5 | 2011 | |

| Intel Core 2 Extreme X6800 (2-core) | 27,079 MIPS at 2.93 GHz | 9.2 | 4.6 | 2006 | [72] |

| AMD Athlon FX-60 (2-core) | 18,938 MIPS at 2.6 GHz | 7.3 | 3.6 | 2006 | [72] |

| AMD Athlon 64 3800+ X2 (2-core) | 14,564 MIPS at 2.0 GHz | 7.3 | 3.6 | 2005 | [72] |

Zuletzt bearbeitet:

Dark Soul

Lieutenant

- Registriert

- Juli 2007

- Beiträge

- 557

@Blaze1987

Vielen Dank für die Benches. Ja die 6k in Port Royal sind eben das CPU Limit was ich vermute.

Den Test von Techspot testet ja "nur" mit einer 3090 - da ist die 4090 ein Ganz anderes Biest dagegen.

Ich setze aktuell auf AM5 (Ryzen 7900) - oder eben TRX50 (Threadripper 7960X). Bei beiden Plattformen ist der minimale Speichertakt bei 300 MHz (DDR5-4800).

Aber auch da bin ich mir nicht sicher ob das Korrekt wäre so die IPC zu vergleichen...? Wir möchten ja ein Bottleneck messen, und wenn wir durch den Speicher eines künstlich erstellen, dann messen wir eben nicht die CPU. Der Ram müsste meiner Meinung nach Maximal sein, damit eben nicht dies der Limitierende Faktor ist. Durch zwei Runs mit min / optimalen Ram Einstellungen könnte man dies aber natürlich ausschliessen

Habe Ready or Not nicht, auch keine 4090 - für die Threadripper Kiste kommt aber eine die nächsten Tage! Da kann ich Benches starten für alles mögliche

@Jan Computerbase testet ja aber bald ein "GPU braucht CPU" mit Intel CPUs, dürfte ich den Wunsch anbringen, nach der Ganzen Diskussion, dass eine CPU der Broadwell Generation vertreten sein wird?

Vielen Dank für die Benches. Ja die 6k in Port Royal sind eben das CPU Limit was ich vermute.

Den Test von Techspot testet ja "nur" mit einer 3090 - da ist die 4090 ein Ganz anderes Biest dagegen.

Ich nehme an dass du 2133 MT/s meinst, der Speichertakt am Oszillator liegt nur bei 266MHz (266Hz x 8 = 2133MT/s --> DDR4-2133).Ansonsten biete ich gerne an, dass ich meine CPUs im BIOS auf 3 GHz fest konfiguriere und falls es jemanden interessiert, der kann eine aktuelle Intel / Ryzen CPU genauso auf 3 GHz fest einstellen und den RAM Takt ggfls. auf 2133 MHz.

Ich setze aktuell auf AM5 (Ryzen 7900) - oder eben TRX50 (Threadripper 7960X). Bei beiden Plattformen ist der minimale Speichertakt bei 300 MHz (DDR5-4800).

Aber auch da bin ich mir nicht sicher ob das Korrekt wäre so die IPC zu vergleichen...? Wir möchten ja ein Bottleneck messen, und wenn wir durch den Speicher eines künstlich erstellen, dann messen wir eben nicht die CPU. Der Ram müsste meiner Meinung nach Maximal sein, damit eben nicht dies der Limitierende Faktor ist. Durch zwei Runs mit min / optimalen Ram Einstellungen könnte man dies aber natürlich ausschliessen

Habe Ready or Not nicht, auch keine 4090 - für die Threadripper Kiste kommt aber eine die nächsten Tage! Da kann ich Benches starten für alles mögliche

@Jan Computerbase testet ja aber bald ein "GPU braucht CPU" mit Intel CPUs, dürfte ich den Wunsch anbringen, nach der Ganzen Diskussion, dass eine CPU der Broadwell Generation vertreten sein wird?

Blaze1987

Lt. Commander

- Registriert

- Sep. 2008

- Beiträge

- 1.056

Wenn Computerbase wieder CPU limitierende Spiele auswählt oder Spiele a la Hogwarts (oder allgemein Konsolen Ports Spiderman etc. / Anno was wahrscheinlich sehr gut mit CPU Takt skaliert etc.), keine native 4k Auflösung ohne max Details (also mit aktivieren FSR / DLSS) dann werden wir immer im CPU Limit bleiben.

Aus eigener Erfahrung kenn ich bisher nur Ready or Not, wo die 4090 überhaupt Luft schnappen muss und am ächzen ist. Auf Epic / 4K + 150 % Skalierung wäre ich wirklich mal auf einen Gegenvergleich gespannt.

Natürlich sollen auch immer Spiele im CPU Limit getestet werden (niedrige Auflösungen und bekannte Spiele dafür).

Auch diese Spieler möchten wissen, welche CPU für genau diese Spiele benötigt wird für Min FPS.

Aber bitte nicht nur und vor allem auch die andere Seite als Gegensatz / für die anderen Spieler / das andere Extrem!

Um mehr geht es doch nicht!

Sonst weiß niemand, ob jemand mit ner 4090 aufwärts (auch in Zukunft) im einen GPU limitierenden Spiel 3000 € oder mehr in einen neuen Sockel / CPU investieren sollte für die gewünschten Min FPS in Spielen, wo eine High End GPU auch mal richtig gefordert wird.

Traumhaft wären Spiele IPC Vergleiche auf 3 GHz / ähnlicher Ram Takt. Auch wenn ich mir das aufwendig / schwierig vorstelle.

Danke.

Aus eigener Erfahrung kenn ich bisher nur Ready or Not, wo die 4090 überhaupt Luft schnappen muss und am ächzen ist. Auf Epic / 4K + 150 % Skalierung wäre ich wirklich mal auf einen Gegenvergleich gespannt.

Natürlich sollen auch immer Spiele im CPU Limit getestet werden (niedrige Auflösungen und bekannte Spiele dafür).

Auch diese Spieler möchten wissen, welche CPU für genau diese Spiele benötigt wird für Min FPS.

Aber bitte nicht nur und vor allem auch die andere Seite als Gegensatz / für die anderen Spieler / das andere Extrem!

Um mehr geht es doch nicht!

Sonst weiß niemand, ob jemand mit ner 4090 aufwärts (auch in Zukunft) im einen GPU limitierenden Spiel 3000 € oder mehr in einen neuen Sockel / CPU investieren sollte für die gewünschten Min FPS in Spielen, wo eine High End GPU auch mal richtig gefordert wird.

Traumhaft wären Spiele IPC Vergleiche auf 3 GHz / ähnlicher Ram Takt. Auch wenn ich mir das aufwendig / schwierig vorstelle.

Danke.

Zuletzt bearbeitet:

Das Ding ist, wer in der Lage ist die Werte zu lesen, der wird aus einem Low Res Bench wie 720p die richtigen Schlüsse ziehen können. Während aber Niemand in der Lage ist, aus einem GPU Limit zu sehen, wo die CPU zu einem Problem wird.Blaze1987 schrieb:Aber bitte nicht nur und vor allem auch die andere Seite als Gegensatz / für die anderen Spieler / das andere Extrem!

Um mehr geht es doch nicht!

Exakt das ist der Grund, warum es Low Res Benches bei CPU Vergleichen gibt.

Es ist und war nie die Intention in Benches von CPUs oder GPUs Aussagen zur Lauffähigkeit im Sinne von so udn so viele FPS zu bringen.Blaze1987 schrieb:Sonst weiß niemand, ob jemand mit ner 4090 aufwärts (auch in Zukunft) im einen GPU limitierenden Spiel 3000 € oder mehr in einen neuen Sockel / CPU investieren sollte für die gewünschten Min FPS in Spielen, wo eine High End GPU auch mal richtig gefordert wird.

Warum? Weil es schlicht von den Settings und vom Rest des Systems abhängt. Niemand braucht in Benches absolute FPS. Das einzige was man benötigt sind relative Werte zueinander.

CPU A ist so und so viel schneller wie CPU B - wenn du nun ein GPU Upgrade durchführst, vorher aber gerade so mit ach und krach ins GPU Limit gelaufen bist, dann wird die so und so viel schnellere CPU dir also so und so viel "Luft" nach oben bringen.

Das ganze ist ein lebender Prozess. Die GPU Leistung steigt im Schnitt schneller als die CPU Leistung. Gleichsam steigt die Anforderung der Gamer an die GPU über die selbe Zeit (mehr Auflösung, mehr Details) und die Games fordern durch neue Titel auch immer mehr.

Benches sind immer ein Wert zur Messzeit und haben dort Gültigkeit. In einem Jahr können Titel am Markt sein, die komplett andere Anforderungen definieren... (siehe RT bspw. oder via DLSS/FSR auf einmal niedrigere Auflösung in der Basis)

Du kannst in fast jedem Titel die Anforderung in ein GPU Limit drehen und damit die CPU weitestgehend aus dem Fokus nehmen. Aber was bringt dir das? Ich hab nix von "8k" Auflösung per DSR/VSR auf meinem UHD Screen, wenn ich dann war GPU limitiert bin, die CPU wurst egal ist, aber ich nur noch 30 FPS hab... Ein Teil der im Schnitt gesteigerten Anforderungen ist es eben, dass gerade im Gaming 100/120/144 und noch mehr Hz durchaus die Regel sind. Die GPU ins Limit zu prügeln hilft dir für so eine Anforderung exakt gar nicht.

Wozu?Blaze1987 schrieb:Traumhaft wären Spiele IPC Vergleiche auf 3 GHz / ähnlicher Ram Takt. Auch wenn ich mir das aufwendig / schwierig vorstelle.

Was bringt das?

Aktuelle CPUs takten annähernd 6GHz - wozu sollte man das halbieren?

Damit vergleicht man auch keine IPC, weil ihr ja immer reale Anwendungen messen wollt und diese sind nunmal von mehr als nur dem Core Takt beeinflusst. Bei AMD bspw. die IF Taktrate, die den Cachespeed beeinflusst, was bspw. bei Games sehr viel Einfluss auf die Leistung hat. Siehe dazu Zen2 und 3 OC Vergleiche mit hohem IF Clock.

Wenn es ein paar MHz Differenz wären, OK, aber so drastisch dass man auf 3GHz runter geht, ergibt heutzutage keinen Sinn.

Blaze1987

Lt. Commander

- Registriert

- Sep. 2008

- Beiträge

- 1.056

@fsonne:

Man kann eben nicht jedes Spiel zu einem GPU Limit einstellen, wenn man mit GSync / Freesync spielt (als Beispiel 120 Hz).

Das weiß ich.

Beispiele:

Company of Heroes 3

Insurgency Sandstorm

Counter Strike 2

Wenn du Sinn von einer IPC / PPC Messung in Frage stellst, hast du mich nicht verstanden. Oder möchtest du nicht?

Nicht jedes Spiel skaliert linear mit Takt oder Ram Geschwindigkeiten / Latenzen / Bandbreite (R/RW) .

Da können auch je nach Spiel andere Faktoren dazu beitragen.

Genauso sollte man ehrlicherweise immer mehrere Einblicke gewähren und nicht einen GPU benötigt CPU Test veröffentlichen, wo man nur im CPU Limit testet.

Anders rum natürlich genauso.

Findest du es nicht etwas seltsam, wenn ich mit 10+ Jahre alter (nicht Gaming optimierten) CPU im Port Royale mit einer 4090 FE "nur" (noch nicht einmal) 6000 Punkte liegen lasse? Selbst dort, befinde ich mich in einem Bottleneck, aber das CPU Limit muss hier schon gewaltig gering sein.

Und trotzdem wird es viel zu oft behauptet (vor allem in Kaufberatungen) , dass eine schnelle GPU "immer" egal mit welchen Grafikeinstellungen (selbst wenn das Ziel 120 @Hz mit maximalen Qualitätseinstellungen und Auflösung ) die schnellste CPU verlangt.

Bezüglich ein Spiel / Spiele ins GPU Limit zu setzen:

Wenn ich mit den maximalsten Grafikeinstellungen (als Beispiel) in Ready or Not meine 80 - 130 FPS erreiche und ich mal zur Abwechslung auch eine 4090 ausreizen kann bzw. die schon zu langsam ist, ist das nicht in Ordnung und vor allem kein reguläres / reales Nutzerprofil?

Warum kauft man sich denn die schnellste GPU?

Damit ich im CPU Limit bleibe und dafür visuelle Abstriche in Kauf nehme?

Es mag ja sein, dass es genügend Spieler gibt, welche gerne immer (in 1080 P) 144 / 200 / 300 FPS besitzen wollen.

Aber es gibt auch genügend Spieler welche Ihre Spiele für die Immersion so hoch knallen wie möglich und je nach Spiel trotzdem ihre Wunsch FPS erreichen und via GSync / Freesync ein sauberes Spielerlebnis genießen.

Und für diese ist die IPC von CPUs sehr wohl wichtig, aber vielleicht hat die CPU ja überhaupt keine Aussagekraft auf die Min FPS (1% Low oder 95 %). Da nicht jedes Spiel überhaupt mit mehr Takt / neue Architekturen, vor allem im GPU Limit, skaliert.

Genauso, wie hoch der Einfluss einer aktuellen / schnellen CPU für die schnellste GPU auf max. Grafikeinstellungen (RT lass ich jetzt mal raus) überhaupt ist.

Denn sonst holt man sich keinen neuen Sockel (1000 € Board, 500 € Ram, 3000 € CPU für einen aktuellen TR) und investiert lieber in andere Hardware (GPU, Massenspeicher etc.).

Oder ist es nur das Ziel, zu blenden / eine Seite der Medaille zu beleuchten?

Sieh dir doch die aktuelken 4K Benches von Andantech an...?!

Sind das für jeden Spieler zu wenige FPS im 95 % Bereich?

Oder ein unrealistisches Szenario, wo CPUs im GPU Limit mit einem Preisunterschied von fast 500 € getestet werden und man für diesen Spieler dann die schnellste CPU empfiehlt, obwohl für 120 Hz die schnellste GPU vielleicht mehr Sinn ergeben würde?

Auch wenn es nur ein Spiel von vielen ist, zeigt als Beispiel Ready or Not genau das auf was ich meine:

https://www.youtube.com/live/8dfjnrbnKdI?si=UInPKk7RN-v2rXAR

Hier wird nur 100 % Skalierung genutzt.

Die genutzte CPU ist ein 13900k.

Sieht die die 1% Low (Min FPS) doch mal an: 55 FPS ohne DLSS (welches für mich persönlich die Grafikqualität massiv verschlechtert wenn man selbst davor sitzt @ 45 / 55 Zoll oder höher).

Meinst du wirklich da bringt eine schnellere CPU / neuer Sockel etwas? Vielleicht? Oder doch nicht?

Und würde da einem Spieler für eine Kaufberatung nur ein 720 p / oder unterhalb von max Settings ein Test etwas bringen?

(Wenn nur im CPU Limit getestet wird, wird man das mit Sicherheit nicht sauber abgrenzen können. Da hilft nur ein Kreuztest im GPU Limit. Also beides!)

Werden die 1 % Low FPS von dem CPU Limit diktiert oder doch eher von der aktuellsten schnellsten GPU überhaupt?

Also mir persönlich nicht! Das würde das Bild einfach nur verzerren! Solange nur eine Seite der Medaille beleuchtet wird.

Die Immersion ist nun mal auf max. Settings für die meisten Spieler höher.

In diesem Beispiel weiß man nicht was limitiert.

Wahrscheinlich die 4090 oder die Spiele Engine (eher ersteres).

Und trotzdem ist es genau für diese Spieler relevant, ob sich eine schnelle CPU überhaupt lohnt oder man sich lieber Geld zurücklegt für die nächsten Grafikkarten Generationen und nicht für einen neuen Sockel inkl. CPU für mindestens 1500 € im Desktop Bereich oder fast 4000 € oder mehr im HEDT Bereich ...!

Man kann eben nicht jedes Spiel zu einem GPU Limit einstellen, wenn man mit GSync / Freesync spielt (als Beispiel 120 Hz).

Das weiß ich.

Beispiele:

Company of Heroes 3

Insurgency Sandstorm

Counter Strike 2

Wenn du Sinn von einer IPC / PPC Messung in Frage stellst, hast du mich nicht verstanden. Oder möchtest du nicht?

Nicht jedes Spiel skaliert linear mit Takt oder Ram Geschwindigkeiten / Latenzen / Bandbreite (R/RW) .

Da können auch je nach Spiel andere Faktoren dazu beitragen.

Genauso sollte man ehrlicherweise immer mehrere Einblicke gewähren und nicht einen GPU benötigt CPU Test veröffentlichen, wo man nur im CPU Limit testet.

Anders rum natürlich genauso.

Findest du es nicht etwas seltsam, wenn ich mit 10+ Jahre alter (nicht Gaming optimierten) CPU im Port Royale mit einer 4090 FE "nur" (noch nicht einmal) 6000 Punkte liegen lasse? Selbst dort, befinde ich mich in einem Bottleneck, aber das CPU Limit muss hier schon gewaltig gering sein.

Und trotzdem wird es viel zu oft behauptet (vor allem in Kaufberatungen) , dass eine schnelle GPU "immer" egal mit welchen Grafikeinstellungen (selbst wenn das Ziel 120 @Hz mit maximalen Qualitätseinstellungen und Auflösung ) die schnellste CPU verlangt.

Bezüglich ein Spiel / Spiele ins GPU Limit zu setzen:

Wenn ich mit den maximalsten Grafikeinstellungen (als Beispiel) in Ready or Not meine 80 - 130 FPS erreiche und ich mal zur Abwechslung auch eine 4090 ausreizen kann bzw. die schon zu langsam ist, ist das nicht in Ordnung und vor allem kein reguläres / reales Nutzerprofil?

Warum kauft man sich denn die schnellste GPU?

Damit ich im CPU Limit bleibe und dafür visuelle Abstriche in Kauf nehme?

Es mag ja sein, dass es genügend Spieler gibt, welche gerne immer (in 1080 P) 144 / 200 / 300 FPS besitzen wollen.

Aber es gibt auch genügend Spieler welche Ihre Spiele für die Immersion so hoch knallen wie möglich und je nach Spiel trotzdem ihre Wunsch FPS erreichen und via GSync / Freesync ein sauberes Spielerlebnis genießen.

Und für diese ist die IPC von CPUs sehr wohl wichtig, aber vielleicht hat die CPU ja überhaupt keine Aussagekraft auf die Min FPS (1% Low oder 95 %). Da nicht jedes Spiel überhaupt mit mehr Takt / neue Architekturen, vor allem im GPU Limit, skaliert.

Genauso, wie hoch der Einfluss einer aktuellen / schnellen CPU für die schnellste GPU auf max. Grafikeinstellungen (RT lass ich jetzt mal raus) überhaupt ist.

Denn sonst holt man sich keinen neuen Sockel (1000 € Board, 500 € Ram, 3000 € CPU für einen aktuellen TR) und investiert lieber in andere Hardware (GPU, Massenspeicher etc.).

Oder ist es nur das Ziel, zu blenden / eine Seite der Medaille zu beleuchten?

Sieh dir doch die aktuelken 4K Benches von Andantech an...?!

Sind das für jeden Spieler zu wenige FPS im 95 % Bereich?

Oder ein unrealistisches Szenario, wo CPUs im GPU Limit mit einem Preisunterschied von fast 500 € getestet werden und man für diesen Spieler dann die schnellste CPU empfiehlt, obwohl für 120 Hz die schnellste GPU vielleicht mehr Sinn ergeben würde?

Auch wenn es nur ein Spiel von vielen ist, zeigt als Beispiel Ready or Not genau das auf was ich meine:

https://www.youtube.com/live/8dfjnrbnKdI?si=UInPKk7RN-v2rXAR

Hier wird nur 100 % Skalierung genutzt.

Die genutzte CPU ist ein 13900k.

Sieht die die 1% Low (Min FPS) doch mal an: 55 FPS ohne DLSS (welches für mich persönlich die Grafikqualität massiv verschlechtert wenn man selbst davor sitzt @ 45 / 55 Zoll oder höher).

Meinst du wirklich da bringt eine schnellere CPU / neuer Sockel etwas? Vielleicht? Oder doch nicht?

Und würde da einem Spieler für eine Kaufberatung nur ein 720 p / oder unterhalb von max Settings ein Test etwas bringen?

(Wenn nur im CPU Limit getestet wird, wird man das mit Sicherheit nicht sauber abgrenzen können. Da hilft nur ein Kreuztest im GPU Limit. Also beides!)

Werden die 1 % Low FPS von dem CPU Limit diktiert oder doch eher von der aktuellsten schnellsten GPU überhaupt?

Also mir persönlich nicht! Das würde das Bild einfach nur verzerren! Solange nur eine Seite der Medaille beleuchtet wird.

Die Immersion ist nun mal auf max. Settings für die meisten Spieler höher.

In diesem Beispiel weiß man nicht was limitiert.

Wahrscheinlich die 4090 oder die Spiele Engine (eher ersteres).

Und trotzdem ist es genau für diese Spieler relevant, ob sich eine schnelle CPU überhaupt lohnt oder man sich lieber Geld zurücklegt für die nächsten Grafikkarten Generationen und nicht für einen neuen Sockel inkl. CPU für mindestens 1500 € im Desktop Bereich oder fast 4000 € oder mehr im HEDT Bereich ...!

Zuletzt bearbeitet:

Jo 200 fps, da machen ich einen cut. Ich bin der egal was kommt bei 144 Hz mit 144 fps user. Die games von mir könnten alle mehr fps aber das juckt mich nicht.

Und darum ist so eine Plattform mehr für Arbeit gut. Allerdings wäre es bei mir 3000 € nur für ein Programm was damit nach oben skaliert wirklich nutzbar. Ich würde also dann viel Geld für eine Anwendung wenn alles doch besser skaliert als gedacht wenn alles gut geht, ausgeben wo dann 15 % mehr leistung hat als die mainstream Plattform für 1400€. Nur blöd das mein Programm Probleme mit Windows 11 hat. Das setzt ja diese Plattform voraus.

Das erklärt auch warum der threadripper 7960x so ne schlechte Leistung abliefert. Der 5965wx lief unter windows 10 und darum ist diese CPU auch schneller gewesen.

Ich finde es total bescheuert warum man windows 11 als Pflicht sieht und windows 10 ausschließt.

Aber gut amd wird es schon wissen. Villeicht hilft Windows 12 ja damit das ich so ein Problem nicht mehr habe.

Wobei mit ner aktuellen Version war die Leistung normal gewesen. Also kann man sagen irgendwann bringt ne alte Software auch nix mehr. Das erklärt auch warum alte games auf Windows 10 teilweise Probleme haben aber auf einer ältere betriebsystem alles in Ordnung ist. Mit Windows 11 verbindet mich jedoch nix.

Damit disqualifiziert sich leider diese threadripper Plattform sich selbst,was ich echt schade finde.

Der es testet wird noch andere Tests machen. Und wenn mein verdacht richtig liegt müsste die alte Version fast die selbe Leistung erreichen wie die neue.

Nun ja es hat schon seinen Grund warum ich warte, weil genau solche Probleme will ich nicht haben. Nen System soll ohne Probleme laufen und das tut es ja eben nicht. Brauche ja ne ordentliche CPU Leistung. Am Geld wird es so langsam auch nicht scheitern. Wenn ich es richtig anstelle dann schaffe ich mit so 2500 € auch ein threadripper System. Aber wozu wenn bald Zen 5 vor der Türe steht. Die Leistung wird auf jedenfall nicht auf der Stelle treten das ist sicher.

Und darum ist so eine Plattform mehr für Arbeit gut. Allerdings wäre es bei mir 3000 € nur für ein Programm was damit nach oben skaliert wirklich nutzbar. Ich würde also dann viel Geld für eine Anwendung wenn alles doch besser skaliert als gedacht wenn alles gut geht, ausgeben wo dann 15 % mehr leistung hat als die mainstream Plattform für 1400€. Nur blöd das mein Programm Probleme mit Windows 11 hat. Das setzt ja diese Plattform voraus.

Das erklärt auch warum der threadripper 7960x so ne schlechte Leistung abliefert. Der 5965wx lief unter windows 10 und darum ist diese CPU auch schneller gewesen.

Ich finde es total bescheuert warum man windows 11 als Pflicht sieht und windows 10 ausschließt.

Aber gut amd wird es schon wissen. Villeicht hilft Windows 12 ja damit das ich so ein Problem nicht mehr habe.

Wobei mit ner aktuellen Version war die Leistung normal gewesen. Also kann man sagen irgendwann bringt ne alte Software auch nix mehr. Das erklärt auch warum alte games auf Windows 10 teilweise Probleme haben aber auf einer ältere betriebsystem alles in Ordnung ist. Mit Windows 11 verbindet mich jedoch nix.

Damit disqualifiziert sich leider diese threadripper Plattform sich selbst,was ich echt schade finde.

Der es testet wird noch andere Tests machen. Und wenn mein verdacht richtig liegt müsste die alte Version fast die selbe Leistung erreichen wie die neue.

Nun ja es hat schon seinen Grund warum ich warte, weil genau solche Probleme will ich nicht haben. Nen System soll ohne Probleme laufen und das tut es ja eben nicht. Brauche ja ne ordentliche CPU Leistung. Am Geld wird es so langsam auch nicht scheitern. Wenn ich es richtig anstelle dann schaffe ich mit so 2500 € auch ein threadripper System. Aber wozu wenn bald Zen 5 vor der Türe steht. Die Leistung wird auf jedenfall nicht auf der Stelle treten das ist sicher.

Blaze1987

Lt. Commander

- Registriert

- Sep. 2008

- Beiträge

- 1.056

@Dark Soul:

Bewusst für dich gebencht und jedem anderen, welcher meint, das CPU Takt alleine / ggfls. Architekturen im GPU Limit eine (wesentliche) Rolle spielen:

Test: Mindestens 1 GHz weniger CPU Takt aber grob. 300 MHz mehr D-Ram Takt:

Port Royal @ 2400 MHz Ram Takt & Default CPU Takt (3,6 Ghz für ein Core) & 4090 FE Factory Default:

20321 Points

Jetzt wird dein (immer wieder angesprochene Vermutung) CPU Bootleneck abgegrenzt:

Port Royal @ 2400 MHz Ram Takt & Default CPU Takt @ 2,4 Ghz festgenagelt (Intel Xeon Turbo deaktiviert / kann leider keinen Mutlipier beim E5-26XX konfigurieren) & 4090 FE Factory Default:

22094 Points

Ich hoffe, nun ist ersichtlich, warum man beide Extreme (von mir aus alles: 720p / 1080p / 1440p / 4K / max settings @ 60 Hz / 120 Hz / 144 Hz / Unlimited FPS) für einen Test (egal ob GPU oder CPU!) testen sollte, falls man überhaupt einen Artikel so nennen sollte "GPU benötigt CPU" / benötigte CPU Leistung in Relation setzen sollte.

Vor allem, wenn so ein Test auf einmal als Referenz gelten soll (und dann als Grundlage für eine Kaufberatung genutzt wird - das ist das Schlimmste von allen - ist mir doch genau gestern hier passiert!), welche CPU benötige ich, wenn ich eine 4090 befeuern möchte.

Sollte das Fazit dann nicht heißen: Kommt auf das Spiel und deine Einstellungen an?

Oder noch besser: Im GPU Limit, können auch ganz andere Faktoren auschlaggebend sein?!

In den getesteten Spielen hatte dies im GPU Limit eine hohe / mittlere Auswirkung der Min FPS (1% / 95 %) bzw. @ Hz Zahl XY....

&

In den bekannten CPU limitierenden Spielen (wie viele gibt es davon nochmal?!) hat dies eine hohe / mittlere Auswirkung der Min FPS (1% / 95 %) bzw. @ Hz Zahl XY... bei einer 4090 @ 60 Hz / 120 Hz / 144 Hz / Unlimited FPS?

Und jetzt wäre ein IPC / PPC Vergleich spannend + Einfluss des D-Rams!

In meinen speziellen Fall, ist davon auszugehen, dass die schlechten D-Ram Latenzen und die niedrige Frequenz den Referenz Portal Royal Score stark beeinflussen.

Was für reg. ECC RDIMM nicht erstaunen sollte.

Hätte ich 2x E5-1680 v4 + CPUs und schnellen UDIMM, würde ich mit ziemlicher Sicherheit den 4090 FE Referenz Score näher kommen / wenn nicht sogar treffen.

Leider komme ich nicht über 2133 MTs / 2400 MHz Ram Takt mit den RDIMMs.

Hätte gerne weiter gemacht.

PS. Wenn der RDIMM @ 2667 MHz konfiguriert wird (CPU weiterhin @ 2,4 Ghz und die 4090 FE weiterhin auf Factory Defaults), hole ich nichts mehr raus. Vermutlich steigen die Latenzen - oder eher der Xeon lässt einfach nicht mehr zu:

PPS.

Jau - bei 2400 MHz / effektiv 2133 MTs D-RAM ist bei mir Schluss. Ich kann den BIOS auch 3200 MHz vorgeben. Aber die werden ignoriert. Schade, schade...

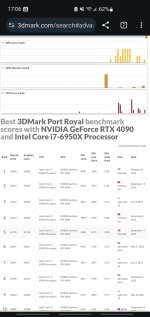

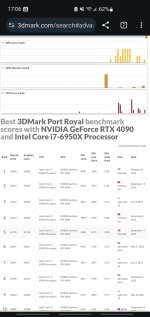

Das meine Vermutung stimmt, zeigen 3DMark Ergebnisse mit dem Intel Core i7-6950x mit UDIMM @ 3200 MHz und der RTX 4090: http://www.3dmark.com/pr/1833406

Selbst auf X99 mit guten UDIMM (3200 MHz) sind die Referenz Scores mit einer 4090 möglich.

Leider finde ich keinen i7-6950X mit maximal 3,6 GHz und 3200 MHz UDIMM.

Immerhin kommt der hier dem Referenz 4090 Score sehr Nahe mit 3,4 GHz (aber leider der RAM auf 2200 MHz) und geringen 4090 Boost :

http://www.3dmark.com/pr/2726153

Bewusst für dich gebencht und jedem anderen, welcher meint, das CPU Takt alleine / ggfls. Architekturen im GPU Limit eine (wesentliche) Rolle spielen:

Test: Mindestens 1 GHz weniger CPU Takt aber grob. 300 MHz mehr D-Ram Takt:

Port Royal @ 2400 MHz Ram Takt & Default CPU Takt (3,6 Ghz für ein Core) & 4090 FE Factory Default:

20321 Points

Jetzt wird dein (immer wieder angesprochene Vermutung) CPU Bootleneck abgegrenzt:

Port Royal @ 2400 MHz Ram Takt & Default CPU Takt @ 2,4 Ghz festgenagelt (Intel Xeon Turbo deaktiviert / kann leider keinen Mutlipier beim E5-26XX konfigurieren) & 4090 FE Factory Default:

22094 Points

Ich hoffe, nun ist ersichtlich, warum man beide Extreme (von mir aus alles: 720p / 1080p / 1440p / 4K / max settings @ 60 Hz / 120 Hz / 144 Hz / Unlimited FPS) für einen Test (egal ob GPU oder CPU!) testen sollte, falls man überhaupt einen Artikel so nennen sollte "GPU benötigt CPU" / benötigte CPU Leistung in Relation setzen sollte.

Vor allem, wenn so ein Test auf einmal als Referenz gelten soll (und dann als Grundlage für eine Kaufberatung genutzt wird - das ist das Schlimmste von allen - ist mir doch genau gestern hier passiert!), welche CPU benötige ich, wenn ich eine 4090 befeuern möchte.

Sollte das Fazit dann nicht heißen: Kommt auf das Spiel und deine Einstellungen an?

Oder noch besser: Im GPU Limit, können auch ganz andere Faktoren auschlaggebend sein?!

In den getesteten Spielen hatte dies im GPU Limit eine hohe / mittlere Auswirkung der Min FPS (1% / 95 %) bzw. @ Hz Zahl XY....

&

In den bekannten CPU limitierenden Spielen (wie viele gibt es davon nochmal?!) hat dies eine hohe / mittlere Auswirkung der Min FPS (1% / 95 %) bzw. @ Hz Zahl XY... bei einer 4090 @ 60 Hz / 120 Hz / 144 Hz / Unlimited FPS?

Und jetzt wäre ein IPC / PPC Vergleich spannend + Einfluss des D-Rams!

In meinen speziellen Fall, ist davon auszugehen, dass die schlechten D-Ram Latenzen und die niedrige Frequenz den Referenz Portal Royal Score stark beeinflussen.

Was für reg. ECC RDIMM nicht erstaunen sollte.

Hätte ich 2x E5-1680 v4 + CPUs und schnellen UDIMM, würde ich mit ziemlicher Sicherheit den 4090 FE Referenz Score näher kommen / wenn nicht sogar treffen.

Leider komme ich nicht über 2133 MTs / 2400 MHz Ram Takt mit den RDIMMs.

Hätte gerne weiter gemacht.

PS. Wenn der RDIMM @ 2667 MHz konfiguriert wird (CPU weiterhin @ 2,4 Ghz und die 4090 FE weiterhin auf Factory Defaults), hole ich nichts mehr raus. Vermutlich steigen die Latenzen - oder eher der Xeon lässt einfach nicht mehr zu:

PPS.

Jau - bei 2400 MHz / effektiv 2133 MTs D-RAM ist bei mir Schluss. Ich kann den BIOS auch 3200 MHz vorgeben. Aber die werden ignoriert. Schade, schade...

Das meine Vermutung stimmt, zeigen 3DMark Ergebnisse mit dem Intel Core i7-6950x mit UDIMM @ 3200 MHz und der RTX 4090: http://www.3dmark.com/pr/1833406

Selbst auf X99 mit guten UDIMM (3200 MHz) sind die Referenz Scores mit einer 4090 möglich.

Leider finde ich keinen i7-6950X mit maximal 3,6 GHz und 3200 MHz UDIMM.

Immerhin kommt der hier dem Referenz 4090 Score sehr Nahe mit 3,4 GHz (aber leider der RAM auf 2200 MHz) und geringen 4090 Boost :

http://www.3dmark.com/pr/2726153

Zuletzt bearbeitet:

dazu müsste man eine Vergleichbar Plattform haben um das zu testen.Naja ich selbst hatte früher auch so eine CPU gehabt.Die war zwar wirklich besser gewesen als der i7 6950x. So ein System habe ich selbst noch.Könnte also rein Theoretisch die selbe CPU wie die 2699v4 rein stecken.Nur halt eben keine dieser GPU.

Und naja bei reiner CPU Leistung ist diese um einiges schlechter.Entspricht einer i9 7900 von der Leistung her.Ein i9 7920x war schon etwas schneller gewesen.Der Ryzen 7 1800x was auf dem selben level wie der 2699v4.Dieser packte bei mir damals Allcore nur 2,8 ghz.Und ich habe dann HT abgeschaltet das es dann 22 Threads sind weil schon damals meine Software mit 44 Threadeds Probleme hatte.Wenn ich HT ein hatte,war dann der 6950x sogar schneller gewesen.

In Spielen war diese CPU auch schlechter weil ich nur 4 Kern Spiele hatte.

Da war dann der i5 2500k sogar fast gleich schnell gewesen.

Anderst als heute war damals die Xeon CPU eher nicht zum Zocken geeigent.Auch wenn der Takt mit noch weniger Kernen Auslastung gestiegen war.Damals wie heute zockte ich nur in Full HD mit 60 HZ.

Naja ich muss überegen welche GPU ich da drinnen hatte.Denke mal so eine gtx 1060 oder kurzfristig sogar eine GTX Titan 6 gb wohl halt die erste Titan.Die war super Teuer gewesen.Geholfen hat mir das aber wenig.In dem anderen System war eine gtx 750 ti drinnen.

Das alles änderte sich gewiss in Zischen weil Spiele von 2018 sind anspruchsvoller und da dürfte es nun dank der GPU eine Steigerung erfahren haben.DIe Titan fuhr ja schon damals mit der gtx 750 ti schlitten,aber nun ist es gewiss mehr als das doppelte an Leistung.

Und ram unterschiede gibt es ja auch.Das eine System verwendet ddr3 und das andere DDR4.

Und ich hatte ddr4 auf 2133 mhz gestellt.Die Quadchannel brauchte in Games im Grunde damals mir garanix.

Und verloren gegen einen ddr3 1866 mhz mit Dualchannel.

Wie es in Zukunft weiter geht,denke mal DDR5 wird da gewiss auch noch mal einen Plus machen für die Games wo vom extra Ram profitieren.

Gillt gewiss ja auch für den Threadripper,nehme ich mal an.

Und naja bei reiner CPU Leistung ist diese um einiges schlechter.Entspricht einer i9 7900 von der Leistung her.Ein i9 7920x war schon etwas schneller gewesen.Der Ryzen 7 1800x was auf dem selben level wie der 2699v4.Dieser packte bei mir damals Allcore nur 2,8 ghz.Und ich habe dann HT abgeschaltet das es dann 22 Threads sind weil schon damals meine Software mit 44 Threadeds Probleme hatte.Wenn ich HT ein hatte,war dann der 6950x sogar schneller gewesen.

In Spielen war diese CPU auch schlechter weil ich nur 4 Kern Spiele hatte.

Da war dann der i5 2500k sogar fast gleich schnell gewesen.

Anderst als heute war damals die Xeon CPU eher nicht zum Zocken geeigent.Auch wenn der Takt mit noch weniger Kernen Auslastung gestiegen war.Damals wie heute zockte ich nur in Full HD mit 60 HZ.

Naja ich muss überegen welche GPU ich da drinnen hatte.Denke mal so eine gtx 1060 oder kurzfristig sogar eine GTX Titan 6 gb wohl halt die erste Titan.Die war super Teuer gewesen.Geholfen hat mir das aber wenig.In dem anderen System war eine gtx 750 ti drinnen.

Das alles änderte sich gewiss in Zischen weil Spiele von 2018 sind anspruchsvoller und da dürfte es nun dank der GPU eine Steigerung erfahren haben.DIe Titan fuhr ja schon damals mit der gtx 750 ti schlitten,aber nun ist es gewiss mehr als das doppelte an Leistung.

Und ram unterschiede gibt es ja auch.Das eine System verwendet ddr3 und das andere DDR4.

Und ich hatte ddr4 auf 2133 mhz gestellt.Die Quadchannel brauchte in Games im Grunde damals mir garanix.

Und verloren gegen einen ddr3 1866 mhz mit Dualchannel.

Wie es in Zukunft weiter geht,denke mal DDR5 wird da gewiss auch noch mal einen Plus machen für die Games wo vom extra Ram profitieren.

Gillt gewiss ja auch für den Threadripper,nehme ich mal an.

C4rp3di3m

Captain

- Registriert

- Jan. 2008

- Beiträge

- 3.243

Blaze1987

wenn dich interessiert ,hier sind alle meine 7960X Benches die ich bisher gemacht habe.Zu den Tests