Kaufmannsladen schrieb:

Die TPUs sind sehr stark auf Googles Bedürfnisse ausgerichtet und kein echter Vergleich mit NVIDIAs.

Das Thema ist an der Stelle allerdings komplizierter und

@0xffffffff drückt das an der Stelle schon sehr gut aus. Gerade die Entwicklung "reiner" TPUs - Tensor-Processing-Unit - ist für Nvidia - und bedingt AMD - durchaus gefährlich.

Nvidias aktueller Wachstumstreiber ist KI und dort auf der einen Seite wegen CUDA und eben der Tensor-Rechenleistung. Googles TPUs sind - und ja das ist grob vereinfacht - das, was am Ende dabei raus kommt, wenn man bei Blackwell die FP32-Shader, die INT32-Shader sowie die die FP64-Shader herausstreicht. Für die meisten AI-Workloads ist das vollkommen ausreichend und mehr wird nicht benötigt.

Den Umgang mit

Sparse-Matrix ist auch keine exklusive Funktion mehr von CUDA, sondern quasi zum Branchen-Standard geworden. Nvidia hat aktuell noch den Vorteil einiger "exklusiven" Datenformate wie TF32, TF16, jedoch kann Nvidia diese Vorteile weitgehend nicht ausspielen, weil allgemein sich Datenformate wie INT8, FP8 sowie nun kommend auch FP4 und INT4 durchsetzen und da sind aktuell quasi alle Akteure bemüht, dass diese Formate standardisiert werden, weil sich keine Firma exklusiv von Nvidia abhängig machen will.

Und gerade Alphabet, als eines der Vorreiterunternehmen auf diesem Gebiet legt quasi jede ihre Frameworks Hardwareagnostisch aus, so dass man quasi alles verwenden kann. Bei PyTorch und Co sieht man weitgehend ähnliche Bemühungen und AMD sowie Intel (bis jetzt) sägen mit großer Freude an CUDA und geben sich alle Mühe, dass man CUDA "bricht" und im AI-Bereich machen sie da auch große Fortschritte.

Nvidia ist uneingeschränkt Marktführer, doch diese Position macht Nvidia an sehr vielen Stellen auch angreifbar und gerade "Investoren" sehen es nicht gerne, wenn der Marktführer droht die Marktführerschaft zu verlieren. Und klar, wir reden hier nicht von einer Entwicklung die von heute auf morgen statt findet, wir reden hier von einem Prozess, der Jahre dauern kann, doch wenn der Stein erst mal ins Rollen kommt, kann es auch sehr schnell gehen, wie man an Intel jetzt gesehen hat.

p4z1f1st schrieb:

Der Vorsprung von NV bzgl der Rechenleistung und der Entwicklung liegt aber mehrere Generationen vorne

Nein, nicht wirklich. Nvidia liegt bei der Rechenleistung nicht mehrere Generationen vorne und auch auf der Software-Ebene verschieben sich aktuell einige Sachen, so dass zumindest die "CUDA"-Exklusivität aufgebrochen wird.

Auf die Rechenleistung einer Karte bezogen, hat Nvidia aktuell zwar einen Vorsprung, jedoch ist AMD da gar nicht soweit weg. Das Problem da ist zum Teil auch, was AMD und Nvidia gerne als TOPS ausgeben, was in der Regel massiv geschönte Werte sind, die quasi nur zu treffen, wenn man eine ultra dünn besetzte Matrix hat.

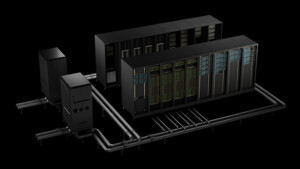

Was Nvidia noch hat, ist die "Rackscale"-Lösung als Vorsprung zu AMD, in wie weit Google hier mit Rackscale agiert, keine Ahnung.