INe5xIlium

Lt. Commander

- Registriert

- Aug. 2010

- Beiträge

- 1.133

Hallo,

ich habe 2 AOMEI Image Dateien von jeweils 1TB und möchte gerne wissen, ob die identisch sind.

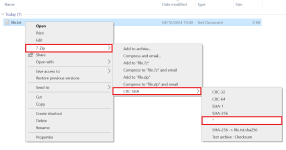

Früher hatte ich mal eine Browser Extension, die mir Checksummen berechnet hat. Wenn es einen halben Tag dauert, ist eine Browser Extension nicht optimal, finde ich.

Jetzt habe ich WinMerge verwendet, weil ich es grade hatte. Er vergleicht schon seit 12 Stunden File 1/1. Da hätte ich mindestens gerne einen Progress. Der TaskManager zeigt mir noch immer 100% Disk-Auslastung an. Weil beide Images auf der gleichen Platte liegen, macht die nur 40MB/s, statt die ~200MB/s, wie sonst.

Ich würde aber gerne wissen, ob die Images noch identisch sind. Welches Programm würdet ihr dafür emfpehlen? Die KI empfiehlt BeyondCompare, aber ist das wirklich anders als WinMerge?

ich habe 2 AOMEI Image Dateien von jeweils 1TB und möchte gerne wissen, ob die identisch sind.

Früher hatte ich mal eine Browser Extension, die mir Checksummen berechnet hat. Wenn es einen halben Tag dauert, ist eine Browser Extension nicht optimal, finde ich.

Jetzt habe ich WinMerge verwendet, weil ich es grade hatte. Er vergleicht schon seit 12 Stunden File 1/1. Da hätte ich mindestens gerne einen Progress. Der TaskManager zeigt mir noch immer 100% Disk-Auslastung an. Weil beide Images auf der gleichen Platte liegen, macht die nur 40MB/s, statt die ~200MB/s, wie sonst.

Ich würde aber gerne wissen, ob die Images noch identisch sind. Welches Programm würdet ihr dafür emfpehlen? Die KI empfiehlt BeyondCompare, aber ist das wirklich anders als WinMerge?