Wie viel RAM für Anno 1800 und wie schnell soll er sein?

Entstehung und Erklärungen zum Skript-Benchmark

Dieser Thread ist ein Ableger eines großen Anno 1800 Benchmarks, der aufgeteilt werden musste.Der Hauptthread mit den Inhaltsverzeichnis bietet Erläuterungen die vorher gelesen werden sollten.

Die Frage nach der sinnvollen Menge an RAM für Anno 1800 war ein zentraler Grund für den großen Aufwand mit dem Skriptbenchmark.

Windows fängt schon ab ca. 80% reserviertem RAM an, vermehrt Daten in die Auslagerungsdatei zu verschieben, so dass es mit wenig RAM schwer ist herauszufinden ob wirklich noch Platz da ist, oder ob notwendige Daten ausgelagert wurden.

Selbst wenn man sehr viel RAM einbaut und sich die reservierte Menge anguckt, und feststellt, dass z.B. mehr als 16GB reserviert wurden, ist das noch kein Garant dafür, dass die 16 GB wirklich zu wenig sind.

Denn es kann sein, dass die wirklich benötigten Daten in die 16 GB passen und der Rest der in die Auslagerungsdatei wandert, kann überflüssig/ungenutzt sein.

Selbst wenn man sehr viel RAM einbaut und sich die reservierte Menge anguckt, und feststellt, dass z.B. mehr als 16GB reserviert wurden, ist das noch kein Garant dafür, dass die 16 GB wirklich zu wenig sind.

Denn es kann sein, dass die wirklich benötigten Daten in die 16 GB passen und der Rest der in die Auslagerungsdatei wandert, kann überflüssig/ungenutzt sein.

Da einen Anno Spieler eher nicht die ersten Minuten der Spielzeit interessieren, ist der Spielstand aus dem Lategame mit DLCs und die lange Vorbereitungsphase nötig, um eine Antwort zu liefern die relevant für den Spieler ist.

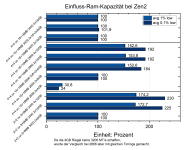

Die Ergebnisse für die Ramkapazität

Was man hier sieht sind die prozentualen Unterschiede durch unterschiedlich viel Ram auf die 1% und 0,1% low Frametimes, am Beispiel von Zen2 CPUs.

Der untere Block bezieht sich auf einen Ryzen 3100 der einen halbierten L3 Cache gegenüber einer normalen Zen2 CPU hat, wie sie im oberen Block dargestellt ist.

Wir sehen für den Ryzen 3100 durch den Wechsel von 16 GB auf 32 bzw. 64 GB RAM einen riesen Sprung von 73-130%.

16 GB sind also definitiv zu wenig und 64 GB unnötig viel Kapazität.

Der mittlere Block unterscheidet sich in der Ramgeschwindigkeit gegenüber dem oberen Block und muss mit nur 2666 MT/s auskommen, da die 4 GB Module nicht so hoch zu takten sind.

Mit 100% wieder bezogen auf 16GB RAM, bricht die Leistung mit nur 8 GB massiv ein und liefert weniger als 31%, der bereits nicht ausreichenden 16 GB konfiguration.

32 und 64 GB gewinnen fein den low Frametimes 53-92% und liegen wieder fast gleichauf.

Die 24 GB sind bei den 1% low Frametimes nur leicht schlechter als 32 und 64 GB.

Auch wenn mit 64 GB verfügbarem RAM, davon ca 33 GB reserviert werden, müssen bei 24 GB Ram scheinbar nicht so viele wichtige Daten ausgelagert werden, als dass es einen deutlichen Nachteil bedeutet.

Die Tests bei 3400 MT/s mit 32, 48 und 64 GB im oberen Block zeigt keine Unterschiede außerhalb der Messunsicherheit, da bereits 32 GB ausreichend viel sind.

Als weiteren Indikator für das Auslagern wurde bei einigen Messungen die geschriebenen GB auf dem Systemlaufwerk vor und nach den Messungen verglichen.

Mit 64 GB und 48 GB wurde in den ca. 2 Stunden nur 1 GB an Daten geschrieben.

Mit 32 GB waren es 3 GB,

mit 16 GB waren es 20-21GB,

und mit 8 GB waren es 67 GB die auf das Systemlaufwerk geschrieben wurden.

Was bedeutet das für die FPS?

Wie zu erwarten gibt es selbst mit 16 GB nur geringe Einbußen für die FPS und lediglich 8 GB liegt deutlich zurück.

Zwischen dem unteren und dem mittleren Block gibt es kaum Unterschiede in der Leistung, obwohl beide gegenüber dem oberen Block andere Nachteile haben.

Der untere Block muss auf die Hälfte des L3 Cache verzichten und hat nur vier statt acht Kerne.

Der mittler Block hat den vollen Cache und 8 Kerne, hat aber dafür mit 2666 statt 3400 MT/s, den langsameren RAM.

Die Effekte heben sich scheinbar zufällig nahezu auf.

Mehr zu Cache und Kernen in einem anderen Artikel-Thread und mehr zur Ramgeschwindigkeit weiter unten.

Wie sieht es mit der RAM-Kapazität bei Zen/Zen+ und Zen3 aus?

Beide Architekturen reagieren genauso wie Zen2.

Zu erwähnen wären die Ergebnisse mit halbiertem L3 Cache, die sogar weniger Skalierung zeigen als die normalen 8 MB pro CCX.

Ein größerer L3 Cache fängt also keine Laufwerkszugriffe auf die Auslagerungsdatei ab.

Die normalen 32 MB L3 Cache reagieren wieder ähnlich auf den Wechsel von 16 auf 32 GB RAM.

Aber die 96 MB L3 Cache profitieren nochmal ein gutes Stück stärker und die 0,1% low Frametimes verdreifachen sich.

Es ist zu vermuten, dass eine schnellere CPU prozentual stärker profitieren kann, wenn sie nicht so oft auf das Laufwerk warten muss.

Welchen Einfluss hat die Ramgeschwindigkeit?

Das Optimieren des RAMs ist in den letzten Jahren deutlich populärer geworden. Mehr Spieler haben entdeckt oder mitbekommen, dass schnellerer RAM im CPU Limit einen deutlichen Einfluss haben kann.

Und da die aktuellen CPUs nur selten signifikant optimiert werden können, ist schneller Ram eine der letzten Möglichkeiten für mehr FPS und bessere Frametimes.

Fangen wir mit einem FPS-Verlaufsdiagramm bei Zen2 an:

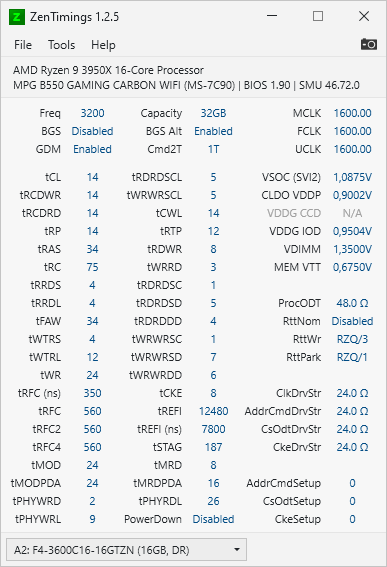

Wieder am Beispiel von Zen2 CPUs sieht man einen nicht ganz linearen Verlauf und stattdesen ein Abflachen hin zu 3400-3733 MT/s.

Dem Wert bei 3733 muss eigentlich kritisch betrachtet werden, da er mit anderen Timings entstanden ist als die Werte bis 3400.

Es mussten einige Timings höher gesetzt werden um den Takt zu erreichen aber andere Timings konnten sogar verbessert werden weil hier nur Micron-E benutzt wurde und die anderen Werte einem gemeinsammen Nenner aus Micron-E/B und Samsung B-Die gerecht werden mussten.

Nimmt man den Wert bei 3733 MT/s raus, sieht der Verlauf schon deutlich linearer aus.

Die roten Datenpunkte entsprechen dem halben L3 Cache des Ryzen 3100 und man kann sehen, dass die FPS sehr ähnlich steigen aber auf einem niedrigeren Level starten.

Sehen wir uns die prozentualen Verbesserungen an, dann zeigt sich eine ordentliche Skalierung von der DDR4 Basis 2133 MT/s zu den schnellen 3400 MT/s mit tollen 42%. ...und sogar 47,5% bei maximalem OC.

Das gilt auch genauso für die Situation mit halbiertem L3 Cache.

Wer Anno 1800 spielt sollte sich also dringen Gedanken um seinen RAM machen.

Der Sprung von 26 auf 38 FPS ist stark spürbar und macht das Spiel flüssiger und reaktionsschneller.

Wie sieht es aus wenn man den Ram nicht manuell optimieren möchte und auf ein XMP Profil zurückgreift?

Alle XMP Profile sind schonmal deutlich besser als die Basis 2133 MT/s die viele Mainboards automatisch wählen.

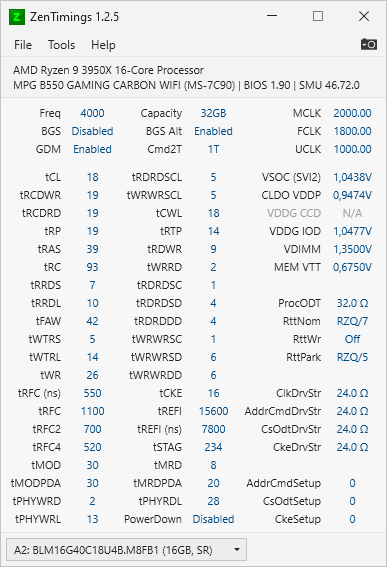

Selbst der 4000 CL18 19er Ram, der aufgrund des asynchronen Betriebs zwischen MCLK und FCLK sogar schlechter läuft als die 16 GB Hynix Ram mit 3000 CL16 18, liegt 26% über 2133 MT/s.

Micron Ram ist leider nicht mehr zu vernünftigen Preisen zu kaufen, aber in der Vergangenheit war es eine tolle Empfehlung wie sich hier zeigt.

Wird nur das XMP Profil geladen, schlagen die 3600 Cl16 18 von Micron die sündhaft teuren Samsung B-Die 3200 14 14 und liegen mit den 3600 16 16 gleichauf. Der Samsung speicher hat zwar mehr Potential für niedrige tRFC Latenzen und bessere Haupttimings aber die Wahl der Timings durch das Mainboard bzw. XMP-Profil machen davon keinen Gebrauch.

Das Potential der Micron Chips zeigt sich auch in dem Ergebnis des OC Wertes auf 3733 bei manuell ausgeloteten Timings.

Immerhin 13% mehr FPS konnten durch das manuelle Optimieren aus dem 3000 15 16er Kit herausgeholt werden.

Ob das stundenlange Herumprobieren und Testen von Ramtakt und Timings, sowie eine erhöhte DRAM Voltage, diese 13% rechtfertigt muss jeder für sich entscheiden.

Für Ryzen sollte der asynchrone Betrieb von FCLK/MCLK dringend vermieden werden und auch ein möglichst hoher Takt ist anzustreben.

Optimierte SubTimings sind nochmal ein i-Tüpfelchen das ein paar weitere Prozent herausholen kann.

Wer ein gutes Preis/Leistungsverhältnis anstrebt und sich nicht mit manuellen Einstellungen herumschlagen möchte für den sind 2x16 GB 3200 Cl16 18 18er Kits eine gute Wahl die auch in den meisten Fällen problemlos funktionieren sollten.

Wer ein gutes Angebot findet kann auch auf 3600 MT/s gehen, aber hier kann es passieren dass die Subtimings sehr viel schlechter gewählt werden oder das die Stabilität nicht gegeben ist.

Optimierte SubTimings sind nochmal ein i-Tüpfelchen das ein paar weitere Prozent herausholen kann.

Wer ein gutes Preis/Leistungsverhältnis anstrebt und sich nicht mit manuellen Einstellungen herumschlagen möchte für den sind 2x16 GB 3200 Cl16 18 18er Kits eine gute Wahl die auch in den meisten Fällen problemlos funktionieren sollten.

Wer ein gutes Angebot findet kann auch auf 3600 MT/s gehen, aber hier kann es passieren dass die Subtimings sehr viel schlechter gewählt werden oder das die Stabilität nicht gegeben ist.

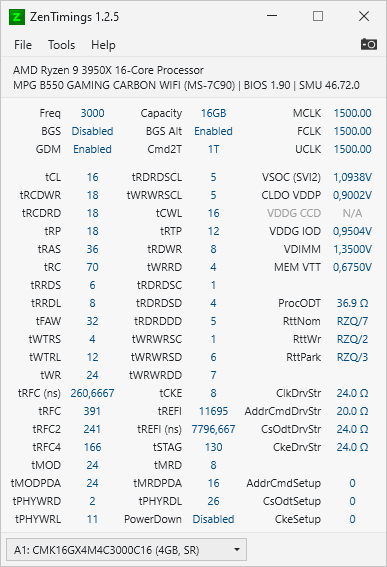

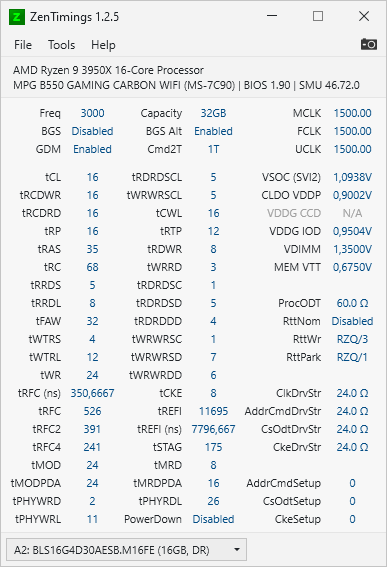

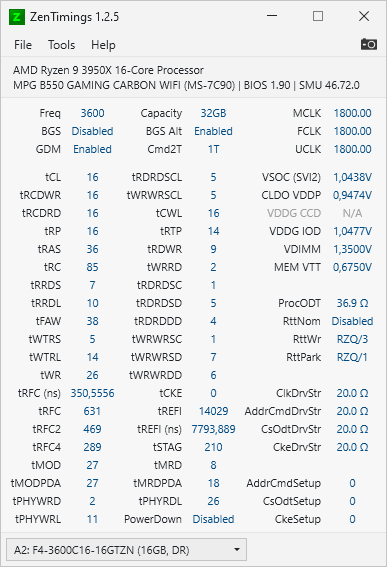

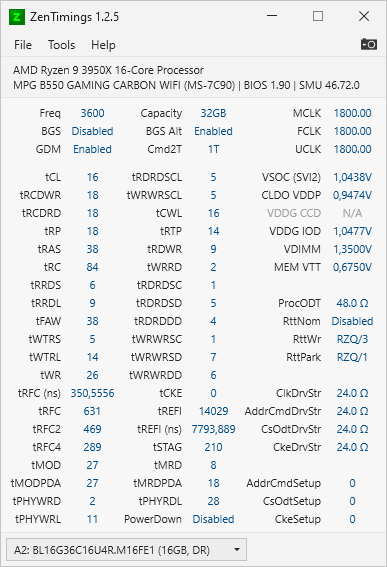

XMP:

Manuelle Timings:

Die manuellen Timings mussten auf diversen Ramriegeln mit 3400 MT/s laufen um eine gute Vergleichbarkeit zu gewährleisten.

Natürlich könnten sie besser sein wenn sie jeweils einzeln optimiert worden wären, aber ich musste mich am kleinsten gemeinsamen Nenner orientieren.

Die Hynix-Chips können diese Timings nur bei 2666 MT/s.

Manuelle Timings:

Die manuellen Timings mussten auf diversen Ramriegeln mit 3400 MT/s laufen um eine gute Vergleichbarkeit zu gewährleisten.

Natürlich könnten sie besser sein wenn sie jeweils einzeln optimiert worden wären, aber ich musste mich am kleinsten gemeinsamen Nenner orientieren.

Die Hynix-Chips können diese Timings nur bei 2666 MT/s.

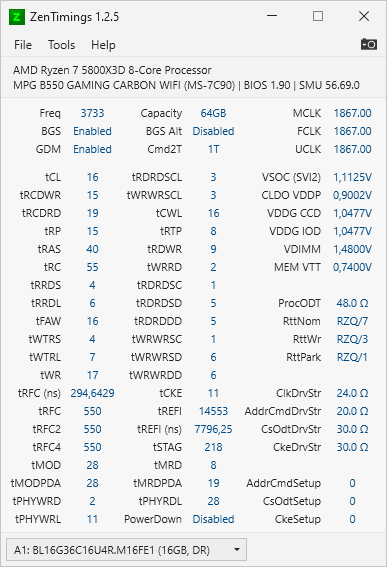

Wie sieht es bei Zen/Zen+ und Zen3 aus?

Zen und Zen+ reagieren sehr ähnlich wie Zen2 und profitieren von 2133 auf 3400 MT/s mit 34-40% mehr FPS.

Links sieht man, dass die Steigerung der FPS nicht sonderlich gut mit einer lineare Regression dargestellt werden kann. Es gibt eine Art Sättigung bei höherer Ramgeschwindigkeit.

Rechts bei den Prozentbalken profitiert Zen3 (32 MB L3) mit 38% mehr FPS von dem Wechsel auf 3400 und mit 42% durch das OC auf 3733 MT/s.

Jeder Prozentpunkt bei der Ramgeschwindigkeit wird damit zu 64% in mehr FPS verwandelt.

50% mehr RAM-Takt(Bei festen Timings) würde dann also erwartungsgemäßt 50*0,64=32 Prozent mehr FPS erzeugen.

In älteren Tests von mir mit Ivy Bridge(DDR3) lag diese "Rendite" über 12 Spiele bei durchschnittlich 40% und mit dem Ryzen 1800X bei nur 24%...beides also deutlich schwächer und nur Spiele-Ausnahmen waren an 60% ran gekommen.

Die 96MB L3 Cache CPU(Ryzen 5800X3D) profitiert prozentual bei den FPS weniger stark, als die normale Version mit 32 MB L3 Cache.

Allerdings muss man hier beachten, dass die CPU auch 44% höhere FPS erreicht und in Teilen der Messung anfängt GPU limitiert zu sein.

Das ist auch gut daran zu erkennen, dass sich die 0,1% und 1% Low Frametimes sehr ähnlich verbessern (egal ob 32 oder 96 MB L3 Cache) und nur die FPS zu höherem Takt begrenzt wirken.

Die Aussage, dass eine X3D CPU kaum von schnellem RAM profitiert bewahrheitet sich im Falle von Anno 1800 also nicht.

Die wichtigen 1% low Frametimes profitieren sehr ähnlich und man sollte den RAM hier nicht einfach ignorieren.

Fazit

Trotz des großen Aufwandes um ein besonders anspruchsvolles Lategame zu simulieren, sind mehr als 32 GB RAM nicht nötig für Anno 1800.Mehr RAM senkt die Schreiblast auf dem Systemlaufwerk von ungefär 3 GB auf 1 GB pro 2h aktivem Spielen, was für moderne SSDs irrelevat ist.

Dem Benchmark fehlen zwar noch die letzten drei DLCs aus 2023 so dass sich die Situation nochmal leicht verschieben könnte wenn wirklich alles ausgenutzt wird, da aber schon 24 GB nahezu ausreichend waren sollten 32GB auch bei weiter gestiegenen Anforderungen ausreichen.

Schneller Ram ist zusätzlich sehr wichtig. Überhaupt ein XMP Profil mit mehr als 3000 MT/s geladen zu haben bringt schonmal einen gewalltigen Schub gegenüber den Basis-2133 MT/s.

Manuelles Optimieren des Rams ist dann eine Kür die nochmal etwas drauflegen kann, aber Wunder sollte man nicht erwarten.

Es sei auch nochmal darauf hingewiesen, dass schlecht konfigurierter Ram oder sogar single Channel Ram keinen Einfluss auf die Häufigkeit von Frametimepeaks hat!

Die Ausprägung der Peaks reagiert prozentual sehr ähnlich zu den FPS und schnellerer RAM macht diese weniger störend und spürbar. Er zaubert diese aber nicht einfach weg!

Zu wenig Ram führt hingegen zu deutlich mehr Frametimepeaks und das Aufrüsten kann viele wegzaubern, aber leider nie alle Peaks.

Mit wie viel RAM spielt ihr Anno 1800?

Und wie ist euer RAM konfiguriert? XMP, selbst optimiert, oder habt ihr das Bios eventuell gar nicht angerührt?

<- Vorheriger Thread(Cache, Kerne/Threads, CCX usw.) --Übersicht-- nächster Thread(RAM: Ranks, Channel, BankgroupSwap) ->Anhänge

Zuletzt bearbeitet: