Die Cuda Cores sind auch wichtig für RT, die verarbeiten nämlich die Ergebnisse der Schnittberechnungen weiter.MrHeisenberg schrieb:Blöd nur, dass die RT Cores für Ray Tracing nötig sind und nicht die Cuda Cores.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Portal with RTX im Test: Die RTX-4000-Techdemo im Grafikkarten-Benchmark

- Ersteller Jan

- Erstellt am

- Zum Test: Portal with RTX im Test: Die RTX-4000-Techdemo im Grafikkarten-Benchmark

metoer

Lt. Junior Grade

- Registriert

- Juli 2015

- Beiträge

- 340

Ich dachte mir schon das die Anforderungen für AMD Karten heftig werden, aber so extrem? Etwas verwunderlich ist das dann doch, selbst bei vollem RT mit Pathtracing sollte der Abstand nicht so gigantisch sein.

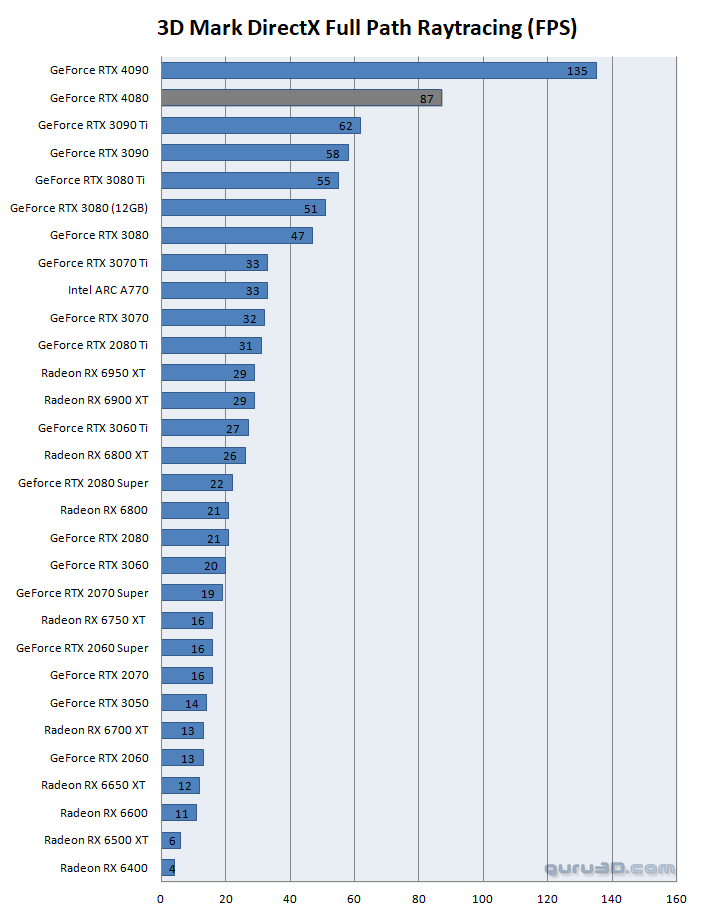

Im 3D Mark RT Featuretest ist eine 3080ti ca. 90% schnelller als eine 6900XT, bei Portal sind es 1200%!!!

Natürlich kann man nicht erwarten das Nvidia auf AMD Karten Rücksicht nimmt und optimiert, aber das riecht schon fast nach Absicht.

Im 3D Mark RT Featuretest ist eine 3080ti ca. 90% schnelller als eine 6900XT, bei Portal sind es 1200%!!!

Natürlich kann man nicht erwarten das Nvidia auf AMD Karten Rücksicht nimmt und optimiert, aber das riecht schon fast nach Absicht.

Ja dann warte mal noch bis Anfang nächstes Jahr oder so, Nvidia wird federn lassen bzw auch die Skalpter müssen billiger verkaufen wenn sie nicht auf ihren Modellen sitzen bleiben wollen.SavageSkull schrieb:Ich bin sogar am Überlegen, ob ich meine 3090 verkaufe und dafür eine 4080 kaufe.

Je nachdem was man für die 3090 bekommt, wäre das ein überschaubarer Invest und für Raytracing ein spürbarer Sprung nach vorne.

Aber wenn du in den Regionen wilderst tun dir vielleicht 200 Euro mehr ausgeben für 2 Wochen weniger warten auch nicht weh. Ich würde es halt schon aus Prinzip nicht machen, da ich mich ungern von jemandem Verarschen lasse, eine Karte überteuert zum Wucher verkauft bekommen mit Lügen es sei das äquivalent zur 3080 ti (oder wars 3090 ti) die zur Hochzeit des Miningbooms aufn Markt kam und dann sagen "seht damals hatten wir die selbe UVP also haben wir es gar nicht deutlich teurer gemacht".

Außerdem wenn ich jetzt sagen wir für 2000 Euro ne 4090 kaufen würde die ich später für 1200 Euro verkaufen kann in 2 Jahren vielleicht, oder für 1500 ne 4080 die ich dann für 500 Euro in 2 Jahren verkaufen kann, da kostet dich am ende die 4080 eventuell mehr wenn du Einkauf - verkauf 1000 Euro vs 800 Euro zahlst. Wenn sich die gesamte Presse einig ist das die 4080 ne Schlechte Karte ist oder schon fast an Betrug grenzt dann würde ich da mit keinem guten Wiederverkaufswert rechnen.

SavageSkull

Fleet Admiral

- Registriert

- Mai 2010

- Beiträge

- 13.135

Die 4080 ist keinesfalls eine schlechte Karte. Habe ich auch nirgends gelesen. Die passt nur nicht ins Preisgefüge. Die ist einfach doppelt so teuer, wie sie wert sein sollte, wenn man die 4090 als Anhaltspunkt nimmt. Und selbst die ist schon ein überteuerter Anhaltspunkt..Sentinel. schrieb:Wenn sich die gesamte Presse einig ist das die 4080 ne Schlechte Karte ist oder schon fast an Betrug grenzt dann würde ich da mit keinem guten Wiederverkaufswert rechnen.

Laphonso

Vice Admiral

- Registriert

- Jan. 2012

- Beiträge

- 6.200

Vergleiche doch mal bitte 1st Gen Turing mit RDNA2 als first gen AMD Raytracing Rohleistung.metoer schrieb:Natürlich kann man nicht erwarten das Nvidia auf AMD Karten Rücksicht nimmt und optimiert, aber das riecht schon fast nach Absicht.

Die RTX (!) 2060 und 2070..findet man ...huch....gaaaaaaaaaaaaanz weit unten.

Sogar die RTX 3050 sieht da alt aus.

Die 6700XT liegt nur minimal knapp hinter der 70er Klasse Nvidias.

Ich finde man redet AMDs Karten hier schlechter als sie sind.

Stelle ich Super Resolution und Frame Generation aus, knackt mir die 4090, ein 2000 Euro Chip, auch auf 30-40 fps weg in UWQHD.

Mal so formuliert: Ohne DLSS Unterstützung sehen die 1st Gen RT GPUs von Nvidia auch nicht "gut" aus.

SavageSkull

Fleet Admiral

- Registriert

- Mai 2010

- Beiträge

- 13.135

Frame Generation sollte bei Tests ab jetzt immer erwähnt und mit und ohne getestet werden.Laphonso schrieb:Stelle ich Super Resolution und Frame Generation aus, knackt mir die 4090, ein 2000 Euro Chip, auch auf 30-40 fps weg in UWQHD.

Mal so formuliert: Ohne DLSS Unterstützung sehen die 1st Gen RT GPUs von Nvidia auch nicht "gut" aus.

Das verzerrt das Bild zu sehr. Dabei sind die Fake Frames wohl kaum im Sinne eines flüssigen Spielablaufs geeignet. Bestenfalls zu einer flüssigen Bilddarstellung.

Laphonso

Vice Admiral

- Registriert

- Jan. 2012

- Beiträge

- 6.200

Sicher fehlen da noch viel mehr Spiele für eine repräsentative Grundgesamtheit,SavageSkull schrieb:Dabei sind die Fake Frames wohl kaum im Sinne eines flüssigen Spielablaufs geeignet.

aber nach fast 50 Stunden..

...Spiderman mit Frame Generation kann ich nur sagen "wow"...

Das ist fast hysterisch, mit Ultraraytracingsettings minfps (!) von 120-130 zu schieben und im peak 200 fps zu ballern bei mir in UWQHD.

Die OFA Technologie ist ein noch krasserer impact als DLSS und FSR in meinem Augen.

Fake ist hier nur der Glaube, dass Frame Generation nicht funktioniert.

Ich bin eher fassungslos beeindruckt, wie gut das bereits in der ersten Iteration abliefert.

Und zwar das: Einen flüssigen Spielablauf.

Die Panikreaktion von AMD, "FSR3 soon" auf die Folien zu klatschen (sie hatten NICHTS, um das auch nur zeigen) zur RNDA3 Präsentation sprach Bände.

Dass AMD darauf reagieren will sagt alles, was man wissen muss.

da!mon

Lt. Commander

- Registriert

- Juli 2006

- Beiträge

- 1.113

Wenn ich diese Aussage für bare Münze nehme....Sentinel. schrieb:Und Portal RTX zu großen Teilen auf Path- Tracing.

...und dazu noch diesen Benchmark von Quake II RTX, welches ebenfalls auf Path-Tracing setzt...MrHeisenberg schrieb:Kannst du diese Aussage irgendwie belegen?

Nur, weil es ein paar Spiele gibt, die RT nur marginal einsetzen und deswegen die AMD Karten nicht so einbrechen, ist das noch kein Beweis.

...dann ergibt sich mir ein anderes Bild als in einer überzogenen Tech-Demo von NV.

Klar, AMD hängt immernoch hinterher, aber besser als 3,6 fps ist das Ergebnis allemal...

Beide Spiele sind übrigens von Lightspeed Studios.

Ergänzung ()

Auch wenn das nun offtopic ist: mich würde mal interessieren wie die Latenzen mit Framegeneration sind.Laphonso schrieb:Das ist fast hysterisch, mit Ultraraytracingsettings minfps (!) von 120-130 zu schieben und im peak 200 fps zu ballern bei mir in UWQHD.

Also Darstellungslatenz und Systemlatenz. Für mich, der sehr sensibel auf input oder rendering lag reagiert, wären 50ms deutlich schlimmer zu spielen, als 180ms Ping nach Kanada...

Zuletzt bearbeitet:

Saki75

Lt. Commander

- Registriert

- Dez. 2014

- Beiträge

- 1.137

Also alles schön und gut aber mal ganz ehrlich , hätte man nicht auch das menü zumindest etwas remastern können , aber die jungs haben ja bestimmt keine zeit für sowas.

Alt X um ins RTX menü zu kommen und irgendwelche uralten einstellungen von windows aero usw und bei einem 13900k und einer RTX4090 shadows auf disabled laut empfehlung

Alt X um ins RTX menü zu kommen und irgendwelche uralten einstellungen von windows aero usw und bei einem 13900k und einer RTX4090 shadows auf disabled laut empfehlung

Taxxor

Fleet Admiral

- Registriert

- Mai 2011

- Beiträge

- 19.228

Ich hab's dort genau andersrum gemacht und nach dem niedrigsten Verbrauch gejagt ^^Laphonso schrieb:aber nach fast 50 Stunden..

...Spiderman mit Frame Generation kann ich nur sagen "wow"...

Das ist fast hysterisch, mit Ultraraytracingsettings minfps (!) von 120-130 zu schieben und im peak 200 fps zu ballern bei mir in UWQHD.

ich war schon mit der 6800XT mit 60FPS zufrieden in dem Spiel und habe auch mal mit um die 80 gespielt und keinen großen Unterschied bemerkt. Dafür war ich dann aber auch bei 280W Verbrauch.

Jetzt habe ich das Limit bei 80 und DLSS Q + FG aktiv, ich merke keinen höheren Input lag als vorher mit der AMD bei normalen 60 und es wirkt flüssiger als diese 60. Das ganze bei 85W in WQHD RT Ultra.

Bei AMD hatte ich ja auch kein Reflex, also könnte die Latenz mit 40FPS+FG+Reflex insgesamt sogar ziemlich gleich sein wie die von 60FPS ohne Reflex.

Bei Portal scheint das fps Limit aber nicht zu funktionieren, selbst wenn ich es global setzte läuft Portal weiter mit Max fps und das RTSS Limit kann man mit DLSS FG nicht nutzen.

aber Portal dürfte ja wie die anderen source games auch ne Konsole haben womit das geht oder?

Zuletzt bearbeitet:

R

Ragnarök88

Gast

Das hieße aber dann auch, dass die RT Unterschiede hinsichtlich der Leistung deutlich höher lägen als zunächst vermutet und AMD darauf hoffen muss, dass Entwickler nur sehr geringfügig mit RT hantieren..Sentinel. schrieb:nVidia geht von Anfang an Raytracing All In. AMD wartet ab und Pokert damit, dass der RT Anteil bei Spielen nur langsam ansteigt, womit sie in der Praxis wahrscheinlich sogar recht behalten werden. Spart ja auch Kohle, einen anderen Ansatz zu wählen, der zwar nicht super, aber für einige Szenarien zumindest ausreichend scheint.

Die eklatanten Unterschiede kommen ja auch nur in diversen Machbarkeitsstudien zum Tragen.

Bei dem hohen Marktanteil von Nvidia Grafikkarten sehe ich diese Strategie aber nicht aufgehen.

Ja, das ist man einfach nicht mehr gewohnt. Das waren so die Zeiten als einige GPU Hersteller Pleite gingen und nur noch ATI und NVidia am Markt übrig blieben..Sentinel. schrieb:Die Spielerschaft hat sich einfach über die Jahre daran gewöhnt, dass es keine Neuerungen mehr gibt, die disruptiv sind.

Aber es wird nach über 30 Jahren auch mal Zeit für einen Tapetenwechsel.

..::Borni::..

Lt. Junior Grade

- Registriert

- Feb. 2011

- Beiträge

- 428

Ich hab zwar den Thread jetzt nicht gelesen aber hier geht es zu 99 % wahrscheinlich darum das Nvidia vs AMD und Nvidia böse und teuer. Während sich hier gebattlet wurde hab ich alle Achievment erspielt und muss sagen war sehr cool diesen Klassiker nochmal zu spielen.

Ich muss an dieser Stelle auch sagen das Spiel ist bei mir sehr oft abgestürzt wenn man oft neu laden oder neu anfangen muss bei den Portal Challenges. Sonst laufen bei mir alle Spiele mega stabil. Ich könnte mir vorstellen das es eventuell an der Frame Generation liegt, hab es aber nicht getestet ohne. Dieses Feature scheint noch etwas Entwicklung zu brauchen. Während es lief war es aber von der Performance und auch Latenz echt top.

Im Prinzip ist das ganze nicht mehr als ne kostenlose Mod für Portal.

Ich muss an dieser Stelle auch sagen das Spiel ist bei mir sehr oft abgestürzt wenn man oft neu laden oder neu anfangen muss bei den Portal Challenges. Sonst laufen bei mir alle Spiele mega stabil. Ich könnte mir vorstellen das es eventuell an der Frame Generation liegt, hab es aber nicht getestet ohne. Dieses Feature scheint noch etwas Entwicklung zu brauchen. Während es lief war es aber von der Performance und auch Latenz echt top.

Im Prinzip ist das ganze nicht mehr als ne kostenlose Mod für Portal.

Hi,

So, habe mal das neue Fortnite mit UE 5.1 getestet und bin beruhigt!

Alle hochgedreht sind meine Werte gleich, sowie teilweise auch über denen von dem Ergebnis der 3060 12 GB hier aus dem Video hier (Kapitel TSR native, Hardware RT on):

Meine Welt ist somit wieder in Ordnung, den NVIDIAnern sei also Portal RTX gegönnt.

/edit

Achja:

Meine CPU und GPU: 5800X3d und eine 6700XT

Gruß

Alef

So, habe mal das neue Fortnite mit UE 5.1 getestet und bin beruhigt!

Alle hochgedreht sind meine Werte gleich, sowie teilweise auch über denen von dem Ergebnis der 3060 12 GB hier aus dem Video hier (Kapitel TSR native, Hardware RT on):

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Meine Welt ist somit wieder in Ordnung, den NVIDIAnern sei also Portal RTX gegönnt.

/edit

Achja:

Meine CPU und GPU: 5800X3d und eine 6700XT

Gruß

Alef

.Sentinel.

Admiral

- Registriert

- Okt. 2007

- Beiträge

- 8.623

Ist halt die Frage, welchen Part an RT man betrachtet. Dispatch, Intersection, BVH Generierung und dessen Updates usw. usf.Ragnarök88 schrieb:Das hieße aber dann auch, dass die RT Unterschiede hinsichtlich der Leistung deutlich höher lägen als zunächst vermutet und AMD darauf hoffen muss, dass Entwickler nur sehr geringfügig mit RT hantieren.

In den Einzeldisziplinen hätte AMD in ihrer reinen Peak- Leistung kein größeres Problem.

Es ist halt die Summe der einzelnen Stages inkl. der Speicherverwaltung, die hier halt darüber entscheidet, ob irgendwo die Pipeline verstopft. Da hat nVidia nicht umsonst und auch unter fertigungstechnischem Schmerz und unter Einbuße von ein wenig Rasterleistung das Kommunikationsmanagement auf den Karte umgekrempelt.

SP-937-215

Cadet 4th Year

- Registriert

- Apr. 2008

- Beiträge

- 78

Portal Rtx ist schlicht und ergreifend eine "NVIDIA only" Techdemo. Kann man über den Link schön nachlesen. AMD kann unter diesen Voraussetzungen gar nicht gut performen.

https://twitter.com/JirayD/status/1601036292380250112?s=20&t=d3es4Jx6n_9x5jXm0u5gGg

https://twitter.com/JirayD/status/1601036292380250112?s=20&t=d3es4Jx6n_9x5jXm0u5gGg

t3chn0

Admiral

- Registriert

- Okt. 2003

- Beiträge

- 9.721

.Sentinel. schrieb:Das kann eigentlich nicht sein, da Du mittels DLSS quality über der nativen Auflösung liegst. Auch sollten bei DLSS sämtliche Texturen in unveränderter Auflösung vorliegen, was ein Vermatschen ausschließen muss.

Also ich merke da auf jeden Fall einen schon deutlichen Unterschied zwischen nativ und DLSS. DLSS sieht auf jeden Fall schlechter aus, teilweise auch deutlich schlechter. Alles hat einen gewissen "Schleier" und Objekte in der Distanz sind unsauber gerendert. Ich habe gerade bestimmt 3h lang bei BF2042 damit rumprobiert und es gibt einen klaren grafischen Rückschritt zu nativ.

Bist Du Dir wirklich sicher, dass bei DLSS Quality über der nativen Auflösung gerendert wird? Ich habe jetzt zig Quellen durch und alle bestätigen dass die Auflösung geringer ist. Macht ja auch Sinn. Man gewinnt ja deutlich an Performance.

Die 4090 ist sogar noch immer zu langsam für 4K nativ auf Ultra Preset ohne RT in 2042. Nativ kommt man auf 106-117 FPS. Mit DLSS liege ich immer in meinem Cap von 117 FPS und bei nur noch 250W Verbrauch.

Siehe auch hier:

https://www.benq.eu/de-at/knowledge-center/knowledge/dlss-presets-performance-quality-balanced.html

DLSS Qualität

Rendert das Spiel intern mit der Auflösung, die der Zielauflösung am nächsten kommt. Wenn du also dein Spiel auf 4K (3840 x 2160) einstellst, erwarte ein 3200 x 1800 Rendering, das auf 4K super gesampelt wird. Dies bittet die KI, die visuelle Qualität und die tatsächliche Pixelanzahl gegenüber der Framerate zu priorisieren. Dies ist die anspruchsvollste Einstellung und kommt in vielerlei Hinsicht der Ausschaltung von DLSS am nächsten. Dies entspricht in etwa der grafischen Treue oder der Qualitätseinstellung vieler neuerer Konsolenspiele. Empfohlen für Leute, die 4K-Monitore verwenden und einen leistungsstarken PC haben oder umgekehrt für 1080p-Spieler, die ein optimiertes Bild auf bescheidenerer Hardware wollen.DLSS Leistung

Das Aushängeschild von DLSS, da es die Grundprämisse der Technologie mit besserer Framerate für weniger Aufwand verkörpert. Es erlaubt dem Spiel, mit einer niedrigeren, aber immer noch soliden internen Auflösung zu laufen und hat daher einen größeren Super-Sampling-Bereich zu überwinden als die Qualitätseinstellung. In den meisten Fällen wahrscheinlich 1080p bis 2160p, wenn du in 4K spielst. Das führt manchmal zu einem Verlust der Bildschärfe oder leicht verschwommener Grafik, was unserer Meinung nach mit der Verbesserung der KI-Routinen verschwinden wird. Priorität hat die Bildrate gegenüber der Auflösung. Ähnlich wie bei dem Performance-Modus der Konsole. Daher empfehlen wir es für Nutzer von 1440p/2K-Monitoren.DLSS Ultraleistung

Das extremste Profil, das sich fast ausschließlich der Bereitstellung von FPS auf Kosten der internen Auflösung und der Ausgabegrafik widmet. Dies kann zu weichen, verschwommenen Grafiken führen, da die Lücke zwischen der internen Rendering- und der Ausgabeauflösung so groß ist. Wenn nicht anders angegeben, könnte es zwischen 720p und 2160p sein, was eine große Lücke ist, wenn die KI nicht sehr gut ist. Diese Einstellung ist großartig, wenn du die schnellstmögliche Framerate mit DLSS haben willst und es dir nichts ausmacht, einen Kompromiss bei der visuellen Wiedergabetreue einzugehen. Diese Einstellung ist vor allem für Benutzer mit 1080p-Monitoren mit hoher Aktualisierungsrate oder für Leute, die einen 4K-Monitor mit einer bescheidenen Grafikkarte haben, zu empfehlen. In diesem Sinne hat der Ultraleistungs-Modus, genau wie der Qualitäts-Modus, einen gewissen internen Widerspruch in sich. Dieses Profil wird manchmal auch als Ultra Performance oder Performance Ultra bezeichnet.

DLSS Ausgeglichen

Selbsterklärende Einstellung, die versucht, einen guten Mittelweg zwischen Render- und Ausgabeauflösung zu finden und dabei so nah wie möglich an der nativen Framerate des Host-Displays zu bleiben. Oder an die Framerate, die du in den Spieleinstellungen angibst. Wir finden, dass dieses Profil ehrlich gesagt das beste ist. Unsere Erfahrung mit den beiden bisherigen DLSS-Titeln (CP2077 und Death Stranding) zeigt uns, dass die Einstellung "Ausgeglichen" sehr gut funktioniert, obwohl es möglich ist, dass diese Einstellung einen stärkeren Effekt auf die Variabilität der Auflösung hat. Einige Leute könnten die Auflösungsveränderung bemerken, aber das ist unwahrscheinlich. Empfehlenswert ist der Modus daher für alle, obwohl 4K-Nutzer am meisten von dieser guten Kombination aus Leistung und Qualität profitieren werden.Mit der Zeit und der Reife der Technik werden vielleicht mehr Einstellungen verfügbar sein, oder die Einstellungen werden verschwinden und durch intelligenteres DLSS ersetzt, das ohne Profile funktioniert. Wir werden sehen, und hoffen, dass wir dir bis dahin helfen können, immer die beste Performance zu haben!

.Sentinel.

Admiral

- Registriert

- Okt. 2007

- Beiträge

- 8.623

t3chn0 schrieb:Also ich merke da auf jeden Fall einen schon deutlichen Unterschied zwischen nativ und DLSS. DLSS sieht auf jeden Fall schlechter aus, teilweise auch deutlich schlechter. ... Bist Du Dir wirklich sicher, dass bei DLSS Quality über der nativen Auflösung gerendert wird? Ich habe jetzt zig Quellen durch und alle bestätigen dass die Auflösung geringer ist. Macht ja auch Sinn. Man gewinnt ja deutlich an Performance.

Ein UHD Bild hat 8.847.360 Pixel.

Es ist ein Rechenbeispiel- Wenn Du DLSS Quality nimmts, dann hast Du in Frame #1 nach Szenezwechsel 3.686.400 Pixel. Frame #2 immer das Doppelte 7.372.800 und ab Frame #3 geht das Clamping und das Verwerfen ungültiger Pixel los.

Also statt 14.745.600 Pixeln werden "nur" noch 10.000.000-12.000.000 Pixel übrig bleiben. Das bleibt dann über die gesamte Szenerie weiter ansteigend so lange bis wieder ein kompletter Szenenwechsel oder ein schneller Kameraschwenk stattfindet oder der kumulation treshold überschritten ist.

Du hast damit so gut wie durchgängiges Supersampling der Szene, weswegen das Antialias auch deutlich überlegen ist.

Unschärfe liegt diesbzeüglich nie in der Geometrie. Es sind zu 99% die Texturen, bei welchen die Entwickler pfuschen.

Wenn DLSS aktiviert wird, stellen die nämlich die Engine nicht intern um, dass bei DLSS die kumulierten Texturpixel als Ausgabeformat vorliegen, sondern immer nur die des aktuellen niedriger aufgelösten Frames.

Um die Entwickler darauf hinzuweisen, gibt es in der integrations Checklist von DLSS folgenden Passus:

Den Du normalerweise für eine Zertifizierung checken musst.

Die Formel:

Mip bias = Native bias + Log2(Render Res/Native Res)

Leider scheint das 99% der Entwickler nicht zu interessieren. DLSS kann per se letztendlich nicht "unschärfer" sein, wenn ordnungsgemäß integriert.

Es liegt nicht an nVidia oder DLSS, wenn da was verwaschen aussieht.

Zuletzt bearbeitet:

SavageSkull

Fleet Admiral

- Registriert

- Mai 2010

- Beiträge

- 13.135

Ursprünglich ist das ja auch eine Alternative zu den bisherigen Post Processing Antialiasing Methoden wie TSAA und Konsorten. Ziel sollte in erster Linie ein besseres Bild sein, da die Post Processing Methoden das Bild eher unscharf werden lassen und gleichzeitig mehr Leistung, was ja der Pferdefuß von den richtigen Kantenglättungsmethoden sind.t3chn0 schrieb:Also ich merke da auf jeden Fall einen schon deutlichen Unterschied zwischen nativ und DLSS.

Native Auflösung ohne Kantenglättung ist immer sauberer und schärfer, aber SSSSAA + Raytracing wäre ein Killer für die Performance.

Ähnliche Themen

- Antworten

- 806

- Aufrufe

- 61.222

- Antworten

- 469

- Aufrufe

- 32.607

- Antworten

- 247

- Aufrufe

- 26.520

- Antworten

- 786

- Aufrufe

- 77.608

- Antworten

- 1.324

- Aufrufe

- 84.675