Baal Netbeck

Fleet Admiral

- Registriert

- Apr. 2008

- Beiträge

- 11.965

Dies ist ein ausgelagertes Thema aus diesem Hauptthread:

https://www.computerbase.de/forum/t...kussion-zu-spieletests.1728575/#post-20678303

Intro:

Rise of the Tomb Raider ist zwar über weite Teile eher GPU limitiert, aber in einigen Bereichen, wie die Sowjet Anlage, dem Geothermale Tal und im Bereich gegen Ende ein ziemlich CPU lastiges Spiel und hat es daher in meinen eigenen Testparcour für CPU Tests geschafft .

.

Die Tatsache, dass es DX11 und 12 unterstützt war auch interessant.

Die Testkandidaten sind mein Ryzen 1800X in verschiedenen Konfigurationen gegen einen i5 3570K.

Beide mit meiner Vega64 LC(undervolted) gepaart.

In diesem Review zeige ich diverse Aspekte wie:

Einflüsse von 4 vs 8 Kernen, SMT an/aus, Skalierung mit Ramgeschwindigkeit, verschiedene CCX Konfigurationen für Ryzen. IPC Vergleiche, Einfluss des HBCC, Einfluss von CPU und RAM Optimierungen, DX12 vs 11 und eine Betrachtung der Infinity Fabric Skalierung.

Fangen wir mit der Testszene an.

Es war schwer eine reproduzierbare und CPU intensive Szene zu finden.

Es war schwer eine reproduzierbare und CPU intensive Szene zu finden.

Der integrierte Benchmark ist sinnlos. Er hat nichts mit dem Gameplay zu tun, die erste Szene ist langweilig, die zweite ganz ok und die letzte, hatte auf vier Kernen massive Probleme mit zufällig geladenen oder nicht geladenen Objekten. Laden sie zu spät, gibt dies Ruckler und auf der anderen Seite hatte man vorher zu hohe FPS weil nicht viel zum rendern da war.

Erst wollte ich eine Herausforderung nutzen....aber da haben sich teilweise die Bedingungen geändert und ich konnte maches neue nicht abwählen....

Dann wollte ich nach dem durchspielen ein Gebiet laden und dort herumlaufen, aber dann endet man mit verschiedenen Tageszeiten und Wetterbedingungen...absolut unbrauchbar.

Jetzt nutze ich ein savegame aus der Kampagne und zwar nachdem man zum erstem Mal das Geothermale Tal betreten hat.

Man muss die Szene erst einmal abgelaufen sein um die Gespräche per Funk abzuschließen und dann kann man einen Speicherstand anlegen.

Der Vorteil ist z.B. das immer gleiche Wetter und Tageszeit, sowie nur einen Autosave Punkt. Ich hätte es gerne komplett ohne Autosave gemacht aber da habe ich nichts gutes gefunden, das ausreichend Gameplay abdeckt.

Der Szenenablauf ist recht aufwendig geworden. ich wechsle immer wieder ins rennen, lasse Lara aber auch an bestimmten Stellen gehen. Ich benutze den Bogen und justiere die Kamera bei dem Seilrutschen irgendwo mittig während sie versucht nach rechts oder links wegzugleiten.

Ich war überrascht, wie zuverlässig die Szene doch ist obwohl ich so viel unterschiedliches mache.

Wer die Szene selbst testen möchte findet hier das benutzte savegame:

https://drive.google.com/drive/folders/1Hahuj2q234W1LTFi5WLAZOo_uR4tF-qu?usp=sharing

Frametimegraphen:

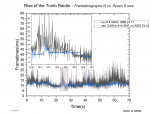

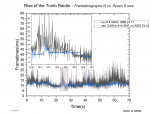

Zuerst der Vergleich meines Ryzen 7@3,8GHz und des Ivy Bridge i5 mit 4,4GHz

Wie man sieht, hat das Spiel auf dem i5 mit großen Frametime Schwankungen zu kämpfen.

Sowohl beim Durchschnitt als auch bei den Frametimes liefern die 8 Kerne des Ryzen deutlich bessere Leistung, auch wenn er trotzdem ab und zu Peaks zeigt.

Zumindest mit 4,4GHz und 1866er Ram liefert der i5 3570K jedoch auch brauchbare Leistung. Man spürt den Unterschied, aber es ist fast immer ordentlich spielbar.

Um diesem Auf und Ab eine quantitative Entsprechung zu geben benutze ich eine Reihe statistischer Werte die ich aus der Auswertung von jeweils fünf Messungen gewinne.

Die gezeigten Frametimeverläufe waren jeweils die zweit besten was die 0.1% low Werte angeht.

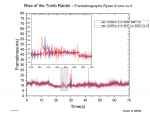

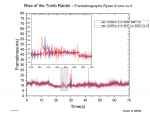

Nun zeige ich noch den Vergleich zu vier Kernen bei Ryzen, was einem 1500X mit OC entsprechen würde.

Durch das aktivierte SMT macht sich der Ryzen trotz nur 4 Kernen deutlich besser als der i5 im vorherigen Vergleich.

In dem Heran gezoomten Bereich erkennt man gut, wie gleich doch die Durchschnittlichen Frametimes sind. Mit nur 4 Kernen sind sie jedoch generell deutlich größeren Schwankungen unterlegen, der Bereich von 24 zu 24,5s scheint unabhängig davon die gleiche Form zu zeigen.

Die Ausschläge um 30s sind auf das Abspringen vom ersten Seil mit damit verbundenem Autosave zurückzuführen.

Der Ausschlag bei 42s scheint immer dann aufzutreten, wenn die Kamera aus dem "am Seil gleiten Modus" in den "laufen Modus" wechselt. durch den Kamerawechsel, fällt es mir nicht negativ auf.

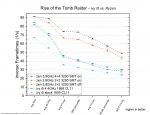

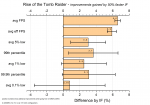

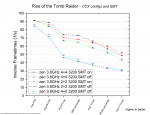

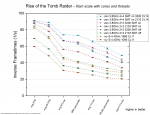

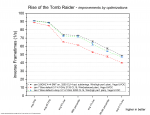

Vergleichen wir also die Systeme quantitativ:

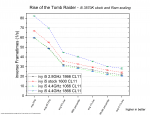

i5 vs. Ryzen

Zur Erklärung des Diagramms:

Mit nur 4 Kernen und ohne SMT sind die Unterschiede zum i5 insgesamt nur gering aber der Ryzen kann überall eine minimale Führung halten

Schalten wir bei den 4 zen Kernen SMT hinzu, springt die Leistung deutlich nach oben

Wie schon am Frametimegraph gesehen, ist der Durchschnitt gleich zu echten 8 Kernen, die Frametimelostanz fällt jedoch deutlich ab.

Ohne Übertaktung fällt der i5 noch weiter zurück und fällt mit den 1% low Werten unter 30 FPS.

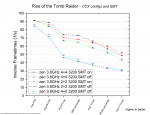

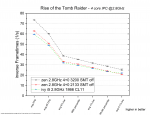

Ryzen CCX Konfiguration und SMT

2+2 muss sich ohne SMT hier leicht der 4+0 Komfiguration geschlagen geben. Die Unterschiede sind aber wieder gering.

4+0 hat den Vorteil keine Komunikation der Kerne über den IF zu haben, muss im Gegenzug aber mit dem halben L3 Cache zurechtkommen.

Wie schon vorher gezeigt verbesser SMT bei vier Kernen das Spielgefühl deutlich.

Bei 8 Kernen zeigt ein deaktivieren von SMT eine leichte verschlechterung der allgemeinen Frametimeschwankungen(mittlerer Bereich) aber eine leichte Verbesserung, wenn es um einzelne Ausreißer geht.

Gefühlt habe ich diese Unterschiede nicht aber die Fehlerbalken sagen sie sind reproduzierbar.

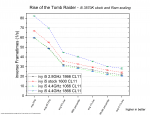

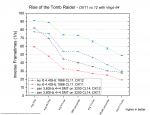

Leistungsaufspaltung beim i5

Als Überraschung zeigt sich, das Rise of the Tomb Raider auf dem i5 offenbar sehr Ram hungrig ist.

Nur 2,8 GHz machen sich dank schnellem Ram leicht besser als 4,4GHz mit 1066MHz DDR3, die stock Taktraten mit 1600er Ram(Intel Freigabe) liegen irgendwo in der Mitte. agieren jedoch schon in Bereichen, die kritische Werte erreichen und daher spürbar schlechter laufen.

Der Wechsel von 1066 auf 1866 macht aus dem 75% schnelleren Ram also ca 37,3% mehr avg FPS aus und 40% mehr 1% low.

Von 2,8 zu 4,4GHz sind es 57% mehr Takt. Dies führt zu einer Steigerung der avg FPS von 38% und 33% bei den 1% low.

Die Ram Geschwindigkeit zeigt sich also überaus deutlich.

IPC Vergleich

Drei mal vier Kerne, ohne HT/SMT, bei 2,8GHz im Vergleich.

Ryzen ist zweimal vertreten und zwar einmal mit schnellem und einmal mit langsamem Ram.

Von dem Leistungsvorsprung bleibt bei 2133er DDR4 nur noch ein Hauch übrig.

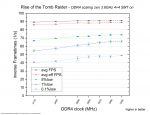

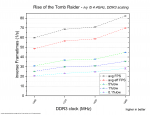

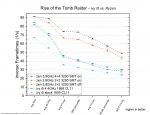

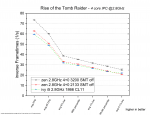

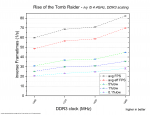

DDR4 Ram Skalierung

Ich habe eine etwas andere Auftragung gewählt.

Wir sehen hier wie sich die verschiedenen Statistikwerte mit steigender Ram Geschwindigkeit verändern.

Anders als beim i5 sind wir hier mit 8 Kernen +SMT unterwegs und befinden uns fast immer im GPU limit.

Die avg FPS und avg eff FPS zeigen daher so gut wie keine Unterschiede.

Lediglich unterhalb von 2666MHz scheint es minimale Verluste zu geben.

Von 2133 zu 3200MHz DDR4 sind nur 2% Steigerung.

Die 5%, 1% und 0.1% low Werte reagieren besser und zeigen ersteine beginnende Sättigung zu höheren Taktraten.

Sie profitieren bis rauf zu 3066/3200MHz.

Die 1% low Werte verbessern sich mit 50% mehr Ram geschwindigkeit immerhin um 21,2%, jedoch kein Vergleich zu den 40% die man mit dem i5 sehen konnte.

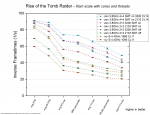

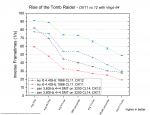

Unterschiedliche Ram Skalierung bei anderen Kern und Thread Anzahlen?

Ich hoffe man kann es halbwegs erkennen. Gleiche Farben gehören zur selben Konfiguration, aber in dunkel mit dem schlechtesten Ram und in hell mit dem schnellsten.

Egal ob 4 Kerne ohne SMT, mit SMT oder 8 Kerne mit SMT, der Wechsel von 2133 auf 3200 MHz bringt zumindest für alles was nicht FPS im Namen hat deutliche Leistungsgewinne.

Der i5 gewinnt absolut gesehen gar nicht so viel mehr aber prozentual gesehen wird es deutlicher.

DDR3 Ram Skalierung

Die Erkenntnisse zu der Skalierung mit DDR3 Geschwindigkeit ist hier nochmal genauer zu sehen.

Die angedeutete Stufe bei 1600MHz ist etwas komisch, aber ich habe die Daten nochmal überprüft und es scheint richtig zu sein.

DirectX 11 vs 12

Sowohl auf dem i5 als auch auf dem Ryzen hasst die Vega64 DX11!

Die Verluste sind so schlimm, dass die 8 Kerne des Ryzen mit DX11 bei den avg FPS unter die DX12 Werte des i5 fallen und trotz besserer Frametimekonstanz bei den "Ausreißer sensitiven" 0,1% low nur gleichauf liegen.

Für eine Nvidia Grafikkarte würde das Bild vermutlich anders aussehen aber mit einer AMD GPU empfehle ich auf jeden Fall DX12 zu verwenden.

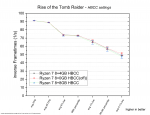

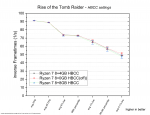

HBCC settings

Keine Unterschiede außerhalb der Konfidenzintervalle.

Es ist völlig egal was man wählt.

Ryzen optimieren und übertakten

Mit dem 1800X habe ich bereits das stärkste Modell der Ryzen 100er Serie.

Aber wie viel Leistung verschenkt man wenn man weder den Ram im Bios einstellt noch den Energiesparplan ändert?

Und wie viel Leistung kann man mit einem minimalen OC auf 3,8GHz und optimieren von Subtimings noch herausholen?

Antwort A.....man verliert nicht allzu viel aber mehr als nötig.

Antwort B.....man gewinnt in ROTTR etwas aber nicht viel, die Optimierungen helfen hier mehr dem eigenen Ego als dem Spielgefühl.

100MHz mehr allcore(3,6% mehr score in Cinebench) und 9,6% mehr Leserate des Ram bringen 0,4% mehr avg FPS und 5,1% mehr 1% low.

Der ausbalancierte Energiesparplan sollte inzwischen auch für Ryzen funktionieren und nicht mehr die Kerne schlafen legen aber auf Höchstleistung wird nicht heruntergetaktet.

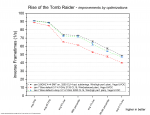

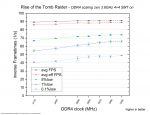

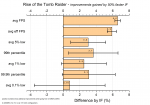

Einfuss von Ramtakt auf den Infinity Fabric

Hintergrund:

Ganz wichtig sind hier die Fehlerbalken!

Nur die oberen zwei Werte haben eine ordentliche Aussagekraft!

Grob kann man sagen, dass eine Beschleunigung des IF um 50%, um die 6% bessere FPS in Rise of the Tomb Raider ausmacht.

Mein Fazit aus diesem speziellen Ergebnis lautet:"Da das Spiel vor allem mit 4 Kernen von schnellerem Ram profitiert, sollte man wenn möglich diesen einsetzen. Die Angst das der IF sonst deutlich limitiert ist in diesem Fall nicht völlig unbegründet.

6% sind deutlich mehr als ich erwartet hatte!."

Fazit:

Rise of the Tomb Raider verlangt nach einer ordentlichen Grafikkarte und limitiert auch grob 90% der Zeit über diese.

Aber die restlichen 10% sind trotzdem regelmäßig Teil des Spiels und oft die besonderen Bereiche.

Ich habe das Spiel mit dem i5 durchgespielt und an mehreren Stellen ist mir die Leistung negativ aufgefallen, was nachträglich mit dem Ryzen getestet Butterweich lief.

Wie man auch an den Daten sieht, vermag das Spiel mit mehr als 4 Kernen umzugehen und selbst SMT bei 8 Kernen hat größtenteils positive Auswirkungen.

Wichtig für Besitzer von AMD Grafikkarten ist die Wahl der API. DX11 lässt meine Vega64 deutlich früher in ein CPU limit laufen und DX12 ist definitiv vorzuziehen.

Den HBCC kann man ignorieren.

Der Einfluss des Infinity Fabric ist überaschend groß.

Insgesamt bin ich mit den Frametimes im Spiel sehr zufrieden.

Die richtige Hardware vorausgesetzt, läuft es Butterweich, fühlt sich reaktionsschnell an und gerade die Animationen und der Feinschliff den man an so vielen Stellen sieht haben mich begeistert....Gameplay und Story waren auch Okay

Das vier Kerne hier ab und zu straucheln und sich träger anfühlen ist für manche schade, aber wenn dabei alle Kerne auf 100% sind(und das sind sie öfter), ist es zumindest keine schlechte Hardwareauslastung sondern einfach zu viel Arbeit für die vorhandene Rohleistung.

https://www.computerbase.de/forum/t...kussion-zu-spieletests.1728575/#post-20678303

Intro:

Rise of the Tomb Raider ist zwar über weite Teile eher GPU limitiert, aber in einigen Bereichen, wie die Sowjet Anlage, dem Geothermale Tal und im Bereich gegen Ende ein ziemlich CPU lastiges Spiel und hat es daher in meinen eigenen Testparcour für CPU Tests geschafft

Die Tatsache, dass es DX11 und 12 unterstützt war auch interessant.

Die Testkandidaten sind mein Ryzen 1800X in verschiedenen Konfigurationen gegen einen i5 3570K.

Beide mit meiner Vega64 LC(undervolted) gepaart.

In diesem Review zeige ich diverse Aspekte wie:

Einflüsse von 4 vs 8 Kernen, SMT an/aus, Skalierung mit Ramgeschwindigkeit, verschiedene CCX Konfigurationen für Ryzen. IPC Vergleiche, Einfluss des HBCC, Einfluss von CPU und RAM Optimierungen, DX12 vs 11 und eine Betrachtung der Infinity Fabric Skalierung.

Fangen wir mit der Testszene an.

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Der integrierte Benchmark ist sinnlos. Er hat nichts mit dem Gameplay zu tun, die erste Szene ist langweilig, die zweite ganz ok und die letzte, hatte auf vier Kernen massive Probleme mit zufällig geladenen oder nicht geladenen Objekten. Laden sie zu spät, gibt dies Ruckler und auf der anderen Seite hatte man vorher zu hohe FPS weil nicht viel zum rendern da war.

Erst wollte ich eine Herausforderung nutzen....aber da haben sich teilweise die Bedingungen geändert und ich konnte maches neue nicht abwählen....

Dann wollte ich nach dem durchspielen ein Gebiet laden und dort herumlaufen, aber dann endet man mit verschiedenen Tageszeiten und Wetterbedingungen...absolut unbrauchbar.

Jetzt nutze ich ein savegame aus der Kampagne und zwar nachdem man zum erstem Mal das Geothermale Tal betreten hat.

Man muss die Szene erst einmal abgelaufen sein um die Gespräche per Funk abzuschließen und dann kann man einen Speicherstand anlegen.

Der Vorteil ist z.B. das immer gleiche Wetter und Tageszeit, sowie nur einen Autosave Punkt. Ich hätte es gerne komplett ohne Autosave gemacht aber da habe ich nichts gutes gefunden, das ausreichend Gameplay abdeckt.

Der Szenenablauf ist recht aufwendig geworden. ich wechsle immer wieder ins rennen, lasse Lara aber auch an bestimmten Stellen gehen. Ich benutze den Bogen und justiere die Kamera bei dem Seilrutschen irgendwo mittig während sie versucht nach rechts oder links wegzugleiten.

Ich war überrascht, wie zuverlässig die Szene doch ist obwohl ich so viel unterschiedliches mache.

Wer die Szene selbst testen möchte findet hier das benutzte savegame:

https://drive.google.com/drive/folders/1Hahuj2q234W1LTFi5WLAZOo_uR4tF-qu?usp=sharing

Frametimegraphen:

Zuerst der Vergleich meines Ryzen 7@3,8GHz und des Ivy Bridge i5 mit 4,4GHz

Wie man sieht, hat das Spiel auf dem i5 mit großen Frametime Schwankungen zu kämpfen.

Sowohl beim Durchschnitt als auch bei den Frametimes liefern die 8 Kerne des Ryzen deutlich bessere Leistung, auch wenn er trotzdem ab und zu Peaks zeigt.

Zumindest mit 4,4GHz und 1866er Ram liefert der i5 3570K jedoch auch brauchbare Leistung. Man spürt den Unterschied, aber es ist fast immer ordentlich spielbar.

Um diesem Auf und Ab eine quantitative Entsprechung zu geben benutze ich eine Reihe statistischer Werte die ich aus der Auswertung von jeweils fünf Messungen gewinne.

Die gezeigten Frametimeverläufe waren jeweils die zweit besten was die 0.1% low Werte angeht.

Nun zeige ich noch den Vergleich zu vier Kernen bei Ryzen, was einem 1500X mit OC entsprechen würde.

Durch das aktivierte SMT macht sich der Ryzen trotz nur 4 Kernen deutlich besser als der i5 im vorherigen Vergleich.

In dem Heran gezoomten Bereich erkennt man gut, wie gleich doch die Durchschnittlichen Frametimes sind. Mit nur 4 Kernen sind sie jedoch generell deutlich größeren Schwankungen unterlegen, der Bereich von 24 zu 24,5s scheint unabhängig davon die gleiche Form zu zeigen.

Die Ausschläge um 30s sind auf das Abspringen vom ersten Seil mit damit verbundenem Autosave zurückzuführen.

Der Ausschlag bei 42s scheint immer dann aufzutreten, wenn die Kamera aus dem "am Seil gleiten Modus" in den "laufen Modus" wechselt. durch den Kamerawechsel, fällt es mir nicht negativ auf.

Vergleichen wir also die Systeme quantitativ:

i5 vs. Ryzen

Zur Erklärung des Diagramms:

Aufgetragen auf der y- Achse sind die "inversen Frametimes". Das sind im Grunde die FPS aber halt nicht durch "Zählen von Frames über einen Zeitraum" bestimmt, sondern über den Kehrwert der Frametimes gebildet.

Wenn ihr hier bei einem Wert links(avg FPS) 44 in 1/s seht, dann würde euch Fraps auch 44 FPS anzeigen.

Aus dem Frametimeverlauf bestimme ich einen effektiven Frametimeverlauf. Diesen habe ich ausführlich im Hauptthread unter "Nomenklatur" diskutiert.

"avg eff FPS" ist der Kehrwert des Durchschnitts dieses effektiven Frametimeverlaufs.

Um so stärker dieser Wert gegenüber den avg FPS abfällt um so stärker sind die relativen Schwankungen der Frametimes ....eine Art "Mikroschwankungsindikator".

Es folgen die Xth percentile und X% low Werte, die sich Stück für Stück immer weiter den schlechten Frametime Werten zuwenden und daher für das Spielgefühl besonders wichtig sind.

5%low und 99th percentile sind dabei noch eher auf den allgemeinen Spielfluss konzentriert und bekommen wenig bis nichts von einzelnen Frametimepeaks(Rucklern) mit.

Die letzten drei Werte werden je nach Spiel mehr oder weniger von diesen Frametimepeaks dominiert und sind meiner Meinung nach oft das beste Mittel um zu beschreiben ob und wie "Ruckelig" sich das Spiel anfühlt.

Leider basieren sie nur auf einem kleinen Teil der Frametimes und daher unterliegen sie größeren Ungenauigkeiten.

Auch wenn ich die 0,1% low Werte sehr schätze, bieten sie oft zu schlechte Reproduzierbarkeiten und daher bin ich ein großer Fan der 1% low Werte.

Diese sind in der Regel noch gut zu reproduzieren und entsprechen sinnvoll dem Spielgefühl.

Die Linien zwischen den Symbolen sind extra gestrichelt, da sie nur zur besseren Lesbarkeit beitragen sollen und keine Punkte dazwischen suggerieren sollen.

In der Legende sieht man die Symbolformen und Farben der verscheidenen Testkandidaten.

Die Wertepunkte selbst sind Durchschnittswerte aus den drei besten Werten von fünf Messungen und haben zusätzlich Fehlerbalken, die sich aus der empirischen Standardabweichung dieser drei besten Werte ergeben.

Wenn ihr hier bei einem Wert links(avg FPS) 44 in 1/s seht, dann würde euch Fraps auch 44 FPS anzeigen.

Aus dem Frametimeverlauf bestimme ich einen effektiven Frametimeverlauf. Diesen habe ich ausführlich im Hauptthread unter "Nomenklatur" diskutiert.

"avg eff FPS" ist der Kehrwert des Durchschnitts dieses effektiven Frametimeverlaufs.

Um so stärker dieser Wert gegenüber den avg FPS abfällt um so stärker sind die relativen Schwankungen der Frametimes ....eine Art "Mikroschwankungsindikator".

Es folgen die Xth percentile und X% low Werte, die sich Stück für Stück immer weiter den schlechten Frametime Werten zuwenden und daher für das Spielgefühl besonders wichtig sind.

5%low und 99th percentile sind dabei noch eher auf den allgemeinen Spielfluss konzentriert und bekommen wenig bis nichts von einzelnen Frametimepeaks(Rucklern) mit.

Die letzten drei Werte werden je nach Spiel mehr oder weniger von diesen Frametimepeaks dominiert und sind meiner Meinung nach oft das beste Mittel um zu beschreiben ob und wie "Ruckelig" sich das Spiel anfühlt.

Leider basieren sie nur auf einem kleinen Teil der Frametimes und daher unterliegen sie größeren Ungenauigkeiten.

Auch wenn ich die 0,1% low Werte sehr schätze, bieten sie oft zu schlechte Reproduzierbarkeiten und daher bin ich ein großer Fan der 1% low Werte.

Diese sind in der Regel noch gut zu reproduzieren und entsprechen sinnvoll dem Spielgefühl.

Die Linien zwischen den Symbolen sind extra gestrichelt, da sie nur zur besseren Lesbarkeit beitragen sollen und keine Punkte dazwischen suggerieren sollen.

In der Legende sieht man die Symbolformen und Farben der verscheidenen Testkandidaten.

Die Wertepunkte selbst sind Durchschnittswerte aus den drei besten Werten von fünf Messungen und haben zusätzlich Fehlerbalken, die sich aus der empirischen Standardabweichung dieser drei besten Werte ergeben.

Mit nur 4 Kernen und ohne SMT sind die Unterschiede zum i5 insgesamt nur gering aber der Ryzen kann überall eine minimale Führung halten

Schalten wir bei den 4 zen Kernen SMT hinzu, springt die Leistung deutlich nach oben

Wie schon am Frametimegraph gesehen, ist der Durchschnitt gleich zu echten 8 Kernen, die Frametimelostanz fällt jedoch deutlich ab.

Ohne Übertaktung fällt der i5 noch weiter zurück und fällt mit den 1% low Werten unter 30 FPS.

Ryzen CCX Konfiguration und SMT

2+2 muss sich ohne SMT hier leicht der 4+0 Komfiguration geschlagen geben. Die Unterschiede sind aber wieder gering.

4+0 hat den Vorteil keine Komunikation der Kerne über den IF zu haben, muss im Gegenzug aber mit dem halben L3 Cache zurechtkommen.

Wie schon vorher gezeigt verbesser SMT bei vier Kernen das Spielgefühl deutlich.

Bei 8 Kernen zeigt ein deaktivieren von SMT eine leichte verschlechterung der allgemeinen Frametimeschwankungen(mittlerer Bereich) aber eine leichte Verbesserung, wenn es um einzelne Ausreißer geht.

Gefühlt habe ich diese Unterschiede nicht aber die Fehlerbalken sagen sie sind reproduzierbar.

Leistungsaufspaltung beim i5

Als Überraschung zeigt sich, das Rise of the Tomb Raider auf dem i5 offenbar sehr Ram hungrig ist.

Nur 2,8 GHz machen sich dank schnellem Ram leicht besser als 4,4GHz mit 1066MHz DDR3, die stock Taktraten mit 1600er Ram(Intel Freigabe) liegen irgendwo in der Mitte. agieren jedoch schon in Bereichen, die kritische Werte erreichen und daher spürbar schlechter laufen.

Der Wechsel von 1066 auf 1866 macht aus dem 75% schnelleren Ram also ca 37,3% mehr avg FPS aus und 40% mehr 1% low.

Von 2,8 zu 4,4GHz sind es 57% mehr Takt. Dies führt zu einer Steigerung der avg FPS von 38% und 33% bei den 1% low.

Die Ram Geschwindigkeit zeigt sich also überaus deutlich.

IPC Vergleich

Drei mal vier Kerne, ohne HT/SMT, bei 2,8GHz im Vergleich.

Ryzen ist zweimal vertreten und zwar einmal mit schnellem und einmal mit langsamem Ram.

Von dem Leistungsvorsprung bleibt bei 2133er DDR4 nur noch ein Hauch übrig.

DDR4 Ram Skalierung

Ich habe eine etwas andere Auftragung gewählt.

Wir sehen hier wie sich die verschiedenen Statistikwerte mit steigender Ram Geschwindigkeit verändern.

Anders als beim i5 sind wir hier mit 8 Kernen +SMT unterwegs und befinden uns fast immer im GPU limit.

Die avg FPS und avg eff FPS zeigen daher so gut wie keine Unterschiede.

Lediglich unterhalb von 2666MHz scheint es minimale Verluste zu geben.

Von 2133 zu 3200MHz DDR4 sind nur 2% Steigerung.

Die 5%, 1% und 0.1% low Werte reagieren besser und zeigen ersteine beginnende Sättigung zu höheren Taktraten.

Sie profitieren bis rauf zu 3066/3200MHz.

Die 1% low Werte verbessern sich mit 50% mehr Ram geschwindigkeit immerhin um 21,2%, jedoch kein Vergleich zu den 40% die man mit dem i5 sehen konnte.

Unterschiedliche Ram Skalierung bei anderen Kern und Thread Anzahlen?

Ich hoffe man kann es halbwegs erkennen. Gleiche Farben gehören zur selben Konfiguration, aber in dunkel mit dem schlechtesten Ram und in hell mit dem schnellsten.

Egal ob 4 Kerne ohne SMT, mit SMT oder 8 Kerne mit SMT, der Wechsel von 2133 auf 3200 MHz bringt zumindest für alles was nicht FPS im Namen hat deutliche Leistungsgewinne.

Der i5 gewinnt absolut gesehen gar nicht so viel mehr aber prozentual gesehen wird es deutlicher.

DDR3 Ram Skalierung

Die Erkenntnisse zu der Skalierung mit DDR3 Geschwindigkeit ist hier nochmal genauer zu sehen.

Die angedeutete Stufe bei 1600MHz ist etwas komisch, aber ich habe die Daten nochmal überprüft und es scheint richtig zu sein.

DirectX 11 vs 12

Sowohl auf dem i5 als auch auf dem Ryzen hasst die Vega64 DX11!

Die Verluste sind so schlimm, dass die 8 Kerne des Ryzen mit DX11 bei den avg FPS unter die DX12 Werte des i5 fallen und trotz besserer Frametimekonstanz bei den "Ausreißer sensitiven" 0,1% low nur gleichauf liegen.

Für eine Nvidia Grafikkarte würde das Bild vermutlich anders aussehen aber mit einer AMD GPU empfehle ich auf jeden Fall DX12 zu verwenden.

HBCC settings

Keine Unterschiede außerhalb der Konfidenzintervalle.

Es ist völlig egal was man wählt.

Ryzen optimieren und übertakten

Mit dem 1800X habe ich bereits das stärkste Modell der Ryzen 100er Serie.

Aber wie viel Leistung verschenkt man wenn man weder den Ram im Bios einstellt noch den Energiesparplan ändert?

Und wie viel Leistung kann man mit einem minimalen OC auf 3,8GHz und optimieren von Subtimings noch herausholen?

Antwort A.....man verliert nicht allzu viel aber mehr als nötig.

Antwort B.....man gewinnt in ROTTR etwas aber nicht viel, die Optimierungen helfen hier mehr dem eigenen Ego als dem Spielgefühl.

100MHz mehr allcore(3,6% mehr score in Cinebench) und 9,6% mehr Leserate des Ram bringen 0,4% mehr avg FPS und 5,1% mehr 1% low.

Der ausbalancierte Energiesparplan sollte inzwischen auch für Ryzen funktionieren und nicht mehr die Kerne schlafen legen aber auf Höchstleistung wird nicht heruntergetaktet.

Einfuss von Ramtakt auf den Infinity Fabric

Hintergrund:

Wer sich mit Ryzen beschäftigt hat, der wird öfter gehört haben, dass Ryzen schnellen Ram braucht, weil sonst die Kommunikation zwischen den CCX durch einen lansamen IF behindert wird.

Aber ist dem auch so? Ich habe noch keinen brauchbaren Test gesehen, der das untersucht hat und habe mir was eigenes überlegt.

Theoretisch ist da schonmal was dran. Gerade in neueren PC Spielen wird die Arbeit auf mehrere Kerne aufgeteilt und es findet viel Kommunikation statt um alles synchron zu halten und die Ergebnisse zusammenzuführen.

Der IF ist an den Takt des Ram gekoppelt und es gibt Veröffentlichungen, die zeigen das sich die Latenzen von einem CCX zum anderen mit schnellerem Ram verbessern.

Die Frage ist, ob dies rein theoretisch ist oder wirklich so signifikant, dass es sich auch in der Spieleperformance niederschlägt.

Leider steigt mit schnellerem Ram auch die Spieleperformance und es wird schwer zu sehen, was davon die IF Verbesserung war und was einfach der schnelle Ram.

Die IF Unterschiede von 2+2 zu 4+0 werden durch den doppelten L3 Cache bei 2+2 verschleiert.

Vorgehen

Bei den Ryzen 8 Kernern hat man die Möglichkeit über das Bios Kerne zu deaktivieren und dies habe ich einmal als 2+2 und einmal als 4+0 Konfiguration gemacht. SMT war deaktiviert.

Dann habe ich beides einmal mit 2133 und einmal mit 3200er Ram getestet.

Dann habe ich den prozentualen Performance Gewinn(2133 zu 3200) einmal für 2+2 und für 4+0 ermittelt und die Differenz gebildet.

Unter der Annahme, das der Gewinn durch den schnelleren Ram gleich sein sollte, zeigt die Differenz also den reinen Einfluss durch den beschleunigten IF.

Die Ergebnisse beruhen allerdings auf je vier fehlerbehafteten Größen und wenn man mit Gaußscher Fehlerfortpflanzung die Fortpflanzung dieser Fehler in das Endergebnis berechnet, zeigen sich leider große Unsicherheiten.

Aber ist dem auch so? Ich habe noch keinen brauchbaren Test gesehen, der das untersucht hat und habe mir was eigenes überlegt.

Theoretisch ist da schonmal was dran. Gerade in neueren PC Spielen wird die Arbeit auf mehrere Kerne aufgeteilt und es findet viel Kommunikation statt um alles synchron zu halten und die Ergebnisse zusammenzuführen.

Der IF ist an den Takt des Ram gekoppelt und es gibt Veröffentlichungen, die zeigen das sich die Latenzen von einem CCX zum anderen mit schnellerem Ram verbessern.

Die Frage ist, ob dies rein theoretisch ist oder wirklich so signifikant, dass es sich auch in der Spieleperformance niederschlägt.

Leider steigt mit schnellerem Ram auch die Spieleperformance und es wird schwer zu sehen, was davon die IF Verbesserung war und was einfach der schnelle Ram.

Die IF Unterschiede von 2+2 zu 4+0 werden durch den doppelten L3 Cache bei 2+2 verschleiert.

Vorgehen

Bei den Ryzen 8 Kernern hat man die Möglichkeit über das Bios Kerne zu deaktivieren und dies habe ich einmal als 2+2 und einmal als 4+0 Konfiguration gemacht. SMT war deaktiviert.

Dann habe ich beides einmal mit 2133 und einmal mit 3200er Ram getestet.

Dann habe ich den prozentualen Performance Gewinn(2133 zu 3200) einmal für 2+2 und für 4+0 ermittelt und die Differenz gebildet.

Unter der Annahme, das der Gewinn durch den schnelleren Ram gleich sein sollte, zeigt die Differenz also den reinen Einfluss durch den beschleunigten IF.

Die Ergebnisse beruhen allerdings auf je vier fehlerbehafteten Größen und wenn man mit Gaußscher Fehlerfortpflanzung die Fortpflanzung dieser Fehler in das Endergebnis berechnet, zeigen sich leider große Unsicherheiten.

Ganz wichtig sind hier die Fehlerbalken!

Nur die oberen zwei Werte haben eine ordentliche Aussagekraft!

Grob kann man sagen, dass eine Beschleunigung des IF um 50%, um die 6% bessere FPS in Rise of the Tomb Raider ausmacht.

Mein Fazit aus diesem speziellen Ergebnis lautet:"Da das Spiel vor allem mit 4 Kernen von schnellerem Ram profitiert, sollte man wenn möglich diesen einsetzen. Die Angst das der IF sonst deutlich limitiert ist in diesem Fall nicht völlig unbegründet.

6% sind deutlich mehr als ich erwartet hatte!."

Fazit:

Rise of the Tomb Raider verlangt nach einer ordentlichen Grafikkarte und limitiert auch grob 90% der Zeit über diese.

Aber die restlichen 10% sind trotzdem regelmäßig Teil des Spiels und oft die besonderen Bereiche.

Ich habe das Spiel mit dem i5 durchgespielt und an mehreren Stellen ist mir die Leistung negativ aufgefallen, was nachträglich mit dem Ryzen getestet Butterweich lief.

Wie man auch an den Daten sieht, vermag das Spiel mit mehr als 4 Kernen umzugehen und selbst SMT bei 8 Kernen hat größtenteils positive Auswirkungen.

Wichtig für Besitzer von AMD Grafikkarten ist die Wahl der API. DX11 lässt meine Vega64 deutlich früher in ein CPU limit laufen und DX12 ist definitiv vorzuziehen.

Den HBCC kann man ignorieren.

Der Einfluss des Infinity Fabric ist überaschend groß.

Insgesamt bin ich mit den Frametimes im Spiel sehr zufrieden.

Die richtige Hardware vorausgesetzt, läuft es Butterweich, fühlt sich reaktionsschnell an und gerade die Animationen und der Feinschliff den man an so vielen Stellen sieht haben mich begeistert....Gameplay und Story waren auch Okay

Das vier Kerne hier ab und zu straucheln und sich träger anfühlen ist für manche schade, aber wenn dabei alle Kerne auf 100% sind(und das sind sie öfter), ist es zumindest keine schlechte Hardwareauslastung sondern einfach zu viel Arbeit für die vorhandene Rohleistung.

Zuletzt bearbeitet: