Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News WD Blue 3D NAND: Vereinzelt Leistungsverlust beim Lesen alter Dateien

- Ersteller MichaG

- Erstellt am

- Zur News: WD Blue 3D NAND: Vereinzelt Leistungsverlust beim Lesen alter Dateien

Mir persönlich ist es erst einmal egal, ob WD Mist gebaut hat oder nicht. Ich will auf die Daten meiner 2 Jahre alten 4TB WD Blue 3D zugreifen bevor mir WD eine Lösung (per Firmware oder sonstwie) bietet.EDV-Leiter schrieb:Hier geht es aber um ein Problem, bei dem die Auslesegeschwindigkeit auf einstellige Werte absinken kann. Damit ist es nicht mit wenigen Stunden sondern eher in richtung mehrere Tage getan.

Die benötigte Zeit zum Testen (oder für ein Backup-Image) hängt extrem davon ab, wie man die SSD nutzt. Wenn man die SSD vor X Jahren vollgeschreiben hat, dann betrifft es u.U. alle Daten. Wenn sie aber kontinuierlich genutzt wird, dann sollte es nur ein paar alte Daten betreffen.

Im Zweifel lässt man das Backup halt über Nacht laufen. Nicht jeder hat nur eine 1-Zimmer Wohnung, wo der laufende PC beim Schlafen stört. Im Worst case (volle 4 TB SSD, die sich im Schnitt nur mit 20 MB/s lesen lässt) sind das halt 58 Stunden. Aber mal ehrlich, sowas wäre einem schon viel früher aufgefallen und nicht erst mit der Meldung hier.

Die einzige Alternative, die mir derzeit einfällt, ist mit dem Testtool die Dateien zu ermittlen, die langsam im Lesen sind (das dauert dann genauso lange wie die Erstellung eines kompletten Backups), nur diese zu sichern, auf der WD Blue 3D zu löschen und neu zu schreiben.

Da sich bei mir nur ein paar wenige Dateien langsam (10 von gut 16000 Dateien mit 90-150 MB/s) lesen lassen, ist mir das erst einmal egal. Ein Backup der Daten gibt es sowieso, falls irgendwann eine Datei nicht mehr lesbar sein sollten. Leider liefert das Tool nur eine einzige Zahl für jede Daten, was bei einer 2TB Datei recht ungenau ist.

Würdest Du ernsthaft ein Firmware-Update ohne Backup einspielen? Ich jedenfalls nicht. Entweder, das Backup gibt es, dann entfällt die Zeit auch mit dem seltsamen Workaround. Oder es es gibt dies nicht, dann íst es jetzt endlich Zeit, eins anzulegen und es dauert halt.EDV-Leiter schrieb:Insofern kann ich den Workaround von WD nicht ganz ernst nehmen, da nicht wirklich praxistauglich.

Zuletzt bearbeitet:

Also den Werten links in den Details nach sind meine wohl noch fit. Die zweite sieht auf dem Bild glaube ich schlimmer aus als es ist mit den min 31 MB/s.

Das ist auch eher mein Datengrab, wo einerseits viele kleine Dateien (vollkommen legale Musiksammlung hust) als auch große Klopper liegen (Sicherungskopien diverser Spiele-CDs und Spiele-Installer).

Nihil Baxxter

Lt. Junior Grade

- Registriert

- Mai 2020

- Beiträge

- 457

Demolition-Man

Rear Admiral

- Registriert

- Juli 2004

- Beiträge

- 5.861

Edit: Hat nichts mit meiner PCIe M.2 SSD zu tun?

Der Name ist aber fast identisch?!

Betrifft also nur SATA?

Bin ein wenig verwirrt, sorry.

Der Name ist aber fast identisch?!

Betrifft also nur SATA?

Bin ein wenig verwirrt, sorry.

Zuletzt bearbeitet:

- Registriert

- Juli 2010

- Beiträge

- 12.935

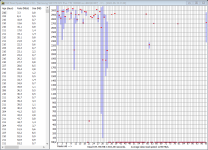

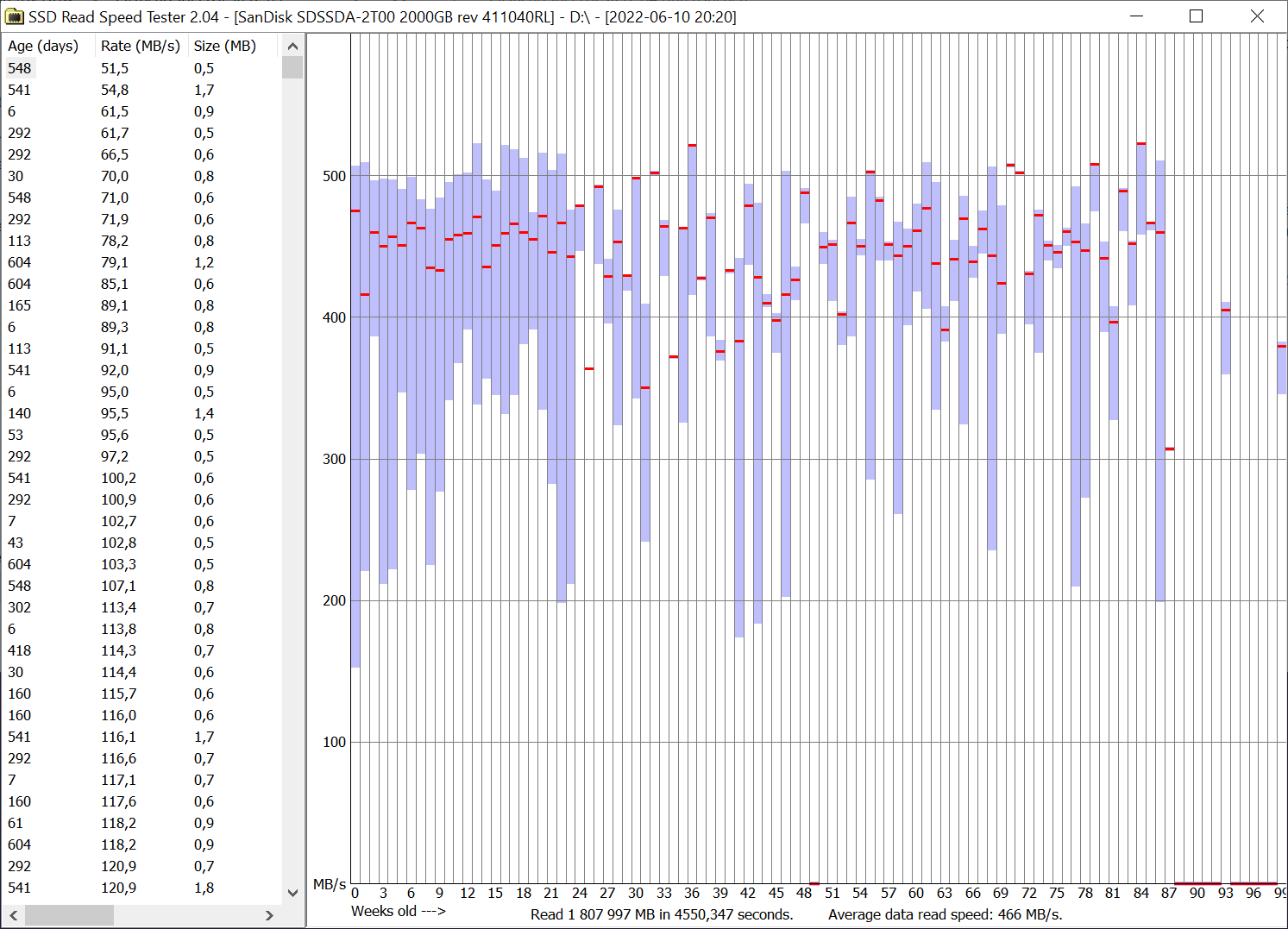

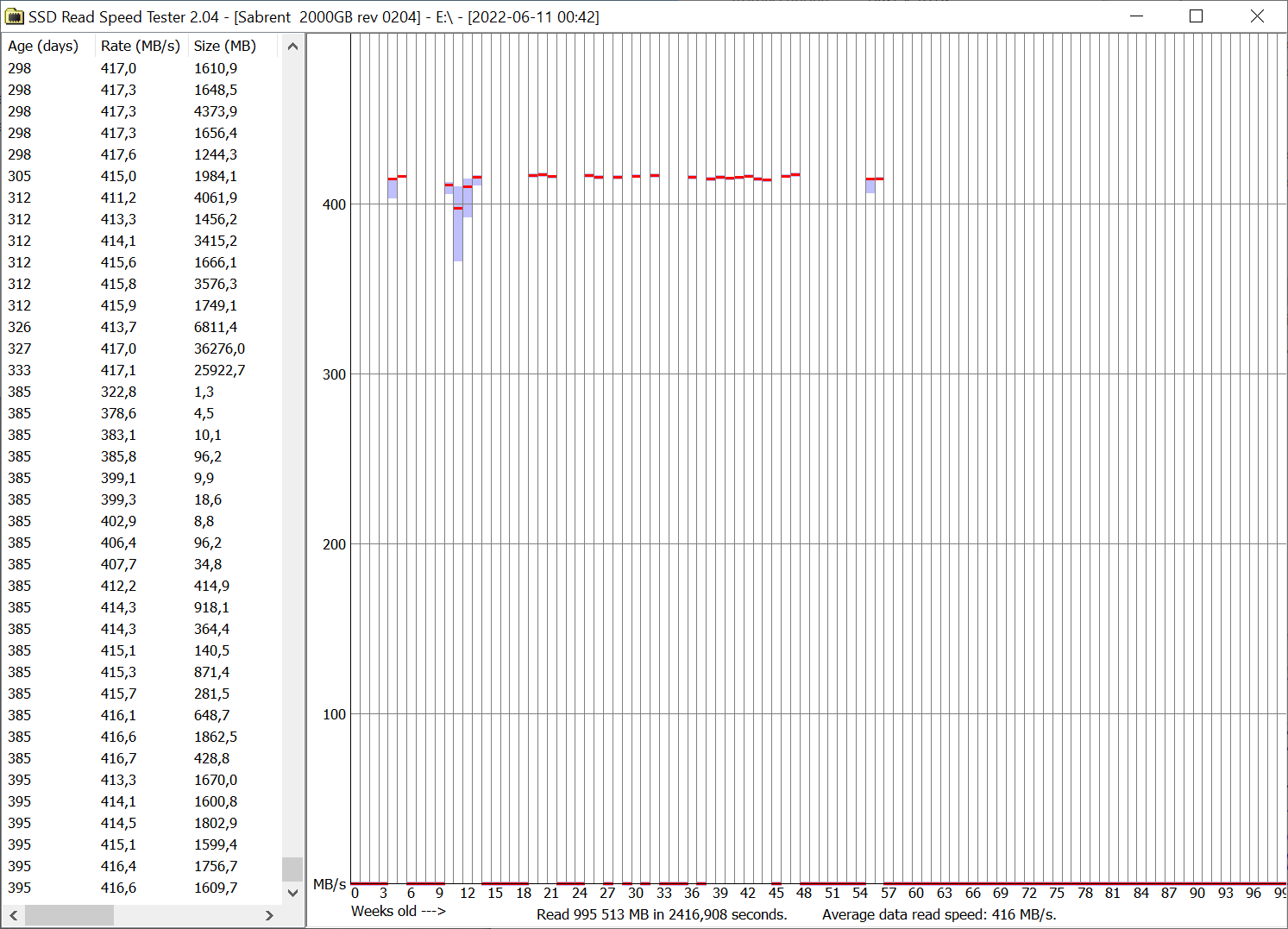

Danke für eure Screenshots! Ehrlich gesagt verwirren mich die Graphen von dem Tool inzwischen selbst. Wofür steht eigentlich die rote Linie? 😅 Aber wenn oben links nichts im einstelligen Bereich steht und unten rechts der Average Speed bei ~500 MB/s (SATA) steht, dann sollte alles passen. Bei den betroffenen sind es ja nur noch ~50 MB/s Average.

@Demolition-Man Es ging primär um die genannten SATA-Modelle, aber Screenshots mit NVMe-Drives sind auch willkommen.

@Demolition-Man Es ging primär um die genannten SATA-Modelle, aber Screenshots mit NVMe-Drives sind auch willkommen.

Stormfirebird

Admiral

- Registriert

- Sep. 2012

- Beiträge

- 9.202

Durchschnittliche Leserate für den Tag würde ich behaupten.MichaG schrieb:Wofür steht eigentlich die rote Linie?

Was ist fit und was sollte man als "langsam" bezeichnen. Oder besser: wie testet dieses Programm? Für mich sind auch Dateien >20MB, die mit <200 MB/s gelesen werden, auf einer SATA SSD langsam.shirkai schrieb:Also den Werten links in den Details nach sind meine wohl noch fit.

Das ganze ist wohl eher ein grobes Schätztool welches nur dann sinnvolle Erkenntnisse liefert, wenn große Dateien extrem langsam lesbar sind. Oder wenn, wie in dem Beispiel aus dem Artikel, quasi die gesamte SSD nahezu unlesbar ist. Sprich wenn man auch bei jedem Zugriff auf beliebige Dateien sofort merkt, dass etwas nicht ok ist.

Ich habe das "Tool" zweimal über meine WD Blue 3D 4TD (zwangsweise SATA da WD die ja nicht als 4TB M.2 Variante bringen will) laufen lassen, und da kann man die Werte schlicht vergessen. Dagegen sind Crystal Disk Mark Werte noch um Welten konsistenter.

Die einzig echte Erkenntnis, die ich aus dem Programm ziehe ist, dass auf meiner Crucial M500 (960GB) weniger Dateien von dem Tool langsam gelesen werden können wie auf meiner WD Blue 3D.

Anhänge

Bei mir sind zwei Blue 3D 1TB vom Problem betroffen, Alter der Daten jeweils anderthalb Jahre. Eine der beiden dient als Backup meiner Datenpartition der System-SSD (Samsung 860 Evo), hauptsächlich Dokumente sowie Fotos und Musikdateien, welche sich nach einmaligem Schreiben praktisch nie mehr ändern (auf beiden SSDs und auch beim zweiten Backup auf Crucial MX500 nicht). Die andere beherbergt mein Spielesystem mit der Steam-Bibliothek, deren Daten ebenfalls nach der Installation sich großteils nicht mehr ändern, außer bei Spielen, die immer noch regelmäßig Updates erhalten.

Abhilfe hat bei mir die Verwendung von "badblocks -nvs" in einem Live-Linux gebracht. Das hat sämtliche Daten (im Rohformat) eingelesen und neu geschrieben. Hat sogar mit meinen Verschlüsselten Daten auf den SSDs funktioniert, ohne irgendwas zu zerschießen. Das ist sicher die beste Methode, wenn man sich ein Formatieren, wie von WD vorgeschlagen, aus verständlichen Gründen ersparen will. (Hier macht es sich der Hersteller sehr leicht und wälzt das Problem auf die Kunden ab. Noobs sind so oder so davon überfordert und dürfen sich mit einem unbrauchbaren Spielesystem rumärgern oder alles neu installieren.) Nachteil: Bei meinen 1TB-SSDs hat die Prozedur rund 16 Stunden gedauert, weil die Lesbarkeit der Daten bereits so schlecht war. Möglicherweise geht es schneller, wenn die Daten noch nicht so alt sind. Ich werde den Verlauf über die Zeit mal beobachten. Der Vorgang verbraucht halt jedes Mal einen Schreibzyklus, aber gerade wenn die SSD voller Daten ist, die nie überschrieben werden, verbraucht man ja im täglichen Einsatz kaum Schreibzyklen, so dass das leicht zu verschmerzen ist. Der Aufwand des Ganzen ist aber ein Unding, wenn man bedenkt, dass man ihn bei den Konkurrenzprodukten von Samsung und Crucial nicht hat.

Mir ist inzwischen eingefallen, dass ich noch eine dritte Blue 3D habe (im Nachhinein blöd, so viele gekauft zu haben, waren halt die günstigsten der bisher empfehlenswerten SSDs), eine M.2 mit 500GB. Diese steckt in einem USB-Gehäuse und dient mir nur als Transportmittel zwischen verschiedenen Rechnern, deshalb sind da keine alten Daten drauf. Aber ich werde mal Testdaten ablegen und beobachten, ob das Problem dort nach einiger Zeit genauso auftritt.

Abhilfe hat bei mir die Verwendung von "badblocks -nvs" in einem Live-Linux gebracht. Das hat sämtliche Daten (im Rohformat) eingelesen und neu geschrieben. Hat sogar mit meinen Verschlüsselten Daten auf den SSDs funktioniert, ohne irgendwas zu zerschießen. Das ist sicher die beste Methode, wenn man sich ein Formatieren, wie von WD vorgeschlagen, aus verständlichen Gründen ersparen will. (Hier macht es sich der Hersteller sehr leicht und wälzt das Problem auf die Kunden ab. Noobs sind so oder so davon überfordert und dürfen sich mit einem unbrauchbaren Spielesystem rumärgern oder alles neu installieren.) Nachteil: Bei meinen 1TB-SSDs hat die Prozedur rund 16 Stunden gedauert, weil die Lesbarkeit der Daten bereits so schlecht war. Möglicherweise geht es schneller, wenn die Daten noch nicht so alt sind. Ich werde den Verlauf über die Zeit mal beobachten. Der Vorgang verbraucht halt jedes Mal einen Schreibzyklus, aber gerade wenn die SSD voller Daten ist, die nie überschrieben werden, verbraucht man ja im täglichen Einsatz kaum Schreibzyklen, so dass das leicht zu verschmerzen ist. Der Aufwand des Ganzen ist aber ein Unding, wenn man bedenkt, dass man ihn bei den Konkurrenzprodukten von Samsung und Crucial nicht hat.

Mir ist inzwischen eingefallen, dass ich noch eine dritte Blue 3D habe (im Nachhinein blöd, so viele gekauft zu haben, waren halt die günstigsten der bisher empfehlenswerten SSDs), eine M.2 mit 500GB. Diese steckt in einem USB-Gehäuse und dient mir nur als Transportmittel zwischen verschiedenen Rechnern, deshalb sind da keine alten Daten drauf. Aber ich werde mal Testdaten ablegen und beobachten, ob das Problem dort nach einiger Zeit genauso auftritt.

Demolition-Man

Rear Admiral

- Registriert

- Juli 2004

- Beiträge

- 5.861

Meine Sandisk SSD ist zu neu das bringt nichts, sorry. Alle Dateien oben links in der Ecke und volles Tempo.

Was ich anbieten kann, ist ein Vergleich mit meiner Samsung. Die macht auch komische Sachen... vielleicht nur defekt.^^

Das bringt mich aber auf Ideen, noch aus HDD Zeiten, daher vielleicht obsolet: Ein Systemlaufwerk neigt eher zu Einbrüchen bei Tests als ein zusätzliches. Die Dateigröße spielt ein Rolle, richtig große Dateien von Games, oder viele winzige Systemdateien führen zu unterschiedlicher Geschwindigkeiten. Aber eher beim Schreiben?

Falls ich Müll schreibe, bitte drauf hinweisen, danke:

Vielleicht sollte man mal alle SSD`s Queerbeet gegentesten...

Was ich anbieten kann, ist ein Vergleich mit meiner Samsung. Die macht auch komische Sachen... vielleicht nur defekt.^^

Das bringt mich aber auf Ideen, noch aus HDD Zeiten, daher vielleicht obsolet: Ein Systemlaufwerk neigt eher zu Einbrüchen bei Tests als ein zusätzliches. Die Dateigröße spielt ein Rolle, richtig große Dateien von Games, oder viele winzige Systemdateien führen zu unterschiedlicher Geschwindigkeiten. Aber eher beim Schreiben?

Falls ich Müll schreibe, bitte drauf hinweisen, danke:

Vielleicht sollte man mal alle SSD`s Queerbeet gegentesten...

Anhänge

die 4TB hat wohl eine leicht neuere Firmware mit 411040 statt 411030 bei den 1-2TB

die 500er von @Sje2006 hat 415000 als firmware - ist das normal bei den M.2 SATA?

401020 habe ich auch noch gesehen, vermutlich der Vorgänger von 411030 oder ist das die Linie einer möglichen älteren Hardwarerevision?

die 500er von @Sje2006 hat 415000 als firmware - ist das normal bei den M.2 SATA?

401020 habe ich auch noch gesehen, vermutlich der Vorgänger von 411030 oder ist das die Linie einer möglichen älteren Hardwarerevision?

T3rm1

Lieutenant

- Registriert

- Nov. 2005

- Beiträge

- 683

Ist ja jetzt nicht so, dass die neuen Daten genau im gleichen Speicherbereich landen würden.Dabei genügte laut Anwendern bereits eine Formatierung und das anschließende Wiederaufspielen der zuvor gesicherten (!) Daten.

Beitrag

Fleet Admiral

- Registriert

- Nov. 2011

- Beiträge

- 10.738

Na na na, ein bisschen Umweltbewusstsein bitte. Bevor du sie wegschmeißt, kannst du sie auch einfach mir schenken.FR3DI schrieb:Sollte sich dort etwas "Negatives" ergeben, gehen die direkt in die Tonne!

Ergänzung ()

Das ist kein "Workaround", das macht jede SSD. Und zwar egal ob MLC, TLC oder QLC. Mit der Zeit macht sich die gespeicherte Ladung eben vom Acker, das ist der Lauf der Dinge.RayKrebs schrieb:Tja, so ist das halt mit SSDs die mehr 3-4Bits in einer Zelle speichern. Das ist dann quasi Analogtechnik und wenn die Zelle altert sinken die Pegel und die ECC muss heftig ausgleichen, das kostet dann Zeit.

Wenn mich nicht alles täuscht war das bei Samsungs 840Evo dann auch der Workaround, das die Daten im Hintergrund neu auf andere Speicherzellen umkopiert wurden.

Bei DRAM-Zellen ist die Information in winzigen Kondensatoren gespeichert, deren Ladung so klein ist, dass sie zigtausend mal pro Sekunde aufgefrischt werden muss und bei jedem Lesevorgang muss man dann so einen winzig kleinen Strom richtig messen und die Ladung fließt dabei auch noch ab und muss neu aufgebracht werden.

Und es funktioniert trotzdem.

Zuletzt bearbeitet:

Tenferenzu

Banned

- Registriert

- Okt. 2017

- Beiträge

- 6.473

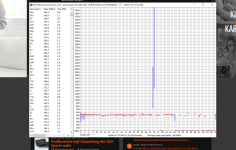

Meine 2TB Sandisk Plus zeigt jetzt keine wirklichen Anzeichen von Schwäche. Die 2TB Sandisk Pro ist gerade noch am durchlaufen und wird später nachgereicht.

Plus:

Pro:

Edit: Die Plus läuft seit Sommer 2019 in meinem Thinkpad E495 als Datenplatte und ist dementsprechend voll. Die Pro dagegen wurde irgendwann vor ca. 2 Jahren formattiert und dient als externe Festplatte in einem USB-Gehäuse. Davor war sie 3 Jahre in meinem Desktop als Datenplatte. Allgemein zeigen beide Platten keine auffälligkeiten. Die einzige Auffälligkeit ist, das die verbaute 970 Evo im Thinkpad manchmal doch arg langsam ist beim öffnen von Ordnern und Dateien aber das ist irgendein Thinkpad, Windows 10, Ryzen Problem das so noch nie unter Linux vorgekommen ist. (Die davor verbaute SN530 256 GB hatte das gleiche Problem weswegen ich so viel Geld in eine 970 Evo gesteckt habe um danach herauszufinden, dass das Problem weiterhin besteht......)

Plus:

Pro:

Edit: Die Plus läuft seit Sommer 2019 in meinem Thinkpad E495 als Datenplatte und ist dementsprechend voll. Die Pro dagegen wurde irgendwann vor ca. 2 Jahren formattiert und dient als externe Festplatte in einem USB-Gehäuse. Davor war sie 3 Jahre in meinem Desktop als Datenplatte. Allgemein zeigen beide Platten keine auffälligkeiten. Die einzige Auffälligkeit ist, das die verbaute 970 Evo im Thinkpad manchmal doch arg langsam ist beim öffnen von Ordnern und Dateien aber das ist irgendein Thinkpad, Windows 10, Ryzen Problem das so noch nie unter Linux vorgekommen ist. (Die davor verbaute SN530 256 GB hatte das gleiche Problem weswegen ich so viel Geld in eine 970 Evo gesteckt habe um danach herauszufinden, dass das Problem weiterhin besteht......)

Zuletzt bearbeitet:

redjack1000

Fleet Admiral

- Registriert

- März 2022

- Beiträge

- 10.256

Ui ich habe zwei von den WD Blue 1TB Sata SSD, mit genau dem Fehlerbild, in meiner Grabbelkiste liegen. Dann hol ich die bei Gelegenheit mal wieder raus und schau mir die mal genauer an.

Die waren in einer Workstation verbaut, als Raid1 (Intel Software Raid). Ich hatte die schon abgeschrieben, und ersetzt durch Samsung Pro SSD.

Ergebnisse werden folgen, sehr spannend.

CU

redjack

Die waren in einer Workstation verbaut, als Raid1 (Intel Software Raid). Ich hatte die schon abgeschrieben, und ersetzt durch Samsung Pro SSD.

Ergebnisse werden folgen, sehr spannend.

CU

redjack

Ähnliche Themen

- Antworten

- 168

- Aufrufe

- 23.091

- Antworten

- 61

- Aufrufe

- 12.215

- Antworten

- 26

- Aufrufe

- 5.981