Turing TU102, -104, -106: Die Technik der Nvidia GeForce RTX 2080 Ti, 2080 & 2070

3/3SLI über NVLink mit 85-Euro-Brücke

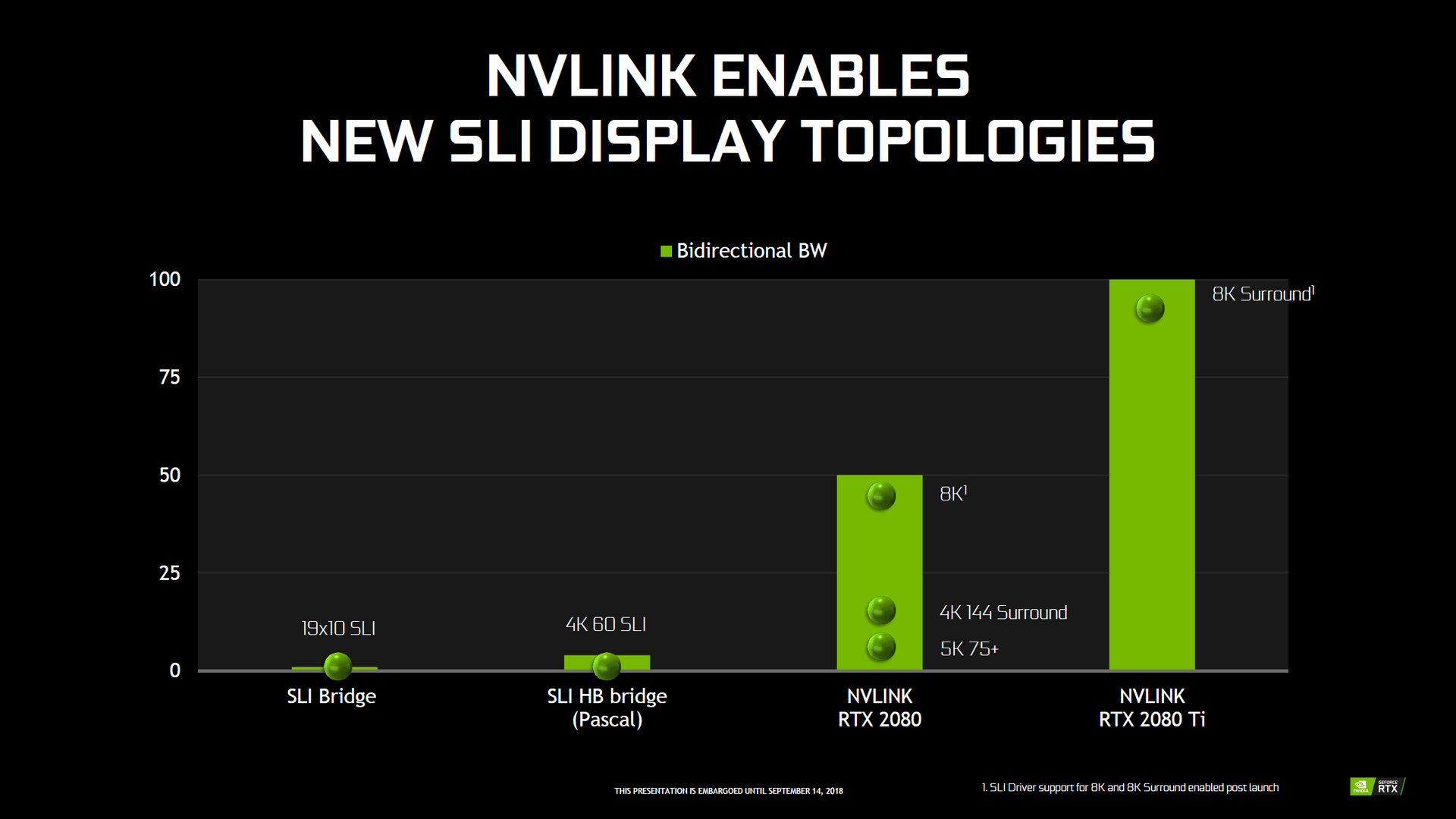

SLI, ein bei Spieler-Grafikkarten zuletzt nur noch stiefmütterlich behandeltes Thema, kommuniziert auf Turing nicht mehr wie bisher über eine klassische SLI- oder eine SLI-HB-Brücke, sondern über den bisher für professionelle Nvidia-Grafikkarten gedachten NVLink-Anschluss. Der Vorteil ist die massiv höhere Bandbreite. Der Nachteil lag in der Vergangenheit beim Preis. Kosteten entsprechende Brücken bisher über 500 Euro, gibt es die GeForce-RTX-Version allerdings jetzt für 85 Euro. Eine SLI-HB-Brücke bleibt mit 40 Euro trotzdem deutlich günstiger. SLI ist auf Turing mit maximal zwei Grafikkarten möglich.

| Grafikkarte | SLI über | Bandbreite je Richtung |

|---|---|---|

| GeForce RTX 2080 Ti | NVLink | 50 GB/s |

| GeForce RTX 2080 | NVLink | 25 GB/s |

| GeForce RTX 2070 | - | - |

| GeForce GTX 1080 Ti | SLI-HB | < 5 GB/s |

| GeForce GTX 1080 | SLI-HB | < 5 GB/s |

| GeForce GTX 1070 | SLI-HB | < 5 GB/s |

NVLink mit bis zu 100 GB/s für SLI

Dafür liefert selbst eine SLI-HB-Bridge nur eine Bandbreite von unter 5 GB/s. Die TU102-GPU (RTX 2080 Ti) unterstützt hingegen – wie auf Quadro RTX 8000 und 6000 – zwei NVLinks der zweiten Generation mit acht Lanes. Jeder Link bietet 25 GB/s in eine Richtung. Damit verfügt der TU102 über eine Bandbreite von 50 GB/s pro Richtung für SLI, insgesamt also 100 GB/s. Das reicht laut Nvidia auch noch für den 8K-Surround-Betrieb (drei Monitore mit jeweils 8K-Auflösung). Die TU104-GPU (GeForce RTX 2080 und Quadro RTX 5000) muss sich dann mit einem NVLink zufrieden geben. Entsprechend sinkt die Bandbreite auf 25 GB/s pro Richtung und insgesamt 50 GB/s. Laut Nvidia ist die Bandbreite ausreichend für 4K Surround mit 144 Hz, 5K mit 75 Hz oder 8K mit 60 Hz.

Zum Vergleich: Nvidia Volta auf der Tesla V100 unterstützt mit maximal sechs NVLink-Anbindungen bis zu 300 GB/s und als Quadro mit vier NVLinks bis zu 200 GB/s.

Kein NVLink = kein SLI für die RTX 2070

Die TU106-GPU verzichtet dagegen auf NVLink. Entsprechend unterstützt die GeForce RTX 2070 kein SLI. Bei Pascal war hingegen die GeForce GTX 1060 die erste Karte ohne SLI-Funktion.

Raytracing auf Turing im Detail

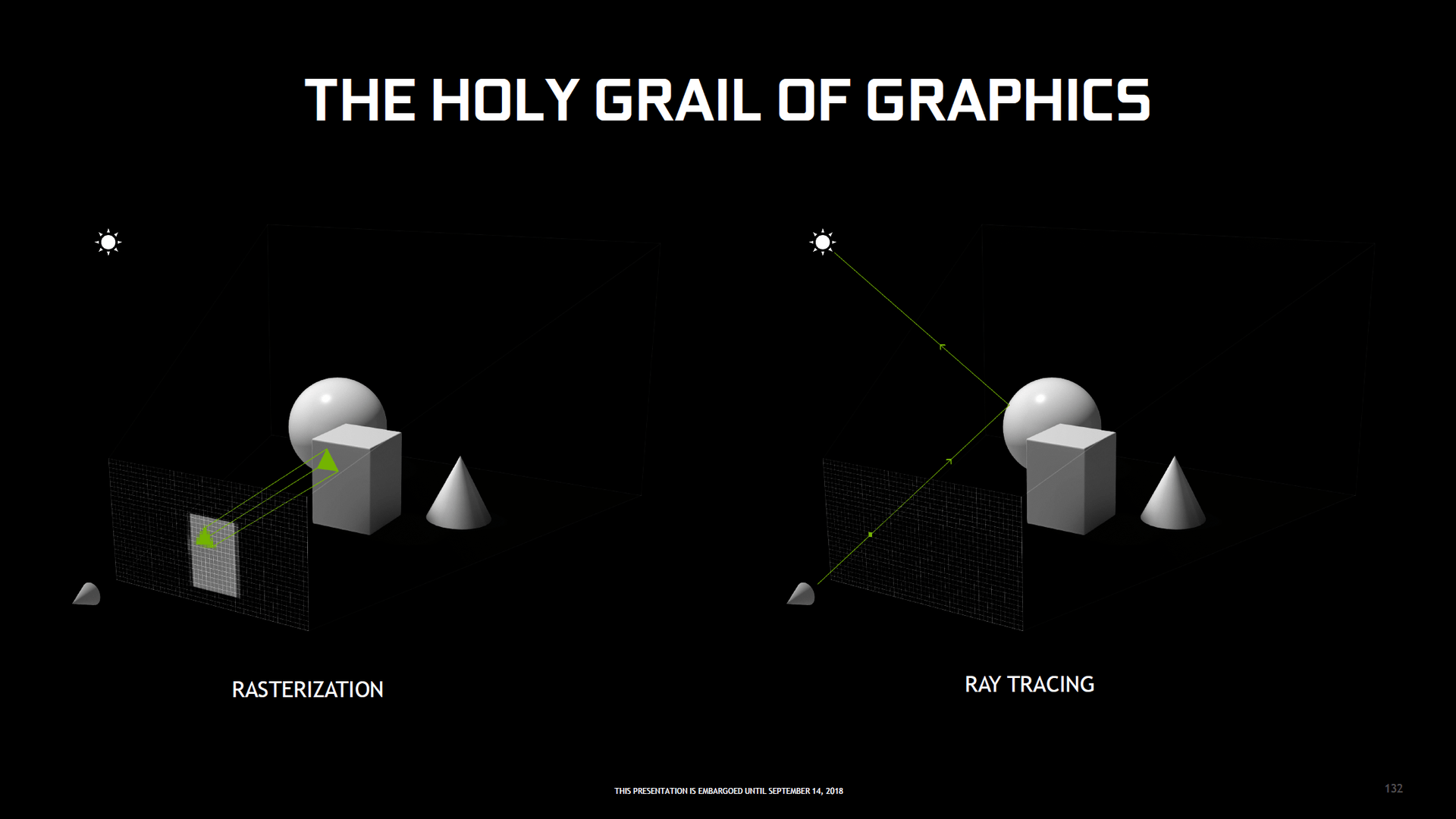

Moderne Spiele rendern eigentlich durchweg auf Basis eines Rasterizers. Er übersetzt Vektorgrafiken anhand definierter Regeln in aus Pixel zusammengesetzte Bilder. Es wird mit Tricks gearbeitet. Das geht auf Kosten der Qualität, liefert aber eine gute Performance. Clipping-Fehler, also in Spielen sichtbare Gegenstände, die eigentlich nicht sichtbar sind, oder Lichtquellen ohne realistischen Licht- und Schattenwurf sind prominente sichtbare Nachteile.

Raytracing nutzt Lichtstrahlen statt Tricks

Raytracing geht anders vor. Hier werden Lichtstrahlen ausgehend von Lichtquellen verschossen, die dann auf Objekte treffen und so die Sichtbarkeit von dreidimensionalen Objekten überprüfen. Die Lichtstrahlen können dann noch verschieden oft reflektiert werden, um so den Einfluss von Objekten auf anderen Objekten zu berechnen. So wird sichergestellt, dass der Spieler nur das sieht, was von Lichtstrahlen erreicht wurde, die dann wiederum „in sein Auge“ reflektiert wurden – und sorgt darüber hinaus für eine korrekte Darstellung von Licht und Schatten.

Raytracing kann bei entsprechend vielen Strahlen damit absolut realistische Grafikeffekte erzeugen. Doch das Problem ist: Raytracing ist enorm rechenintensiv. Selbst High-End-Rechner waren dafür bis jetzt viel zu langsam. Deshalb wurde bisher nur auf Raytracing zurück gegriffen, wenn die Grafik möglichst realistisch sein sollte, die Rechenzeit aber keine übergeordnete Rolle spielt. Die Filmbranche greift auf Raytracing zurück, denn dort ist es weniger ein Problem, wenn jedes Frame mehrere Stunden zur Vollendung braucht.

Exkurs: Was ist Raytracing?

Mehr Details gefällig? ComputerBase hatte sich bereits vor Jahren in der Serie „Raytracing in Spielen“ ausführlich mit dem Thema Raytracing befasst. Die darin präsentierten Informationen und Erkenntnisse zur alternativen Rendering-Methode sind auch heute noch gültig. Besonders empfehlenswert: Wie funktioniert Raytracing?

In Spielen werden Hybrid-Engines zum Einsatz kommen

Nvidia verfolgt mit der Turing-GPU und damit den GeForce-RTX-Grafikkarten im Spiele-Bereich einen Mittelweg, den Microsoft mit DXR in DirectX 12 definiert hat und mit Windows 10 Oktober 2018 Update ausliefern wird – und Vulkan wird folgen. Mit Hilfe der Raytracing-Kerne („RT Cores“) sollen die GPUs schnell genug dafür sein, um einen hybriden Rasterizer/Raytracing-Ansatz in Echtzeit wiederzugeben. Sprich, nur einige wenige Elemente werden mit Raytracing berechnet. Der Großteil dagegen immer noch mit dem klassischen Rasterizer.

Manche Grafikeffekte sind mit Rasterisierungstechniken nur schwer, falsch oder überhaupt nicht zu realisieren. Genau dort soll in den entsprechenden Spielen dann Raytracing zum Einsatz kommen. Als Einsatzszenario nennt Nvidia Reflexionen, Lichtbrechungen, Schatten, Umgebungsverdeckung, Global Illumination und auch spezielle Lichtberechnungen, die bis jetzt im voraus berechnet werden mussten. Zudem gibt es weitere Einsatzmöglichkeiten wie Sichtbarkeitsprüfungen, Audio-Simulation, Partikelsimulationen und Sichtbarkeitsprüfungen für KI.

Aber auch für den hybriden Ansatz wird extrem viel Rechenleistung benötigt. Daher picken sich die aktuell bereits mit Raytracing angekündigten Spiele nur einzelne Punkte heraus. In Battlefield 5 werden zum Beispiel nur die Reflexionen mit Raytracing berechnet. In Shadow of the Tomb Raider sind es die Schatten. Und auch dann muss man Leistungseinbußen in Kauf nehmen.

Leistungsverluste auch auf GeForce RTX

So peilt Dice für Battlefield V zum Beispiel Full HD mit stabilen 60 FPS an – auf einer GeForce RTX 2080 Ti wohlgemerkt. Mit derselben Grafikkarte sind ohne Raytracing problemlos 3.840 × 2.160 bei der Framerate möglich. Tomb Raider läuft aktuell in Full HD sogar nur mit 30 FPS.

Entwickler und Nvidia betonen, dass es noch viel Optimierungspotential gibt. Erst die Verfügbarkeit finaler Titel mit DXR (RTX) wird also zeigen, wie gut das optische Ergebnis ist und wie stark der Leistungsverlust ausfällt. Nicht nur das optische Potential ist in jedem Fall groß, denn auch die Sichtbarkeitsprüfung für KI-Charaktere verspricht deutliche Vorteile gegenüber dem Status quo. Die Situation schreit nach einem klassischen Henne-Ei-Problem: Ohne erste DXR-Beschleuniger keine DXR-Spiele und ohne DXR-Spiele keine DXR-Beschleuniger.

Turing ist der Anfang mit KI-Trick

Turing ist erst der Anfang vom Rasterizer-Raytracing-Hybrid, dass der Technik mittelfristig eine große Zukunft bevorsteht, davon ist auszugehen. Das wird allerdings noch viel mehr Rechenleistung erforderlich machen.

Denn um eine perfekte RT-Grafik zu erreichen, müssten pro Pixel eigentlich viele Strahlen verschossen werden. Zum Anfang wird es hingegen nicht einmal einen Strahl für jeden Pixel geben. Dadurch kommt das Problem auf, dass die Grafik ein starkes Rauschen (Noise) aufweist, da diverse Informationen fehlen. Es gibt aber mittlerweile Möglichkeiten, das Rauschen extrem gut abzustellen. Eine auf KI-Basis nutzt Nvidia bei Turing.

Denoising per Tensor-Kern oder auch per Compute

Nvidia sieht als Denoiser („Entrauscher“) primär die neuen Tensor-Kerne vor. So lässt sich per AI Learning ein KI-basierter Denoiser für ein Spiel anlernen, der die Grafikartefakte aus dem finalen Bild quasi verlustfrei entfernen kann. Durch die Tensor-Kerne soll Turing das sehr schnell erledigen können. Die Nutzung der Tensor-Kerne ist nicht Teil von DXR, sondern läuft über Nvidias GameWorks-Programm ab. Auch wenn ein anderer GPU-Hersteller „KI-Kerne“ hätte, wären diese also nicht nutzbar. AMD müsste also eine eigene Lösung anbieten, um das Rauschen im DXR-Raytracing zu unterdrücken.

Aber es gibt auch Ansätze ohne KI. So nutzt Dice für Battlefield V zum Beispiel einen Compute Shader über die klassischen ALUs, um das Denoising zu erledigen. Optisch lassen sich bei der Umsetzung nur an wenigen Stellen kleine Artefakte erkennen, ansonsten ist auch dieser Weg optisch sehr gut und auf Nvidia- und AMD-Grafikkarten anwendbar. Wie viel Performance der Compute-Ansatz kostet, ist unklar, es dürfte aber mehr sein als der KI-Ansatz über Tensor-Cores.

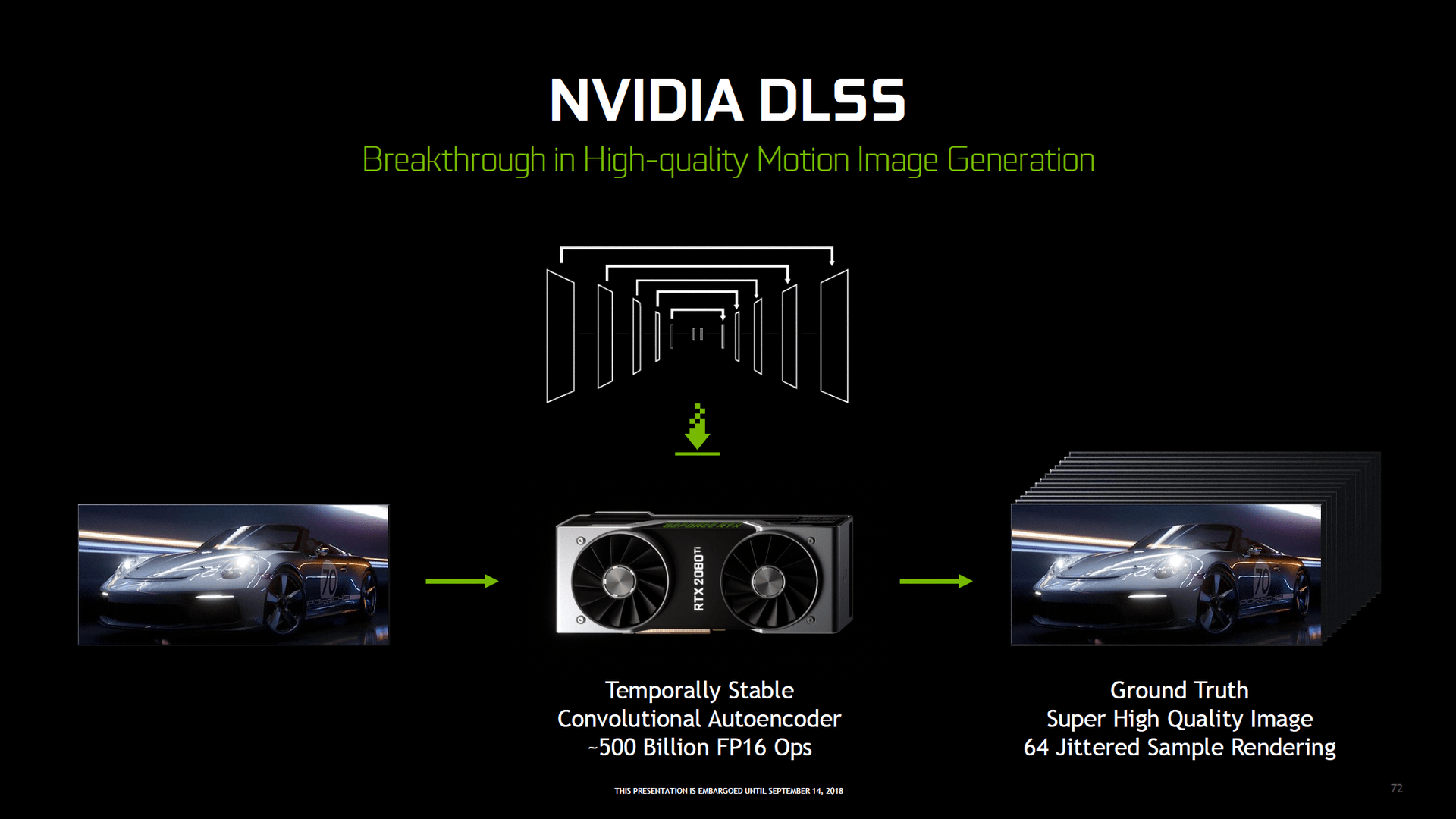

Eine Kantenglättung mit Deep Learning

Mit den Tensor-Kernen der Turing-GPUs lassen sich KI-basierte Algorithmen sehr schnell ausführen. Das hat zwar primär Einsatzgebiete im professionellen Bereich, doch soll es auch Vorteile für Spieler geben. So bietet Nvidia auf Turing mit DLSS (Deep Learning Super-Sampling) eine KI-basierte Kantenglättung an.

DLSS ist Kantenglättung mit KI-Unterstützung auf der Cloud

Damit DLSS funktioniert, muss auch in diesem Fall der Spieleentwickler mit Nvidia zusammen arbeiten und die neue NGX-API in das Spiel integrieren. Der Entwickler muss das Spiel Nvidia zur Verfügung stellen und Nvidia selbst lässt dann einen KI-Algorithmus (AI Learning) über das Spiel laufen, der die „Grafik kennenlernt“. Nvidia nutzt nach eigenen Angaben tausende extrem hochauflösende Bilder zum Antrainieren des neuronalen Netzwerkes.

Der Spieler muss wiederum GeForce Experience installieren, da das Tool die Ergebnisse der KI herunterladen und über die NGX-API integrieren kann. Theoretisch können auch über das Spiel selbst (per Patch) oder über den Grafiktreiber die Algorithmen ausgeliefert werden. Nvidia sieht aktuell aber anscheinend nur die Variante per GeForce Experience vor.

Der Ersteindruck zu DLSS überzeugt

DLSS gibt es in zwei verschiedenen Qualitätsstufen. DLSS und DLSS 2X. Die Qualität soll dem von 64× Super Sampling entsprechen. Mit DLSS soll die Qualität der Kantenglättung deutlich besser als mit dem derzeit oft genutzten Post-Processing-AA ausfallen. So soll es diverse Probleme wie Unschärfe oder fehlerhafte Details durch das Berücksichtigen mehrerer Frames für einen temporalen Effekt mit DLSS nicht geben. Allerdings gibt Nvidia zu, dass auch DLSS nicht perfekt ist und es zu Problemen kommen kann. Mit mehr Training könnte diese Probleme aber mit der Zeit ausgeräumt werden. Da DLSS über die Tensor-Kerne berechnet wird, soll die Kantenglättung zudem sehr schnell auf Turing laufen – genaue Angaben gibt es aber noch nicht.

ComputerBase konnte sich DLSS 2X in Epics Infiltrator-Demo bereits ansehen. Dort hinterließ die neue Kantenglättung einen sehr guten Eindruck, die dem von TAA klar überlegen gewesen ist. Allerdings war dies nur ein Beispiel. Ob DLSS genauso gut in richtigen Spielen funktioniert, wird sich noch zeigen müssen. 21 Spiele mit DLSS sind angekündigt, wann sie erscheinen hingegen noch unbekannt.

Neue Shader(-Tricks) für mehr Performance

Nvidia hat mit Turing noch weitere Änderungen an der Architektur vorgenommen und diese unter „Advanced Shading Technologies“ zusammengefasst. Ein Überblick:

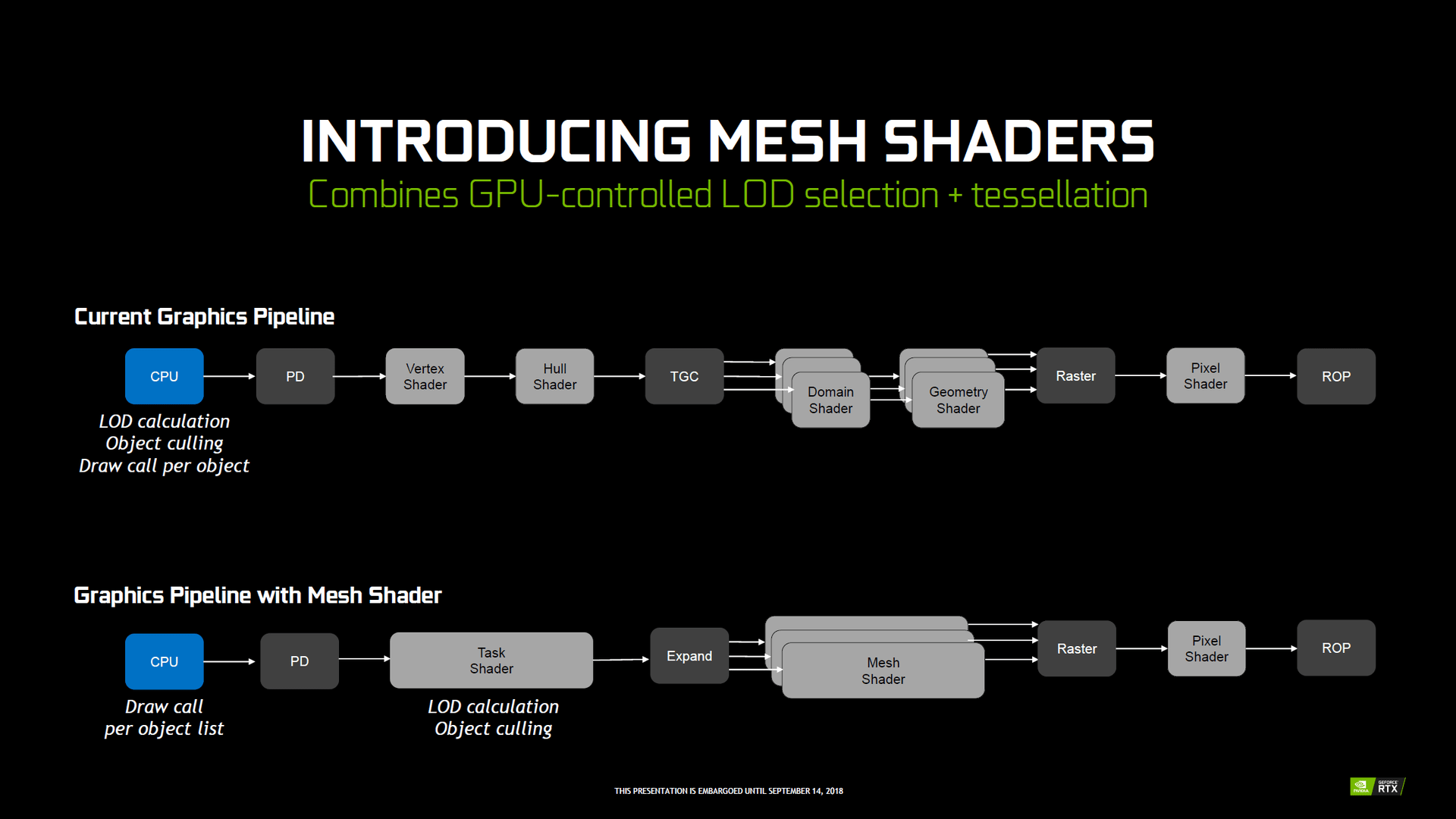

Mesh Shading vernetzt Shader

Mit Hilfe von Mesh Shading soll es für Entwickler einfacher werden, Draw-Call-Engpässe auf der CPU mit Hilfe einer neuen Shader-Pipeline zu umgehen, sodass deutlich mehr Dreiecke als zuvor in einem Frame genutzt werden können um komplexere Umgebungen ohne Leistungsverlust zu erstellen.

Mesh Shader verkürzen die klassische Render-Pipeline, die unter anderem aus Vertex Shader, Hull- sowie Domain- Shader für Tessellation, Geometry Shader und Pixel Shader bestehen. Mesh Shading fasst den Vertex und den Hull Shader als Task Shader und den Domain Shader sowie den Geometry Shader als Mesh Shader zusammen. Die überarbeitete Pipeline beherrscht dieselben Fähigkeiten, ist aber individueller programmierbar. Anstatt dass die CPU jedes einzelne Objekt mit einem eigenen Draw Call an die GPU schickt, kann der Entwickler der GPU direkt eine Liste an Objekten schicken, um so die Anzahl der Draw Calls auf der CPU zu reduzieren.

Variable Rate Shading fasst Pixel zusammen

Mit Hilfe von Variable Rate Shading (VRS) wird es wiederum möglich sein, dass die Shading Rate von Dreiecken in einem 16×16 Pixel großen Feld unterschiedlich ausfallen kann. Normalerweise wird jedes Pixel mit einem eigenen Shader berechnet. Mit VRS kann der Entwickler jetzt festlegen, dass in dem 16×16 Pixel großen Feld zum Beispiel nur 4 oder nur 16 Pixel einen eigenen Farbwert erhalten. Laut Nvidia benötigt bei manchen Objekten beziehungsweise Szenen nicht jedes Pixel einen eigenen Farbwert, sodass mit einer geringeren Shading Rate die Performance verbessert werden kann, ohne dass dies optisch auffällt.

Content Adaptive Shading ist automatisches VRS

Content Adaptive Shading (CAS) macht eigentlich genau dasselbe wie Variable Rate Shading. Allerdings konfiguriert nicht der Entwickler, welche Bereiche eines Frames mit welcher Shading Rate berechnet werden. Stattdessen wird der letzte dargestellte Frame nach der Fertigstellung durch die GPU analysiert und berechnet, in welchem Bereich des Bildes es nur geringe Details gegeben hat. Daraufhin reduziert CAS in diesem Bereich für den nächsten Frame die Shading Rate automatisch. Laut Nvidia soll das ohne Qualitätsverlust möglich sein.

Es gibt auch neue Optimierungen für VR-Spiele

Mit Multi-View Rendering kann ein Entwickler nun zum Beispiel eine Szene aus mehreren verschiedenen Blickpunkten aus rendern lassen – in einem Renderdurchgang. Bis zu vier Blickpunkte sind in einem Renderdurchgang möglich. MVR erweitert das mit Pascal eingeführte Simultaneous Multi-Projection (SMP) und eignet sich für VR-Anwendungen, die dadurch beschleunigt werden können.

Vorteile nur mit dem Segen der Entwickler

Sämtliche in diesem Abschnitt genannten Features müssen mit vom Spieleentwickler integriert werden. Zudem können die Features unterschiedlich intensiv genutzt werden. So kann der Entwickler bei VRS frei entscheiden, in welchen Frames welche Bereiche wie optimiert werden können – und beim nächsten Frame wieder alles ändern.

Auf dem Papier ein großer Schritt – und in der Praxis?

Nvidia hat mit Turing die eigene GPU-Architektur im Vergleich zu Pascal und damit auch Maxwell völlig umgekrempelt. Natürlich wird längst nicht alles umgeworfen, denn bereits gut funktionierendes muss und sollte nicht neu erfunden werden. Dennoch steht fest, dass Turing die mit Abstand größten Änderungen an der Technik seit Jahren aufweist. Selbst bei Kepler, dem Nachfolger von Fermi, hat es nicht derart weitreichende Veränderungen gegeben.

Davon ohne Ablenkung durch Benchmark zu berichten, dürfte Nvidias Motivation hinter der Entscheidung gewesen sein, die Details zur Technik vor ersten Tests – ohne Spiele mit Unterstützung der neuen Funktionen – der GeForce-RTX-Grafikkarten zur Veröffentlichung freizugeben.

Und in der Praxis?

Denn ob sich die vielen Neuerungen auch für den Endkunden und damit den Spieler auszahlen werden und wenn ja in welchem Umfang oder wann, ist auf Basis der heute veröffentlichten Informationen noch komplett offen. Weil Nvidia nicht nur an der Anzahl der Ausführungseinheiten, dem Takt und dem Speicher, sondern auch der Detailkonfiguration gedreht hat, sind auch in klassischen Spielen ohne neue Features Änderungen zu erwarten, die vom Wechsel von Maxwell auf Pascal nicht bekannt waren. Dem einen Titel könnten die Neuerungen mehr, dem anderen weniger gefallen. Nvidias Aussage zu 50 Prozent mehr Leistung im Vergleich RTX 2080 und GTX 1080 steht auch heute noch ungeprüft im Raum.

Doch auch wenn erste Tests diese Frage klären können werden, werden sie das gesamte Potenzial von Turing noch nicht erschließen können, denn Raytracing und KI in Spielen steht noch in – oder eher gesagt vor – den Startlöchern. Was die neuen Techniken wirklich bringen, wird sich so richtig erst in ein paar Jahren wirklich klären lassen. Nvidia ist hier Pionier – Ausgang noch offen.

Die Kommentare der ComputerBase-Leser der letzten Wochen, nicht nur als Reaktion auf erste Leistungseindrücke zu RTX in Battlefield V, sprechen dann auch eine deutliche Sprache: Die neuen Funktionen klingen interessant, in erster Linie interessiert Spieler aber die Leistung der neuen Generation in aktuellen Spielen. Einen nicht unerheblichen Einfluss auf diese Perspektive haben auch die Preise, die gegenüber Pascal deutlich steigen.

Erst Tests werden erste Antworten liefern

Wie gut sich Turing in aktuellen Titeln gegenüber Pascal schlägt und ob bzw. welche Vorteile Spieler schon kurzfristig aus den neuen Funktionen respektive Kernen ziehen können, das wird ComputerBase in Kürze in einem ausführlichen Test klären. Drei Grafikkarten mit Turing befinden sich mittlerweile in der Redaktion.

Die nachfolgende Tabelle fasst die größten Neuerungen der Architektur noch einmal zusammen, nennt den potentiellen Nutzen und ob Entwickler explizit dafür entwickeln müssen. Erst ein Test und die Zeit werden allerdings klären, welche der von Nvidia heute präsentierten großen Entwicklungsschritte sich für Käufer der neuen Generation in welchem Ausmaß auch materialisieren werden.

| Spekulative Auswirkung | Optimierung/Anpassung der Software notwendig? |

|

|---|---|---|

| Neuer SM-Aufbau | bessere Auslastung/Performance Anpassung an heutige und zukünftige Software |

nein |

| INT32-ALUs | bessere Performance | nein |

| Tensor-Cores | neuartige Berechnungsmethode mit deutlich mehr Leistung KI-Algorithmen ausführen |

ja |

| Raytracing | realistische Grafikeffekte die vorher unmöglich/kaum möglich waren |

ja |

| Neue Cache-Struktur | bessere Performance | nein |

| GDDR6-Speicher | höhere Speicherbandbreite bessere Energieeffizienz |

nein |

| Effektivere Speicherkompression | weniger tatsächliche Speicherbandbreite benötigt mehr effektive Bandbreite vorhanden |

nein |

| VirtualLink-Anschluss | Zukünftige VR-Headsets mit einem Kabel | nein |

| Verbesserte Video-Beschleunigung | Beschleunigung von 8K-Videos Bessere Bildqualität beim Streaming/Transcodieren |

ja (einmalig) |

| SLI über NVLink | mehr Bandbreite für hohe Auflösung und Frameraten stabilere Frametimes |

nein |

| Diverse neue Shadertechniken | mehr Leistung bei keinem/geringen Qualitätsverlust | ja |

| DLSS-Kantenglättung | hochwertige Kantenglättung (fast) ohne Nachteile kein/kaum Leistungsverlust durch Tensor-Cores |

ja |

ComputerBase hat die Informationen für diesen Artikel sowohl auf einer Veranstaltung zur Gamescom als auch in der vergangenen Woche von Nvidia erhalten. Die einzige Vorgabe war der Veröffentlichungszeitpunkt. Eine Einflussnahme auf die Berichterstattung gab es nicht.

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.

Im Podcast erinnern sich Frank, Steffen und Jan daran, wie im Jahr 1999 alles begann.