Intel Sapphire Rapids: Elite-Einheiten als Workload-Spezialisten

Was lange währt, wird endlich gut? Die ewig verspätete Server-CPU-Familie Intel Sapphire Rapids alias Xeon Scalable in 4. Generation bringt dafür viele Neuheiten mit. Bestückt mit spezialisierten Einheiten (Accelerator), werden gewisse Einsatzgebiete massiv beschleunigt. Das macht es aber auch komplizierter.

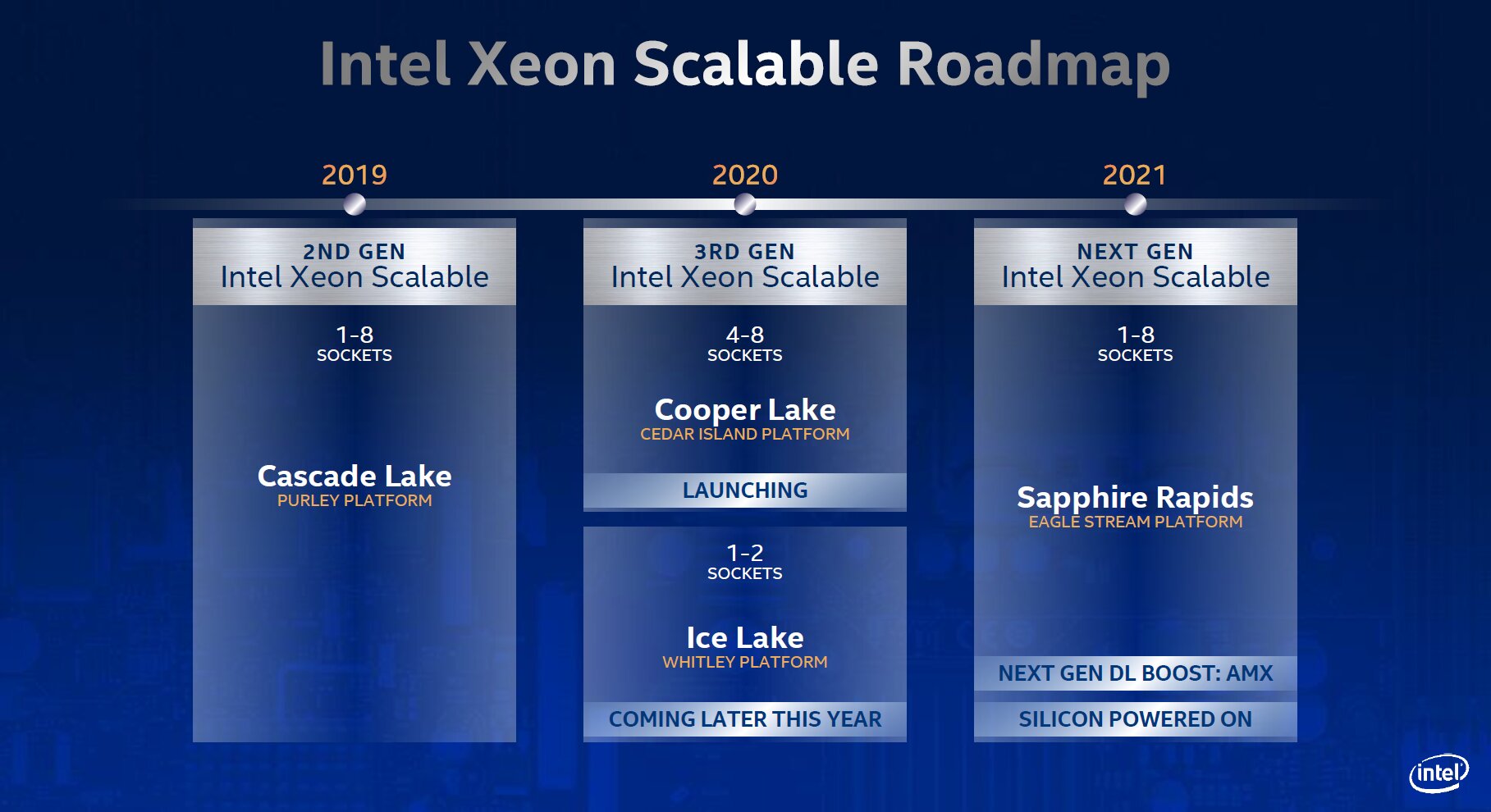

Mit reichlich Verspätung

Erstmals für 2021 als Nachfolger von Ice Lake angekündigt, verpasste Intels 4. Generation der „Xeon Scalable Processors“ namens Sapphire Rapids auch die verschiedenen Termine im Jahr 2022. Zunächst galten Probleme beim 10-nm-Prozess alias Intel 7 als Ursache für die Verspätungen. Später wurden auch Probleme bei der Validierung der CPU und der dazugehörigen Plattform genannt.

Letztlich wurde inoffiziell eine schlechte Ausbeute beim Herstellungsprozess verantwortlich gemacht und im November 2022 folgte die Gewissheit, dass Sapphire Rapids erst im Januar 2023 erscheinen würde.

Architektur und Neuerungen

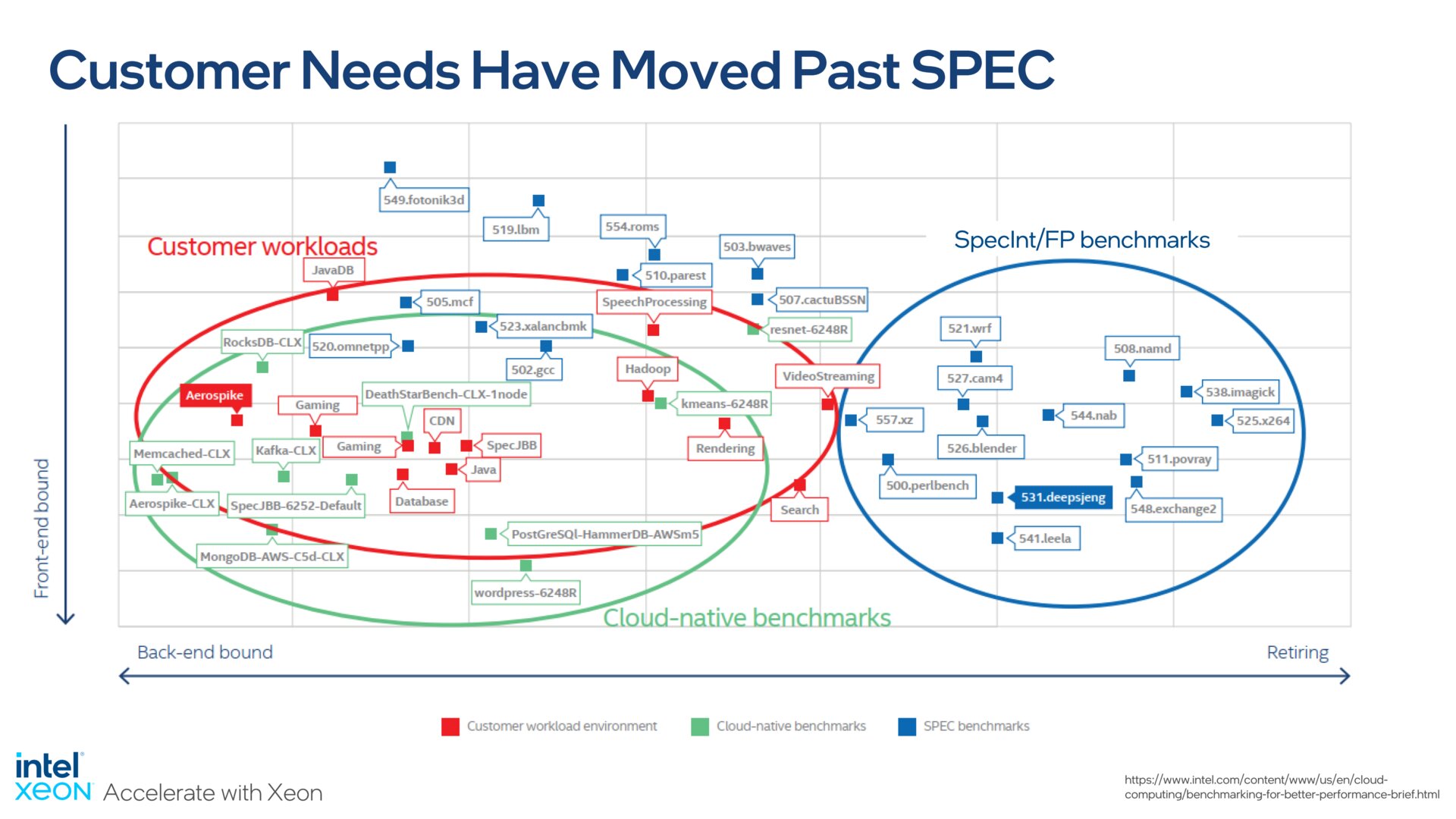

Workload statt SPEC-Benchmarks

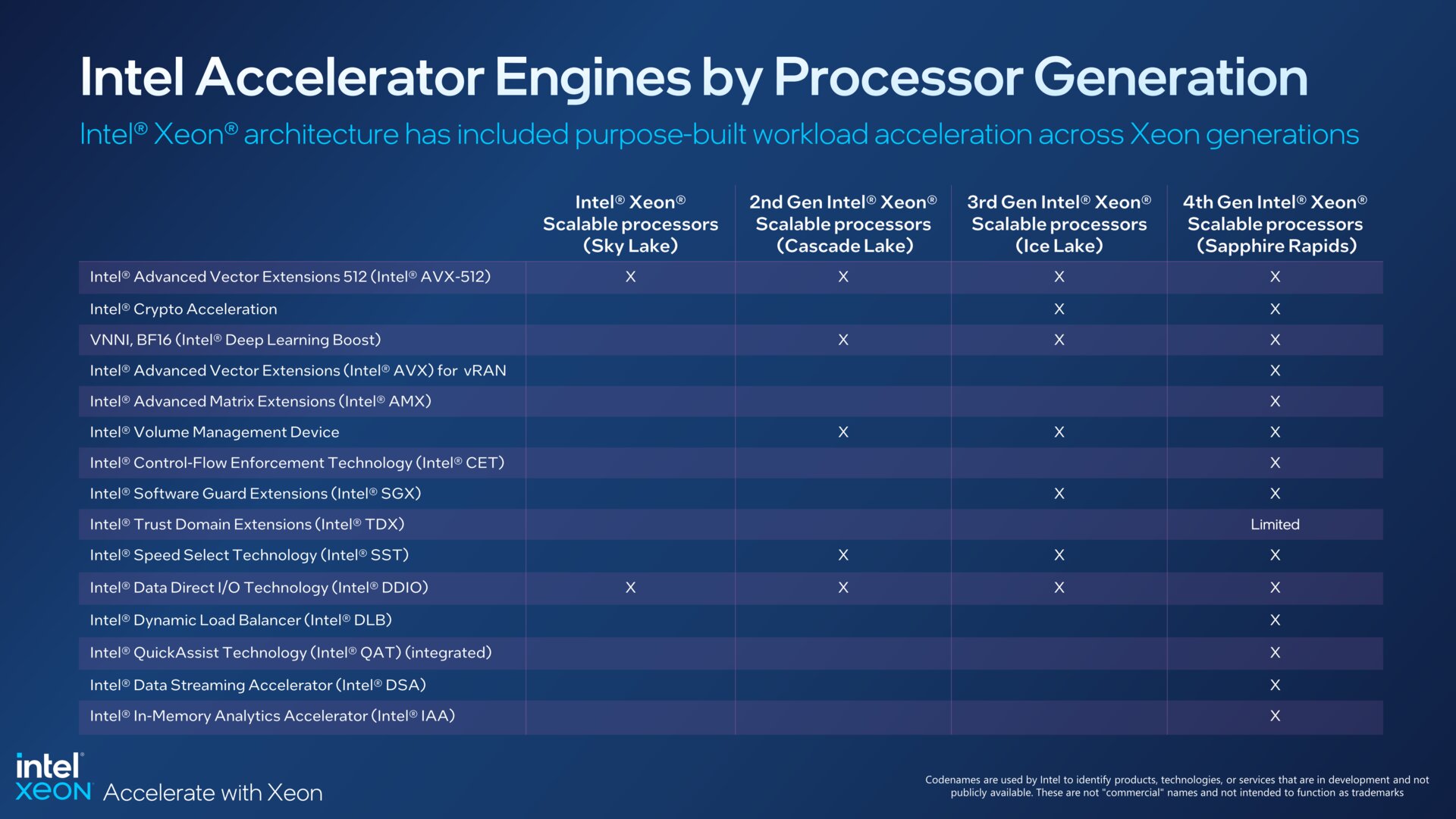

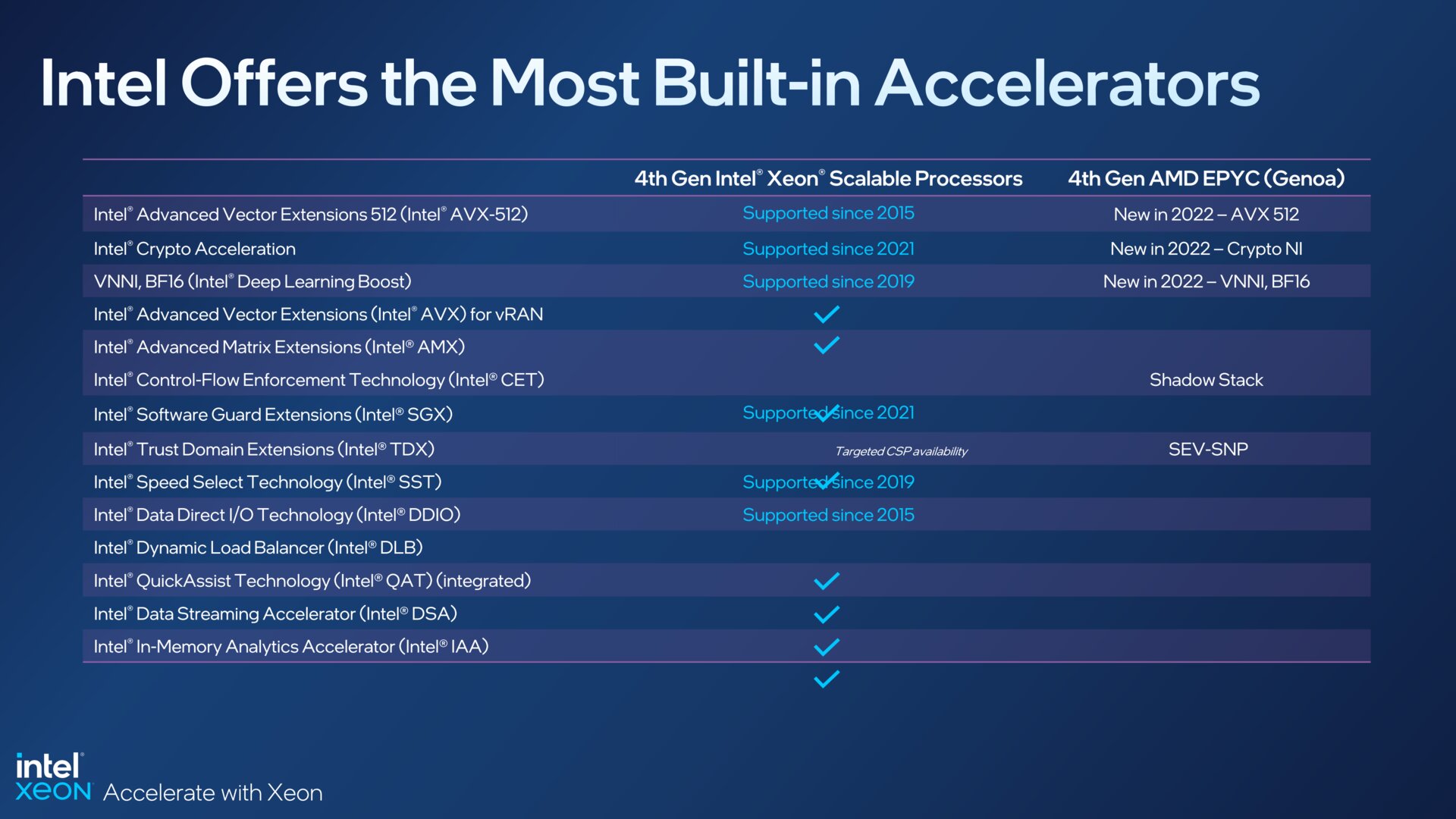

„Workload First“ lautet Intels Devise bei der neuen Xeon-Generation. Zusätzliche spezialisierte Einheiten sollen in ihrem jeweiligen Einsatzbereich für große Leistungssprünge sorgen. Intel spricht auch von integrierten Beschleunigern (Accelerators), von denen Sapphire Rapids mehr als jede andere CPU zuvor biete.

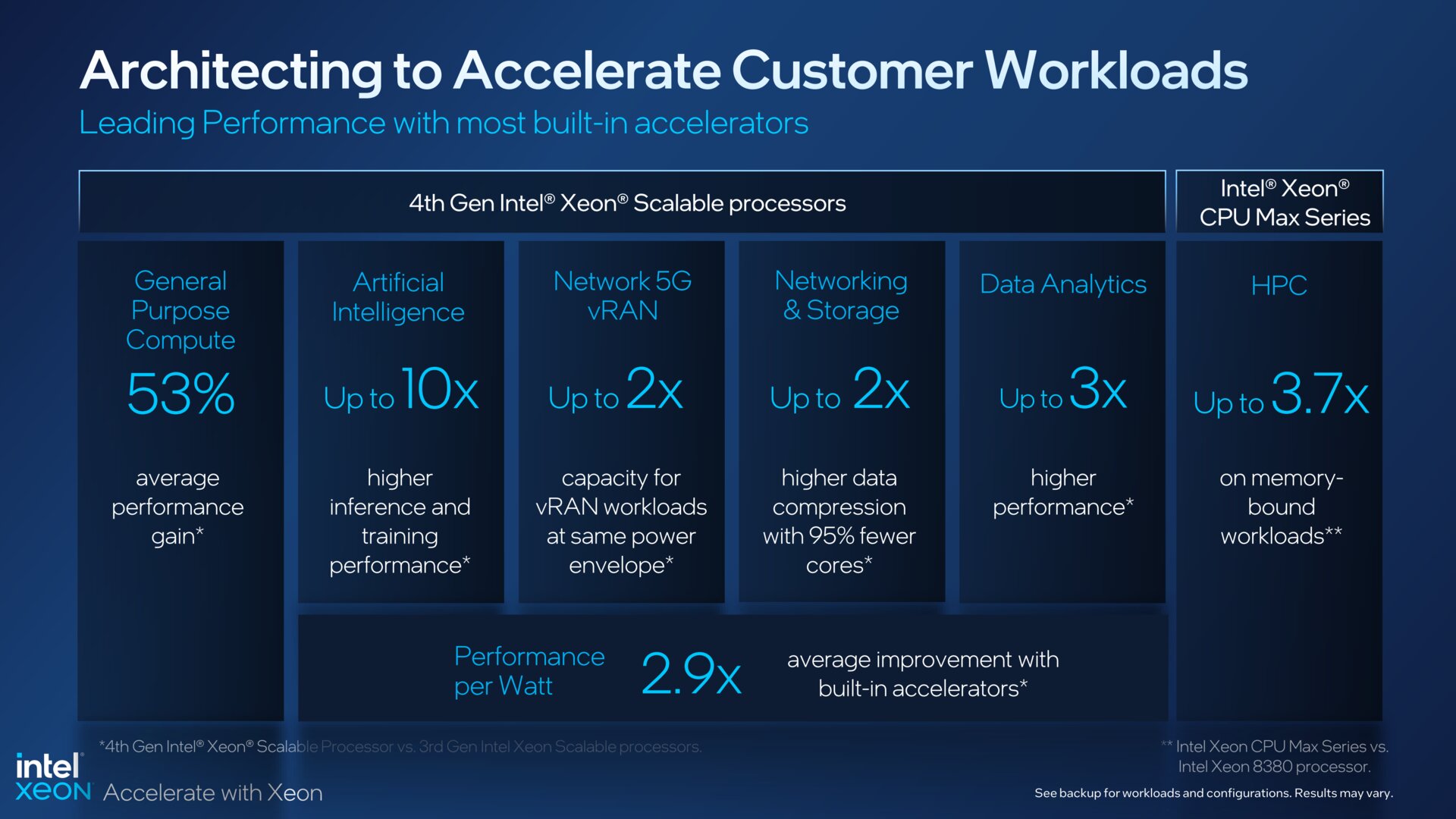

Im jeweiligen Spezialgebiet soll damit auch die Effizienz steigen. Intel nennt eine um bis zu 2,9-fache Leistung pro Watt und einen absolut niedrigeren Stromverbrauch pro CPU. Im Idealfall sollen sich so auch die Gesamtkosten (TCO) für den Betrieb eines Servers deutlich verringern.

In den Standard-Benchmarks der Branche, wie etwa den Tests der „Standard Performance Evaluation Corporation“ (SPEC), hat Intel schon lange das Nachsehen, denn AMD Epyc kann mit deutlich mehr Kernen auch deutlich mehr leisten.

Intel argumentiert nun, dass die wirklich benötigte Leistung ganz andere Testkriterien als jene in den SPEC-Benchmarks erfordert. In Bezug auf die echte Arbeitslast (Workload) sieht sich der Konzern nun besser aufgestellt. Unabhängige Tests werden zeigen, wo Intel wirklich steht.

Das ganze Thema auf „Real World Performance“ zu lenken, erinnert jedoch an das, was Intel vor einigen Jahren auch im Desktop und Notebook versucht hatte, als man dort in Rückstand geraten war. Schwarzweiß war das Thema auch dort bekanntlich nicht und dürfte entsprechend im Serverumfeld ebenfalls wie immer ganz genau auf das gewählte Szenario ankommen.

Intels Leistungsversprechen

Gegenüber der 3. Generation sollen die neuen Xeon bei allgemeinen Rechenaufgaben („general purpose“) im Durchschnitt um etwa 53 Prozent bei der Leistung zulegen. Mit den zusätzlichen Beschleunigern gibt es punktuell größere Sprünge, aber eben nur für das jeweilige Spezialgebiet. Der Bereich künstliche Intelligenz soll so etwa um den Faktor 10 beschleunigt werden, Datenanalysen sollen bis zu 3-mal schneller laufen und bestimmte Netzwerk- sowie Storage-Aufgaben mit verdoppelter Leistung erledigt werden. Dank schnellem HBM-Speicher sollen die Xeon Max in speicherlimitierten HPC-Anwendungen das 3,7-Fache des Xeon 8380 leisten.

Wie so oft gilt es, die öffentlichen Intel-Dokumente und deren Fußnoten genau zu überprüfen, um zu sehen, ob das eigene Einsatzgebiet darunter fällt.

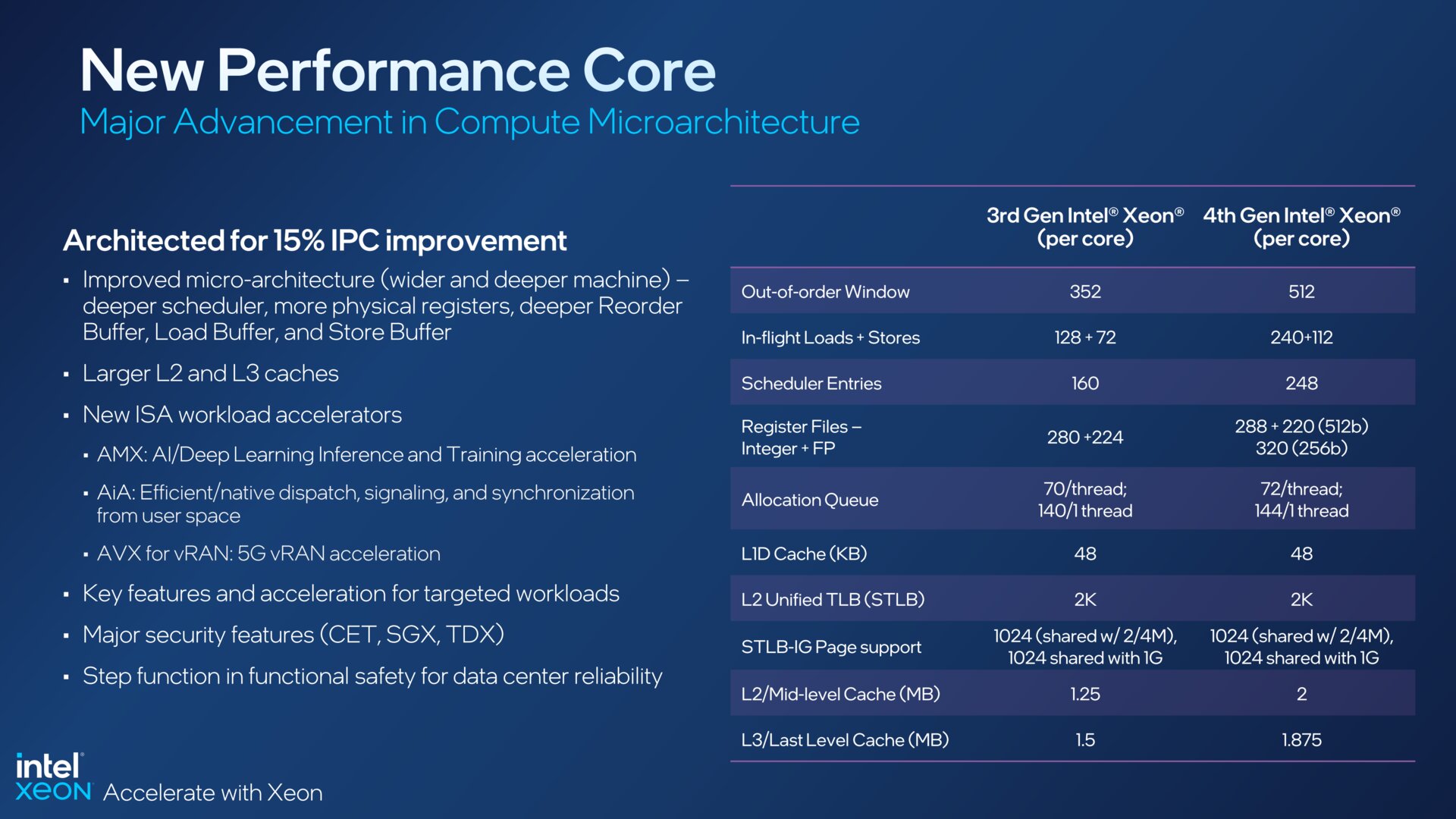

Neue Kerne und DDR5

Während die oben genannten Beschleuniger die größte Neuerung darstellen, gibt es in der Basis, den eigentlichen Kernen, keine großen Überraschungen. Hier wechselt Intel von der Sunny-Cove-Architektur bei Ice Lake nun auf Golden Cove, wie sie im Client-Segment schon bei Alder Lake alias Core i-12000 (und einige 13000er) zu finden ist. Bei Sapphire Rapids bieten sie aber mit 2 MB pro Kern nochmals mehr L2-Cache.

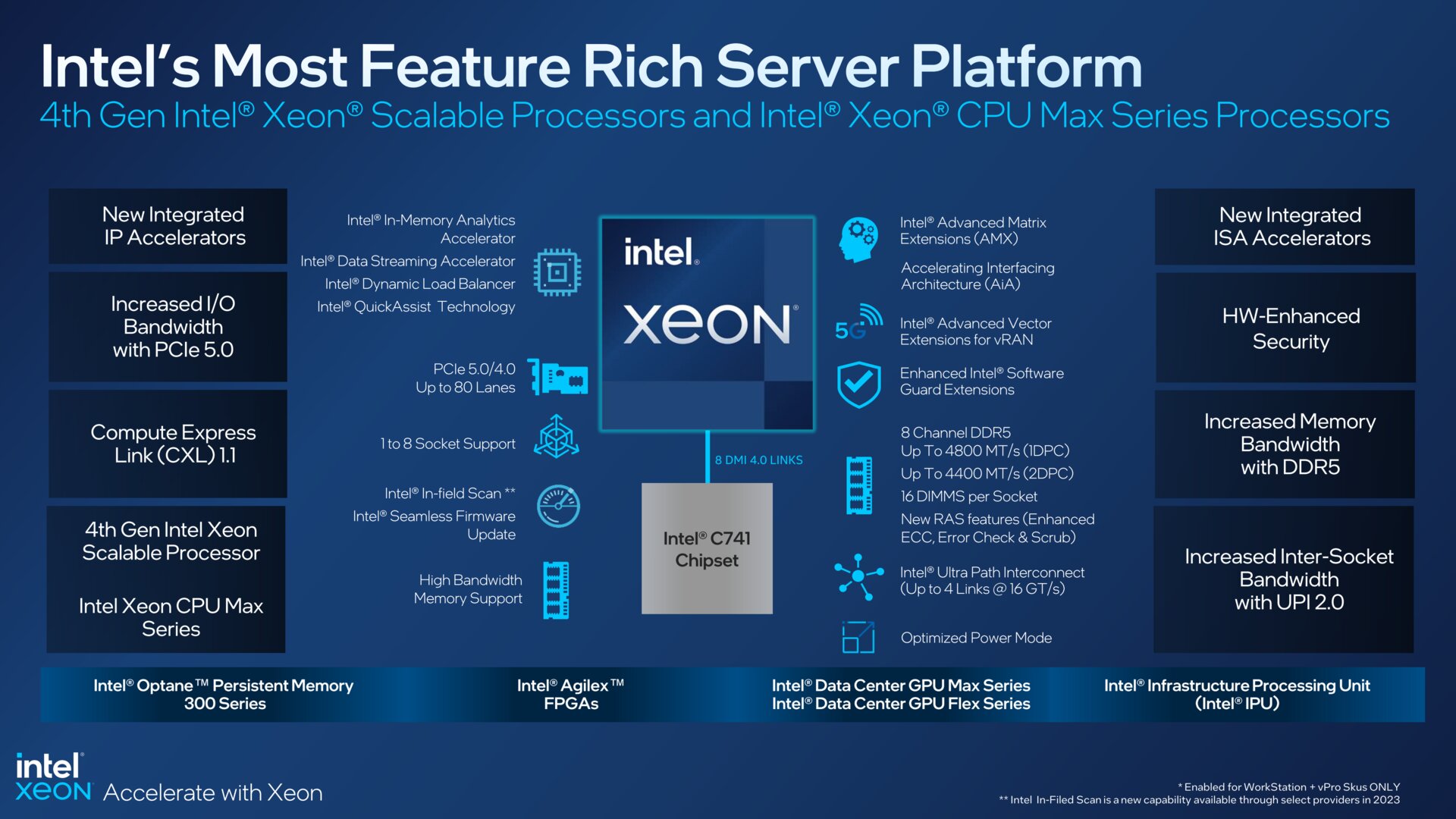

Die jüngere Architektur sorgt in Kombination mit größeren Zwischenspeichern (Caches) für eine Leistungssteigerung bei den Befehlen pro Taktzyklus (IPC) von rund 15 Prozent, so Intel. Hinzu kommt der Wechsel von DDR4- auf schnelleren DDR5-Arbeitsspeicher. Auch PCIe 5.0 wird unterstützt, mehr dazu beim detaillierten Blick auf die Plattform weiter unten.

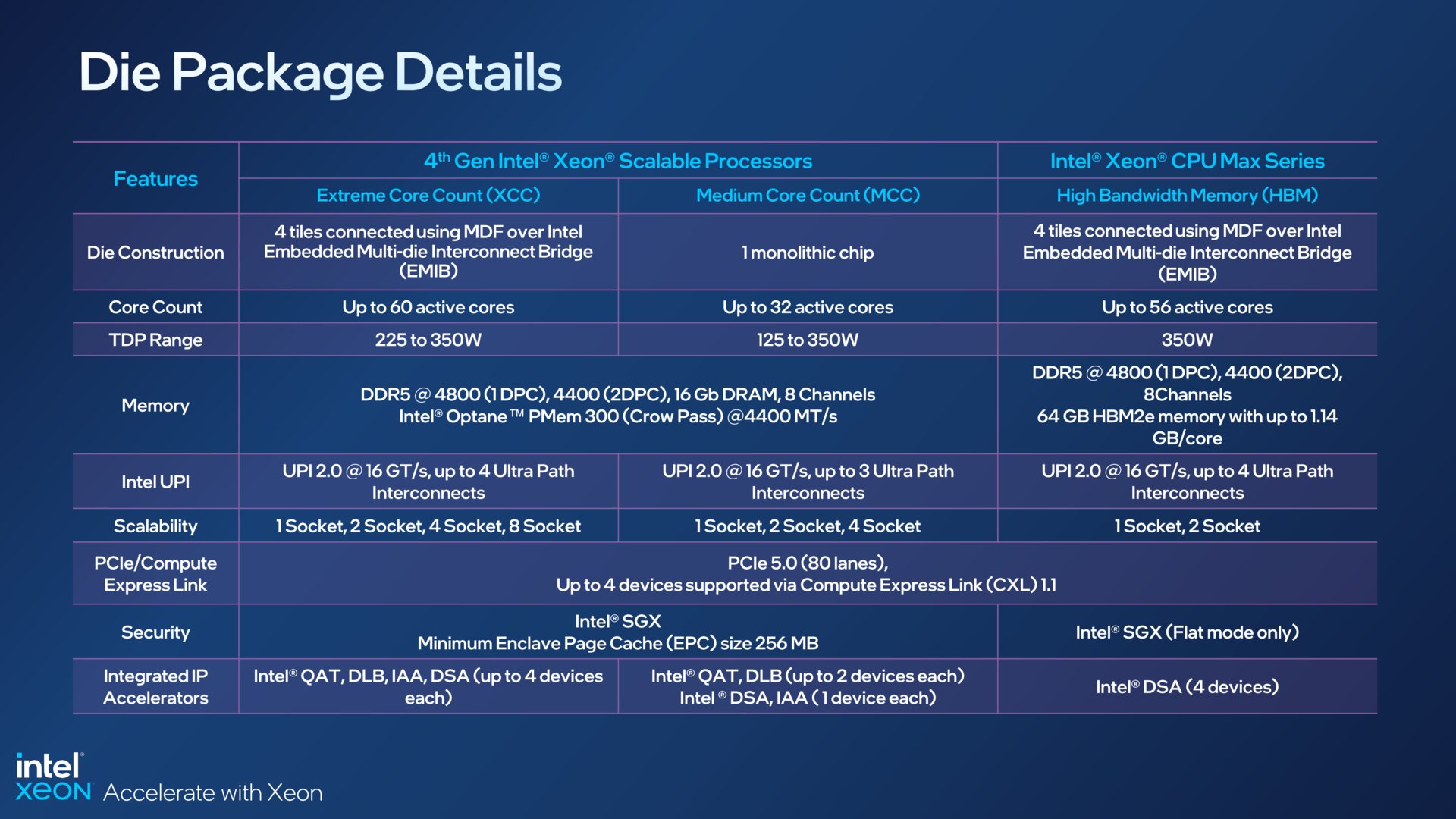

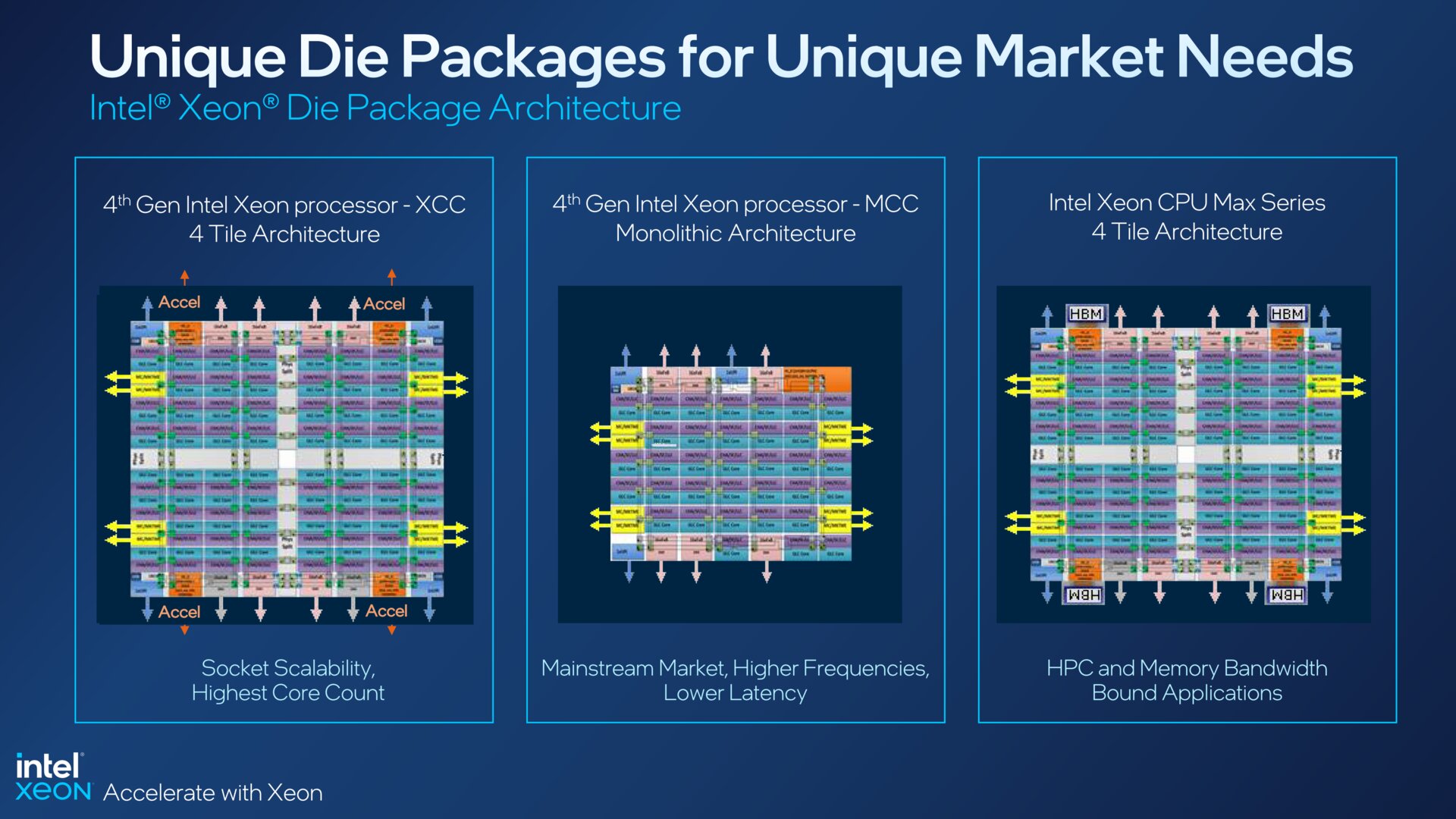

Drei verschiedene Chip-Designs

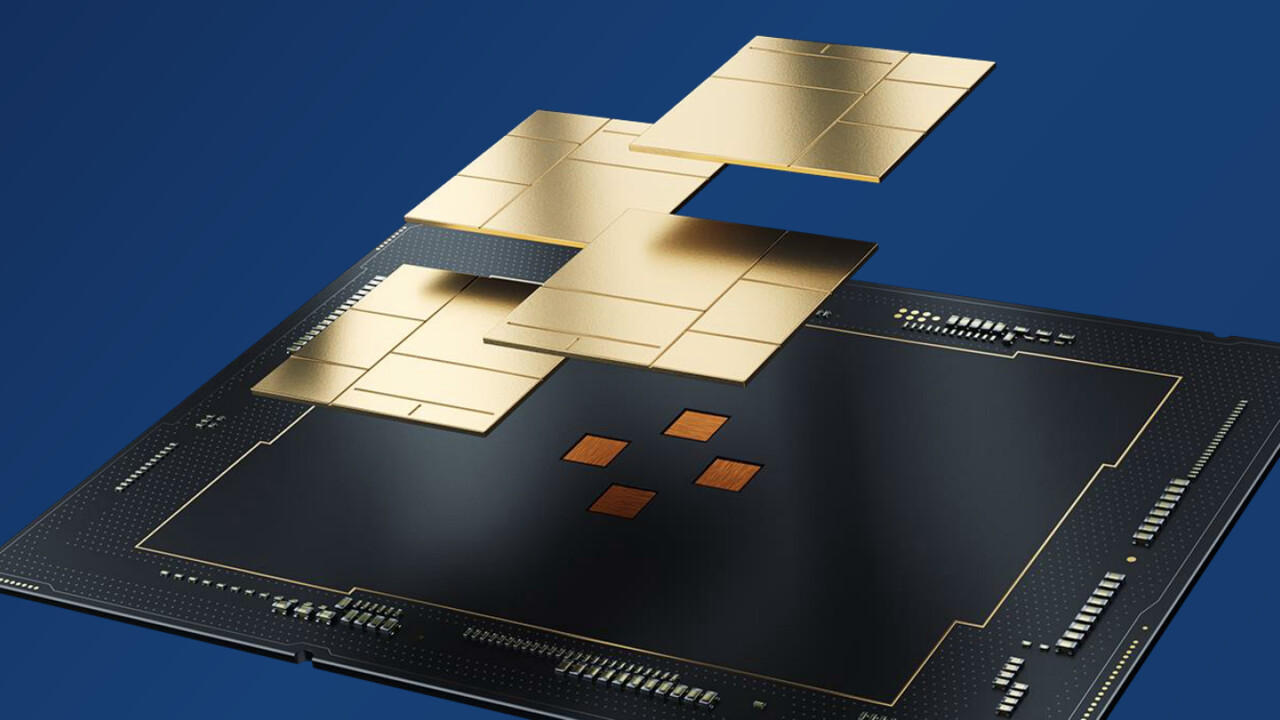

Die zahlreichen Xeon-Modelle fußen auf drei unterschiedlichen Die-Konfigurationen. Die Mainstream-Modelle werden von einem monolithischen Chip mit bis zu 32 Kernen befeuert und sind für Systeme mit bis zu vier Sockeln (4S) vorgesehen. Intel nennt diese Klasse auch „Medium Core Count“ (MCC).

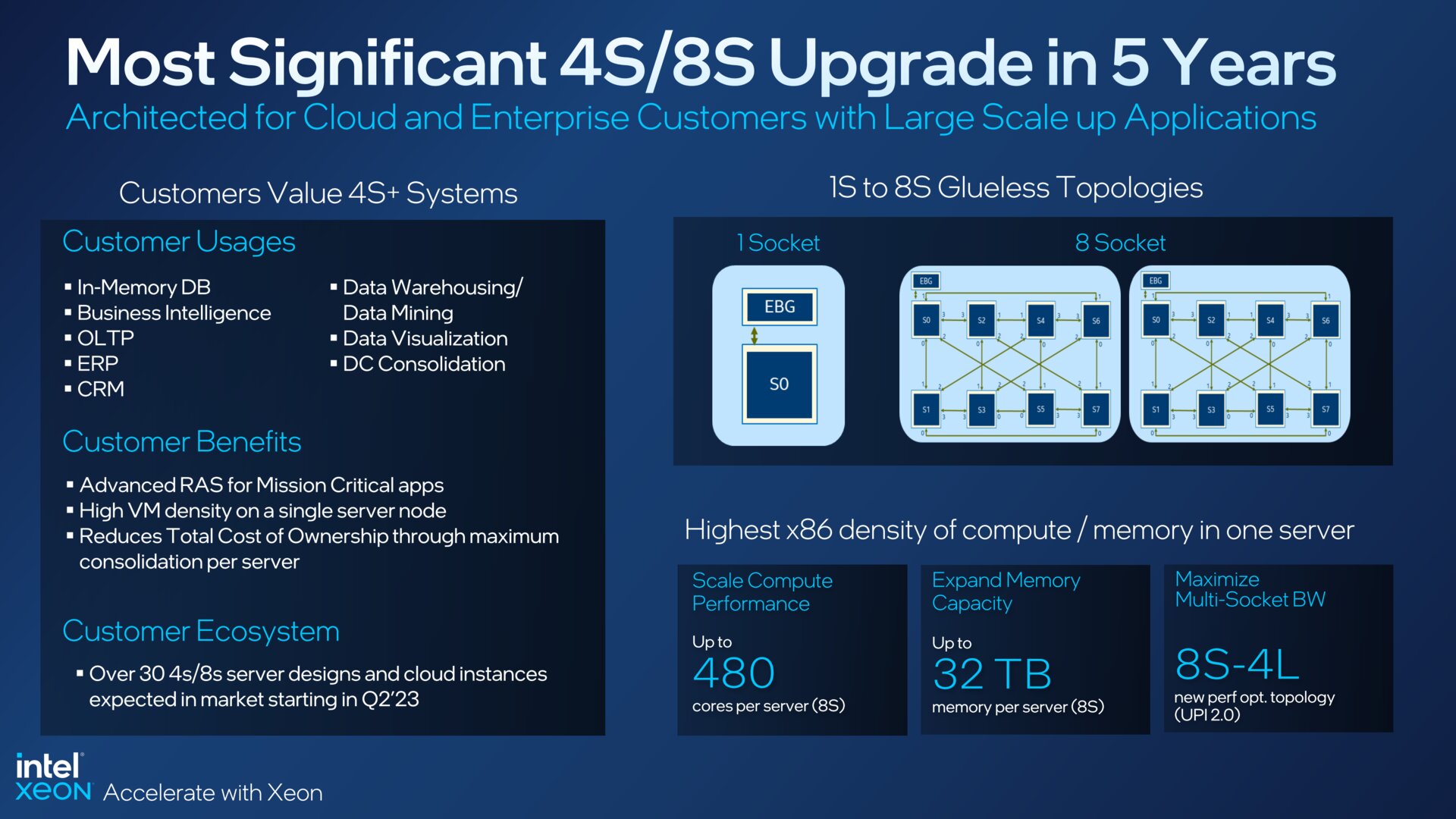

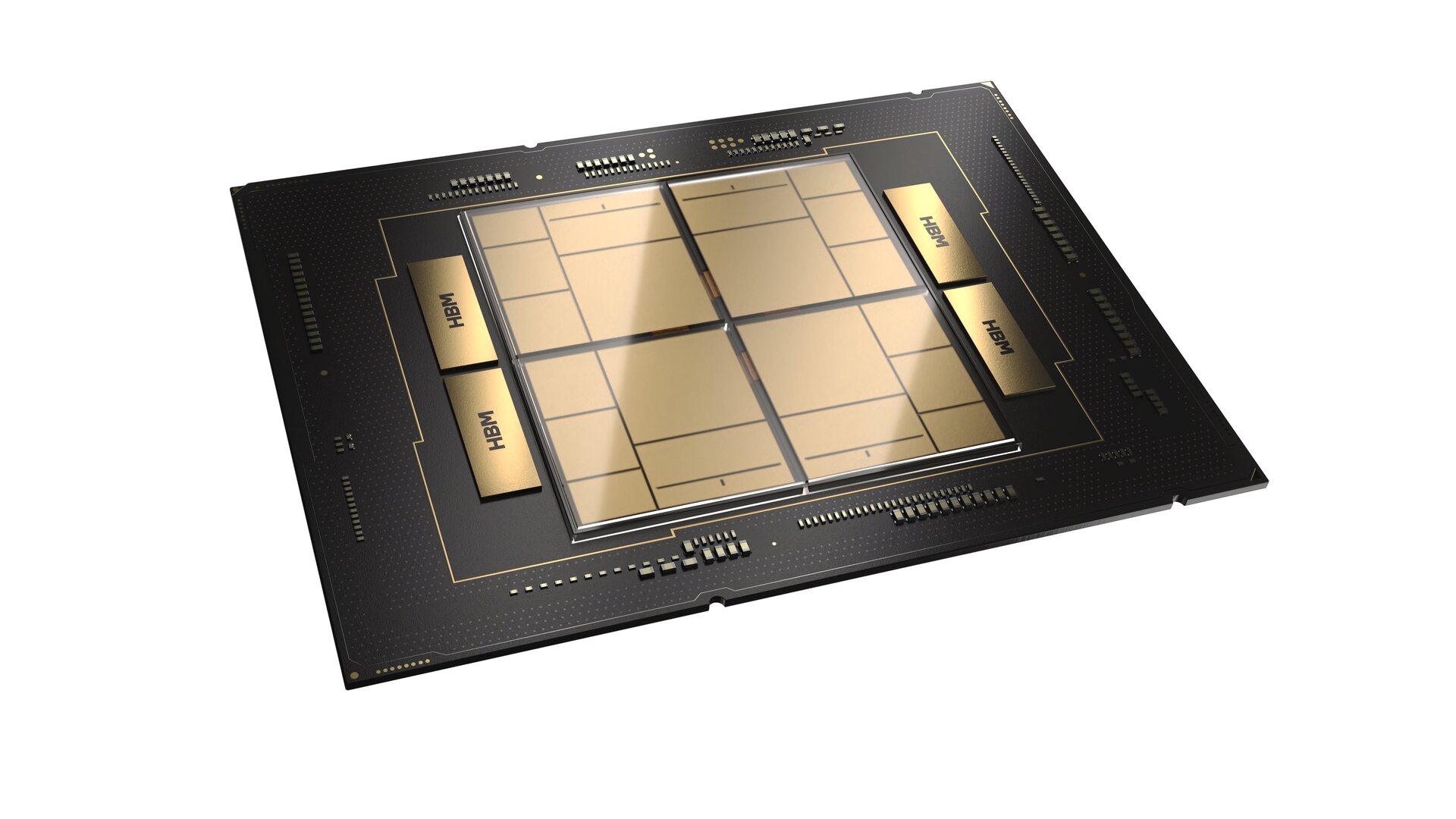

Bei „Extreme Core Count“ (XCC) geht es nun auf bis zu 60 Kerne hoch. Dabei greift Intel auf einen Multi-Chip-Ansatz zurück: Vier sogenannte Tiles werden zu einem Paket zusammengefügt. Jeder Tile verfügt über einen Speichercontroller, I/O und Beschleuniger. So bietet diese Ausführung in der Spitze auch mehr Beschleuniger. Zudem werden bis zu acht Sockel unterstützt. Acht DDR5-Speicherkanäle sind wiederum auch beim Mono-Chip vorhanden.

Die dritte Variante betrifft die Serie Xeon Max, die den Tile-Ansatz mit High Bandwidth Memory (HBM) kombiniert. Hier gibt es maximal 56 CPU-Kerne und 64 GB HBM2e für einen hohen Speicherdurchsatz. Bei den Spezialeinheiten respektive Beschleunigern gibt es allerdings nur eine Sorte (DSA).

Die Spezialeinheiten (Beschleuniger)

Was alle Ausführungen von Sapphire Rapids bieten, sind die sogenannten „Data Streaming Accelerator“ (DSA), die somit fester Bestandteil des Designs sind. Damit soll der Datenstrom, also die Übertragung und Umwandlung von Daten, für Bereiche wie Netzwerk und Storage beschleunigt werden. Mindestens einer dieser DSA ist stets vorhanden. Manche Modelle bieten aber auch zwei, drei oder sogar vier DSA.

Ebenso stets gesetzt sind die Befehlsbeschleuniger („ISA Accelerator“). Damit sind die „Advanced Matrix Extensions“ (AMX) für schnelleres Deep Learning im AI-Sektor, die bekannten „Advanced Vector Extensions“ (AVX-512) und AVX für vRAN zur Verdoppelung der Dichte der virtuellen Funkzugangsnetzwerke gemeint.

Optionale Beschleuniger

Manche der Accelerator sind wiederum nicht bei allen Xeon-Varianten ab Werk aktiviert, können aber teils nachträglich per On-Demand-Upgrade (siehe unten) freigeschaltet werden.

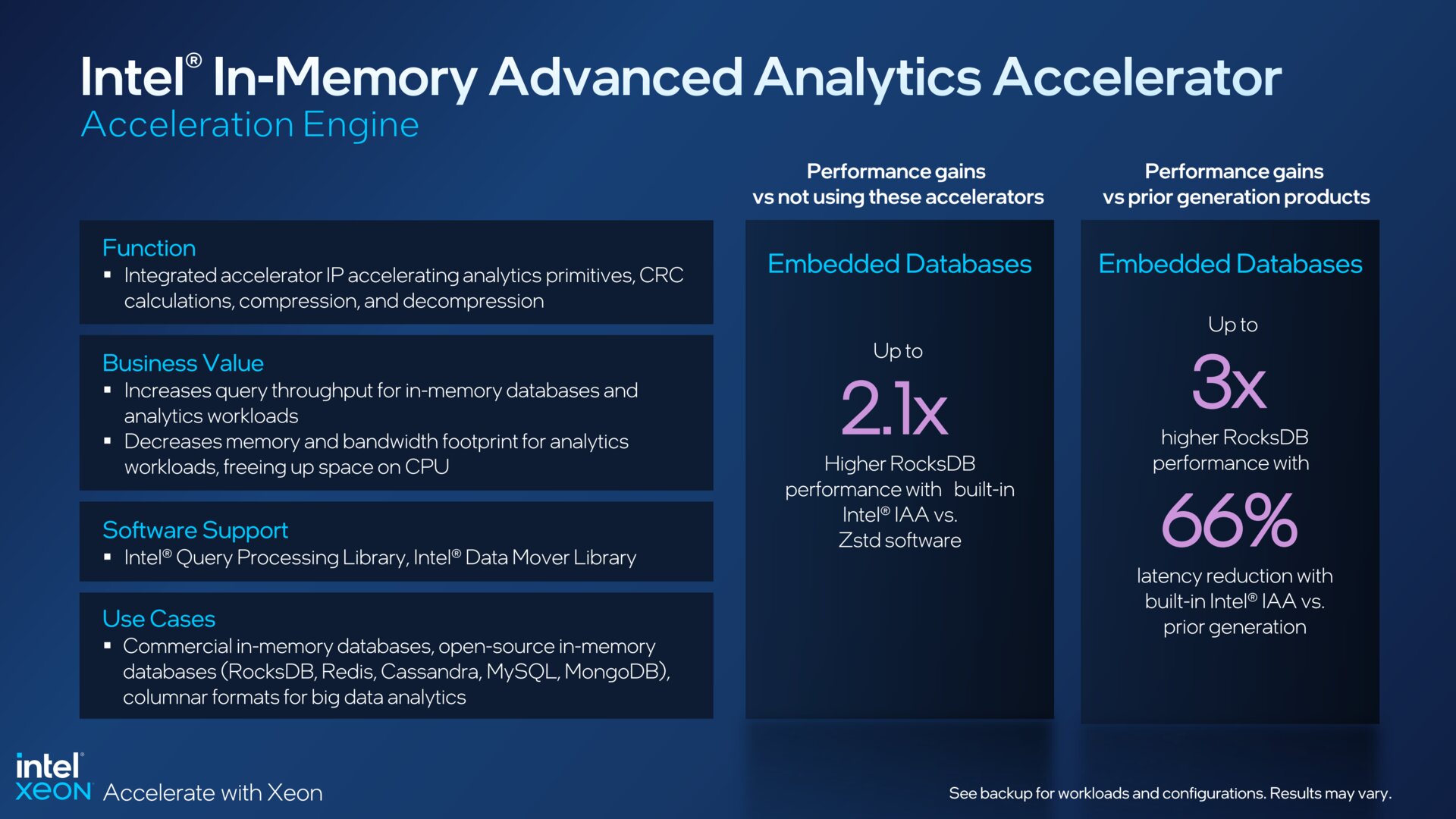

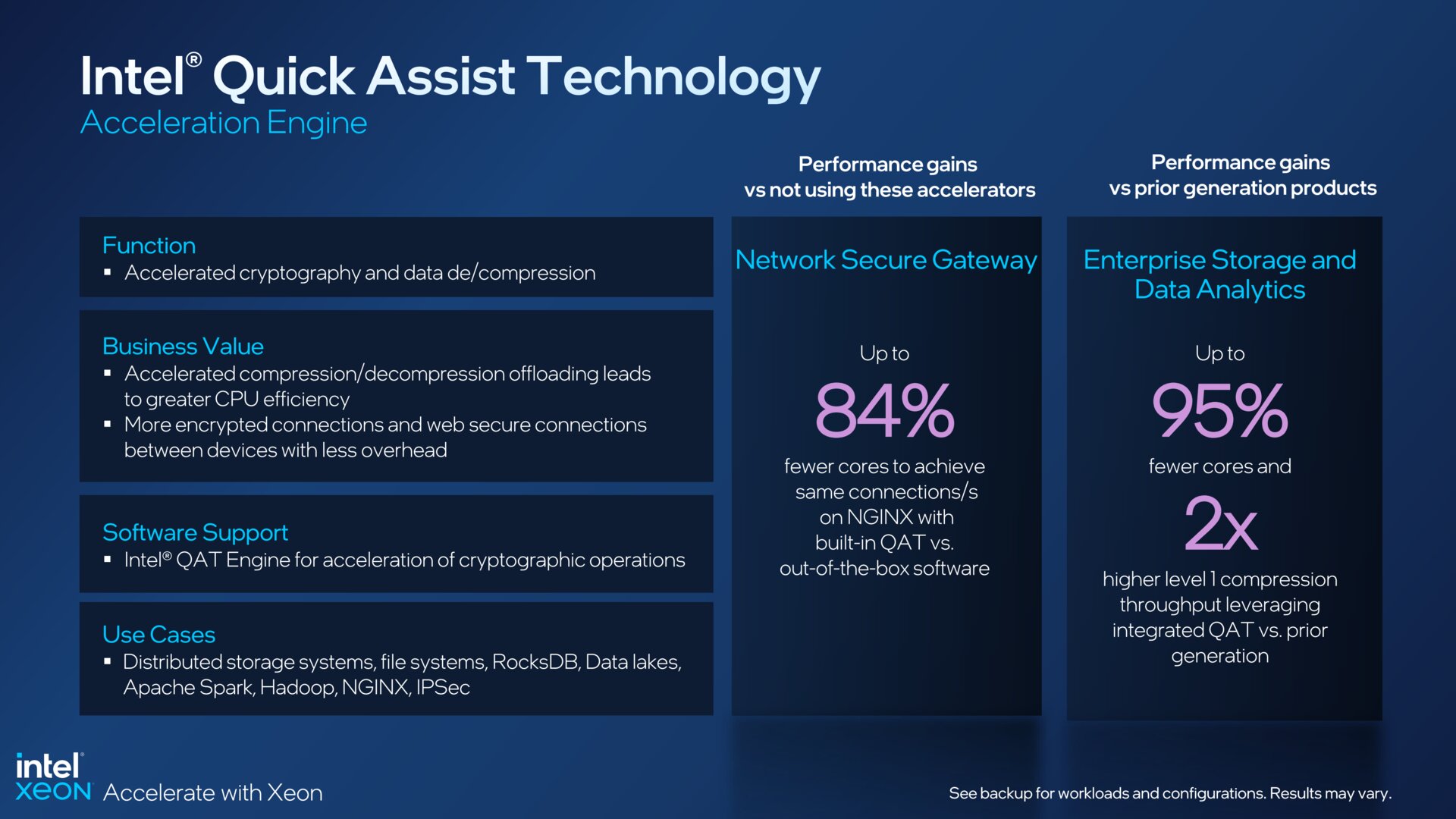

Die „Dynamic Load Balancer“ (DLB) sorgen für eine dynamische Verteilung der Netzwerkdaten auf mehrere CPU-Kerne, was je nach Workload sehr variiert. Der „In-Memory Analytics Accelerator“ (IAA) soll zum Beispiel den Durchsatz bei Datenbankabfragen beschleunigen. Für schnellere Verschlüsselung und Komprimierung von Daten wird wiederum die „QuickAssist Technology“ (QAT) genutzt.

Mehr Accelerator als AMD

Intel rühmt sich nun mit der CPU mit den meisten dieser spezialisierten Beschleuniger-Einheiten. Das gilt nicht nur für den Vergleich mit dem bisherigen Portfolio, sondern auch als Argument gegen den Kontrahenten AMD.

Die neue Plattform

Neuer Sockel

Sapphire Rapids wechselt gegenüber Ice Lake-SP im LGA 4189 den Sockel und nimmt im neuen LGA 4677 mit mehr Kontakten Platz. Die maximale TDP steigt von 270 auf 350 Watt an. Die „5“ steht nicht nur im Fokus der neuen AMD-Plattformen, denn auch Intel setzt nun erstmals auf DDR5-RAM und PCI Express 5.0 im Server.

DDR5 und PCIe 5.0

Bis zu 16 DDR5-Module können mit 4.400 MT/s (2 DIMMs pro Channel) oder bis zu 8 Module mit 4.800 MT/s (1 DIMM pro Channel) betrieben werden. Die maximal 1,5-fache Erhöhung des Speicherdurchsatzes ergibt sich schlicht durch den Vergleich mit DDR4-3200 beim Vorgänger.

Effektiv verdoppelt wird die Datenübertragungsrate bei Anbindung von Erweiterungskarten durch den Wechsel von PCIe 4.0 auf PCIe 5.0. Gerundet können bei einer PCIe-x16-Verbindung nun bis zu 64 GB/s in jede Richtung übertragen werden. Eine CPU liefert gleich 80 PCIe-5.0-Lanes, die abwärtskompatibel auch mit PCIe 4.0 funktionieren.

CXL 1.1 und UPI 2.0

Für den HPC-Sektor (Supercomputer) relevant ist der Compute Express Link (CXL), der in Version CXL 1.1 auf PCIe 5.0 basiert. Bis zu vier CXL-Geräte können pro CPU angebunden werden, darunter etwa CXL-Speichererweiterungen.

Zur Verbindung der CPUs untereinander in Systemen mit mehreren Sockeln dienen hingegen die sogenannten „Ultra Path Interconnects“ (UPI), die in Version 2.0 mit 16 GT/s arbeiten. Die Mainstream-Xeon besitzen deren drei, während Xeon XCC und Xeon Max deren vier aufweisen.

Max steht für HBM auf CPU und GPU

Die Xeon Max sind eigens für das „High Performance Computing“ (HPC), also etwa Supercomputer, konzipiert. Als Xeon-Max-CPU gibt es fünf Modelle von Sapphire Rapids mit 32 bis 56 Kernen, die jeweils auf 64 GB HBM2e-Speicher zurückgreifen können, womit Anwendungen mit hohem Bedarf an Speicherbandbreite deutlich beschleunigt werden können.

Diese lassen sich für nochmals mehr Leistung in diesem Segment mit der Data Center GPU Max Series kombinieren, die Intel bereits letztes Jahr vorgestellt hat.

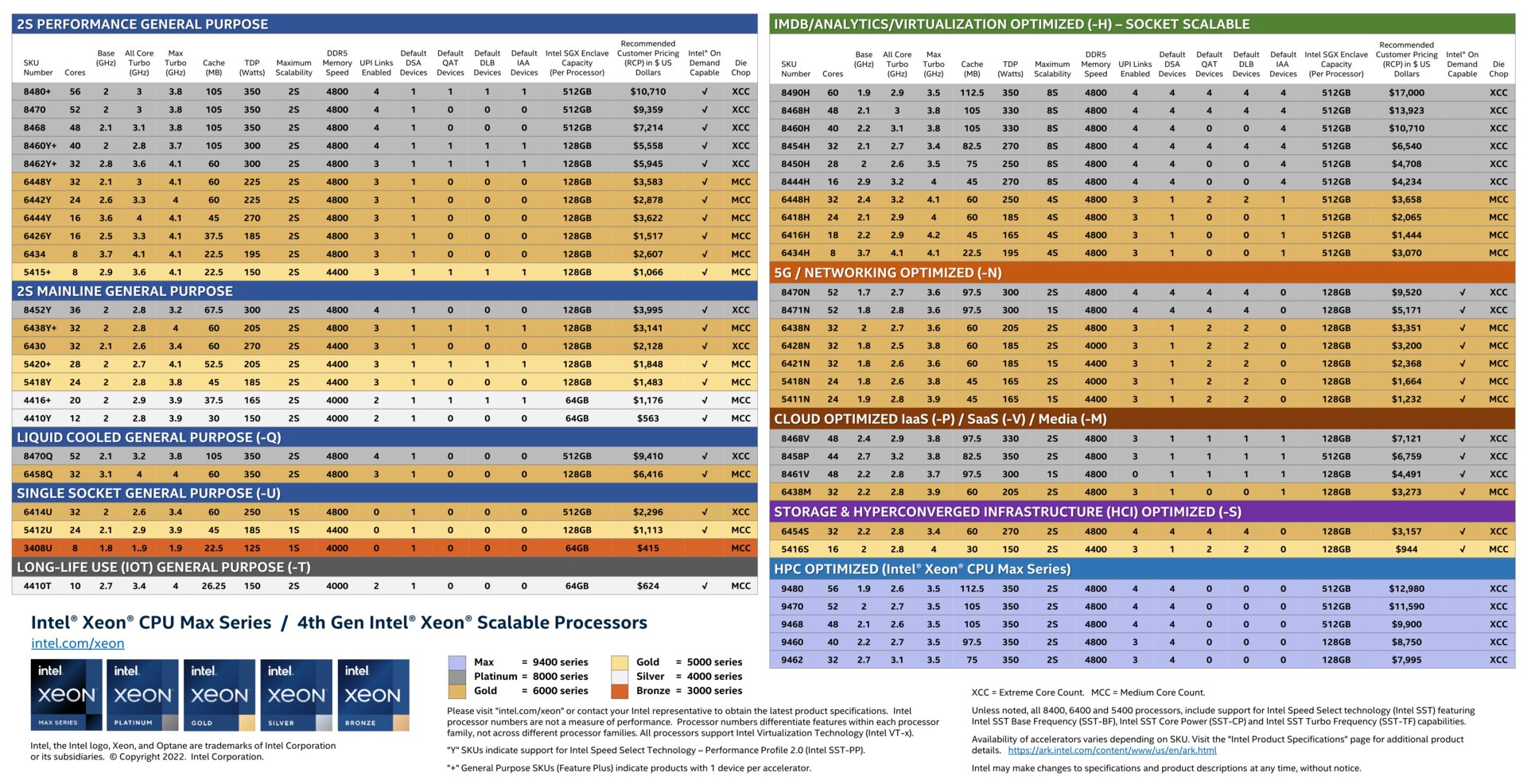

Ein wahrer Dschungel an SKUs

Wer bei den vielen Varianten der Intel Xeon schon zuvor den Wald vor lauter Bäumen nicht mehr sah, findet sich spätestens jetzt im Dschungel wieder. Denn es gilt nun nicht mehr nur nach Kernen, Cache, Takt und TDP zu schauen, sondern auch, welches Modell jetzt welche Accelerator bietet und wie viele es jeweils sind.

Die bunte Palette reicht vom Xeon Bronze 3408U mit 8 Kernen für 415 US-Dollar bis hin zum Xeon Platinum 8490H mit 60 Kernen und dem Maximalausbau an Beschleunigern für satte 17.000 US-Dollar.

| Modell | Kerne | L3-Cache | Basistakt | Turbotakt 1C/nC | TDP | Preis |

|---|---|---|---|---|---|---|

| Xeon Platinum 8380 | 40 | 60 MB | 2,3 GHz | 3,4 / 3,0 GHz | 270 W | $ 8.099 |

| Xeon Platinum 8368Q | 38 | 57 MB | 2,6 GHz | 3,7 / 3,3 GHz | 270 W | $ 6.743 |

| Xeon Platinum 8368 | 38 | 57 MB | 2,4 GHz | 3,4 / 3,2 GHz | 270 W | $ 6.302 |

| Xeon Platinum 8362 | 32 | 48 MB | 2,8 GHz | 3,6 / 3,5 GHz | 265 W | $ 5.448 |

| Xeon Platinum 8360Y | 36 | 54 MB | 2,4 GHz | 3,5 / 3,1 GHz | 250 W | $ 4.702 |

| Xeon Platinum 8358P | 32 | 48 MB | 2,6 GHz | 3,4 / 3,2 GHz | 240 W | $ 3.950 |

| Xeon Platinum 8358 | 32 | 48 MB | 2,6 GHz | 3,4 / 3,3 GHz | 250 W | $ 3.950 |

| Xeon Platinum 8352M | 32 | 48 MB | 2,3 GHz | 3,5 / 2,8 GHz | 185 W | $ 3.864 |

| Xeon Platinum 8352S | 32 | 48 MB | 2,2 GHz | 3,4 / 2,8 GHz | 205 W | $ 4.046 |

| Xeon Platinum 8352V | 36 | 54 MB | 2,1 GHz | 3,5 / 2,5 GHz | 195 W | $ 3.450 |

| Xeon Platinum 8352Y | 32 | 48 MB | 2,2 GHz | 3,4 / 2,8 GHz | 205 W | $ 3.450 |

| Xeon Platinum 8351N* | 36 | 54 MB | 2,4 GHz | 3,5 / 3,1 GHz | 225 W | $ 3.027 |

| Xeon Gold 6354 | 18 | 39 MB | 3,0 GHz | 3,6 / 3,6 GHz | 205 W | $ 2.445 |

| Xeon Gold 6348 | 28 | 42 MB | 2,6 GHz | 3,5 / 3,4 GHz | 235 W | $ 3.072 |

| Xeon Gold 6346 | 16 | 36 MB | 3,1 GHz | 3,6 / 3,6 GHz | 205 W | $ 2.300 |

| Xeon Gold 6342 | 24 | 36 MB | 2,8 GHz | 3,5 / 3,3 GHz | 230 W | $ 2.529 |

| Xeon Gold 6338N | 32 | 48 MB | 2,2 GHz | 3,5 / 2,7 GHz | 185 W | $ 2.795 |

| Xeon Gold 6338T | 24 | 36 MB | 2,1 GHz | 3,4 / 2,7 GHz | 165 W | $ 2.742 |

| Xeon Gold 6338 | 32 | 48 MB | 2,0 GHz | 3,2 / 2,6 GHz | 205 W | $ 2.612 |

| Xeon Gold 6336Y | 24 | 36 MB | 2,4 GHz | 3,6 / 3,0 GHz | 185 W | $ 1.977 |

| Xeon Gold 6334 | 8 | 18 MB | 3,6 GHz | 3,7 / 3,6 GHz | 165 W | $ 2.214 |

| Xeon Gold 6330N | 28 | 42 MB | 2,2 GHz | 3,4 / 2,6 GHz | 165 W | $ 2.029 |

| Xeon Gold 6330 | 28 | 42 MB | 2,0 GHz | 3,1 / 2,6 GHz | 205 W | $ 1.894 |

| Xeon Gold 6326 | 16 | 24 MB | 2,9 GHz | 3,5 / 3,3 GHz | 185 W | $ 1.300 |

| Xeon Gold 6314U | 32 | 48 MB | 2,3 GHz | 3,4 / 2,9 GHz | 205 W | $ 2.600 |

| Xeon Gold 6312U | 24 | 36 MB | 2,4 GHz | 3,6 / 3,1 GHz | 185 W | $ 1.450 |

| Xeon Gold 5320T | 20 | 30 MB | 2,3 GHz | 3,5 / 2,9 GHz | 150 W | $ 1.727 |

| Xeon Gold 5320 | 26 | 39 MB | 2,2 GHz | 3,4 / 2,8 GHz | 185 W | $ 1.555 |

| Xeon Gold 5318N | 24 | 36 MB | 2,1 GHz | 3,4 / 2,7 GHz | 150 W | $ 1.375 |

| Xeon Gold 5318S | 24 | 36 MB | 2,1 GHz | 3,4 / 2,6 GHz | 165 W | $ 1.667 |

| Xeon Gold 5318Y | 24 | 36 MB | 2,1 GHz | 3,4 / 2,6 GHz | 165 W | $ 1.273 |

| Xeon Gold 5317 | 12 | 18 MB | 3,0 GHz | 3,6 / 3,4 GHz | 150 W | $ 950 |

| Xeon Gold 5315Y | 8 | 12 MB | 3,2 GHz | 3,6 / 3,5 GHz | 140 W | $ 895 |

| Xeon Silver 4316 | 20 | 30 MB | 2,3 GHz | 3,4 / 2,8 GHz | 150 W | $ 1.002 |

| Xeon Silver 4314 | 16 | 24 MB | 2,4 GHz | 3,4 / 2,9 GHz | 135 W | $ 694 |

| Xeon Silver 4310T | 10 | 15 MB | 2,3 GHz | 3,5 / 2,9 GHz | 105 W | $ 555 |

| Xeon Silver 4310 | 12 | 18 MB | 2,1 GHz | 3,3 / 2,7 GHz | 120 W | $ 501 |

| Xeon Silver 4309Y | 8 | 12 MB | 2,8 GHz | 3,6 / 3,4 GHz | 105 W | $ 501 |

| Q – Liquid Cooled | ||||||

| S – Maximale SGX Enclave von 512 GB pro CPU | ||||||

| N – Networking/NFV Optimized | ||||||

| P – IaaS Cloud Optimized | ||||||

| V – SaaS Cloud Optimized | ||||||

| M – Media/AI Optimized | ||||||

| T – higher Tcase, 10 Jahre Lebenserwartung | ||||||

| Y – Speed Select Performance Profile 2.0 (Intel SST-PP) | ||||||

| U – Single Sockel | ||||||

| * – Single Sockel | ||||||

Intel On Demand

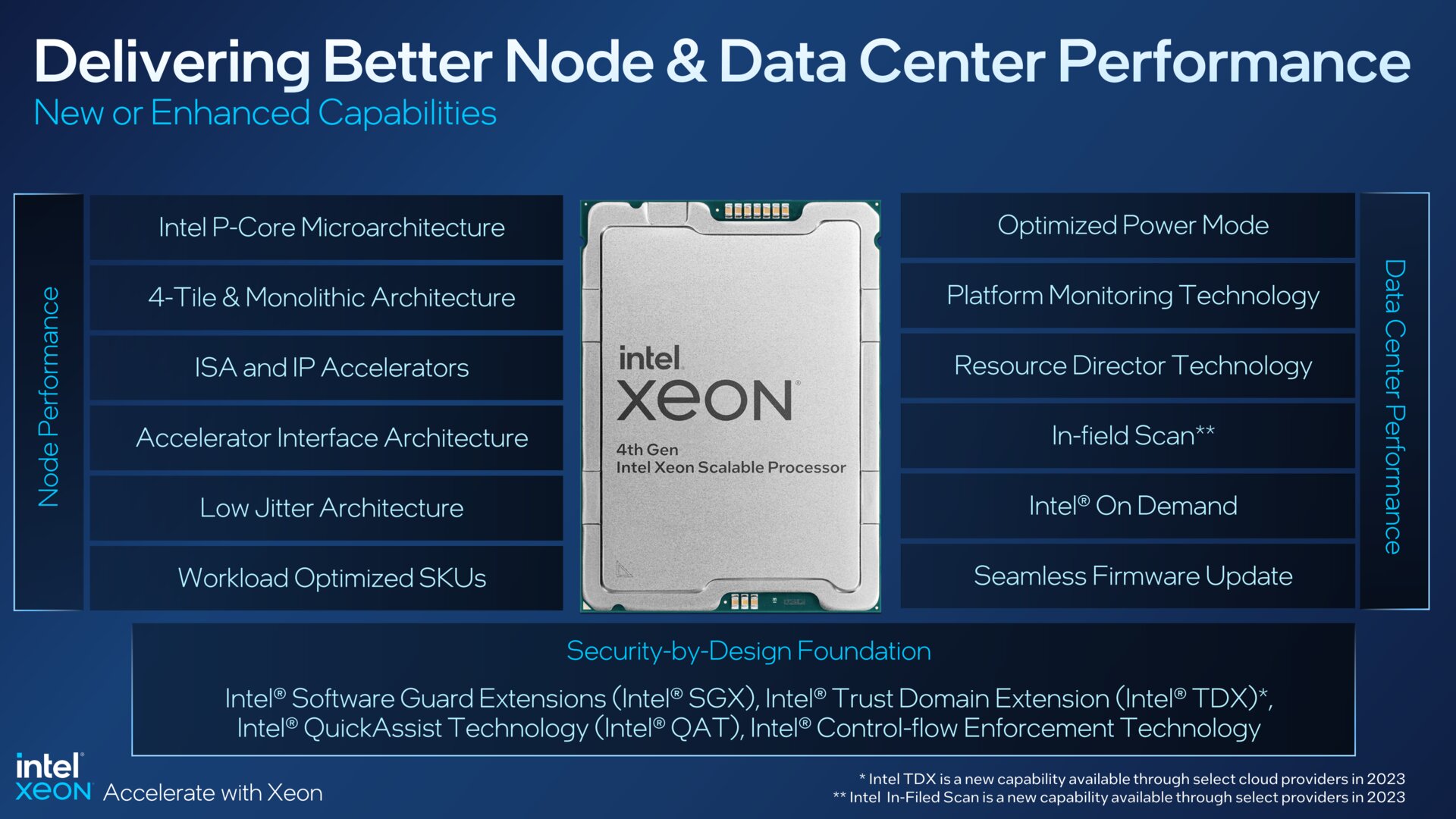

Eine weitere große Neuerung mit Sapphire Rapids ist das Vertriebsmodell Intel On Demand. Damit können auch nach dem Erwerb einer CPU bestimmte Beschleuniger- oder Sicherheitsfunktionen hinzugefügt oder erweitert werden. Die Software-Oberfläche für ein solches Upgrade wird von Intel und Server-Herstellern bereitgestellt. Was ein Upgrade kostet, wurde noch nicht kommuniziert.

Folgende Features sind aufrüstbar:

- Intel Software Guard Extensions

- Intel Data Streaming Accelerator

- Intel Quick Assist Technology (QAT)

- Intel Dynamic Load Balancer

- Intel In-Memory Analytics Accelerator

- Intel Data Streaming Accelerator

Intels Stärke bleibt die Software

Auch wenn AMD bei der Anzahl der Kerne und der Rohleistung Intel in den letzten Jahren davongeeilt ist und deutliche Gewinne bei den Marktanteilen einfahren konnte, ist Intel in einem Punkt weiterhin nicht zu schlagen: Software-Unterstützung. Bei einem Plattformwechsel muss gewährleistet sein, dass die Server gut mit der eingesetzten Software harmonieren. Und gerade hier ist Intels Marktdominanz noch deutlich spürbar.

Unter Berufung auf eine externe Studie erklärt Intel, dass 90 Prozent der Entwickler Software nutzen, die entweder von Intel entwickelt oder für Intel optimiert wurde. Dass Intel im Software-Sektor AMD weit überlegen ist, zeigt sich auch schon beim Personal: Bei Intel sollen allein mehr als 15.000 Software-Engineers arbeiten. Dass AMDs gesamtes Personal im Jahr 2021 etwa 15.500 Mitarbeiter zählte, verdeutlicht die Verhältnisse.

Xeon ungebrochen gefragt

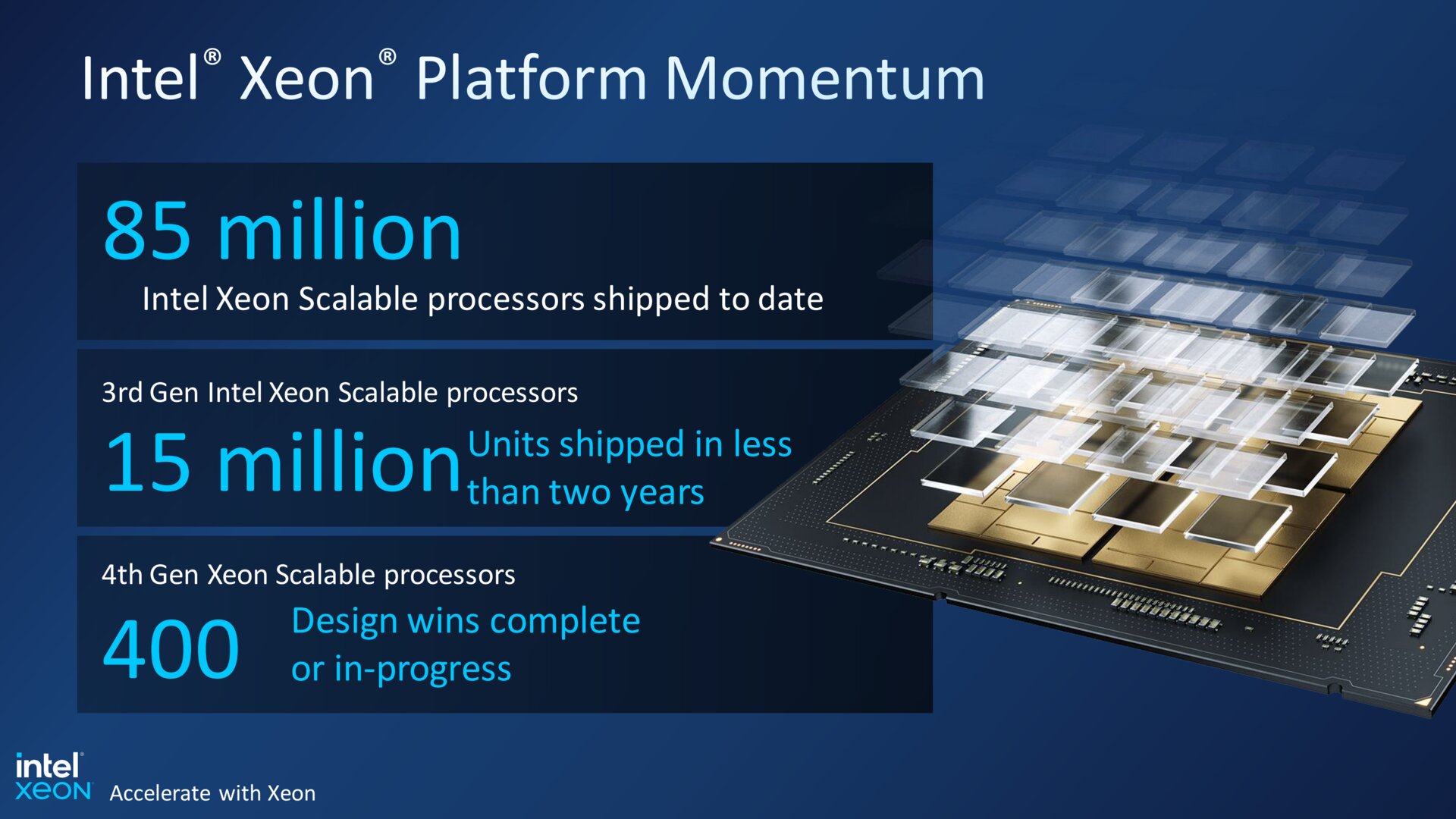

Auch wenn AMD Epyc im dritten Quartal 2022 auf einen Rekordanteil von 17,5 Prozent bei den Server-CPUs geklettert ist, zeigt sich Intel Xeon weiterhin dominant. Das untermauert der Konzern mit eindrucksvollen Verkaufszahlen: Bis heute sollen rund 85 Millionen Xeon Scalable ausgeliefert worden sein. Davon gehen 15 Millionen auf die dritte Generation zurück.

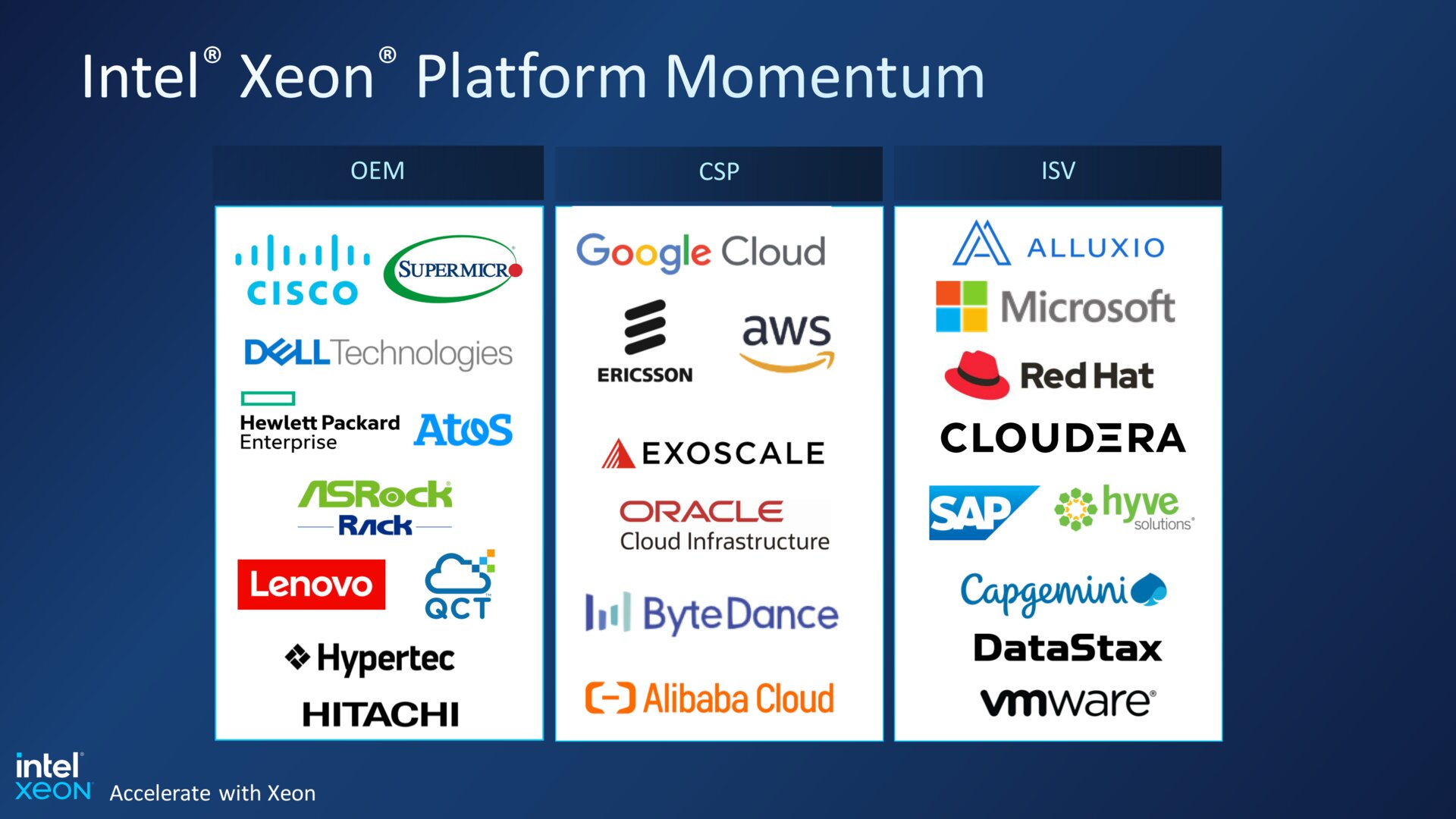

Für die vierte Generation werden aber schon 400 Design-Wins in Aussicht gestellt, die für kommende Endprodukte im Markt stehen. Dass die Größen der Branche auch weiterhin auf Intel setzen, veranschaulicht eine weitere Folie.

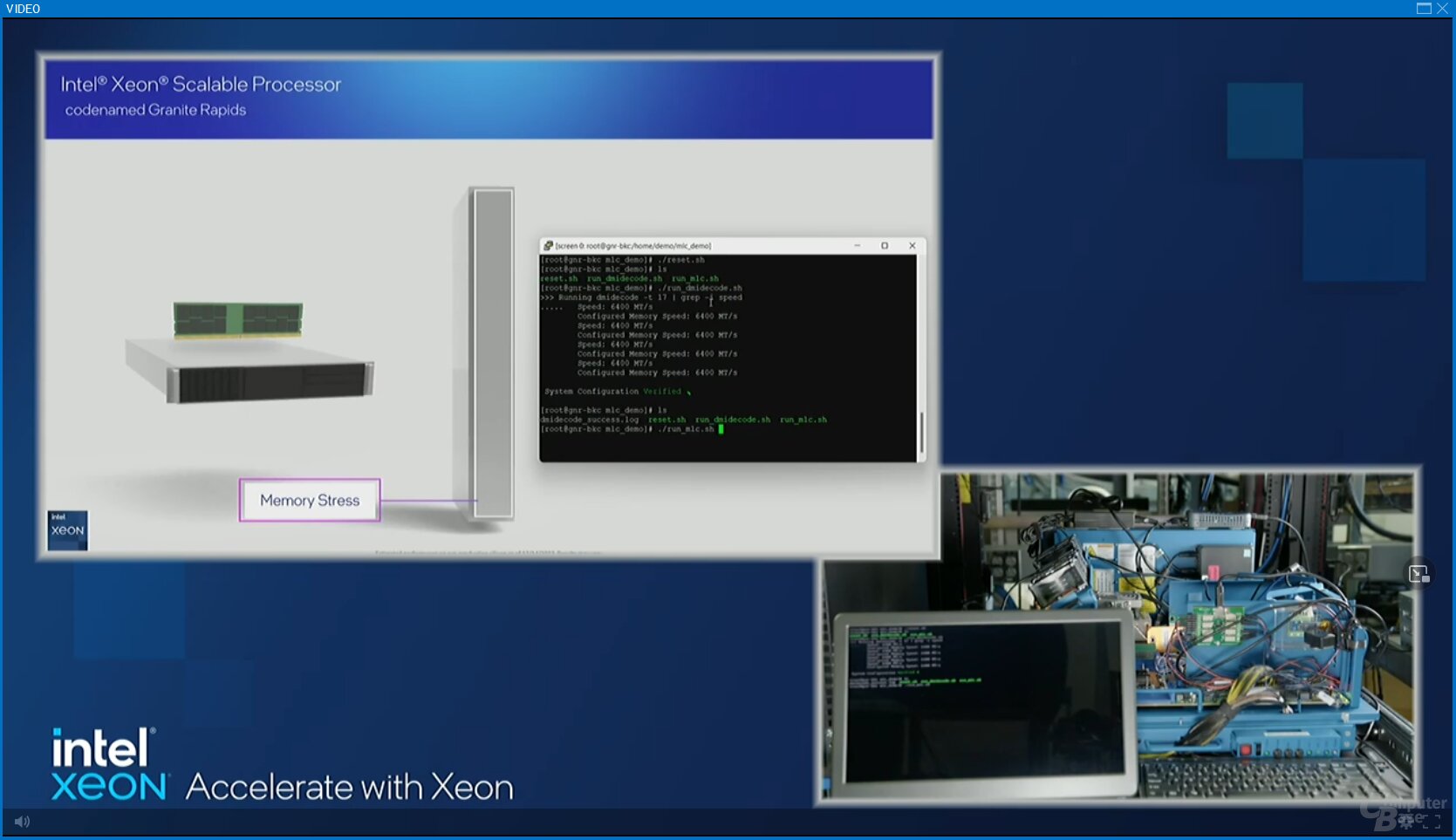

Lauffähiger Granite Rapids im Labor

Da Mitbewerber AMD zuletzt im Serverbereich nicht nur verstärkt Fuß gefasst hat, sondern auch stets die Kadenz und perfekte Umsetzung der neuen Produkte laut Fahrplan betont, springt auch Intel wieder auf den Fahrplan. So zeigte der Hersteller nicht den Drop-in-Nachfolger Emerald Rapids mit vergleichsweise kleinen Optimierungen, sondern den Nachnachfolger Granite Rapids. Dieser arbeitet im Labor bereits mit DDR5-6400 und absolviert erste Tests.

Laut Hersteller liegen sowohl Emerald Rapids als auch Sierra Forest vor dem anvisierten Zeitplan. Wie sich das in den letzten Jahren allerdings mit Xeon-Fahrplänen so an sich hatte, können diese sehr schnell nichts wert sein. Hier muss Intel nach unzähligen Ankündigungen endlich auch wieder einmal pünktlich abliefern.

ComputerBase wurde von Intel zum Server-Workshop in Portland und Hillsboro, USA, eingeladen. Die Redaktion entschied sich jedoch gegen den vier- bis fünftägigen Überseetrip und bekam so zwei Tage lang alle Präsentationen per Livestream direkt von dort übermittelt. Es galten die gleichen NDA-Bedingungen, die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt. Eine Einflussnahme des Herstellers auf den Bericht fand nicht statt, eine Verpflichtung zur Veröffentlichung bestand ebenfalls nicht.

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.