Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

En- und vorallem Dekodieren von Streams/Feeds HEVC 10bit 4:2:2 per CPU

- Ersteller hardwaredau

- Erstellt am

nach den Datasheets kann Intel ab 11th gen hevc 422 de/encode und Nvidia "eigentlich" ab GTX16xx / RTX 20xx aufwärts ebenso, das Thema ist hier eher die Software da die dann diese Hardware Features auch nutzen muss um das zu bewerkstelligen ...

wird beispielsweise bei Adobe Premiere Pro extra hervorgehoben dass dies unterstützt wird ... ab Intel 11th gen, was auch meine Empfehlung für so etwas wäre da hier einfach die größte Verbreitung wäre und das Thema Treiber usw meist gegeben ist.

da dies kein Mainstream ist und der Standard eigentlich auch kaum genutzt wird musst du eher die Software Seite "abklappern" welche dies "wo" unterstützt ...

TMPGEnc ... lange ist es her schreiben auch nur dass 10bit 422 unterstützt wird ... aber nicht ob nur software oder auch hardware gestützt, ebenso das hardware de/encode unterstützt wird, aber nicht bei welchen Formaten ... ich würde dort beispielsweise anfragen ...

schreiben auch nur dass 10bit 422 unterstützt wird ... aber nicht ob nur software oder auch hardware gestützt, ebenso das hardware de/encode unterstützt wird, aber nicht bei welchen Formaten ... ich würde dort beispielsweise anfragen ...

wird beispielsweise bei Adobe Premiere Pro extra hervorgehoben dass dies unterstützt wird ... ab Intel 11th gen, was auch meine Empfehlung für so etwas wäre da hier einfach die größte Verbreitung wäre und das Thema Treiber usw meist gegeben ist.

da dies kein Mainstream ist und der Standard eigentlich auch kaum genutzt wird musst du eher die Software Seite "abklappern" welche dies "wo" unterstützt ...

TMPGEnc ... lange ist es her

Ergänzung ()

Nachtrag, mal kurz nachgeschlagen und es sieht tatsächlich so aus dass hier nur 420 oder 444 geht, 422 (edge case) wird anscheinend nicht unterstützt ... sprich, Empfehlung hierfür auf jeden Fall Intel iGPU ab Iris 11th gen CPU.alturismo schrieb:und Nvidia "eigentlich" ab GTX16xx / RTX 20xx aufwärts ebenso

Zuletzt bearbeitet:

- Registriert

- Juli 2007

- Beiträge

- 203

Da Schlaf überbewertet wird (stimmt nicht) ... NVidia hat noch nie 4:2:2 und wird in absehbarer Zukunft laut Auskunft kein 4:2:2 unterstützen. Warum sie sich so querstellen wissen nur sie. Träge und satte Bude.

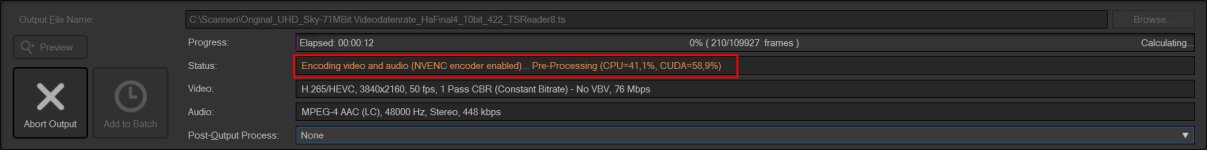

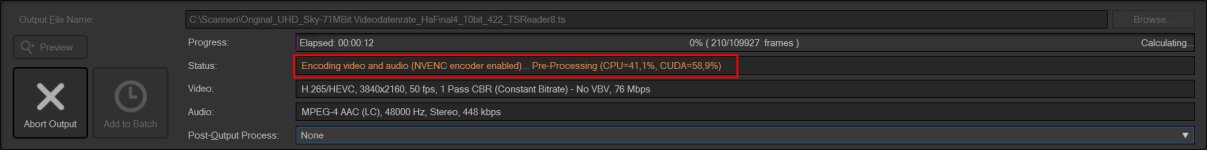

@alturismo: Meinst du genau dieses TMPGEnc, also diese Suite? Unter ähnlichen Begriffen gab es auch noch andere Tools. Diese Suite funktioniert gut und zuverlässig. NVENC wird als Encodierverfahren im Menü auch mit angeboten (siehe Bilder). Auf der Seite kann auch die Hardwareunterstützung nachgelesen werden; inkl. Intel Sync. Unterstützung bei h.264/5 - 4:2:0. Sowie 4:2:2 ins Spiel kommt, verschwindet die NVENC-Unterstützung.

Auch wenn als Ausgabe 4:2:2 aktiviert ist und NVENC im Menü nicht mehr angeboten wird, zeigt das Ausgabestatusfenster immer noch Arbeitsanteile von CUDA an. Kann das einer erklären? Wenn es keine GPU-Unterstützung gibt, wieso dann CUDA? Ich dachte CUDA steht für die Unterstützung durch die GPU-Kerne. Hmm.

@djducky: Du hättest es mit deinem AMD Ryzen ohne iGPU mal testen können, interessehalber. Der Link funktionierte.

@alturismo: Meinst du genau dieses TMPGEnc, also diese Suite? Unter ähnlichen Begriffen gab es auch noch andere Tools. Diese Suite funktioniert gut und zuverlässig. NVENC wird als Encodierverfahren im Menü auch mit angeboten (siehe Bilder). Auf der Seite kann auch die Hardwareunterstützung nachgelesen werden; inkl. Intel Sync. Unterstützung bei h.264/5 - 4:2:0. Sowie 4:2:2 ins Spiel kommt, verschwindet die NVENC-Unterstützung.

Auch wenn als Ausgabe 4:2:2 aktiviert ist und NVENC im Menü nicht mehr angeboten wird, zeigt das Ausgabestatusfenster immer noch Arbeitsanteile von CUDA an. Kann das einer erklären? Wenn es keine GPU-Unterstützung gibt, wieso dann CUDA? Ich dachte CUDA steht für die Unterstützung durch die GPU-Kerne. Hmm.

@djducky: Du hättest es mit deinem AMD Ryzen ohne iGPU mal testen können, interessehalber. Der Link funktionierte.

GrüßeDas "S" am Ende steht für sinnlos. (Wenn es überhaupt so eine potente/teure CPU sein muss?) Spar Dir die 170 € Aufpreis und nimm den normalen K. Der Performanceunterschied liegt nur knapp über der Messtoleranz.hardwaredau schrieb:Wenn, dann würde ich den zurzeit potentesten in dieser Kategorie nehmen, den 13900KS.

Das gesparte Geld bräuchtest Du nämlich für die Kühlung. Um die maximal mögliche Leistung überhaupt abrufen zu können, bedarf es der bestmöglichen Kühlung.

Das nur so am Rande.

- Registriert

- Juli 2007

- Beiträge

- 203

Über K oder KS kann man ja sprechen und sicher Kühlung ist wichtig. Mein gutes altes LianLi müsste dann sicher weichen, aus Platzmangel. Luftkühlung soll ja angeblich nicht langen. Keine Ahnung. Das Problem ist, das vielleicht 3 Prozent der gesamten Nutzungszeit eine hohe Last abverlangt wird. Sonst nicht.

Ich möchte auch noch 3 Sat bzw. Fernsehkarten darin betreiben. Mainboards gibt es für diesen Zweck auch nicht gerade viel. Und kochen sollen die auch nicht.

Ich möchte auch noch 3 Sat bzw. Fernsehkarten darin betreiben. Mainboards gibt es für diesen Zweck auch nicht gerade viel. Und kochen sollen die auch nicht.

- Registriert

- Juli 2007

- Beiträge

- 203

Erstens ... wenn man etwas neu zusammenbaut, da nimmt man doch nicht Mittelmaß, dass schon am Tag des Einbaus nicht mehr Stand der Dinge ist. Zweitens mache ich noch andere Sachen, die vielleicht nicht iGPU-kompatibel sind. Drittens ... Rechenleistung kann man nie genug haben; das hat immer die Zukunft gezeigt und ich rüste nicht alle 2-3 Jahre um und auf. Und preislich ist es auch nicht so happig. Ich brauche Stand jetzt ein neues Board, CPU + Kühlung, RAMs und eventuell je nach Kühlung ein neues Gehäuse. Netzteil, SSDs, GPU und der Rest bleiben erst mal drin.

- Registriert

- März 2017

- Beiträge

- 18.240

Sorry, bei mir wollte die Datei halt nicht runterladen - und ich war gestern ohnehin am gehen.

Aber ja, den 13900K kannste nehmen. Nur für die iGPU wäre das natürlich nicht nötig, wie schon angemerkt. Für ausreichende Kühlung ist zu sorgen, die Raptor Lake können ganz hübsch saufen.

Aber ja, den 13900K kannste nehmen. Nur für die iGPU wäre das natürlich nicht nötig, wie schon angemerkt. Für ausreichende Kühlung ist zu sorgen, die Raptor Lake können ganz hübsch saufen.

- Registriert

- Juli 2007

- Beiträge

- 203

Es gibt immer noch Anwendungen mit Single-Thread. Deshalb würde ich da nicht so tief gehen wollen. Der Kaufpreis ist kein Argument, Stromverbrauch oder Hitze schon eher.

- Registriert

- März 2017

- Beiträge

- 18.240

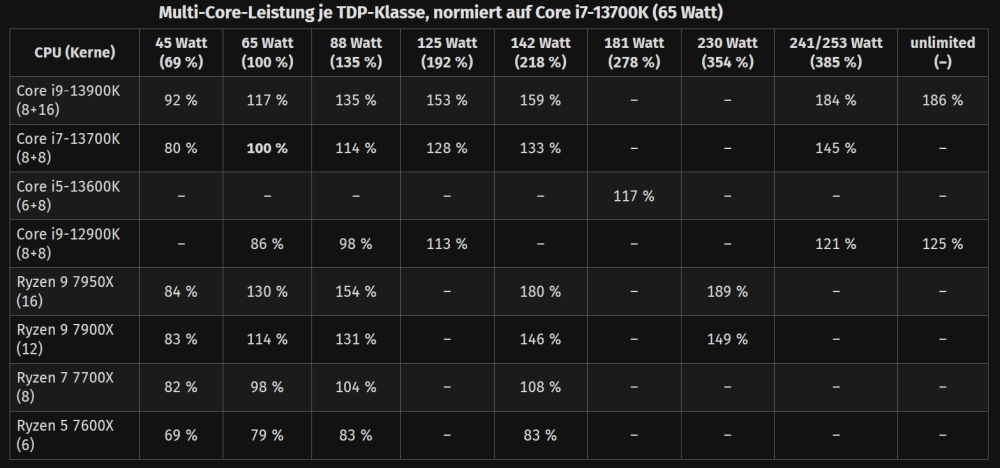

Du kannst auch nem raptor Lake das Saufen abgewöhnen, zum Beispiel durch ein Powerlimit. Die werden nämlich ziemlich überzüchtet ausgeliefert - und saufen dann für ein paar % mehr Leistung gleich exorbitant mehr Strom. Sieht man an der Tabelle aus dem Test ganz gut. Da ist ein 13700k mit mehr als dem doppelten verbrauch ganze 33% schneller. Die Teile über 142W zu betreiben macht kaum noch Sinn. ich schätze mal, dass der Sweet Spot aus Energiehunger und Leistung irgendwo bei 110-125W sein wird.

- Registriert

- Juli 2007

- Beiträge

- 203

Danke @djducky wie immer für die hilfreichen Tipps. Ebenso den sehr hilfsbereiten @HisN. Die eigentliche CPU-Frage ist geklärt. Ich benötige eine höhere Last - da kein Spieler - im Verhältnis zur Gesamtnutzungszeit des PCs recht selten. Deswegen spielt der Stromverbrauch im "Office- oder Allerweltsbetrieb" schon eine Rolle.

Jetzt suche ich noch das passende Mainbord zum i9-13900K. Die Hauptanforderung ist Qualität und Stabilität und nicht Schnickschnack. Bis jetzt habe ich immer die in meinen Augen unverwüstlichen Workstation-Boards von ASUS genommen. Der Preis ist erst mal zweitrangig. Anforderungen sind:

Viele Boards mit Z790-Chipsatz habe ich nicht gefunden, bei den die Steckplätzen vorhanden sind und auch physisch Platz ist sie zu stecken. Meine jetzige GPU MSI RTX 2080 Ti VENTUS verlangt nur 2 Slots, aber eine neuere irgendwann könnte auch mehr benötigen. Platz für eine 3er Slot GPU sollte schon eingeplant werden.

Was ich fand und bei anderen gesehen habe:

Bevor ich eines kaufe, möchte ich schon das genaue Sharing der PCI-Slots und Sata/M.2 genau wissen. Gerade für die beiden genannten Boards. Wenn ich hier quer lese, haben da einige auch Überraschungen erlebt. In den Anleitungen ist das für mich als Gelegenheitszusammbauer nicht immer 100%ig ersichtlich.

Ich nehme wieder jeden Tipp und jede Erklärung der Share-Problematik der Steck- und SATA-Plätze entgegen. Was ich nicht unbedingt brauche ... das ist zu teuer, das brauchst du nicht o.ä. Das muss ich dann schon selbst entscheiden.

Grüße

Jetzt suche ich noch das passende Mainbord zum i9-13900K. Die Hauptanforderung ist Qualität und Stabilität und nicht Schnickschnack. Bis jetzt habe ich immer die in meinen Augen unverwüstlichen Workstation-Boards von ASUS genommen. Der Preis ist erst mal zweitrangig. Anforderungen sind:

- 3 voll nutzbare PCI-E Steckplätze (x1 oder x4) für Sat- oder TV-Karten, die den PCI5-E (x16) nicht sharen

- mindestens 6 SATA-Anschlüsse

- logischerweise reichlich USB-Anschlüsse

- mindestens 1 M.2 NVNe-Anschluss, besser 2, die SATA nicht sharen. Zur Not müsste ich mich von etwas SATA trennen, wäre aber schade um die vorhandenen 4TB-SSD-Sata. Mein jetziges Board ASUS X99-E-10G WS hat 10 Anschlüsse.

Viele Boards mit Z790-Chipsatz habe ich nicht gefunden, bei den die Steckplätzen vorhanden sind und auch physisch Platz ist sie zu stecken. Meine jetzige GPU MSI RTX 2080 Ti VENTUS verlangt nur 2 Slots, aber eine neuere irgendwann könnte auch mehr benötigen. Platz für eine 3er Slot GPU sollte schon eingeplant werden.

Was ich fand und bei anderen gesehen habe:

- ASUS Pro WS W680-ACE Link Herstellerseite (W680-Chipsatz)

- ASUS PRIME Z790-P Link Herstellerseite

- und dann verließen sie ihn.

Bevor ich eines kaufe, möchte ich schon das genaue Sharing der PCI-Slots und Sata/M.2 genau wissen. Gerade für die beiden genannten Boards. Wenn ich hier quer lese, haben da einige auch Überraschungen erlebt. In den Anleitungen ist das für mich als Gelegenheitszusammbauer nicht immer 100%ig ersichtlich.

Ich nehme wieder jeden Tipp und jede Erklärung der Share-Problematik der Steck- und SATA-Plätze entgegen. Was ich nicht unbedingt brauche ... das ist zu teuer, das brauchst du nicht o.ä. Das muss ich dann schon selbst entscheiden.

Grüße

- Registriert

- März 2017

- Beiträge

- 18.240

Die meisten Boards haben zwei bis drei M.2 Steckplätze, davon oft mindestens zwei für PCIe 4.0.

Zusätzliche SATA-Anschlüsse hast du immer, aber bei manchen brettern funktionieren dann eben nicht mehr alle, wenn du das mit Boards belegst. Aber das sind meistens so boards mit 8x SATA, wo dann zwei, drei oder vier nicht mehr funktionieren bei M.2-Vollbestückung. Das verlinkte Prime hat ja überhaupt nur 4x SATA.

Ich habe mir die Anleitungen von den beiden Boards angeschaut und da nichts zu den möglichen Belegungen gefunden.

Bedeutende Vorteile für das W680-Board sehe ich auf den ersten Blick nicht. Ich kenne mich mit diesem Krams wie Intel PMI und diesen ganzen Workstation-Security-Features auch nicht aus - und die machen wohl einen guten teil des Preises aus. Um die Stabilität der Spannungsversorgung musst du dir auch bei dem Z790 keine Sorgen machen. Es sei denn, du willst die CPU wirklich frei drehen lassen bis in die ~240W. Aber hier rutscht mein Wissen auch etwas ins Ungefähre, da will ich nicht ins Blaue tippen und nachher Unsinn erzählen.

Zusätzliche SATA-Anschlüsse hast du immer, aber bei manchen brettern funktionieren dann eben nicht mehr alle, wenn du das mit Boards belegst. Aber das sind meistens so boards mit 8x SATA, wo dann zwei, drei oder vier nicht mehr funktionieren bei M.2-Vollbestückung. Das verlinkte Prime hat ja überhaupt nur 4x SATA.

Ich habe mir die Anleitungen von den beiden Boards angeschaut und da nichts zu den möglichen Belegungen gefunden.

Bedeutende Vorteile für das W680-Board sehe ich auf den ersten Blick nicht. Ich kenne mich mit diesem Krams wie Intel PMI und diesen ganzen Workstation-Security-Features auch nicht aus - und die machen wohl einen guten teil des Preises aus. Um die Stabilität der Spannungsversorgung musst du dir auch bei dem Z790 keine Sorgen machen. Es sei denn, du willst die CPU wirklich frei drehen lassen bis in die ~240W. Aber hier rutscht mein Wissen auch etwas ins Ungefähre, da will ich nicht ins Blaue tippen und nachher Unsinn erzählen.

Bei Deinen Slot-/Lane-Wünschen kann es sein, dass Du erst mit einer HEDT/Workstation Plattform alles ohne Kompromisse bekommst.

Allerdings kosten Board, CPU, Kühler und Gehäuse ein "bisschen" mehr.

Schau Dir mal die beiden News an:

https://www.computerbase.de/news/ma...rds-von-asus-bieten-schlicht-maximales.83372/

https://www.computerbase.de/news/ma...oard-mit-dual-10-gbe-und-mini-lueftern.83377/

Allerdings kosten Board, CPU, Kühler und Gehäuse ein "bisschen" mehr.

Schau Dir mal die beiden News an:

https://www.computerbase.de/news/ma...rds-von-asus-bieten-schlicht-maximales.83372/

https://www.computerbase.de/news/ma...oard-mit-dual-10-gbe-und-mini-lueftern.83377/

- Registriert

- Juli 2007

- Beiträge

- 203

Hi djducky,

der Vorteil der Workstation-Boards ist im allgemeinen die höhere Qualität der Bauteile - laut Aussage. 24/7 permanent kein Problem. Ich habe mal ungelogen ca. 1,5 Jahre meinen Rechner mit nahezu GPU-Vollast für Rechenoperationen durchlaufen lassen. Ich hatte meist 95 % Leistung der GPU. Nur ab und zu habe ich ihn etwas ausgebremst, als es zu sehr ruckelte für Office o.ä. Die Bauteile halten; von früheren einfacheren Boards kenne ich das nicht. Ist aber lange her und vielleicht jetzt anders. Schwach ist, dass es nirgends eine brauchbare detaillierte Sharing-Liste gibt.

Bei den PCI-E Steckplätzen sharen doch generell, wenn überhaupt, nur die 16er - das ist doch richtig? Meistens wenn vorhanden 1 & 2. Dafür gibt es ja auch Listen. Also sehe ich das richtig, dass mechanische PCI-E x1 oder x4 generell nie den 16er Hauptsteckplatz, meistens den oberen, etwas abzweigen?

@MORPEUS: Genau, das ist ein Typus Nachfolgerboard von meinem jetzigen. Ist aber sicherlich auch etwas stark Overkill die Prozessoren betreffend, zumal die Xeon kein iGPU haben. Das lese ich mir mal in Ruhe durch. Die Ausstattung des Boards ist sicherlich sehr gut, aber eben nicht für den richtigen Prozessor geeignet. Ein brauchbare einfachere WS-Variante ist ja schon das oben rausgesuchte ASUS Pro WS W680-ACE.

der Vorteil der Workstation-Boards ist im allgemeinen die höhere Qualität der Bauteile - laut Aussage. 24/7 permanent kein Problem. Ich habe mal ungelogen ca. 1,5 Jahre meinen Rechner mit nahezu GPU-Vollast für Rechenoperationen durchlaufen lassen. Ich hatte meist 95 % Leistung der GPU. Nur ab und zu habe ich ihn etwas ausgebremst, als es zu sehr ruckelte für Office o.ä. Die Bauteile halten; von früheren einfacheren Boards kenne ich das nicht. Ist aber lange her und vielleicht jetzt anders. Schwach ist, dass es nirgends eine brauchbare detaillierte Sharing-Liste gibt.

Bei den PCI-E Steckplätzen sharen doch generell, wenn überhaupt, nur die 16er - das ist doch richtig? Meistens wenn vorhanden 1 & 2. Dafür gibt es ja auch Listen. Also sehe ich das richtig, dass mechanische PCI-E x1 oder x4 generell nie den 16er Hauptsteckplatz, meistens den oberen, etwas abzweigen?

@MORPEUS: Genau, das ist ein Typus Nachfolgerboard von meinem jetzigen. Ist aber sicherlich auch etwas stark Overkill die Prozessoren betreffend, zumal die Xeon kein iGPU haben. Das lese ich mir mal in Ruhe durch. Die Ausstattung des Boards ist sicherlich sehr gut, aber eben nicht für den richtigen Prozessor geeignet. Ein brauchbare einfachere WS-Variante ist ja schon das oben rausgesuchte ASUS Pro WS W680-ACE.

- Registriert

- März 2017

- Beiträge

- 18.240

Ja, hier stoße ich halt an meine Grenzen. Was die Workstations da an Ausstattung habe... keine Ahnung. Ich würde natürlich hoffen, dass die iGPU mit Quicksync deine CPU-Last reduzieren kann.

Ich habe jetzt auch nochmal geschaut, weil ich die Idee hatte, dass Intel ARC Grafikkarten ggf. auch 4:2:2 de/encodieren können. Somit müsstest du keine CPu mit iGPU nehmen und hättest da eine größere Auswahl.

Diese Seite behauptet jedenfalls, es geht auf den ARC Karten:

Ich habe jetzt auch nochmal geschaut, weil ich die Idee hatte, dass Intel ARC Grafikkarten ggf. auch 4:2:2 de/encodieren können. Somit müsstest du keine CPu mit iGPU nehmen und hättest da eine größere Auswahl.

Diese Seite behauptet jedenfalls, es geht auf den ARC Karten:

Dann könntest du dir ggf. einen Xeon (gut, die gibt es auch mit iGPU) oder einen Ryzen 9 oder EPYC anlachen. Falls du den dann überhaupt noch brauchst, wenn dein de/encoding über GPU läuft.What makes us the most excited is the fact that the Intel Arc cards are supposed to have all the same hardware decoding capabilities as Quick Sync on Intel Core 12th Gen CPUs. What that means is that you would no longer be locked into using an Intel Core CPU if you work with the certain "flavors" of HEVC that only Quick Sync supports on a hardware level (such as HEVC 4:2:2 10-bit).

Oh man. Gar nicht mehr dran gedacht. Sorry.hardwaredau schrieb:...zumal die Xeon kein iGPU haben.

(Aber hey, kein Problem. Der hochperformante Onboard-Grafikchip AST2600 übernimmt das Dekodieren mit links. Sogar in h266 26Bit 6:6:6 und CMYK.

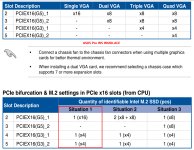

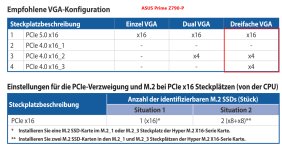

Auf die schnelle konnte ich auch nichts aussagekräftiges finden, ob und wie das ASUS Pro WS W680-ACE Lane-shareing betreibt.

Lediglich in den Tech Specs, Unterpunkt Expansions Slots, wird auf eine PCIe bifurcation table verlinkt. Die mich, ebenso wie die kurze Erwähnung von bifurcation im Bios Handbuch, eher Ratlos zurücklassen.

Das unterste Schaubild in dem Artikel zeigt, was zumindest theoretisch möglich ist.

Lediglich in den Tech Specs, Unterpunkt Expansions Slots, wird auf eine PCIe bifurcation table verlinkt. Die mich, ebenso wie die kurze Erwähnung von bifurcation im Bios Handbuch, eher Ratlos zurücklassen.

Das unterste Schaubild in dem Artikel zeigt, was zumindest theoretisch möglich ist.

- Registriert

- Juli 2007

- Beiträge

- 203

Laut Bedienungsanleitung sharen die beiden oberen. Der 16er von der CPU und der erste vom Chipsatz. Bei beiden Boards. Die x1 oder x4 werden nirgends erwähnt, deshalb ging ich davon aus, dass sie nicht betroffen sind. Wenn der erste vom Chipsatz generell freigelassen wird, dürfte es für meinen Geschmack nirgends bei den anderen Slots Sharing geben. Von den 1er oder 4er PCI-E Slots steht da nirgends etwas.

Die verlinkte Chipsatzgrafik deute ich so, dass die CPU 16 + 4 Lanes oder 2x8 plus 4 ohne Sharing hergibt. Beim Chipsatz steht bis zu 12 PCI-E 4.0 - theoretisch 3 Steckplätze x4 und noch einen vollen 16er PCI-E 4.0.

Die verlinkte Chipsatzgrafik deute ich so, dass die CPU 16 + 4 Lanes oder 2x8 plus 4 ohne Sharing hergibt. Beim Chipsatz steht bis zu 12 PCI-E 4.0 - theoretisch 3 Steckplätze x4 und noch einen vollen 16er PCI-E 4.0.