Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Ist Hardware Video Decoding nur ein Hoax?

- Ersteller Klamann

- Erstellt am

Project 2501

Lt. Junior Grade

- Registriert

- Feb. 2021

- Beiträge

- 380

Hardware-Decoding würde ich nur verwenden, wenn es absolut notwendig ist - z.B. am Laptop im Akkubetrieb oder am Smartphone.

HTPC immer mit halbwegs potenter CPU, damit die alles per Software decodieren kann.

Auch ein Skylake-Pentium hat in meinem alten HTPC bereits 4K AVC und HEVC problemlos in Software geschafft.

Genau wegen solchem im Eingangspost beschriebenen Herumgezicke mache ich um Hardware-Decoding wo es geht einen großen Bogen.

HTPC immer mit halbwegs potenter CPU, damit die alles per Software decodieren kann.

Auch ein Skylake-Pentium hat in meinem alten HTPC bereits 4K AVC und HEVC problemlos in Software geschafft.

Genau wegen solchem im Eingangspost beschriebenen Herumgezicke mache ich um Hardware-Decoding wo es geht einen großen Bogen.

- Registriert

- Nov. 2006

- Beiträge

- 967

Interessant... meinst du der Pentium Silver N6005 (4C/4T, 2.00-3.30GHz) im nächstgrößeren NUC würde das in Software schaffen? Mir gefällt die NUC Plattform schon sehr, da würde ich ggf. den Aufpreis für den Pentium in Kauf nehmen.Project 2501 schrieb:Auch ein Skylake-Pentium hat in meinem alten HTPC bereits 4K AVC und HEVC problemlos in Software geschafft.

@Klamann In wie fern hattest du abgecheckt, dass die HW Decoder auch die Formate vollständig können?

Laut Notebookcheck sollte dein Celeron N5105 Gen11 Grafikeinheiten haben, also die gleichen aus Ice Lake, aber deutlich weniger Recheneinheiten davon. (24 EU).

Ich habe hier ein Comet Lake System (das ist noch Gen9.5, auch 24EU), dass kann laut Datenblatt von Intel kein VP9 Profile 2 (was Youtube zB in dem von die verlinkten HDR Video nutzt, dass ruckelt auch direkt auf meinem 10750H. Die 3D-Last ist im Taskmanager am Limit. Das sind eigentlich immer die allgemeinen Recheneinheiten der iGPU und werden für HDR-Processing genutzt (HDR verlangt den Intel iGPUs selbst mit Alder Lake ein vielfaches ab im Vergleich zu SDR). Und auch für Decoding, wenn die HW Decoder das Format nicht alleine können.

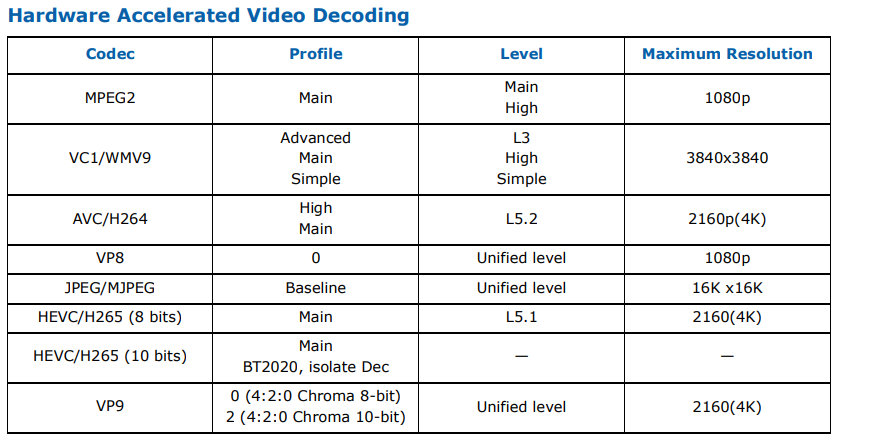

Gen11 sollte zwar VP9.2 können, aber wenn ich das richtig lese kein HEVC in 10 Bit. Also eins mehr als mein Comet Lake und dafür ein anderes weniger. Und das gilt nur fest für Ice Lake, das könnte für den Celeron weiter beschnitten sein, da hat Intel keine öffentlichen Specs für. Und die HW Decoder/Encoder sind wohl ein wenig separat von den eigentlichen Recheneinheiten.

Das könnte also evtl erklären warum du mit HEVC 4K HDR probleme hast.

Abgesehen davon habe ich zB selbst bei Alder Lake festgestellt, dass zB HDR mit 8 Bit Dithering, also wenn das HDR10 Format genutzt wird, aber nur 8 Bit Farbtiefe zum Monitor gehen spürbar mehr Leistung benötigt als mit nativen 10 Bit und ich so auch dort mit mehreren Monitoren ans Limit kommen kann.

Also scheinbar ist dein Celeron sowohl in den unterstützten Formaten 2 Generation alt (faszinierenderweise hat Intel die Gen9 Grafik von Comet Lake mit neuen HW-Decodern für HEVC 10 Bit neu aufgelegt, also mehr als bei Gen11, dafür fehlt dann aber das für Youtube HDR notwendige VP9.2).

Auch mit nur 24EU gegenüber den 72-96EU aus den Ice Lake Notebookprozessoren ist die Celeron iGPU evtl zu schwach für das HDR Processing das Intel braucht für die Ausgabe von HDR10 zum Monitor...

Ich habe auch mal probiert die 3 herunterladbaren UHD HEVC HDR Videos von der Kodi Seite auf meinem 10750H abzuspielen. Die ruckeln fast alle (Nur das Astra-File kann mit MPC-HC ruckelfrei in SDR und HDR abgespielt werden. Die anderen ruckeln auch bei mir und da liegt es definitiv nicht an der CPU Leistung.

Scheint also als ob die Generation von iGPU die du hast noch grundsätzliche Probleme mit den HDR Formaten haben könnte und insbesondere mit der Wiedergabe von HDR. Dann würde ich sagen, es scheint mind. Tiger Lake Core-i / Xe LP / Gen12 Graphics zu brauchen, ganz unabhängig von der CPU Leistung...

Laut Notebookcheck sollte dein Celeron N5105 Gen11 Grafikeinheiten haben, also die gleichen aus Ice Lake, aber deutlich weniger Recheneinheiten davon. (24 EU).

Ich habe hier ein Comet Lake System (das ist noch Gen9.5, auch 24EU), dass kann laut Datenblatt von Intel kein VP9 Profile 2 (was Youtube zB in dem von die verlinkten HDR Video nutzt, dass ruckelt auch direkt auf meinem 10750H. Die 3D-Last ist im Taskmanager am Limit. Das sind eigentlich immer die allgemeinen Recheneinheiten der iGPU und werden für HDR-Processing genutzt (HDR verlangt den Intel iGPUs selbst mit Alder Lake ein vielfaches ab im Vergleich zu SDR). Und auch für Decoding, wenn die HW Decoder das Format nicht alleine können.

Gen11 sollte zwar VP9.2 können, aber wenn ich das richtig lese kein HEVC in 10 Bit. Also eins mehr als mein Comet Lake und dafür ein anderes weniger. Und das gilt nur fest für Ice Lake, das könnte für den Celeron weiter beschnitten sein, da hat Intel keine öffentlichen Specs für. Und die HW Decoder/Encoder sind wohl ein wenig separat von den eigentlichen Recheneinheiten.

Das könnte also evtl erklären warum du mit HEVC 4K HDR probleme hast.

Abgesehen davon habe ich zB selbst bei Alder Lake festgestellt, dass zB HDR mit 8 Bit Dithering, also wenn das HDR10 Format genutzt wird, aber nur 8 Bit Farbtiefe zum Monitor gehen spürbar mehr Leistung benötigt als mit nativen 10 Bit und ich so auch dort mit mehreren Monitoren ans Limit kommen kann.

Also scheinbar ist dein Celeron sowohl in den unterstützten Formaten 2 Generation alt (faszinierenderweise hat Intel die Gen9 Grafik von Comet Lake mit neuen HW-Decodern für HEVC 10 Bit neu aufgelegt, also mehr als bei Gen11, dafür fehlt dann aber das für Youtube HDR notwendige VP9.2).

Auch mit nur 24EU gegenüber den 72-96EU aus den Ice Lake Notebookprozessoren ist die Celeron iGPU evtl zu schwach für das HDR Processing das Intel braucht für die Ausgabe von HDR10 zum Monitor...

Ich habe auch mal probiert die 3 herunterladbaren UHD HEVC HDR Videos von der Kodi Seite auf meinem 10750H abzuspielen. Die ruckeln fast alle (Nur das Astra-File kann mit MPC-HC ruckelfrei in SDR und HDR abgespielt werden. Die anderen ruckeln auch bei mir und da liegt es definitiv nicht an der CPU Leistung.

Scheint also als ob die Generation von iGPU die du hast noch grundsätzliche Probleme mit den HDR Formaten haben könnte und insbesondere mit der Wiedergabe von HDR. Dann würde ich sagen, es scheint mind. Tiger Lake Core-i / Xe LP / Gen12 Graphics zu brauchen, ganz unabhängig von der CPU Leistung...

Zuletzt bearbeitet:

- Registriert

- Nov. 2006

- Beiträge

- 967

@Ray519 ich hatte mich vorwiegend auf den Wikipedia-Eintrag zu Intel Quick Sync Video verlassen, weil ich bei Intel selbst keine Informationen dazu gefunden habe. Im Handbuch zur NUC steht leider nichts über unterstützte Codecs und Parameter. Das wäre natürlich eine Erklärung, wenn Intel beim Celeron mit seinem spärlichen 24 EUs offiziell gar kein 4K Decoding unterstützt.

Ich schau mal, ob ich irgendwo ein offizielles Dokument dazu finden kann...

Ich schau mal, ob ich irgendwo ein offizielles Dokument dazu finden kann...

Diese schönen Specs habe ich bisher nur für die Core Prozessoren gefunden:

https://www.intel.com/content/www/us/en/products/docs/processors/core/core-technical-resources.html

Von AMD kenne ich sowas detailliertes gar nicht.

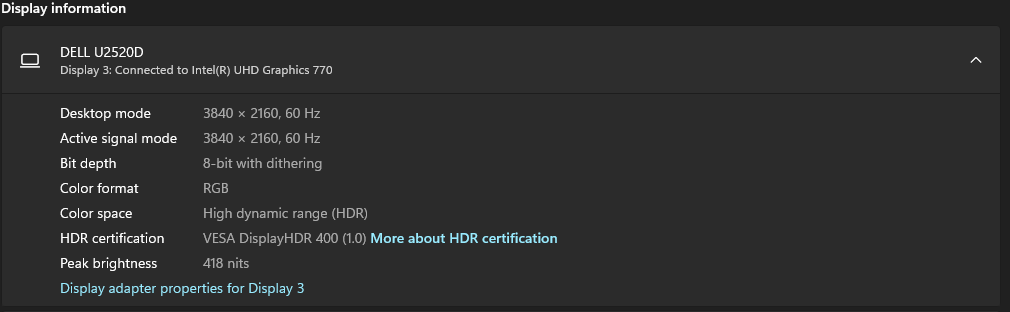

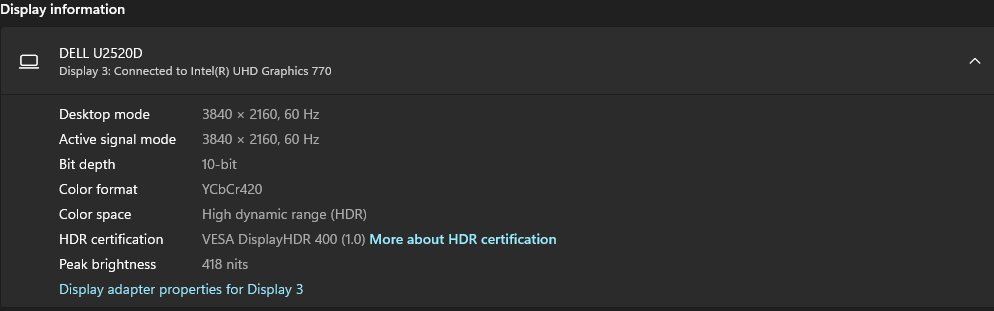

Und fyi, via HDMI 2.0, wenn du 60Hz nutzt, geht 10 Bit ja gar nicht. Ich weiß Alder Lake lässt einen jetzt bei nativen HDMI Ports auch endlich Chroma Subsampling einstellen, aber keine Ahnung ob das schon seit Ice Lake geht. Dann kommt evtl noch der Dithering Overhead für HDR zwangsweise dazu, solange du auf 60 Hz bleibst...

https://www.intel.com/content/www/us/en/products/docs/processors/core/core-technical-resources.html

Von AMD kenne ich sowas detailliertes gar nicht.

Und fyi, via HDMI 2.0, wenn du 60Hz nutzt, geht 10 Bit ja gar nicht. Ich weiß Alder Lake lässt einen jetzt bei nativen HDMI Ports auch endlich Chroma Subsampling einstellen, aber keine Ahnung ob das schon seit Ice Lake geht. Dann kommt evtl noch der Dithering Overhead für HDR zwangsweise dazu, solange du auf 60 Hz bleibst...

- Registriert

- Nov. 2006

- Beiträge

- 967

Das stimmt so nicht. Seit HDMI 2.0a wird HDR bei 4K@60Hz unterstützt. Die NUC 11 hat HDMI 2.0b, das hat alle Features von HDMI 2.0a und dementsprechend auch vollen HDR Support.Ray519 schrieb:Und fyi, via HDMI 2.0, wenn du 60Hz nutzt, geht 10 Bit ja gar nicht.

Ich konnte das auch im Grafiktreiber einstellen und der Fernseher hat das ohne zu murren akzeptiert. Ob da wirklich 10bit Farben auf dem Fernseher dargestellt werden oder doch nur 8bit, kann ich nicht beurteilen, dafür fehlt mir die Erfahrung. Da bräuchte ich mal ein Testvideo und selbst dann wird es wohl schwer zu erkennen sein.

HDR ja, aber nicht mit 10 Bit und 4:4:4 (HDR10 geht auch mit 8 Bit und das ist was du standardmäßig in Windows bekommst, wenn du einfach auf 60Hz stellst und HDR anschaltest).

Denn dafür reicht die HDMI 2.0 Bandbreite nicht (a und b haben die Bandbreite ja nicht erhöht, sondern nur neue Formate / Features definiert.

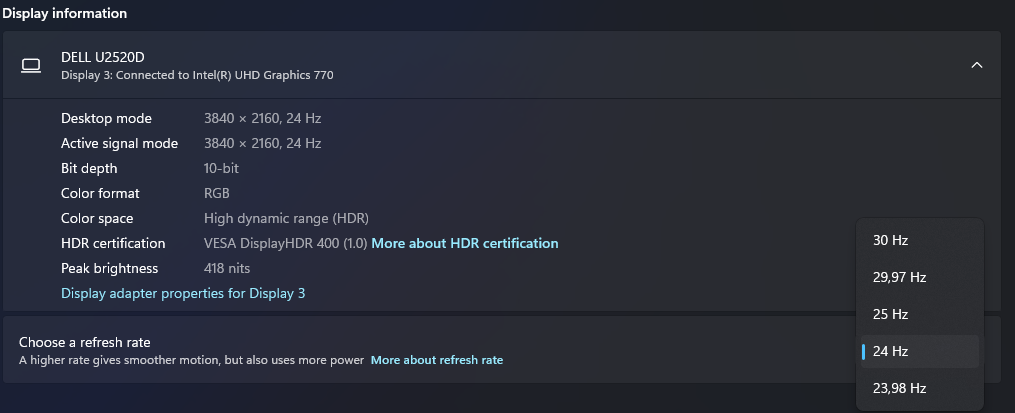

Für 10 Bit mit UHD über HDMI 2.0 wird entweder nur 24Hz oder ähnliches genutzt, weil das meiste Filmmaterial eh nur 24Hz ist, dann geht 10 Bit natürlich. Auch 12 Bit für Dolby Vision. Oder es wird 4:2:0 Chroma Subsampling genutzt, weil so gut wie jedes Consumer-Filmformat eh 4:2:0 hat.

Denn dafür reicht die HDMI 2.0 Bandbreite nicht (a und b haben die Bandbreite ja nicht erhöht, sondern nur neue Formate / Features definiert.

Für 10 Bit mit UHD über HDMI 2.0 wird entweder nur 24Hz oder ähnliches genutzt, weil das meiste Filmmaterial eh nur 24Hz ist, dann geht 10 Bit natürlich. Auch 12 Bit für Dolby Vision. Oder es wird 4:2:0 Chroma Subsampling genutzt, weil so gut wie jedes Consumer-Filmformat eh 4:2:0 hat.

Zuletzt bearbeitet:

- Registriert

- Nov. 2006

- Beiträge

- 967

Mit 4K und HDR ist echt alles komplizierter geworden, das ist doch ein einziges Minenfeld 😅

Also brauche ich ein Gerät mit HDMI 2.1?

Und anscheinend reicht es nicht, dass auf der GPU 4K hardware decoding drauf steht, damit sie das auch wirklich kann...

Wie soll man denn da eine Wahl treffen?

Also brauche ich ein Gerät mit HDMI 2.1?

Und anscheinend reicht es nicht, dass auf der GPU 4K hardware decoding drauf steht, damit sie das auch wirklich kann...

Wie soll man denn da eine Wahl treffen?

Alexander2

Fleet Admiral

- Registriert

- Aug. 2014

- Beiträge

- 15.387

Ja, das beste für deine Gesundheit wäre schreib den dreck ab und genieße die Filme (deren Inhalt/nicht die Technik mit der sie gemacht sind)

Einfacher aber auch nicht Billig ist nen Blueray Player an der Glotze denke ich. Aber selbst die brauchen updates und haben hbier und da Probleme.

Ich hatte mal einen und der lag ne weile im Schrank, als ich den dann mal ausgepackt habe und nutzen wollte für nen Film hat ders auch nicht gebacken bekommen (Tolle DRM gedöns Technik)

(Tolle DRM gedöns Technik)

Und dabei zwingen die einen dabei sogar noch deren Werbung von der Scheibe zu schauen.

Es ist ne einzige große Katastrophe

Einfacher aber auch nicht Billig ist nen Blueray Player an der Glotze denke ich. Aber selbst die brauchen updates und haben hbier und da Probleme.

Ich hatte mal einen und der lag ne weile im Schrank, als ich den dann mal ausgepackt habe und nutzen wollte für nen Film hat ders auch nicht gebacken bekommen

Und dabei zwingen die einen dabei sogar noch deren Werbung von der Scheibe zu schauen.

Es ist ne einzige große Katastrophe

Prollpower

Captain

- Registriert

- Juli 2008

- Beiträge

- 4.026

W0dan schrieb:@Prollpower

Hast du die "Filme & TV" App von Windows 10/11 schonmal probiert? Die ist was Hardwaredecodingkompatibilität und Performance angeht ungeschlagen.

Danke, aber wenn ich schon schreibe, es liegt in einem Format (HEVC, 4K, Chromasubsampling 4:2:2) vor, wo es KEINE Hardwareunterstüzung, !!offiziell bei Nvidia angegeben, dann wird es auch kein anderer Player ändern.

@Prollpower

Wie gesagt, ich hatte ein Format, das von Maxwell nicht unterstützt wurde und konnte es mit keinem anderen Player außer dem Windows Player flüssig abspielen.

Das war ja genau der Grund, warum ich den Kommentar geschrieben habe.

Wie gesagt, ich hatte ein Format, das von Maxwell nicht unterstützt wurde und konnte es mit keinem anderen Player außer dem Windows Player flüssig abspielen.

Das war ja genau der Grund, warum ich den Kommentar geschrieben habe.

Ähnliche Themen

- Antworten

- 24

- Aufrufe

- 1.352

- Antworten

- 9

- Aufrufe

- 917