Cool Master

Fleet Admiral

- Registriert

- Dez. 2005

- Beiträge

- 37.413

Abend,

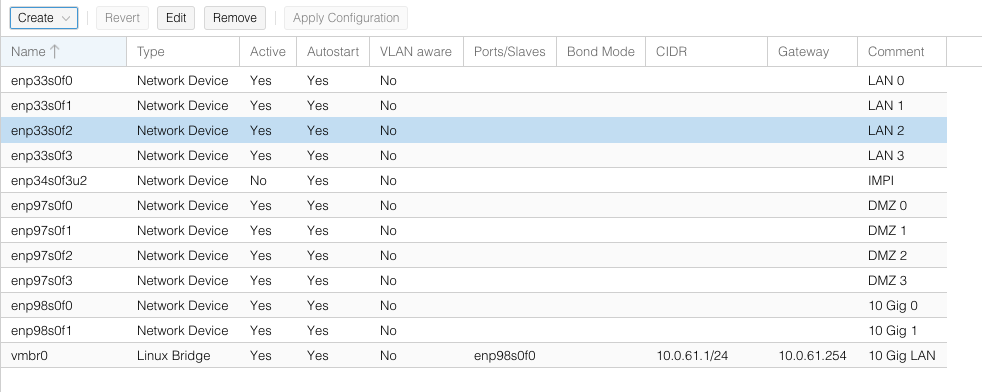

ich stehe wohl einfach aktuell auf dem Schlauch da ich zum ersten Mal Proxmox (6.4) nutze. Mein NICs sieht wie folgt aus:

Ich komme mittels https://10.0.61.1:8006 ohne Probleme auf Proxmox. Wie auf dem Screenshot zu sehen habe ich Kommentare gesetzt was der Port sein soll. Ich stelle mir es gerade so vor:

10 Gig 0 = 10.0.61.1 (geht ohne Probleme)

LAN 0 = 10.0.61.240

LAN 1 = 10.0.61.241

LAN 2 = 10.0.61.242

LAN 3 = 10.0.61.243

IPMI = 10.0.61.2 (geht auch ohne Probleme)

10 Gig 1 = x.x.x.230 (Sollte Proxmox übers Internet sein, falls das geht)

DMZ 0 = x.x.x.180

DMZ 1 = x.x.x.181

DMZ 2 = x.x.x.182

DMZ 3 = x.x.x.183

Meine Frage ist nun wie richte ich die Netzwerkkarten ein, damit ich diese für die VMs nutzen kann? Ich stehe da aktuell voll aufm Schlauch. Des Weiteren kann ich die Interfaces auf eth0, eth1 etc. umbennen oder gibt das Probleme in Proxmox?

ich stehe wohl einfach aktuell auf dem Schlauch da ich zum ersten Mal Proxmox (6.4) nutze. Mein NICs sieht wie folgt aus:

- 2x 10 GBit Onboard (Aktuell nur 1 GBit in Nutzung)

- 1x LAN

- 1x DMZ

- 4x Intel 1 GBIt (Intel I350-T4 V2) für LAN

- 4x Intel 1 Gbit (Intel I350-T4 V2) für DMZ

Ich komme mittels https://10.0.61.1:8006 ohne Probleme auf Proxmox. Wie auf dem Screenshot zu sehen habe ich Kommentare gesetzt was der Port sein soll. Ich stelle mir es gerade so vor:

10 Gig 0 = 10.0.61.1 (geht ohne Probleme)

LAN 0 = 10.0.61.240

LAN 1 = 10.0.61.241

LAN 2 = 10.0.61.242

LAN 3 = 10.0.61.243

IPMI = 10.0.61.2 (geht auch ohne Probleme)

10 Gig 1 = x.x.x.230 (Sollte Proxmox übers Internet sein, falls das geht)

DMZ 0 = x.x.x.180

DMZ 1 = x.x.x.181

DMZ 2 = x.x.x.182

DMZ 3 = x.x.x.183

Meine Frage ist nun wie richte ich die Netzwerkkarten ein, damit ich diese für die VMs nutzen kann? Ich stehe da aktuell voll aufm Schlauch. Des Weiteren kann ich die Interfaces auf eth0, eth1 etc. umbennen oder gibt das Probleme in Proxmox?