Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

[Sammelthread] AI - Bildgenerierung (Stable Diffusion, Midjourney & Co)

- Ersteller MechanimaL

- Erstellt am

- Registriert

- Nov. 2005

- Beiträge

- 1.153

Also um meine Frage zu konkretisieren, ob Amuse selbst eine nicht schaltbare Filter/Zensurfunktion integriert hat, in der offiziellen Version? Manche Models stellen bestimmte Sachen nicht oder schlecht dar, das ist klar, mir geht es rein um das Programm selbst.

- Registriert

- Nov. 2005

- Beiträge

- 1.153

Midjourney hat eine umfangreiche Bildbearbeitungsfunktion (inpainting, ebenen usw.) bekommen:

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Und für Flux gibt es möglicherweise Wachablösung.

Mit HiDream AI gibt es jetzt ein chinesisches OpenSource T2I-Model mit 17B Parametern und laut der Firma ausgezeichneten Benchmark-Ergebnissen:

https://github.com/HiDream-ai/HiDream-I1

Wenn ich das richtig sehe ist das auch nicht distilled, wie die open weights Flux Optionen.

Ob es allerdings für die Community einfach zu trainieren ist, ist fraglich... bei 17B Parametern fürs Generieren und google/t5-v1_1-xxl (11B Parameter?) sowie Meta-Llama-3.1-8B-Instruct (8B Parameter) als Text-Encoder ist das ein echtes Schwergewicht.

Aber Quantization soll wohl reichen um das mit 24GB oder sogar 16GB VRAM nutzen zu können - Text und Image Modelle müssen ja nicht gleichzeitig im VRAM geladen sein.

Es gibt natürlich auch schon erste Ansätze für bessere NSFW Eignung, primär durch Verwendung von de-zensierten Encoder Varianten:

https://civitai.com/models/1496362/hidream-full-gguf-q5km-uncensored

Von AITrepreneur gibt's auch ein Video dazu, welches mich zum Thema aufmerksam gemacht hatte:

Ich werd's mir auf jeden Fall die nächsten Tage mal anschauen.

Mit HiDream AI gibt es jetzt ein chinesisches OpenSource T2I-Model mit 17B Parametern und laut der Firma ausgezeichneten Benchmark-Ergebnissen:

https://github.com/HiDream-ai/HiDream-I1

Wenn ich das richtig sehe ist das auch nicht distilled, wie die open weights Flux Optionen.

Ob es allerdings für die Community einfach zu trainieren ist, ist fraglich... bei 17B Parametern fürs Generieren und google/t5-v1_1-xxl (11B Parameter?) sowie Meta-Llama-3.1-8B-Instruct (8B Parameter) als Text-Encoder ist das ein echtes Schwergewicht.

Aber Quantization soll wohl reichen um das mit 24GB oder sogar 16GB VRAM nutzen zu können - Text und Image Modelle müssen ja nicht gleichzeitig im VRAM geladen sein.

Es gibt natürlich auch schon erste Ansätze für bessere NSFW Eignung, primär durch Verwendung von de-zensierten Encoder Varianten:

https://civitai.com/models/1496362/hidream-full-gguf-q5km-uncensored

Von AITrepreneur gibt's auch ein Video dazu, welches mich zum Thema aufmerksam gemacht hatte:

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Ich werd's mir auf jeden Fall die nächsten Tage mal anschauen.

- Registriert

- Nov. 2005

- Beiträge

- 1.153

Ah ich dachte, wir hätten es hier schon erwähnt ^^ Bin auch grade dran das nochmal näher zu testen, als es erschien, waren erste Ergebnisse noch nicht so toll, da war aber auch einiges noch nicht so bekannt (settings, detailer usw.) und es war sehr langsam (full). Jetzt habe ich schon an versch. Stelle gelesen/gehört, dass dev schneller und nicht schlechter ist. Lass uns einfach mal Ergebnisse und Erkenntnisse hier teilen.

Generell auch interessante Idee, bei Modellen die llama encoder nutzen, da auf abliterated varianten zuzugreifen.

Parallel wollte ich auch das noch testen: https://huggingface.co/lodestones/Chroma

Generell auch interessante Idee, bei Modellen die llama encoder nutzen, da auf abliterated varianten zuzugreifen.

Parallel wollte ich auch das noch testen: https://huggingface.co/lodestones/Chroma

Zuletzt bearbeitet:

- Registriert

- Nov. 2005

- Beiträge

- 1.153

Hier mal ein Vergleichs mit Tarantulas und Bergmännern. Cfg wert 1,1.5,2 pro "dev" Model und jeweils detailer an+aus. Settings vom Detailer sind wie im Airtrepenuer Workflow.

Noch zwei Bergarbeiter in höheren auflösungen 1280x1280, 1504x1504 (q8_full mit detailer). Interessant zu beobachten, wie sich von 1024-1504 der Bildausschnitt jeweils vergrößert:

Noch zwei Bergarbeiter in höheren auflösungen 1280x1280, 1504x1504 (q8_full mit detailer). Interessant zu beobachten, wie sich von 1024-1504 der Bildausschnitt jeweils vergrößert:

Zuletzt bearbeitet:

- Registriert

- Nov. 2005

- Beiträge

- 1.153

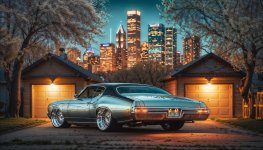

Auch mit dem Fast Modell von HiDream können schon ordentliche Bilder erzeugt werden, wie man hier sieht. Allerdings wird kritisiert, dass die Komposition nicht sehr spannend ist (häufig zentriertes Subjekt). Das ist mir auch aufgefallen. Nichtsdestotrotz ist die Qualität (mit Upscaling), schon recht ansehlich. Die folgenden Bilder hab ich direkt in SwarmUI gemacht. Aber weiteres Testen ist nötig, es entstehen z.T. Artefakte/Schlieren um Ränder von Objekten.. Mit bestimmten Upscalern geht das auch wieder ganz weg. Im Moment gibt es noch zuviele nicht ganz klare Parameter für mich, z.B. was ist beste Sampler/Scheduler Kombi, Sigma-Wert (3-6), Detail Daemon Ja/nein/werte, was als Ausgangsauflösung, bevorzugter Upscale-Prozess usw. ^^

Da ich mich aber grade mehr mit Video beschäftigen wollte, werde ich mich daran jetzt nicht festbeißen und gelegentlich, mal Flux vs Hidream testen und natürlich die Entwicklung bzgl. Finetune Models, LORAs und weiterer Erkenntnisse im Auge behalten.

Hier noch ein weiterer, übersichtlicher Workflow, der auch den Detailer (ohne Lying Sigma) mit an Board hat.

Anbei noch ein paar Bilder von gestern Abend (nix besonderes), mit Hidream Dev direkt in SwarmUI gemacht.

Edit:

HiDream-dev, mit Euler/Normal, CFG1, SigmaShift3 und etwas höherer Base-Auflösung (kein Upscale):

Es lohnt sich auf jedenfall mit einer leicht erhöhten "Base"-Auflösung zu arbeiten. Also bei 4:3/3:2 usw. schon 1024 als den kleinsten Wert zu benutzen (wie beim Löwen oben). Von da lassen sich dann noch gut Upscaling Prozesse einsetzen. Vergleich Base vs leicht erhöht:

Da ich mich aber grade mehr mit Video beschäftigen wollte, werde ich mich daran jetzt nicht festbeißen und gelegentlich, mal Flux vs Hidream testen und natürlich die Entwicklung bzgl. Finetune Models, LORAs und weiterer Erkenntnisse im Auge behalten.

Hier noch ein weiterer, übersichtlicher Workflow, der auch den Detailer (ohne Lying Sigma) mit an Board hat.

Anbei noch ein paar Bilder von gestern Abend (nix besonderes), mit Hidream Dev direkt in SwarmUI gemacht.

Edit:

HiDream-dev, mit Euler/Normal, CFG1, SigmaShift3 und etwas höherer Base-Auflösung (kein Upscale):

Prompt: A majestic male lion with a thick, golden mane, his intense amber eyes gazing directly ahead, stands in the tall grasses of the African savannah. The setting sun bathes the scene in warm hues of orange and gold, casting a radiant glow on his fur. His powerful frame is partially silhouetted against the vibrant sky, highlighting the contours of his muscular build. The surrounding landscape features sparse acacia trees and distant rolling hills, all under a sky painted with streaks of crimson and purple. The close-up perspective captures the lion's regal presence and the serene beauty of the savannah at dusk.

Alamy+12,

Model: HiDream/hiDreamI1Dev_devQ8.gguf, Seed: 1412764184, Steps: 28, CFG Scale: 1, Aspect Ratio: Custom, Width: 1536, Height: 1024, Sampler: Euler, Scheduler: Normal

Alamy+12,

Model: HiDream/hiDreamI1Dev_devQ8.gguf, Seed: 1412764184, Steps: 28, CFG Scale: 1, Aspect Ratio: Custom, Width: 1536, Height: 1024, Sampler: Euler, Scheduler: Normal

Es lohnt sich auf jedenfall mit einer leicht erhöhten "Base"-Auflösung zu arbeiten. Also bei 4:3/3:2 usw. schon 1024 als den kleinsten Wert zu benutzen (wie beim Löwen oben). Von da lassen sich dann noch gut Upscaling Prozesse einsetzen. Vergleich Base vs leicht erhöht:

Zuletzt bearbeitet:

ChatGehPeeTee

Banned

- Registriert

- März 2025

- Beiträge

- 822

Amuse funktioniert auch mit nvidia und wird auch die GPU genutzt.

Sowohl Bild als auch "Video"

Mit RTX 5070 TI getestet

Gibts eig sowas auch für nvidia? also so ne geile .exe wo alles mit dabei ist^^

Funktioniert zwar auch so aber evtl gibts ja nice features oder mehr speed...

Sowohl Bild als auch "Video"

Mit RTX 5070 TI getestet

Gibts eig sowas auch für nvidia? also so ne geile .exe wo alles mit dabei ist^^

Funktioniert zwar auch so aber evtl gibts ja nice features oder mehr speed...

Zuletzt bearbeitet:

- Registriert

- Nov. 2005

- Beiträge

- 1.153

@ChatGehPeeTee Bei den verfügbaren GUIs für lokale Anwendung (etliche sind auf der ersten Seite verlinkt) gibt es vll. das ein oder andere, wo Du bereits aus dem Programm raus auch Modelle usw. laden kannst (Ich glaube bei invoke ist das so). One click installer haben die meisten. Es wird aber meistens kein Weg dran vorbeiführen sich noch etwas näher damit zu beschäftigen, was so oder so, wenn Du Deine Ergebnisse verbessern willst usw. der Fall sein wird. Ich kann Dir aus meiner Erfahrung heraus jetzt nicht xy empfehlen, wenn Du es so einfach wie möglichst haben willst, da ich nicht alles selbst getestet habe, vll hat da jemand anderes auch noch eine Idee. Für die Zukunftsfähigkeit bist Du aber mit SwarmUI gut aufgehoben, du hast comfyUI integriert und eine kontinuierliche Entwicklung jetzt schon über einen längeren Zeitraum, in dem viele andere GUIs eingestellt worden oder ständig ein anderer Fork zu empfehlen ist, da der Originalentwickler nichts mehr macht(e).

Sympathische Website: Absolut nichts zu blocken.

Ich "arbeite" mit ComfyUI. Sehr flexibel, aber mit ordentlich Einarbeitung verbunden, wenn man die Ergebnisse maximieren möchte. Allerdings gibt es eine Menge Workflow-Templates, mit denen man anfangen, experimentieren und lernen kann.

SwarmUI werde ich mir aber auch mal anschauen.

Ich "arbeite" mit ComfyUI. Sehr flexibel, aber mit ordentlich Einarbeitung verbunden, wenn man die Ergebnisse maximieren möchte. Allerdings gibt es eine Menge Workflow-Templates, mit denen man anfangen, experimentieren und lernen kann.

SwarmUI werde ich mir aber auch mal anschauen.

Rickmer schrieb:ich habe vergessen, wie mies die Hände im Allgemeinen sind...

Wohl eher das.

- Registriert

- Nov. 2005

- Beiträge

- 1.153

Mein erster Eindruck ist auch, dass die Hände schlechter sind, als in Flux. Aber wir haben ja Flux Fill zum VerbessernRickmer schrieb:Kommt es mir nur so vor, oder ist HiDream sehr schlecht was Hände angeht?

edit: Oder es ist ein Weilchen her, dass ich zuletzt viel mit AI Bildern gemacht habe und ich habe vergessen, wie mies die Hände im Allgemeinen sind...

- Registriert

- Nov. 2005

- Beiträge

- 1.153

Hat schon jemand das neue "LTX Video 13b distilled fp8" Model ausprobiert? Das ist mit Abstand das schnellste, was ich je an Video Generierung gesehen habe. Mit dem Q8 Kernel Paket von LTX wird die Dauer für die Erstellung nochmal halbiert. Videos in Sekunden lokal generieren.

https://ibb.co/3yd6bhdH

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

https://ibb.co/3yd6bhdH

Emil Galotti

Ensign

- Registriert

- Okt. 2018

- Beiträge

- 171

Hallo,

auch auf die Gefahr hin, hier komplett falsch zu sein, möchte ich ein paar Zeilen, eventuell sogar zum Thema, loswerden.

Vor einigen Wochen habe ich mich erstmals mit Ai- erstellten Videos auseinandergesetzt, und war eigentlich verblüfft, was heute schon möglich erscheint.

Insbesondere hat es mit diese Künstlerin angetan, hier eine best of collection auf You Tube:

Erstaunlich die Vielfalt, die hohe Qualität der Texturen, der abstrakte Aberwitz mit den enorm schnellen Übergängen, die sonst eigentlich per CGI nicht hinzubekommen sind.

Und sie bringt Fast jeden Tag einen neuen Clip auf den Markt

Laut ihrer Beschreibung sind stets angepasste Aufnahmen von Menschen , Maschinen oder Gegenständen Ausgang für die verschiedenen Programme Animationen zu erstellen, was durchaus kostspielig sein kann.

Andererseits reicht auch ein relativ einfacher PC, für Edition und Schnitt und Farbkorrektur.

Obwohl auch noch viele Defizite in den Videos erkennbar sind, vor allem die Füße und Hände, halte ich diese Art der Kreativität durchaus zukunftsträchtig, weiß aber noch nicht wirklich, wie der Ablauf ist.

Vielleicht ist mir die Zukunft schon begegnet, ohne es direkt zu erkennen.

Ich habe viele selbst gerenderte Bilder abstrakter Natur, die ich gern einmal auf eine andere Art animieren möchte, außerhalb eines §D- Programmes.

welches Programm ist versuchsweise empfehlenswert, welche Schritte muss man am Anfang beachten?

Emil Galotti.

Sollte ich fehlplaziert sein, oder die Ordnung stören, bitte einfach löschen.

auch auf die Gefahr hin, hier komplett falsch zu sein, möchte ich ein paar Zeilen, eventuell sogar zum Thema, loswerden.

Vor einigen Wochen habe ich mich erstmals mit Ai- erstellten Videos auseinandergesetzt, und war eigentlich verblüfft, was heute schon möglich erscheint.

Insbesondere hat es mit diese Künstlerin angetan, hier eine best of collection auf You Tube:

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Erstaunlich die Vielfalt, die hohe Qualität der Texturen, der abstrakte Aberwitz mit den enorm schnellen Übergängen, die sonst eigentlich per CGI nicht hinzubekommen sind.

Und sie bringt Fast jeden Tag einen neuen Clip auf den Markt

Laut ihrer Beschreibung sind stets angepasste Aufnahmen von Menschen , Maschinen oder Gegenständen Ausgang für die verschiedenen Programme Animationen zu erstellen, was durchaus kostspielig sein kann.

Andererseits reicht auch ein relativ einfacher PC, für Edition und Schnitt und Farbkorrektur.

Obwohl auch noch viele Defizite in den Videos erkennbar sind, vor allem die Füße und Hände, halte ich diese Art der Kreativität durchaus zukunftsträchtig, weiß aber noch nicht wirklich, wie der Ablauf ist.

Vielleicht ist mir die Zukunft schon begegnet, ohne es direkt zu erkennen.

Ich habe viele selbst gerenderte Bilder abstrakter Natur, die ich gern einmal auf eine andere Art animieren möchte, außerhalb eines §D- Programmes.

welches Programm ist versuchsweise empfehlenswert, welche Schritte muss man am Anfang beachten?

Emil Galotti.

Sollte ich fehlplaziert sein, oder die Ordnung stören, bitte einfach löschen.

Zuletzt bearbeitet:

- Registriert

- Nov. 2005

- Beiträge

- 1.153

Was Du möchtest ist image2video bzw. video2video. Es gibt im lokalen Bereich mehrere Modelle, die das können, in unterschiedlicher Qualität/Geschwindigkeit. Mittlerweile gibt es sogar recht fortgeschrittene Funktionen, mit denen Du Deine Videos kontrollieren kannst, bis hin zu Kamerabewegungen - da erscheinen in den letzten paar Wochen sehr viele Neuheiten und Updates in punkto lokaler Videogenerierung.

Bzgl. Programm/GUI: Am besten fährst Du mit ComfyUI und dann lädst Du dort Workflows rein. Du könntest mit Youtube Tutorials arbeiten, die Schritt für Schritt sagen, welche Dateien Du wo in ComfyUI speichern musst und einen passenden Workflow (den lädst Du dann dort rein) zur Verfügung stellen.

Welche Hardware steht Deinerseits zur Verfügung? Kannst Du engl. bzw. sind englischsprachige Videos für Dich ok?

Bzgl. Programm/GUI: Am besten fährst Du mit ComfyUI und dann lädst Du dort Workflows rein. Du könntest mit Youtube Tutorials arbeiten, die Schritt für Schritt sagen, welche Dateien Du wo in ComfyUI speichern musst und einen passenden Workflow (den lädst Du dann dort rein) zur Verfügung stellen.

Welche Hardware steht Deinerseits zur Verfügung? Kannst Du engl. bzw. sind englischsprachige Videos für Dich ok?

Emil Galotti

Ensign

- Registriert

- Okt. 2018

- Beiträge

- 171

@MechanimaL

Vielen Dank für das rasche Feedback und die Empfehlung.

Ein node based System erzeugt nach meinem langen vergeblichen Versuch Houdini ausreichend zu erlernen erst einmal Gänsehaut, aber vielleicht kann ich mich hier durchsetzen.

Zur Verfügung stehen mit z, Z. zwei PC`s, die mit fachkräftiger Unterstützung dieses Forum von mir zusammengeschraubt wurden, beide mit je 128 GB Ram, Ryzen 9 3900,bzw. 5950, mit kleiner Graka (GTX 1060) da ich für Renderarbeiten ausschließlich den Corona Renderer verwende.

Es scheint schwierig zu sein, erst einmal einen Einstieg aufgrund der Vielzahl der Produkte zu finden, die auch den eigenen Fähigkeiten entsprechen.

Kannst Du vielleicht noch ein Lernvideo benennen, welches sich gut als Einstieg eignet (gern in Englisch)?

Besten Dank schon vorab

EM

Vielen Dank für das rasche Feedback und die Empfehlung.

Ein node based System erzeugt nach meinem langen vergeblichen Versuch Houdini ausreichend zu erlernen erst einmal Gänsehaut, aber vielleicht kann ich mich hier durchsetzen.

Zur Verfügung stehen mit z, Z. zwei PC`s, die mit fachkräftiger Unterstützung dieses Forum von mir zusammengeschraubt wurden, beide mit je 128 GB Ram, Ryzen 9 3900,bzw. 5950, mit kleiner Graka (GTX 1060) da ich für Renderarbeiten ausschließlich den Corona Renderer verwende.

Es scheint schwierig zu sein, erst einmal einen Einstieg aufgrund der Vielzahl der Produkte zu finden, die auch den eigenen Fähigkeiten entsprechen.

Kannst Du vielleicht noch ein Lernvideo benennen, welches sich gut als Einstieg eignet (gern in Englisch)?

Besten Dank schon vorab

EM

- Registriert

- Nov. 2005

- Beiträge

- 1.153

Ich befürchte, mit der 1060 wirst Du bzgl. Videogenerierung auf keinen grünen Zweig kommen. Nach dem was ich so lese, würde es ewig dauern und die Qualität wäre auch nicht sehr ansehlich. Tut mir leid. Da würde ich dann eher zu einer Website greifen, wo Du Deine Werke zum Leben erwecken kannst. Ich schicke Dir eine Liste. Manche bieten auch kostenlose Möglichkeiten (diese sind zwar häufig mit langer Wartezeit oder Einschränkungen bei Länge und Qualität versehen, kann aber trotzdem Spaß machen oder einen ersten Eindruck bieten).

Alle Angaben ohne Gewähr

PS: Wenn Du trotzdem lokal was testen möchtest, dann wäre FramePack evtl möglich, es ermöglicht ordentliche Qualität auch mit niedrigem VRAM, allerdings müsstest Du einen Fork vom orginalen Repo probieren, d.h. eine etwas angepasste Version vom Originalprogramm, der für die 20er Serie gemacht ist - da hat ein 1080ti user berichtet, es hätte geklappt, muss natürlich nicht heißen, dass es mit der 1060 auch geht, aber testen kostet ja nix..

https://github.com/freely-boss/FramePack-nv20 (da ist eine Installations- und Nutzungsanleitung dabei, ansonsten bei youtube nach Framepack local oder ähnlich suchen).

Multi-Modell:

Ich ergänze den Beitrag noch um 2 Videos: Einmal ein Tutorial zum WAN basierten VACE (All-in-One Video Creation and Editing) (lokale Anwendung) und eine Vorführung von 60 nutzergenerierten Clips des neuen VEO3 Modell von Google:

Alle Angaben ohne Gewähr

PS: Wenn Du trotzdem lokal was testen möchtest, dann wäre FramePack evtl möglich, es ermöglicht ordentliche Qualität auch mit niedrigem VRAM, allerdings müsstest Du einen Fork vom orginalen Repo probieren, d.h. eine etwas angepasste Version vom Originalprogramm, der für die 20er Serie gemacht ist - da hat ein 1080ti user berichtet, es hätte geklappt, muss natürlich nicht heißen, dass es mit der 1060 auch geht, aber testen kostet ja nix..

https://github.com/freely-boss/FramePack-nv20 (da ist eine Installations- und Nutzungsanleitung dabei, ansonsten bei youtube nach Framepack local oder ähnlich suchen).

| Anbieter | Preis/Monat (USD) | Hauptfunktionen | Bemerkungen |

|---|---|---|---|

| Runway | $12 (Standard), $28 (Pro), $76 (Unlimited) | Text-/Bild-/Video-zu-Video, Gen-4 Turbo, benutzerdefinierte Stimmen, Lip-Sync, Wasserzeichen entfernen | Pro-Plan bietet erweiterte Funktionen; Unlimited-Plan ermöglicht unbegrenzte Video-Generierung. |

| Kling AI | $3.88 (Standard), $12.88 (Pro), $28.88 (Premier) | Text-/Bild-zu-Video, Multi-Element-Bearbeitung, HD-Qualität, Wasserzeichen entfernen | Günstige Einstiegspreise; Premier-Plan bietet erweiterte Bearbeitungsfunktionen. |

| Luma AI | $9.99 (Lite), $29.99 (Plus), $94.99 (Unlimited) | Text-/Bild-zu-Video, 1080p-Videos, kommerzielle Nutzung, keine Wasserzeichen | Plus-Plan erlaubt kommerzielle Nutzung; Unlimited-Plan bietet unbegrenzte Generierungen. |

| Adobe Firefly Video | $9.99 (20 Clips), $29.99 (70 Clips) | 5-Sekunden-Clips in 1080p, Integration mit Premiere Pro, Fokus auf Qualität | Ideal für professionelle Anwendungen; zukünftige 4K-Unterstützung geplant. |

| Google Flow (Veo 3) | Teil von Google AI Pro/Ultra-Plänen | Text-/Bild-zu-Video, 8-Sekunden-Clips, Szenen-Builder-Tools | Verfügbar in den USA; Teil von Google AI Pro und Ultra Plänen. |

| OpenAI Sora | $20 (ChatGPT Plus), $200 (ChatGPT Pro) | Text-zu-Video, 5–20 Sekunden, 720p–1080p-Auflösung | In ChatGPT Plus/Pro integriert; begrenzte Videolängen. |

| Pika Labs | $3.88 (Standard), $12.88 (Pro), $28.88 (Premier) | Text-/Bild-zu-Video, anpassbare Stile, VFX-Optionen | Erschwingliche Preise; Pro-Plan bietet erweiterte Funktionen. |

| Minimax/Hailuo | Kostenlos (mit täglichen Credits) | Text-/Bild-zu-Video, einfache Bedienung | Kostenlos mit täglichen Credits; begrenzte Funktionen. |

Multi-Modell:

| Plattform | Unterstützte Modelle | Preisstruktur | Besonderheiten |

|---|---|---|---|

| Pollo AI | Kling 1.6, Luma Ray 2, Runway Gen-3, Flux, u.a. | Ab $20/Monat | Bietet eine Vielzahl von Modellen in einer Oberfläche; zusätzliche Funktionen wie Videoeffekte und Upscaling. |

| Krea AI | Kling, Luma, Runway, Minimax, Pika | Kostenlos mit Premiumoptionen | Ermöglicht die Auswahl des gewünschten Modells pro Projekt; intuitive Benutzeroberfläche. |

| AI Animation Studio | Kling, Luma, Runway, Pika, Minimax | Preisgestaltung für Profis | Fokus auf professionelle Workflows; bietet Projektordner und erweiterte Bearbeitungstools. |

| LTX Studio | Kling, Luma, Runway, Pika, u.a. | Ab $15/Monat | Integrierte Storyboarding- und Skriptfunktionen; ideal für narrative Projekte. |

Ich ergänze den Beitrag noch um 2 Videos: Einmal ein Tutorial zum WAN basierten VACE (All-in-One Video Creation and Editing) (lokale Anwendung) und eine Vorführung von 60 nutzergenerierten Clips des neuen VEO3 Modell von Google:

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Zuletzt bearbeitet:

painomatic

Lt. Commander

- Registriert

- Okt. 2010

- Beiträge

- 1.104