Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Server Read Performance

- Ersteller nutsman

- Erstellt am

Nach guten 4 Tagen ist das RAID 1 mit 10TB wieder ready

Habe nun die Array Settings nochmal kontrolliert und identisch gesetzt.

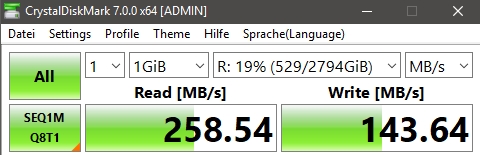

Hier nun ein Bench auf das Array mit 3 TB

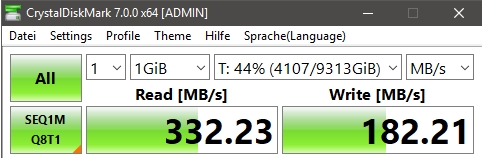

Hier der Bench auf das Array mit 10 TB

Netzwerk 1 GBit's nun in beide Richtungen wieder Full Speed

Habe mir vorhin noch einen 5 Port Switch (2,5GBit's) bestellt. Darüber kann ich dann den Server mit

meiner Hauptarbeitsstation anbinden und hoffentlich den Transfer noch weiter steigern.

Die 2,5GBit's NICs sind auf den Mainboards schon vorhanden.

Was mich nun wundert ist das der Write Speed auf dem 10 TB mit 256KB Stip Size ein wenig geringer ausfällt. Mit einer BBU könnte man noch "Write Back" aktivieren, jedoch sind dann gleich wieder 200€ fällig

Überlege mir gerade ob ich noch "Cached IO" aktivieren soll

* Cached IO: In this mode, all reads are buffered in cache memory.

* Direct IO (Default) In this mode, reads are not buffered in cache memory. Data is transferred to the cache and the host concurrently. If the same data block is read again, it comes from cache memory.

Cached IO provides faster processing, and Direct IO makes sure that the cache and the host contain the same data.

Hatte es mal Testweise auf dem 3TB Array aktiviert und beim Bench einen Read von über 5000MB's

vermutlich weil er die Benchmark Files direkt im Cache lässt und und somit verdammt schnell darauf zugreifen kann. Bringt es im Real Life auch einen großen Vorteil ???

Server ist mit einer USV abgesichert sollte also nix schief gehen können.....

Habe nun die Array Settings nochmal kontrolliert und identisch gesetzt.

- Stip Size 256 KB

- Disk cache enable

- Always read ahead

- Direct IO

- Write Through ("Always Write Back" & "Write Back" not available when BBU absent)

Hier nun ein Bench auf das Array mit 3 TB

Hier der Bench auf das Array mit 10 TB

Netzwerk 1 GBit's nun in beide Richtungen wieder Full Speed

Habe mir vorhin noch einen 5 Port Switch (2,5GBit's) bestellt. Darüber kann ich dann den Server mit

meiner Hauptarbeitsstation anbinden und hoffentlich den Transfer noch weiter steigern.

Die 2,5GBit's NICs sind auf den Mainboards schon vorhanden.

Was mich nun wundert ist das der Write Speed auf dem 10 TB mit 256KB Stip Size ein wenig geringer ausfällt. Mit einer BBU könnte man noch "Write Back" aktivieren, jedoch sind dann gleich wieder 200€ fällig

Überlege mir gerade ob ich noch "Cached IO" aktivieren soll

* Cached IO: In this mode, all reads are buffered in cache memory.

* Direct IO (Default) In this mode, reads are not buffered in cache memory. Data is transferred to the cache and the host concurrently. If the same data block is read again, it comes from cache memory.

Cached IO provides faster processing, and Direct IO makes sure that the cache and the host contain the same data.

Hatte es mal Testweise auf dem 3TB Array aktiviert und beim Bench einen Read von über 5000MB's

vermutlich weil er die Benchmark Files direkt im Cache lässt und und somit verdammt schnell darauf zugreifen kann. Bringt es im Real Life auch einen großen Vorteil ???

Server ist mit einer USV abgesichert sollte also nix schief gehen können.....

Kommt halt drauf an ob die Daten im Cache liegen oder nicht. Wenn ja ist es fast wie aus ner RAM Disk zu arbeiten, wenn nicht bringt der Cache nichts. Also wie immer bei Caches.

Zudem kommt es halt darauf an, was man macht. Wenn man ein file öffnet mit vom daran meditiert und wieder schließt bringt es nichts. Bei ner unter Last stehenden kleinen MySQL DB dann schon wieder. Wo man es z.b. massiv merkt ist bei einem yum install unter CentOS/RedHat

Klar soweit?

Wobei man sagen muss read aus dem Cache bringt jetzt nicht sooo viel bei einem Host. Der kann ja auch selbst einfach im RAM Speichern was normal auch gemacht wird. Eventuell nur nicht in HA setups, aber anderes Thema. Obiger Fall tritt also meist nur auf wenn mehrere/viele die gleichen Daten lesen. Z.b. bei nem MPI Job am Anfang.

Das Meiste bringt dass der posted Write also mit flush vom Controller mit Cache schon als erledigt gemeldet wird wenn die Daten im Cache stehen und nicht wenn es auf der HDD liegt. Da liegt ne Größenordnung oder mehr dazwischen.

Bei yum macht das durchaus den Unterschied zwischen Minuten und Sekunden. Ist aber recht speziell..

Als Test kannst du durchaus gerne mal ne RAM disk erstellen und mit der deine Anwendungen Testen und dann entscheiden ob es dir das Wert ist. Als HomeUser und selbst in nem KMU wird die Antwort wohl meistens nein heißen

Zudem kommt es halt darauf an, was man macht. Wenn man ein file öffnet mit vom daran meditiert und wieder schließt bringt es nichts. Bei ner unter Last stehenden kleinen MySQL DB dann schon wieder. Wo man es z.b. massiv merkt ist bei einem yum install unter CentOS/RedHat

Klar soweit?

Wobei man sagen muss read aus dem Cache bringt jetzt nicht sooo viel bei einem Host. Der kann ja auch selbst einfach im RAM Speichern was normal auch gemacht wird. Eventuell nur nicht in HA setups, aber anderes Thema. Obiger Fall tritt also meist nur auf wenn mehrere/viele die gleichen Daten lesen. Z.b. bei nem MPI Job am Anfang.

Das Meiste bringt dass der posted Write also mit flush vom Controller mit Cache schon als erledigt gemeldet wird wenn die Daten im Cache stehen und nicht wenn es auf der HDD liegt. Da liegt ne Größenordnung oder mehr dazwischen.

Bei yum macht das durchaus den Unterschied zwischen Minuten und Sekunden. Ist aber recht speziell..

Als Test kannst du durchaus gerne mal ne RAM disk erstellen und mit der deine Anwendungen Testen und dann entscheiden ob es dir das Wert ist. Als HomeUser und selbst in nem KMU wird die Antwort wohl meistens nein heißen

ja so habe ich mich auch noch ein wenig eingelesen.

Cached IO oder Direct IO bingt in der Real Performance eher wenig.

Der größte Heben ist wohl noch die Write Back policy.

Ich habe mal testweise "Always Write Back" eingestellt, damit soll "Write Back" auch ohne BBU laufen.

Klar Gefahr von Datenverlust bei Stromausfall besteht aber warum hab ich den eine USV am Server stehen

Aktuell ist jetzt der Flaschenhals das Gbit's LAN welches voll ausgelastet wird, SUPI

Wenn der neue 2,5Gbit's Switch eingebaut ist sollte der HDD Speed vom Server auch über das Netzwerk kommen. Theoretisch sollten ja hier um die 280MB's möglich sein. Bin gespannt.....

Cached IO oder Direct IO bingt in der Real Performance eher wenig.

Der größte Heben ist wohl noch die Write Back policy.

Ich habe mal testweise "Always Write Back" eingestellt, damit soll "Write Back" auch ohne BBU laufen.

Klar Gefahr von Datenverlust bei Stromausfall besteht aber warum hab ich den eine USV am Server stehen

Aktuell ist jetzt der Flaschenhals das Gbit's LAN welches voll ausgelastet wird, SUPI

Wenn der neue 2,5Gbit's Switch eingebaut ist sollte der HDD Speed vom Server auch über das Netzwerk kommen. Theoretisch sollten ja hier um die 280MB's möglich sein. Bin gespannt.....

Ja aber dir kann halt noch immer das Netzteil etc abtauchen. Das passiert gar nicht mal so selten.

Aber muss jeder selbst entscheiden. Controller brauchen auch immer mal wieder ab...

Wir hatten in der Firma bei 100+ Controllern (raid&jbod) um letzten Jahr glaub 3 oder 7 Ausfälle. Also die Dinger waren dann wirklich Schrott und mussten ersetzt werden. Gut mache lief wohl auch schon 7 Jahre oder so, aber Ausfälle passieren.

Wir hatten dieses Jahr auch einmal den Ausfall von zwei Platten in einem ZFS disk Pool. Da haben die Leute geschwitzt bis der Rebuild durch war....

Unsere Systeme sind zwar "nur" als scratch gedacht aber real liegen dann doch auch länger wichtige Daten drauf. Und selbst wenn nicht. Wenn man zehntausende+ Core Stunden für ein Ereignis verballert hat tut es immer weh

Aber muss jeder selbst entscheiden. Controller brauchen auch immer mal wieder ab...

Wir hatten in der Firma bei 100+ Controllern (raid&jbod) um letzten Jahr glaub 3 oder 7 Ausfälle. Also die Dinger waren dann wirklich Schrott und mussten ersetzt werden. Gut mache lief wohl auch schon 7 Jahre oder so, aber Ausfälle passieren.

Wir hatten dieses Jahr auch einmal den Ausfall von zwei Platten in einem ZFS disk Pool. Da haben die Leute geschwitzt bis der Rebuild durch war....

Unsere Systeme sind zwar "nur" als scratch gedacht aber real liegen dann doch auch länger wichtige Daten drauf. Und selbst wenn nicht. Wenn man zehntausende+ Core Stunden für ein Ereignis verballert hat tut es immer weh

Heute einfach mal neugierig gewesen und die beiden NICs vom Server und Workstation mit 2,5GBit's über direktes Kabel verbunden zum testen (passender Switch noch nicht geliefert).

Die Performance steigert sich massiv in Verbindung mit "Write Back" dann geht Schreiben zum Server mit über 280MB's da merkt man deutlich die Nutzung vom Cache.

Lesen vom Server auch sehr ordentlich.

Je nach "Cached IO" oder "Direct IO" gibt es auch hier unterschiede bei den Arrays.

- Das RAID1 mit den 3TB HDDs läuft mit "Direct IO" besser - Lesen um die 220MB's

Bei "Cached IO" werden es nur 195MB's.

- Das RAID1 mit den 10TB HDDs läuft mit "Cached IO" besser - Lesen um die 250-260MB's

Bei "Direct IO" werden es nur 200-210MB's.

Die Umstellung auf 2,5GBit's LAN scheint sich zu lohnen und ist zudem noch für 4-5 Ports günstig da ich bereits ein paar NICs mit 2,5G habe.

Toll wäre auch 10GBit's LAN gewesen jedoch dann für jede Maschine eine PCIe Karte kaufen und die Switche sind auch noch nicht wirklich günstig. Das wird noch einige Zeit dauern....

Die Performance steigert sich massiv in Verbindung mit "Write Back" dann geht Schreiben zum Server mit über 280MB's da merkt man deutlich die Nutzung vom Cache.

Lesen vom Server auch sehr ordentlich.

Je nach "Cached IO" oder "Direct IO" gibt es auch hier unterschiede bei den Arrays.

- Das RAID1 mit den 3TB HDDs läuft mit "Direct IO" besser - Lesen um die 220MB's

Bei "Cached IO" werden es nur 195MB's.

- Das RAID1 mit den 10TB HDDs läuft mit "Cached IO" besser - Lesen um die 250-260MB's

Bei "Direct IO" werden es nur 200-210MB's.

Die Umstellung auf 2,5GBit's LAN scheint sich zu lohnen und ist zudem noch für 4-5 Ports günstig da ich bereits ein paar NICs mit 2,5G habe.

Toll wäre auch 10GBit's LAN gewesen jedoch dann für jede Maschine eine PCIe Karte kaufen und die Switche sind auch noch nicht wirklich günstig. Das wird noch einige Zeit dauern....

QNAP 5 Port 2.5Gbit's Switch für 110€ und bei mir war die Sache geritzt weil die wichtigen Clients bereits 2.5er LAN onBoard drauf haben.

Switch ist heute gekommen. Performance wie gewünscht. Schreiben zum Server mit 300MB's ( das wird am "Write Back" liegen weil er erst mal alles in den Cache stopft.

Lesen vom Server zwischen 260-280MB's ( ja da muss der Controller noch die Daten von den HDDs im RAID1 kratzen ).

Summary.... total zufrieden für den finanzellen Aufwand.

Wenn die 10GBit's Adapter / Switchports in RJ45 mal günstiger werden könnte ein Upgrade interessant sein wenn die HDDs im RAID auch schneller werden.

Mein ursprüngliches Problem scheint verschwunden.

Ich glaube es lag an der alten RAID Config mit Strip 512K, dass war auch das erste Array was ich auf dem Controller aufgesetzt habe. Vielleicht hat was dabei nicht gepasst. Fehler beim Eingrenzen verschwunden und dafür jetzt ein kleines 2.5Gbit's LAN Segment in Betrieb genommen. Schon lustig ist das manchmal kommt.

Frohe Weihnachten und Danke für die Tipps und Ideen. 🍻

Switch ist heute gekommen. Performance wie gewünscht. Schreiben zum Server mit 300MB's ( das wird am "Write Back" liegen weil er erst mal alles in den Cache stopft.

Lesen vom Server zwischen 260-280MB's ( ja da muss der Controller noch die Daten von den HDDs im RAID1 kratzen ).

Summary.... total zufrieden für den finanzellen Aufwand.

Wenn die 10GBit's Adapter / Switchports in RJ45 mal günstiger werden könnte ein Upgrade interessant sein wenn die HDDs im RAID auch schneller werden.

Mein ursprüngliches Problem scheint verschwunden.

Ich glaube es lag an der alten RAID Config mit Strip 512K, dass war auch das erste Array was ich auf dem Controller aufgesetzt habe. Vielleicht hat was dabei nicht gepasst. Fehler beim Eingrenzen verschwunden und dafür jetzt ein kleines 2.5Gbit's LAN Segment in Betrieb genommen. Schon lustig ist das manchmal kommt.

Frohe Weihnachten und Danke für die Tipps und Ideen. 🍻

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 5

- Aufrufe

- 3.642

- Antworten

- 59

- Aufrufe

- 24.258

- Antworten

- 13

- Aufrufe

- 2.713

Windows Server 2008

mySQL Server 5.1 - performance probleme

- Antworten

- 2

- Aufrufe

- 1.936