donnerwolke

Cadet 4th Year

- Registriert

- Aug. 2013

- Beiträge

- 75

Guten Abend miteinander,

ich habe folgendes Anliegen und hoffe hier Hilfe zu finden.

Seit einigen Jahren habe ich einen VPS bei Hetzner. Die Preise sind aber heftig angezogen.

Nun habe ich bei Netcup im Black Week Sale einen VPS gekauft.

Bei Hetzner hatte ich im Webinterface immer die Möglichkeit meine Firewall zu konfigurieren. Ich habe nur den Port 80/443, 22 (für meine IP) geöffnet, da ich einen NGINX ProxyReverse im Einsatz hatte.

Bei Netcup gestaltet sich das ganze ein wenig schwieriger, da der Hoster keine Möglichkeit bereitstellt die Freigaben der Ports zu konfigurieren.

Hier muss ich auf die IPtables bzw UFW zurück greifen. An sich eigentlich nicht schwer.

Ich mach hier beispielsweise einfach nur

Alles, was auf den VPS an sich geht ist auch absolut kein Thema.

Jedoch rennt der NGIX zb. bei mir als Docker und ist dann auch auf den Port 80/443 erreichbar.

Wenn ich jetzt aber den Port 80/443 öffne, ist dieser NICHT erreichbar.

Ich habe mich nun eingelesen und hatte auch schon Themen wie ufw-docker, die einem das Leben angeblich einfacher machen sollen. Jedoch hat das bisher nicht funktioniert.

Aktuell ist die FW deaktiviert und alle Ports von aussen erreichbar. Auch die Ports, die ich eigentlich nicht freigeben will, da der Traffic durch den NGINX gehen soll. (zb. Portainer mit dem Port 9443)

Hat sich jemand schon mal mit dem Thema auseinander gesetzt und kann mich hier in der Einrichtung unterstützen?

Wenn irgendwelche Konfigs benötigt werden, einfach melden.

Eckdaten:

Ich hoffe, ich finde hier des Problems Lösung.

Vielen Dank und einen schönen ersten Advent euch allen!

ich habe folgendes Anliegen und hoffe hier Hilfe zu finden.

Seit einigen Jahren habe ich einen VPS bei Hetzner. Die Preise sind aber heftig angezogen.

Nun habe ich bei Netcup im Black Week Sale einen VPS gekauft.

Bei Hetzner hatte ich im Webinterface immer die Möglichkeit meine Firewall zu konfigurieren. Ich habe nur den Port 80/443, 22 (für meine IP) geöffnet, da ich einen NGINX ProxyReverse im Einsatz hatte.

Bei Netcup gestaltet sich das ganze ein wenig schwieriger, da der Hoster keine Möglichkeit bereitstellt die Freigaben der Ports zu konfigurieren.

Hier muss ich auf die IPtables bzw UFW zurück greifen. An sich eigentlich nicht schwer.

Ich mach hier beispielsweise einfach nur

Code:

sudo ufw allow from 192.168.0.123 to any port 22Jedoch rennt der NGIX zb. bei mir als Docker und ist dann auch auf den Port 80/443 erreichbar.

Wenn ich jetzt aber den Port 80/443 öffne, ist dieser NICHT erreichbar.

Ich habe mich nun eingelesen und hatte auch schon Themen wie ufw-docker, die einem das Leben angeblich einfacher machen sollen. Jedoch hat das bisher nicht funktioniert.

Aktuell ist die FW deaktiviert und alle Ports von aussen erreichbar. Auch die Ports, die ich eigentlich nicht freigeben will, da der Traffic durch den NGINX gehen soll. (zb. Portainer mit dem Port 9443)

Hat sich jemand schon mal mit dem Thema auseinander gesetzt und kann mich hier in der Einrichtung unterstützen?

Wenn irgendwelche Konfigs benötigt werden, einfach melden.

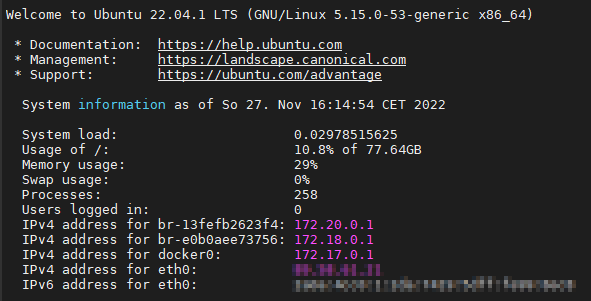

Eckdaten:

- Die Netzwerkkarte ist bei mir auf dem Server die "eth0"

- BS: Ubuntu 22.04

- Ich habe keine GUI installiert (ich habs bisher einfach nicht gebraucht und frisst meiner Meinung nach nur unnötig Speicher)

- Ich habe auf dem Host zwei Dockernetzwerke erstellt.

Ich hoffe, ich finde hier des Problems Lösung.

Vielen Dank und einen schönen ersten Advent euch allen!

Zuletzt bearbeitet: