DJMadMax schrieb:

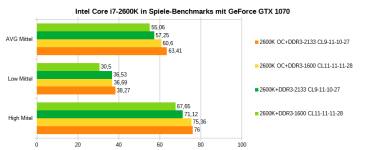

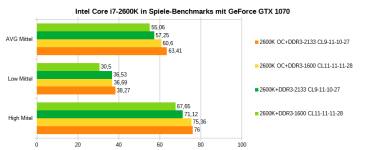

Ehe ich es vergesse: Bei Sandy Bridge (um das CPU Limit weiter anzuheben) profitierst du übrigens sehr von 2133 MHz-RAM gegenüber 1600 MHz (langsameren RAM hast du hoffentlich nicht im Einsatz).

Du schreibst von 24 GB RAM - hast du ein 16er und ein 8er Kit, also 4 Module? Hast du diese auch RICHTIG verbaut, sodass du Dual Channel nutzen kannst?

Vielen Dank für den Tipp mit den schnellen Ram, das werde ich nachher überprüfen (schreibe über Laptop).

Richtig verbaut sind die Riegel. Ist zwar schon lange her, kann mich jedoch erinnern, dass ich dafür extra in die Anleitung des Boards geschaut habe

JMP $FCE2 schrieb:

Lohnt sich bei den absurden Preisen nicht. Einfach sich vom 4k-Hype lösen, und die Auflösung runterschalten. Das sollte bei 4k-Monitoren auch klappen, ohne nennenswerten Matsch zu produzieren.

4K Monitor wurde wegen Arbeit, nicht wegen Zocken oder Hype zugelegt.

Ich dachte immer, man solle in nativer Auflösung zocken, da wenn man zb. auf einen 4k Monitor WQHD einstellt, das Bild sehr schlecht wird. Das kann ich natürlich ausprobieren, danke 👍

Wäre denn auf

Full HD (statt WQHD) runterschalten besser, da teilbar?

DJMadMax schrieb:

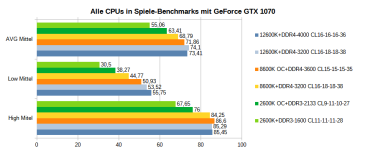

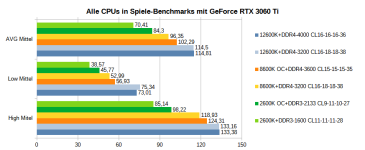

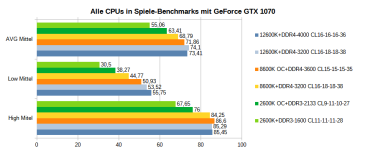

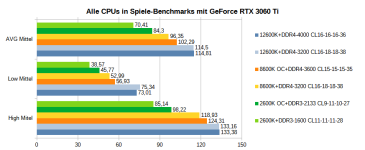

Bittesehr, alle Werte stammen aus meiner persönlichen Ermittlung, es wurden diverse Spieletitel in 1080p bei meist maximalen Details getestet:

Wow vielen Dank für die Bilder und den interessanten Beitrag.

---

Danke für eure Beiträge. Generell sehe ich ein Systemwechsel für mich dadurch noch weniger als Notwendigkeit an und eher als Luxus. Mich juckt es in den Fingern

Eine Überlegung wäre auf AM5 zu warten. Allerdings ist DDR5 (noch) nicht merklich schneller als DDR4 und teurer. Zum Start von AM5 werden die Preise bestimmt immer noch nicht auf DDR4 Niveau sein. Als weitere Neuigkeit wird PCIe 5.0 eingeführt. Das wird wahrscheinlich Jahre dauern, bis man effektiv einen

Unterschied zu PCIe 4.0 merkt, oder?