- Registriert

- Juli 2010

- Beiträge

- 12.907

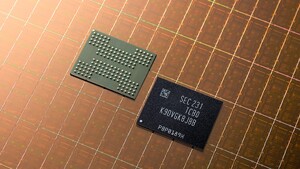

Mit Samsung und Western Digital tun sich zwei Schwergewichte der SSD-Branche zusammen, um neue Speichertechnologien wie Zoned Storage zu etablieren. Durch die Kooperation soll die Standardisierung vorangetrieben werden.

Zur News: Zoned Storage: Samsung und WD treiben Speichertechnik vereint voran

Zur News: Zoned Storage: Samsung und WD treiben Speichertechnik vereint voran