Krautmaster

Fleet Admiral

- Registriert

- Feb. 2007

- Beiträge

- 24.238

Pixelwahn hat halt zur Folge dass du keine GPU die nächsten 3 Jahre finden wirst die ansatzweise in der Lage ist 120hz mit 4K zu befeuern, geschweige denn im Eyefinity.

Bessere Grafik dürfte man gar in kleineren Auflösungen sehen, (wenn man nicht grad nen 40" 4K Moni hat).

Die Konsolen machen es vor. 900p statt 1080p - dafür aber 50% Pixel gespart und die freigelegte Gameleistung in Effekte stecken - das Gesamtresultat ist besser als zwangsweise 1080p zu fahren. 120hz finde ich gerade im Office Bereich eher nen Mehrwert. 120hz bei 4K ausfahren zwecks zocken ist wie gesagt eh schon unwahrscheinlich, dazu muss die Auflösung (oder Effektgewalt) meist eh runter. Und SpieleGrafik mal eben in 10 Bit berechnen dürfte nochmal massiv Leistung kosten.

Zudem hab ich doch nicht gesagt dass es heiße Luft ist oder alles was AMD gebracht hat "heißer Luft" gleich kam. Wie gesagt, es reicht ein Chip im Dezember 2016 von AMD der DP1.3 mitbringt und AMDs Folien sind keine heiße Luft sondern erfüllt. HDR kann man bereits heute (10 Bit Ausgabe). HDMI 2,0 ist nicht sonderlich Kunst, einzig DP1.3 würde schlicht für denn dann angemessenen zeitgemäßen Displaycontroller sprechen.

Ich hoffe natürlich auch, dass es nicht nur auf einen Chip im Dez. 2016 raus läuft sondern auf ein breites Angebot zur Jahresmitte, in <28nm.

Genial fände ich eher HBM2 in Action zusammen mit 16nm. Beides findet keine Erwähnung.

Edit:

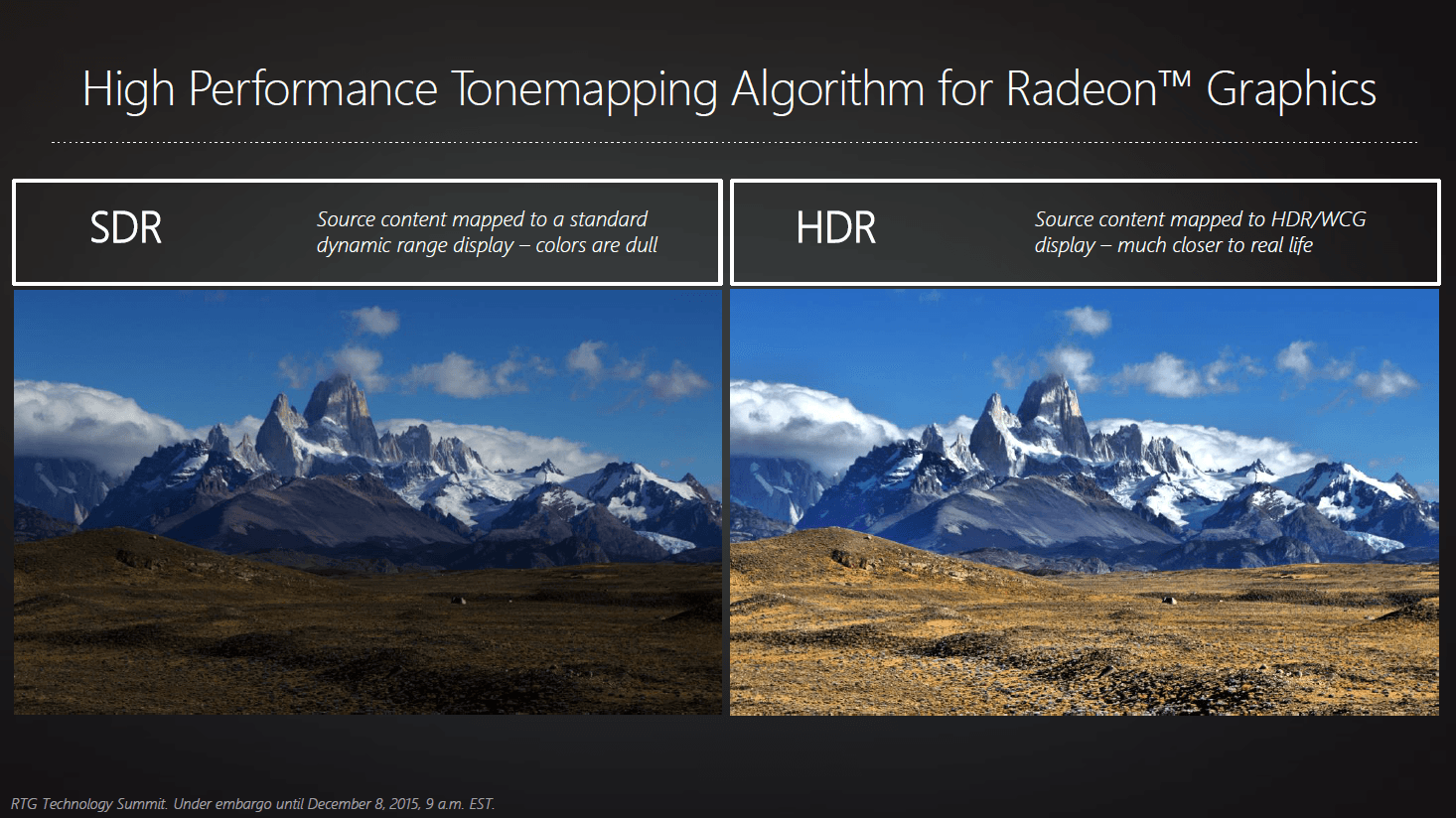

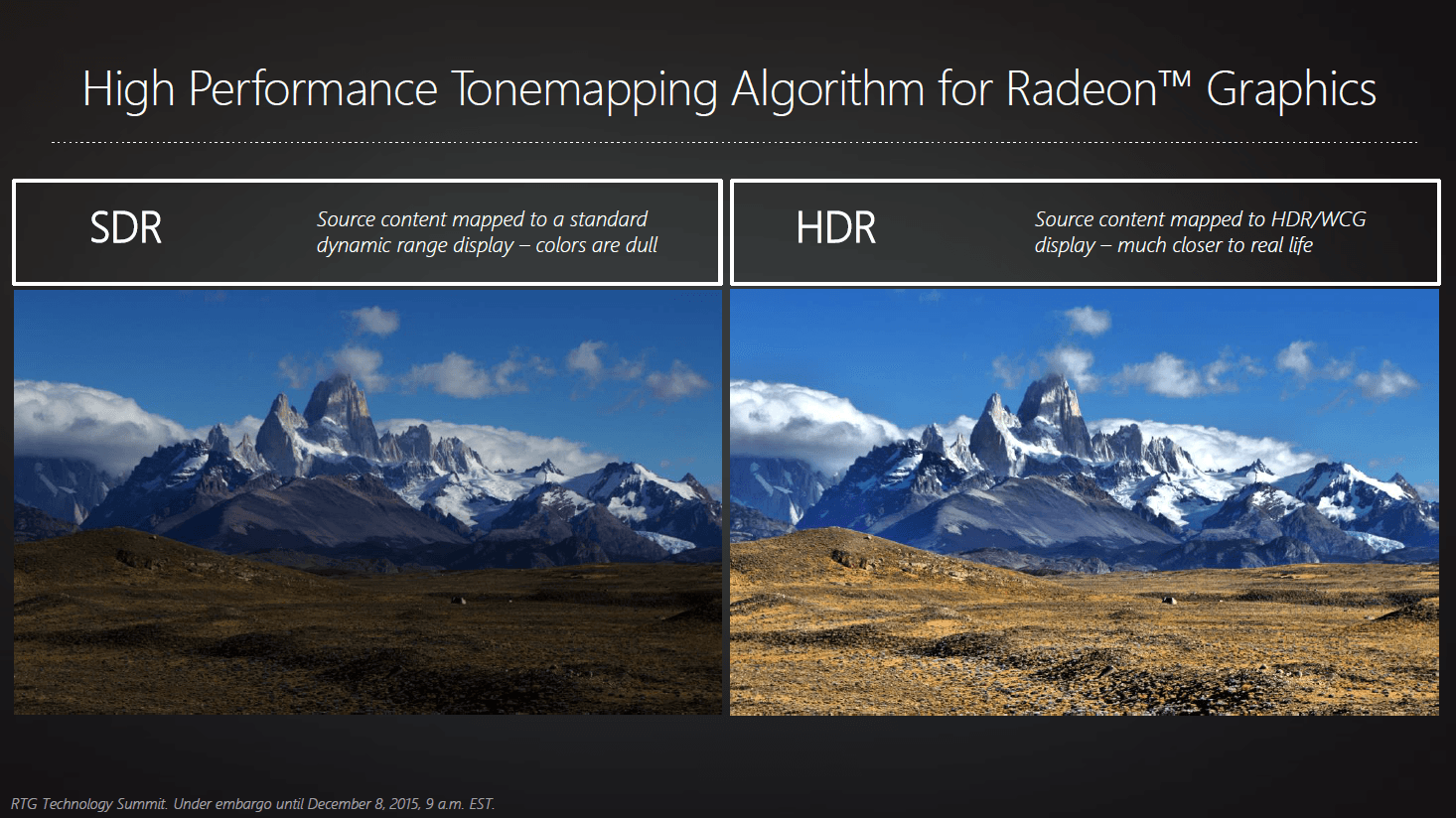

Genau genommen ist der neue Displaycontroller der DP1.3 kann wohl die einzige Ankündigung die man aus der News rausziehen kann. Und sowas find ich eher lächerlich:

aber gut, Marketing halt ^^

Edit2:

10 Bit fände ich generell auch für Hobby Grafiker interessant. Können die aktuellen Karten denn 10 Bit bei 4K @ 60p betreiben? Ich musste dafür glaube ich bei AMD auf 30p zurückgehen (mit meiner alten Karte und DP 1.2 an 4K) - genau das dürfte sich mit den neuen GPU dann ändern. Bei Nvidia braucht es dafür meine ich noch immer eine Quadro, da punktet AMD seit langem (sofern man ein 10 Bit Display kleiner 4K hat).

Bessere Grafik dürfte man gar in kleineren Auflösungen sehen, (wenn man nicht grad nen 40" 4K Moni hat).

Die Konsolen machen es vor. 900p statt 1080p - dafür aber 50% Pixel gespart und die freigelegte Gameleistung in Effekte stecken - das Gesamtresultat ist besser als zwangsweise 1080p zu fahren. 120hz finde ich gerade im Office Bereich eher nen Mehrwert. 120hz bei 4K ausfahren zwecks zocken ist wie gesagt eh schon unwahrscheinlich, dazu muss die Auflösung (oder Effektgewalt) meist eh runter. Und SpieleGrafik mal eben in 10 Bit berechnen dürfte nochmal massiv Leistung kosten.

Zudem hab ich doch nicht gesagt dass es heiße Luft ist oder alles was AMD gebracht hat "heißer Luft" gleich kam. Wie gesagt, es reicht ein Chip im Dezember 2016 von AMD der DP1.3 mitbringt und AMDs Folien sind keine heiße Luft sondern erfüllt. HDR kann man bereits heute (10 Bit Ausgabe). HDMI 2,0 ist nicht sonderlich Kunst, einzig DP1.3 würde schlicht für denn dann angemessenen zeitgemäßen Displaycontroller sprechen.

Ich hoffe natürlich auch, dass es nicht nur auf einen Chip im Dez. 2016 raus läuft sondern auf ein breites Angebot zur Jahresmitte, in <28nm.

Genial fände ich eher HBM2 in Action zusammen mit 16nm. Beides findet keine Erwähnung.

Edit:

Genau genommen ist der neue Displaycontroller der DP1.3 kann wohl die einzige Ankündigung die man aus der News rausziehen kann. Und sowas find ich eher lächerlich:

aber gut, Marketing halt ^^

Edit2:

10 Bit fände ich generell auch für Hobby Grafiker interessant. Können die aktuellen Karten denn 10 Bit bei 4K @ 60p betreiben? Ich musste dafür glaube ich bei AMD auf 30p zurückgehen (mit meiner alten Karte und DP 1.2 an 4K) - genau das dürfte sich mit den neuen GPU dann ändern. Bei Nvidia braucht es dafür meine ich noch immer eine Quadro, da punktet AMD seit langem (sofern man ein 10 Bit Display kleiner 4K hat).

Zuletzt bearbeitet: