CSAM: Apple will Kinderpornografie-Erkennung nicht umsetzen

Apple hat die Entwicklung der im Sommer 2021 vorgestellten CSAM-Erkennung endgültig eingestellt. Das Feature, das Kinderpornografie während des Uploads von Fotos zu iCloud anhand spezieller Hashes erkennen sollte, war zur Ankündigung vielerorts missverstanden, dann kontrovers diskutiert und der Rollout später pausiert worden.

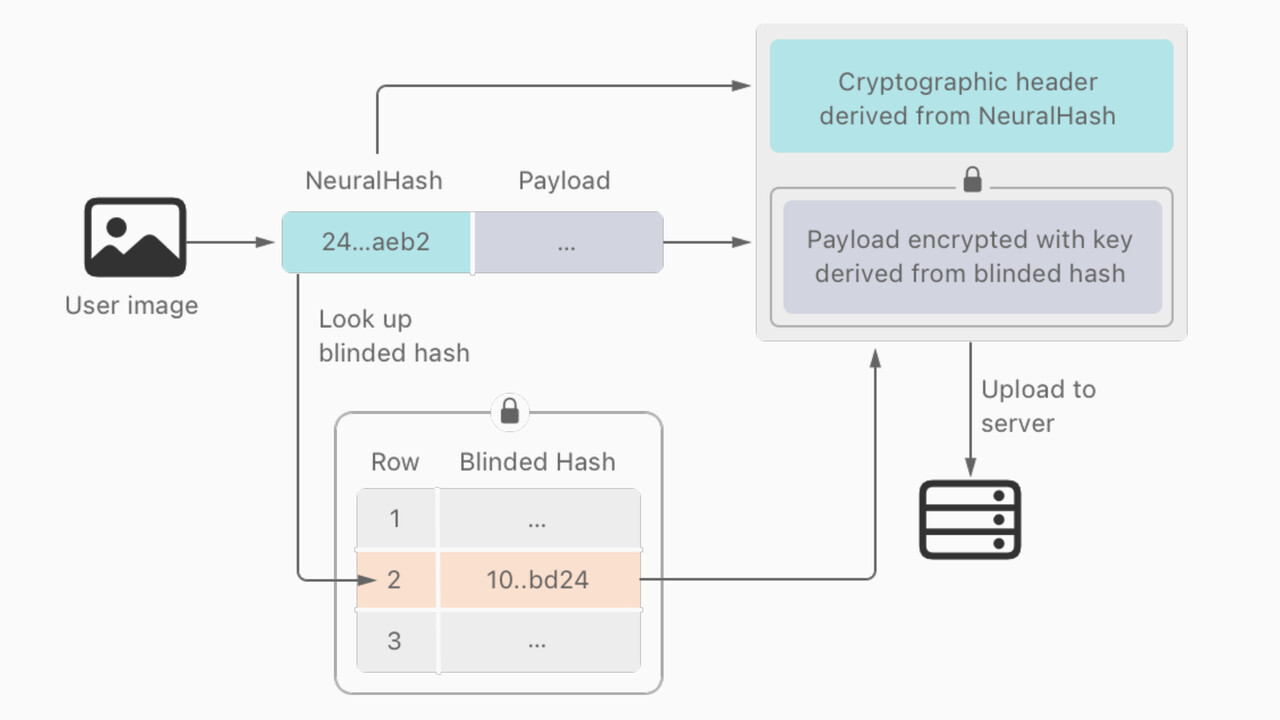

Bei der CSAM-Erkennung (child sexual abuse material) (PDF) sollten Hashes der zu iCloud hochgeladenen Fotos mit den zu nachweislich kinderpornografischen Aufnahmen erstellten Hashes einer Datenbank des National Center for Missing & Exploited Children (NCMEC) verglichen werden. Beim Überschreiten einer Schwelle von rund 30 Treffern hätte Apple nach ursprünglichen Plänen die Strafverfolgungsbehörden eingeschaltet.

Obwohl Apple lediglich mit Hashes arbeiten und keineswegs alle Aufnahmen des Anwenders auf dem Smartphone oder in der Cloud durchsuchen wollte, war das Feature nach seiner Vorstellung im August 2021 vielerorts exakt so wahrgenommen worden. Es hagelte Kritik, dass Apple eine Backdoor in die Geräte integrieren und automatisch die gesamte Fotobibliothek der Anwender durchsuchen wolle. Auf die Kritik reagierte Apple rund einen Monat später mit einer Verschiebung des Features, das ursprünglich für iOS, iPad und macOS kommen sollte.

CSAM-Erkennung wird nicht umgesetzt

Im Rahmen der Ankündigung einer erweiterten Ende-zu-Ende-Verschlüsselung, die ab 2023 auch iCloud Backup, iCloud Drive, Fotos, Notizen, Erinnerungen, Safari Bookmarks, Siri Shortcuts, Sprachmemos und Karten in Apple Wallet umfasst, hat sich Apple jetzt endgültig von der CSAM-Erkennung verabschiedet. Software-Chef Craig Federighi hat diese Entscheidung gegenüber dem Wall Street Journal bestätigt, zudem liegt unter anderem Wired ein offizielles Statement vor. Kinder könnten demnach auch ohne das Durchkämmen der Daten etwa durch die Zusammenarbeit mit entsprechenden Behörden geschützt werden. An dem Communication-Safety-Feature hält Apple allerdings fest.

After extensive consultation with experts to gather feedback on child protection initiatives we proposed last year, we are deepening our investment in the Communication Safety feature that we first made available in December 2021. We have further decided to not move forward with our previously proposed CSAM detection tool for iCloud Photos. Children can be protected without companies combing through personal data, and we will continue working with governments, child advocates, and other companies to help protect young people, preserve their right to privacy, and make the internet a safer place for children and for us all.

Apple

iMessage kann vor Nacktdarstellungen warnen

Seit Dezember des letzten Jahres gibt es für Eltern bei Familien-Accounts in der Nachrichten-App die Option, Kinder zu warnen und hilfreiche Ressourcen bereitzustellen, wenn diese Nacktdarstellungen empfangen oder zu senden versuchen. Die Nachrichten-App nutzt dafür geräteinternes maschinelles Lernen, um Bildanhänge zu analysieren und festzustellen, ob ein Foto vermutlich Nacktdarstellungen enthält. Die Funktion sei so konzipiert, dass Apple keinen Zugriff auf die jeweiligen Fotos erhält, heißt es vom Hersteller. Die erweiterte Kommunikationssicherheit lässt sich von Eltern in den Bildschirmzeit-Einstellungen für den Account des Kindes aktivieren.