Hi,

Ich hoffe ich finde hier Hilfe.

Also ich möchte von einem Objekt ein 3D-Modell erstellen.

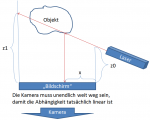

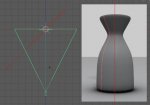

Dazu hab ich von dem Objekt 360 Bilder gemacht (einmal rundherum), dabei hab ich das Objekt mit einem Laser(Linienlaser) "bestrahlt". Ich hab jetzt also 360 Bilder vom Objekt, jeweils 1 Grad gedreht und mit einem Laser bestrahlt. Wie gehts jetzt aber weiter? Ich hab mir gedacht, als nächstes sollte ich eine Punktewolke erstellen.

Dafür hab ich die Roten Pixel (vom Laser) in einem 3 Diminsionalen Feld gespeichert

Feld[<id des Bildes>; <x-koordinaten>; <y-Koordinaten>]

Leider hab ich jetzt keine wirkliche idee wie ich weiter machen soll, hat jemand evtl. einen kleinen Denkanstoß für mich?

Ich hoffe ich finde hier Hilfe.

Also ich möchte von einem Objekt ein 3D-Modell erstellen.

Dazu hab ich von dem Objekt 360 Bilder gemacht (einmal rundherum), dabei hab ich das Objekt mit einem Laser(Linienlaser) "bestrahlt". Ich hab jetzt also 360 Bilder vom Objekt, jeweils 1 Grad gedreht und mit einem Laser bestrahlt. Wie gehts jetzt aber weiter? Ich hab mir gedacht, als nächstes sollte ich eine Punktewolke erstellen.

Dafür hab ich die Roten Pixel (vom Laser) in einem 3 Diminsionalen Feld gespeichert

Feld[<id des Bildes>; <x-koordinaten>; <y-Koordinaten>]

Leider hab ich jetzt keine wirkliche idee wie ich weiter machen soll, hat jemand evtl. einen kleinen Denkanstoß für mich?