Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Die optimale Hardware für einen Excel-Esel ?

- Ersteller Omono

- Erstellt am

slsHyde

Commander

- Registriert

- Dez. 2014

- Beiträge

- 2.232

Genau. Auch mal testweise das andere Häkchen aktivieren. Rückmeldung wäre schön.

Zu den Diensten: Wahrscheinlich ist das verlorene Zeit. Ein Teil der Dienste dürfte das sein, was im anderen Rechner der Controller erledigt, andere Dienste dürften den Unterschied in den Betriebssystemversionen betreffen.

Zu den Diensten: Wahrscheinlich ist das verlorene Zeit. Ein Teil der Dienste dürfte das sein, was im anderen Rechner der Controller erledigt, andere Dienste dürften den Unterschied in den Betriebssystemversionen betreffen.

etwas Performancegewinn

50er test: 15,2s (14,8s)

1 er test 5,6s (4,8s)

Das mit den Diensten habe ich aufgegeben. Extrem mühsam, wenn man nicht weiß wonach man suchen soll.

Zur Optane -> ist das einfach kaufen, einstecken und sollte funktionieren? Oder braucht es da know how?

50er test: 15,2s (14,8s)

1 er test 5,6s (4,8s)

Das mit den Diensten habe ich aufgegeben. Extrem mühsam, wenn man nicht weiß wonach man suchen soll.

Zur Optane -> ist das einfach kaufen, einstecken und sollte funktionieren? Oder braucht es da know how?

kurzes Zwischenupdate - habe auch mit dem Lieferanten Kontakt aufgenommen. Er vermutet, dass die SSD einen Defekt hat und hat mir bereits eine neue auf den Postweg gebracht. Werde diese austauschen und dann "schaun wir mal".

Optane hat er im übrigen auch ins Spiel gebracht. Allerdings mit dem Hinweis, dass damit die Leserate deutlich angehoben werden kann, gleichzeitig aber die Schreibrate sinkt. Will nicht wirklich priorisieren, da beides für unseren Einsatzzweck wichtig ist...

Melde mich nach meiner "Tauschaktion"...

Optane hat er im übrigen auch ins Spiel gebracht. Allerdings mit dem Hinweis, dass damit die Leserate deutlich angehoben werden kann, gleichzeitig aber die Schreibrate sinkt. Will nicht wirklich priorisieren, da beides für unseren Einsatzzweck wichtig ist...

Melde mich nach meiner "Tauschaktion"...

slsHyde

Commander

- Registriert

- Dez. 2014

- Beiträge

- 2.232

Das mit der Schreibrate stimmt nicht. Die liegt sogar eher deutlich höher als in einer herkömmlichen SSD, besonders wenn es nicht nur um kurze Lastspitzen geht. Wobei natürlich bei den kleinen Optanes ein niedrigerer Maßstab gilt. Letztendlich geht es aber eher um Crosslasten. Aber klar - den Test mit dem Austausch der SSD kann man machen. Zwei Werte im Benchmark waren tatsächlich eher mager und die kurzen Aussetzer könnten damit erklärt werden. Bin gespannt.

Zuletzt bearbeitet:

Hi,

SSD getauscht. Kaum Unterschiede. Mein Provider hatte mir noch Testdaten einer 960 Pro geschickt, die doch deutlich über meinen Werten lagen, jedoch noch weit weg von denen meines alten Rechners. Insofern kann man meine Konstellation sicher noch etwas "beefen", aber sie wird trotzdem noch weit vom vorherigen rechner liegen.

Habe noch ein wenig gelesen und dabei (i) verstanden, dass der zu bemerkende Hebel in der "real world" weniger in den sequentiellen Raten, sondern in den 4k tests liegt und (ii) immer wieder gelesen, dass wirkliche Performanceschübe nicht über einen SW Controller via Mainboard, sondern nur über einen HW Controller mit entsprechendem cache erreichbar sind. Nach meinem Verständnis exakt die Konstellation des alten Rechners, was die Performanceunterschiede erklären würde. Wie kann ich dies herstellen und was sind die richtigen dafür notwendigen Controller, damit ich mich im Netz dazu mal belesen kann? Braucht es dann mehrere SSDs, die im RAID verbunden werden müssen?

Ob das zweite Thema der kurzzeitigen GPU Überlastung (freezes) mit der SSD zusammn hängen konnte ich noch nicht testen, da ich dafür im Dauerbetrieb sein muss... Aber erst mal zur Lese-/Schreibperformance. Die ist wirklich sehr ärgerlich und bei unseren Anwendungen sehr hinderlich...

SSD getauscht. Kaum Unterschiede. Mein Provider hatte mir noch Testdaten einer 960 Pro geschickt, die doch deutlich über meinen Werten lagen, jedoch noch weit weg von denen meines alten Rechners. Insofern kann man meine Konstellation sicher noch etwas "beefen", aber sie wird trotzdem noch weit vom vorherigen rechner liegen.

Habe noch ein wenig gelesen und dabei (i) verstanden, dass der zu bemerkende Hebel in der "real world" weniger in den sequentiellen Raten, sondern in den 4k tests liegt und (ii) immer wieder gelesen, dass wirkliche Performanceschübe nicht über einen SW Controller via Mainboard, sondern nur über einen HW Controller mit entsprechendem cache erreichbar sind. Nach meinem Verständnis exakt die Konstellation des alten Rechners, was die Performanceunterschiede erklären würde. Wie kann ich dies herstellen und was sind die richtigen dafür notwendigen Controller, damit ich mich im Netz dazu mal belesen kann? Braucht es dann mehrere SSDs, die im RAID verbunden werden müssen?

Ob das zweite Thema der kurzzeitigen GPU Überlastung (freezes) mit der SSD zusammn hängen konnte ich noch nicht testen, da ich dafür im Dauerbetrieb sein muss... Aber erst mal zur Lese-/Schreibperformance. Die ist wirklich sehr ärgerlich und bei unseren Anwendungen sehr hinderlich...

slsHyde

Commander

- Registriert

- Dez. 2014

- Beiträge

- 2.232

Ich würde dennoch erst mal die Optane versuchen. Das ist Kleingeld und hat eine gewisse Erfolgsaussicht.

Ansonsten muss ich noch mal wegen ein Empfehlung für einen Controller schauen. Ein Raid wäre keine Voraussetzung. Eigentlich scheint es hier ja maßgeblich um den Cache zu gehen. Bin aber heute den ganzen Tag auf Reisen, weiß nicht, ob das heute noch klappt. Du brauchst weder viel CPU-Leistung im Controller, noch viele Anschlüsse, noch viele Funktionen oder RAID-Modi - aber viel Cache.

Dabei entsteht aber das Problen, dass der Cache bei einem Absturz nicht gesichert wird, wenn er keine Notstromversorgung erhält, was aber teuer ist. Es droht dann, dass der gesamte Festplatteninhalt zerstört wird. Datensicherung ist also entsprechend wichtig. Bei der SSD selber könnte/sollte man eine mit Power Loss Protection nehmen.

Es gibt auch Softwarelösungen, mit denen man einen Teil des Arbeitsspeichers als Festplattencache nutzen kann. Das wäre vielleicht auch noch einen Versuch wert.

Zu beachten ist auch, dass wir nach wie vor von einer Theorie reden, auch wenn diese gut begründet ist. Ohne Validierung durch einen testweisen Umbau läufst Du Gefahr, Geld in den Sand zu setzen.

Eine Theorie für die kurzen Freezes wäre, dass die fehlende Leistungsbeständigkeit der 960 zuschlägt. Diese kann durch Überhitzung ausgelöst werden und auch durch die Flashspeicher. Denn schreibend bricht der sehr schnell ein und ist dann nur geringfügig über dem Niveau normaler SSDs. Wenn Du die Optane testest, solltest Du darauf achten, denn die hat das zweite Problem nicht. Und mal die Temps während Dauerbetrieb beobachten.

Ansonsten muss ich noch mal wegen ein Empfehlung für einen Controller schauen. Ein Raid wäre keine Voraussetzung. Eigentlich scheint es hier ja maßgeblich um den Cache zu gehen. Bin aber heute den ganzen Tag auf Reisen, weiß nicht, ob das heute noch klappt. Du brauchst weder viel CPU-Leistung im Controller, noch viele Anschlüsse, noch viele Funktionen oder RAID-Modi - aber viel Cache.

Dabei entsteht aber das Problen, dass der Cache bei einem Absturz nicht gesichert wird, wenn er keine Notstromversorgung erhält, was aber teuer ist. Es droht dann, dass der gesamte Festplatteninhalt zerstört wird. Datensicherung ist also entsprechend wichtig. Bei der SSD selber könnte/sollte man eine mit Power Loss Protection nehmen.

Ergänzung ()

Es gibt auch Softwarelösungen, mit denen man einen Teil des Arbeitsspeichers als Festplattencache nutzen kann. Das wäre vielleicht auch noch einen Versuch wert.

Zu beachten ist auch, dass wir nach wie vor von einer Theorie reden, auch wenn diese gut begründet ist. Ohne Validierung durch einen testweisen Umbau läufst Du Gefahr, Geld in den Sand zu setzen.

Ergänzung ()

Eine Theorie für die kurzen Freezes wäre, dass die fehlende Leistungsbeständigkeit der 960 zuschlägt. Diese kann durch Überhitzung ausgelöst werden und auch durch die Flashspeicher. Denn schreibend bricht der sehr schnell ein und ist dann nur geringfügig über dem Niveau normaler SSDs. Wenn Du die Optane testest, solltest Du darauf achten, denn die hat das zweite Problem nicht. Und mal die Temps während Dauerbetrieb beobachten.

Zuletzt bearbeitet:

Wenn man nach der performantesten Lösung schaut ist es dann ein HW Controller? Vom gefühltem Eindruck bist Du eher zögerlich oder interpretiere ich falsch? Von den Messergebnissen sind zwischen neuer und alter Konstellation beim Öffnen, Speichern und Schließen m.E. Mit Faktor 2 und 3 „Welten“, die selbst bei 50% oder mehr improvisiert der aktuellen SDD nicht geschlossen wären.

Zum Datenverlust - beim alten Rechner haben wir keine Notstromversorgung, aber der Provider hat nie auf das Risiko hingewiesen. Trügerische Sicherheit oder vielleicht doch irgendwie vermieden? Ist es vielleicht durch den dortigen RAID mit zwei identischen SSDs gelöst?

Die 960 Pro hat m.E. eine kleine Batterie. Ist es das, was Du mit Power Loss Protection bei der SSD meinst?

Du siehst ich bin noch stark am Verstehen. Habe das Thema offensichtlich noch nicht in Gänze verstanden. Insbesondere auch nicht, was die theoretisch performanteste Lösung ist, wenn es keine finanziellen Restriktionen gibt.

Bon voyage

Das Problem mit der etwaigen „Performancereduktion w/Überlastung“ hat der HW Controller auch nicht weil er die SSD durch den Zwischencache entlastet, korrekt?

Habe i.ü. gesehen, dass die 960 Pro auch Cache und einen eigenen Controller verbaut hat. Ist die Architektur anders oder warum ist der Leistungsunterschied ggü. einem (externen) Controller mit (externem) Cache so viel anders?

Zu den SW Lösungen für den Arbeitsspeicher: war das nicht unser - nicht erfolgreicher - Versuch mit der RAM Disk?

Zum Datenverlust - beim alten Rechner haben wir keine Notstromversorgung, aber der Provider hat nie auf das Risiko hingewiesen. Trügerische Sicherheit oder vielleicht doch irgendwie vermieden? Ist es vielleicht durch den dortigen RAID mit zwei identischen SSDs gelöst?

Die 960 Pro hat m.E. eine kleine Batterie. Ist es das, was Du mit Power Loss Protection bei der SSD meinst?

Du siehst ich bin noch stark am Verstehen. Habe das Thema offensichtlich noch nicht in Gänze verstanden. Insbesondere auch nicht, was die theoretisch performanteste Lösung ist, wenn es keine finanziellen Restriktionen gibt.

Bon voyage

Ergänzung ()

Das Problem mit der etwaigen „Performancereduktion w/Überlastung“ hat der HW Controller auch nicht weil er die SSD durch den Zwischencache entlastet, korrekt?

Habe i.ü. gesehen, dass die 960 Pro auch Cache und einen eigenen Controller verbaut hat. Ist die Architektur anders oder warum ist der Leistungsunterschied ggü. einem (externen) Controller mit (externem) Cache so viel anders?

Zu den SW Lösungen für den Arbeitsspeicher: war das nicht unser - nicht erfolgreicher - Versuch mit der RAM Disk?

slsHyde

Commander

- Registriert

- Dez. 2014

- Beiträge

- 2.232

Antworten kommen jetzt Stück für Stück weil ich unterwegs bin.

Es gibt zwei Sachen die nicht so ganz zu der Theorie passen: der Test mit der RAM-Disk und die Freezes. Außerdem lehrt die Erfahrung, dass selbst die schönste Theorie an der Realität scheitert. Daher bleibe ich vorsichtig.

Trügerische Sicherheit, ja. Auch der RAID löst das Thema nicht. Ist in hiesiger Größenordnung nicht entscheidend, sollte man aber wissen.

Man kann ggf. den Schreibcache auch abschalten und prüfen, ob der Performanceverlust relevant ist. Und eine USV kann das Thema auch lindern.

Es gibt zwei Sachen die nicht so ganz zu der Theorie passen: der Test mit der RAM-Disk und die Freezes. Außerdem lehrt die Erfahrung, dass selbst die schönste Theorie an der Realität scheitert. Daher bleibe ich vorsichtig.

Ergänzung ()

Trügerische Sicherheit, ja. Auch der RAID löst das Thema nicht. Ist in hiesiger Größenordnung nicht entscheidend, sollte man aber wissen.

Ergänzung ()

Man kann ggf. den Schreibcache auch abschalten und prüfen, ob der Performanceverlust relevant ist. Und eine USV kann das Thema auch lindern.

mit Theorie vs Praxis hast Du erst mal recht

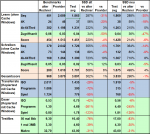

damit ich bei der Vielzahl der Tests noch durchblicke habe ich mir dies gegenübergestellt strukturiert. Meine learnings daraus:

(1) Die synthetischen Tests ohne Cache des BS sind deutlich besser als beim alten Rechner -> klar, weil keine M2 SSD -> Interpretation: Der HW Controller (Cache?) ist der Schlüssel

(2) Die praxisnahen Kopiertests (unter Nutzung des Cache des BS) zeigen einen signifikanten Einbruch bei Programm (viele kleine Dateien) und Spiel (Mix aus großen und kleinen Dateien). Auch ISO (zwei große Dateien) schlechter, aber bei weitem nicht so signifikant.

(3) Mein Testprogramm bestätigt (2). Signifikanter Einbruch bei vielen kleinen Dateien (8kb) und immer noch sehr deutlicher Einbruch bei immer noch kleinen 3 MB Datei. Je kleiner die Dateien, desto größer der Einbruch.

Hilft Dir das irgendwas für die Analyse / Handlungsempfehlungen?

damit ich bei der Vielzahl der Tests noch durchblicke habe ich mir dies gegenübergestellt strukturiert. Meine learnings daraus:

(1) Die synthetischen Tests ohne Cache des BS sind deutlich besser als beim alten Rechner -> klar, weil keine M2 SSD -> Interpretation: Der HW Controller (Cache?) ist der Schlüssel

(2) Die praxisnahen Kopiertests (unter Nutzung des Cache des BS) zeigen einen signifikanten Einbruch bei Programm (viele kleine Dateien) und Spiel (Mix aus großen und kleinen Dateien). Auch ISO (zwei große Dateien) schlechter, aber bei weitem nicht so signifikant.

(3) Mein Testprogramm bestätigt (2). Signifikanter Einbruch bei vielen kleinen Dateien (8kb) und immer noch sehr deutlicher Einbruch bei immer noch kleinen 3 MB Datei. Je kleiner die Dateien, desto größer der Einbruch.

Hilft Dir das irgendwas für die Analyse / Handlungsempfehlungen?

Anhänge

slsHyde

Commander

- Registriert

- Dez. 2014

- Beiträge

- 2.232

Das ist genau der Punkt. Erklärt aber die Freezes nicht und auch nicht die Testergebnisse mit RAM-Disk, zumindest nicht zwingend. Dass die Freezes an mangelnder Leistungsbeständigkeit liegen steht auf dünnem Eis. Die RAM-Disk-Ergebnisse müssten fehlerhaft sein. Das könnte von daher also auch ein Hinweis sein, dass die Ursache eine andere ist. Ein vorheriger Test würde Klarheit schaffen.

Die Optane mit ihrer völlig anderen Leistungscharakteristik könnte halt auch eine Lösung sein. Wenn Du erst den arbeitsaufwändigen Test mit Umbau des Hardwarecontrollers machst, wüßten wir immer noch nicht, ob eine Optane nicht trotzdem die vielleicht viel günstigere Lösung ist. Daher würde ich die 25 € zuerst in die Hand nehmen. Es wäre interessant zu sehen, wie zum einen die Benchmarkergebnisse und zum anderen die Realtestergebnisse sind und ob die Freezes dann weg sind.

Ergänzung ()

Die Optane mit ihrer völlig anderen Leistungscharakteristik könnte halt auch eine Lösung sein. Wenn Du erst den arbeitsaufwändigen Test mit Umbau des Hardwarecontrollers machst, wüßten wir immer noch nicht, ob eine Optane nicht trotzdem die vielleicht viel günstigere Lösung ist. Daher würde ich die 25 € zuerst in die Hand nehmen. Es wäre interessant zu sehen, wie zum einen die Benchmarkergebnisse und zum anderen die Realtestergebnisse sind und ob die Freezes dann weg sind.

Zuletzt bearbeitet:

Die Erklärung für die freezes besorgt mich noch nicht so sehr, da diese u.U. gar nicht damit zusammenhängen. Sollten diese kausal nicht zusammen hängen würde uns die Verquickung potentiell in die falsche Richtung schicken, oder?

Re/RAM Disk: Soll diese de facto den Cache des HW Controllers simulieren? Wenn mein bisheriger Test Dir (nachvollziehbar) zweifelhaft erscheint - wie kann ich denn (richtig) testen?

Re/Optane -> einfach kaufen und einstecken?

Noch mal zu meinem learning -> warum ist der in der 960 Pro (intern) verbaute Controller mit (internem) Cache so viel schlechter wie der (externe) HW Controller mit (externem) cache?

Großes Dankeschön i.ü. für Deine sehr engagierte Hilfe!

Re/RAM Disk: Soll diese de facto den Cache des HW Controllers simulieren? Wenn mein bisheriger Test Dir (nachvollziehbar) zweifelhaft erscheint - wie kann ich denn (richtig) testen?

Re/Optane -> einfach kaufen und einstecken?

Noch mal zu meinem learning -> warum ist der in der 960 Pro (intern) verbaute Controller mit (internem) Cache so viel schlechter wie der (externe) HW Controller mit (externem) cache?

Großes Dankeschön i.ü. für Deine sehr engagierte Hilfe!

slsHyde

Commander

- Registriert

- Dez. 2014

- Beiträge

- 2.232

Die Softwarelösung zur Verwendung des Arbeitsspeichers als Laufwerkscache ist nicht das gleiche wie eine RAM-Disk, kann aber ggf darauf aufsetzen. Kannst ja schon mal suchen ob Du was findest, sonst schau ich unterwegs gelegentlich mal.

Wie gesagt, ich muss hier Stück für Stück antworten. Sind immer wieder Pausen drin. Geduld :-)

Ergänzung ()

Wie gesagt, ich muss hier Stück für Stück antworten. Sind immer wieder Pausen drin. Geduld :-)

Habe ich ;-))

Ich lese immer wieder davon, dass HW Controller Schreib- und Lesegeschwindigkeiten von einem Vielfachen der max 3,5 GB/s der 960 Pro ermöglichen. Ist das korrekt?

Den hatte ich gesehen mit angeblich bis zu 32Gb/s...

HighPoint SSD7101A-1 NVMe M.2 RAID Controller

Ich lese immer wieder davon, dass HW Controller Schreib- und Lesegeschwindigkeiten von einem Vielfachen der max 3,5 GB/s der 960 Pro ermöglichen. Ist das korrekt?

Den hatte ich gesehen mit angeblich bis zu 32Gb/s...

HighPoint SSD7101A-1 NVMe M.2 RAID Controller

Zuletzt bearbeitet:

slsHyde

Commander

- Registriert

- Dez. 2014

- Beiträge

- 2.232

Innerhalb des Laufwerkes muss der Datenverkehr organisiert werden. Dafür der Controller in der SSD/HDD. Im Weiteren wird ein Zwischenspeicher eingebaut, der Cache. Dieser dient als Puffer um Lastspitzen glattzubügeln.

Dann muss der Datenverkehr zwischen Laufwerken und Systen sowie untereinander (Raid) organisiert werden. Dafür braucht es einen Controller, der auch die Schnittstellen bereit stellt. Dieser Controller kann auf dem Mainboard oder einer extra Steckkarte sein.

Bei einer extra Steckkarte kann zusätzlich wieder ein Zwischenspeicher verbaut werden, um Lastspitzen aufzufangen. Bei einem Onboardcontroller kann man den RAM nutzen - mit entsprechender Software.

Derzeit kommt in beiden Fällen, also in dem Laufwerk oder auf der Controllerkarte, meist DDR3 1866 zum Einsatz.

Eine Optane hat keinen Cache, da deren Leistungscharakteristik bereits deutlich näher an Arbeitsspeicher dran ist und das daher nicht mehr wirklich was bringt.

Im Weiteren bedarf es Rechenleistung. Besonders bei komplexeren Raids, da zum Beispiel Paritätsinformationen berechnet werden müssen. Das macht zunächst die CPU. Mit einer zusätzlichen CPU auf einer Steckkarte kann das deutlich beschleunigt werden. Ohne RAID oder bei einfachen RAIDs ist die benötigte Rechenleistung bedeutend geringer. Die CPU eines Rechners ist mit dem kompexeren RAIDs schnell überfordert, ohne RAID eher nicht. Es kann aber bei starken Datenbewegungen schon einiges an Leistung kosten. Bei Dir ist aber die CPU kaum ausgelastet, also ist das nicht der Flaschenhals.

Dann muss der Datenverkehr zwischen Laufwerken und Systen sowie untereinander (Raid) organisiert werden. Dafür braucht es einen Controller, der auch die Schnittstellen bereit stellt. Dieser Controller kann auf dem Mainboard oder einer extra Steckkarte sein.

Bei einer extra Steckkarte kann zusätzlich wieder ein Zwischenspeicher verbaut werden, um Lastspitzen aufzufangen. Bei einem Onboardcontroller kann man den RAM nutzen - mit entsprechender Software.

Derzeit kommt in beiden Fällen, also in dem Laufwerk oder auf der Controllerkarte, meist DDR3 1866 zum Einsatz.

Eine Optane hat keinen Cache, da deren Leistungscharakteristik bereits deutlich näher an Arbeitsspeicher dran ist und das daher nicht mehr wirklich was bringt.

Im Weiteren bedarf es Rechenleistung. Besonders bei komplexeren Raids, da zum Beispiel Paritätsinformationen berechnet werden müssen. Das macht zunächst die CPU. Mit einer zusätzlichen CPU auf einer Steckkarte kann das deutlich beschleunigt werden. Ohne RAID oder bei einfachen RAIDs ist die benötigte Rechenleistung bedeutend geringer. Die CPU eines Rechners ist mit dem kompexeren RAIDs schnell überfordert, ohne RAID eher nicht. Es kann aber bei starken Datenbewegungen schon einiges an Leistung kosten. Bei Dir ist aber die CPU kaum ausgelastet, also ist das nicht der Flaschenhals.

got it, danke. Mein Verständnis:

(1) 960 Pro hat einen eigenen Controller/Cache, dieser ist aber unabhängig von (weiterem externem) Controller/Cache

(2) (weiterer externer) Controller / Cache erspart dem System, auf die SSD zuzugreifen, i.e. kurze Wege = Performancegewinn

(3) Controller auf dem Mainboard = SW Controller = Onboardcontroller = keine Cachenutzung, d.h. immer Zugriff auf SSD notwendig (inkl. der damit einhergehenden geringeren Performance)

(4) Optane - da analog Arbeitsspeicher - eigentlich analog Cacheprozess mit externem HW Controller (siehe 2)

weitergehende Verständnisfragen:

(1) Fängt (externer) HW Controller wirklich nur Lastspitzen oder entlastet er die SSD (durch nicht nötige Zugriffe) bei Datenvolumen < Cachegröße?

(2) Kann eine Optane (vom physischen Prozessvorgang) analog dem Cache des HW Controllers agieren? Warum schreiben dann alle Optanenutzer im Netz von Steigerungen ggü. Nutzung von "normalen" Platten, aber nicht bei M2 SSDs. Dort soll die Optane i.d.R. nichts gebracht haben. Kannst Du Dir das erklären?

(3) Wie kann ein HW Controller (wie oben gepostet) bis zu 32GB/s Performance haben, wenn die Daten "dahinter" doch auf ein und derselben SSD liegen? Hier verstehe ich offensichtlich den technischen Vorgang noch nicht, der zu dieser Vervielfachung der Performance führen soll.

(4) Wenn die hohen Performanceraten (siehe 3) möglich sind - warum kauft dann nicht jeder für 400 EUR einen HW Controller und hat eine richtig schnelle Maschine?

habe noch mal ein wenig auf der HighPoint Seite "geschmökert". Wenn ich es richtig verstehe kommt der Performancegewinn weniger durch den cache, sondern durch irgendeine Multiplikation über viele Lanes.

Kannst Du dies erklären?

(1) 960 Pro hat einen eigenen Controller/Cache, dieser ist aber unabhängig von (weiterem externem) Controller/Cache

(2) (weiterer externer) Controller / Cache erspart dem System, auf die SSD zuzugreifen, i.e. kurze Wege = Performancegewinn

(3) Controller auf dem Mainboard = SW Controller = Onboardcontroller = keine Cachenutzung, d.h. immer Zugriff auf SSD notwendig (inkl. der damit einhergehenden geringeren Performance)

(4) Optane - da analog Arbeitsspeicher - eigentlich analog Cacheprozess mit externem HW Controller (siehe 2)

weitergehende Verständnisfragen:

(1) Fängt (externer) HW Controller wirklich nur Lastspitzen oder entlastet er die SSD (durch nicht nötige Zugriffe) bei Datenvolumen < Cachegröße?

(2) Kann eine Optane (vom physischen Prozessvorgang) analog dem Cache des HW Controllers agieren? Warum schreiben dann alle Optanenutzer im Netz von Steigerungen ggü. Nutzung von "normalen" Platten, aber nicht bei M2 SSDs. Dort soll die Optane i.d.R. nichts gebracht haben. Kannst Du Dir das erklären?

(3) Wie kann ein HW Controller (wie oben gepostet) bis zu 32GB/s Performance haben, wenn die Daten "dahinter" doch auf ein und derselben SSD liegen? Hier verstehe ich offensichtlich den technischen Vorgang noch nicht, der zu dieser Vervielfachung der Performance führen soll.

(4) Wenn die hohen Performanceraten (siehe 3) möglich sind - warum kauft dann nicht jeder für 400 EUR einen HW Controller und hat eine richtig schnelle Maschine?

Ergänzung ()

habe noch mal ein wenig auf der HighPoint Seite "geschmökert". Wenn ich es richtig verstehe kommt der Performancegewinn weniger durch den cache, sondern durch irgendeine Multiplikation über viele Lanes.

Kannst Du dies erklären?

slsHyde

Commander

- Registriert

- Dez. 2014

- Beiträge

- 2.232

Der HighPoint SSD7101A-1 NVMe M.2 RAID Controller hat weder CPU noch Cache. Der würde Dir gar nichts bringen. Die theorethischen Leistungswerte betreffen die Schnittstelle. Das ist PCIe 3.0 x16. Sagt aber nur aus, wieviel maximal über die Schnittstelle möglich wäre. Sonst nichts.

Der Cache kann zum einen Daten schneller aufnehmen als der eigentliche Speicher. Die Daten werden also erst schnell im Cache abgelgt und von da aus dann erst auf den eigentlichen Speicher weitergereicht. Sobald der Cache voll ist, sinkt die Geschwindigkeit auf die eigentliche Schreibleistung des Speichers.

Im Weiteren kann der Cache Daten zum Lesen bereit halten, so dass beim nächsten Lesezugriff auf gleiche Daten die Leseperformance höher ist.

Beide Effekte wirken nur kurzfristig. Bei Dir aber scheint die Gesamtmenge der zu bearbeitenden Daten klein genug zu sein, dass der komplette Vorgang im Cache abläuft. Das ist weit vom Normalfall entfernt.

Im Weiteren hängt dann die Performance von der Leistungsfähigkeit der Laufwerke selber ab und davon, wie diese geschaltet werden. Es gibt verschieden RAID-Modi, die Festplatten derart kombinieren, dass entweder die Performance steigt und oder Redundanz, also Ausfallschutz entsteht.

Ergänzung ()

Der Cache kann zum einen Daten schneller aufnehmen als der eigentliche Speicher. Die Daten werden also erst schnell im Cache abgelgt und von da aus dann erst auf den eigentlichen Speicher weitergereicht. Sobald der Cache voll ist, sinkt die Geschwindigkeit auf die eigentliche Schreibleistung des Speichers.

Im Weiteren kann der Cache Daten zum Lesen bereit halten, so dass beim nächsten Lesezugriff auf gleiche Daten die Leseperformance höher ist.

Beide Effekte wirken nur kurzfristig. Bei Dir aber scheint die Gesamtmenge der zu bearbeitenden Daten klein genug zu sein, dass der komplette Vorgang im Cache abläuft. Das ist weit vom Normalfall entfernt.

Im Weiteren hängt dann die Performance von der Leistungsfähigkeit der Laufwerke selber ab und davon, wie diese geschaltet werden. Es gibt verschieden RAID-Modi, die Festplatten derart kombinieren, dass entweder die Performance steigt und oder Redundanz, also Ausfallschutz entsteht.

Piktogramm

Fleet Admiral

- Registriert

- Okt. 2008

- Beiträge

- 10.099

slsHyde schrieb:[...]Mit einer zusätzlichen CPU auf einer Steckkarte kann das deutlich beschleunigt werden. Ohne RAID oder bei einfachen RAIDs ist die benötigte Rechenleistung bedeutend geringer. Die CPU eines Rechners ist mit dem kompexeren RAIDs schnell überfordert[...]

Das Stimmt so heutzutage nicht mehr. Jeder poplige Intel Atom schafft auf einem einzelnem Kern einen Durchsatz von über 4GB/s* für Raid5. AVX2 fähige CPUs schaffen in der Regel je Takt mindestens den doppelten Durchsatz und AVX512 fähige CPUs verdoppeln diesen Durchsatz nochmals.

Genauso wie Cachingfunktionalität heute über Software abgewickelt wird. Vorzugsweise direkt aus dem RAM der CPU oder aber großen SSDs. Diese Lösungen sind auf jeden fall besser als die 128MB-1024MB "Cache" der dicken. Was sogar soweit geht, dass es mittlerweile für Server Controller mit eingebautem SSD-Cache gibt, den man jedoch üblicherweise via Software ansteuert.

Edit: Normalerweise sind die "Caches" auf den Controllerkarten und auch auf den meisten Consumer SSDs vor allem da um Daten zur Verwaltung des Arrays und zur Berechnung zwischenzuspeichern. Caching findet da nicht großartig statt. Dazu ist da einfach zu wenig Ram auf den Karten. Vor allem im Vergleich zum Ram des eigentlichen Systems (300€ in Ram investiert anstatt in einen Raid Controller mit 1GB Cache, da ist klar wo der Preis-Leistungssieger in Sachen Caching ausschaut)

Bevor man also für Sata Controller Geld ausgibt sollte man das gut begründen können.

* AMD Athlon 5150 mit 1,6GHz schafft über mdadm (Linux Softwareraid) 3,5GB/s

Zuletzt bearbeitet:

slsHyde

Commander

- Registriert

- Dez. 2014

- Beiträge

- 2.232

JaKuE schrieb:(3) Wie kann ein HW Controller (wie oben gepostet) bis zu 32GB/s Performance haben, wenn die Daten "dahinter" doch auf ein und derselben SSD liegen? Hier verstehe ich offensichtlich den technischen Vorgang noch nicht, der zu dieser Vervielfachung der Performance führen soll.

Das fehlende Verständnis betrifft nicht die Technik sondern die Irreführung durch Werbesprüche. Das geht natürlich nicht. Hier wird die maximal mögliche Schnittstellenbandbreite als Leistung beworben (was auch zunächst richtig ist), aber derart, dass es leicht missverstanden werden kann. Klingt halt toll. Die Schnittstelle jedenfalls bremst da nicht.

Ergänzung ()

@ Pictogram

Es geht nicht darum, was die CPU schaffen kann. Auf den Controllern sind ja auch eher kleine Prozessoren, teils sogar Atom oder Celeron 2 Kerner. Dennoch können die das schneller als eine wesentlich leistungsfähigere CPU mit zahlreichen Kernen, höherer Drehzahl, etc. Da liegt eben auch kein Betriebssystem zwischen sondern das läuft wesentlich hardwarenäher.

Wenn eine 960 Pro hier zu langsam ist, wird es wenig bringen, einen SSD-Cache davor zu schalten. Das macht man teils, richtig, um einfach noch mal größeren Cache bei HDD-Raids zu haben, und dann auch nicht nur das ein oder ander GB sondern richrig viel. Aber auch die Controller die so was steuern haben noch Cache aus meist DDR3 1866 drauf - und brauchen den auch.

Softwarelösung um den RAM als Cache für die SSD zu nutzen hatte ich ja schon vorgeschlagen. Wir müssen nur noch eine Software auswählen und ich bin heute etwas limitiert bei 250 km/h.

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 6

- Aufrufe

- 1.135

- Antworten

- 7

- Aufrufe

- 1.049

- Antworten

- 28

- Aufrufe

- 12.145

- Antworten

- 6

- Aufrufe

- 1.831