Crys

Lt. Commander

- Registriert

- Apr. 2009

- Beiträge

- 1.634

Hallo miteinander,

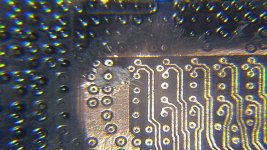

ich habe mich auf ein Experiment eingelassen und in mein altes System eine PCIe NVMe SSD installiert, direkt im zweiten PCIe (Version 3) x16 Slot.

Wohl im Wissen, dass wenn bei mir beide PCIe x16 belegt sind, beide auf 8x herunterfahren.

Installiert ist u. A. eine GTX 1070 und im anderen PCIe ein PCIe-x4 auf m.2 Adapter, mit einer Evo 970 Pro.

Alles läuft toll: Die Evo bringt volle Leistung ... und die Grafikkarte auch ... was mich verwundert.

Ich habe den Time Spy Test in 3D Mark (Steam Demo) gemacht und FurMark.

Im Unterschied von installiertem PCIe-Adapter (und damit x8 Grafikkarte) zu vollen x16 Lanes sind es nur 0,01-4% Minderleistung in beiden Test, bei je 10 Durchläufen. Es wird auch Softwareseitig erkannt, dass nur x8 Lanes der Grafikkarte zur Verfügung stehen.

Gibt es einen Test, der speziell den Datendurchsatz bei der installierten Grafikkarte testet?

Hättet ihr auch mit so wenig Verlust (bei halber Schnittstelle) gerechnet?

ich habe mich auf ein Experiment eingelassen und in mein altes System eine PCIe NVMe SSD installiert, direkt im zweiten PCIe (Version 3) x16 Slot.

Wohl im Wissen, dass wenn bei mir beide PCIe x16 belegt sind, beide auf 8x herunterfahren.

Installiert ist u. A. eine GTX 1070 und im anderen PCIe ein PCIe-x4 auf m.2 Adapter, mit einer Evo 970 Pro.

Alles läuft toll: Die Evo bringt volle Leistung ... und die Grafikkarte auch ... was mich verwundert.

Ich habe den Time Spy Test in 3D Mark (Steam Demo) gemacht und FurMark.

Im Unterschied von installiertem PCIe-Adapter (und damit x8 Grafikkarte) zu vollen x16 Lanes sind es nur 0,01-4% Minderleistung in beiden Test, bei je 10 Durchläufen. Es wird auch Softwareseitig erkannt, dass nur x8 Lanes der Grafikkarte zur Verfügung stehen.

Gibt es einen Test, der speziell den Datendurchsatz bei der installierten Grafikkarte testet?

Hättet ihr auch mit so wenig Verlust (bei halber Schnittstelle) gerechnet?