Ich habe mir heute den 64GB Cruzer Extreme (USB 3.0-Stick) geholt und bin soweit auch zufrieden.

Große Dateien kopiert er zügig und auch bei einem Ordner mit vielen Fotos war der Kopiervorgang schnell.

Habe den Stick auch mit H2testw getestet und es wurde kein Fehler festgestellt.

Der Stick konnte voll geschrieben und wieder richtig gelesen werden:

Achtung: Nur 61026 von 61035 MByte getestet.

Fertig, kein Fehler aufgetreten.

Sie können die Testdateien *.h2w jetzt löschen oder nach Belieben

nochmals überprüfen.

Schreibrate: 151 MByte/s

Leserate: 157 MByte/s

H2testw v1.4

Aaaaber:

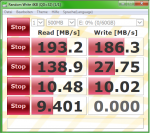

Wenn ich den Stick mit CrystalDiskMark teste, dann gehen die ersten 3 Tests gut, aber der letzte Test stürzt immer ab

Beim letzten Write-test, bricht der Test ab und das Licht des USB-Sticks geht aus... und das reproduzierbar (egal ob 500MB/2GB usw..)

Interessanterweise wird der Stick noch unter "Computer" angezeigt und ich kann sogar was drauf kopieren.

Soll ich den Stick lieber tauschen oder ist die CrystalDiskMark nicht für USB-Sticks geeignet?

LG

- L1nus

Große Dateien kopiert er zügig und auch bei einem Ordner mit vielen Fotos war der Kopiervorgang schnell.

Habe den Stick auch mit H2testw getestet und es wurde kein Fehler festgestellt.

Der Stick konnte voll geschrieben und wieder richtig gelesen werden:

Achtung: Nur 61026 von 61035 MByte getestet.

Fertig, kein Fehler aufgetreten.

Sie können die Testdateien *.h2w jetzt löschen oder nach Belieben

nochmals überprüfen.

Schreibrate: 151 MByte/s

Leserate: 157 MByte/s

H2testw v1.4

Aaaaber:

Wenn ich den Stick mit CrystalDiskMark teste, dann gehen die ersten 3 Tests gut, aber der letzte Test stürzt immer ab

Beim letzten Write-test, bricht der Test ab und das Licht des USB-Sticks geht aus... und das reproduzierbar (egal ob 500MB/2GB usw..)

Interessanterweise wird der Stick noch unter "Computer" angezeigt und ich kann sogar was drauf kopieren.

Soll ich den Stick lieber tauschen oder ist die CrystalDiskMark nicht für USB-Sticks geeignet?

LG

- L1nus