Optisch und technisch eine schöne Grafikkarte, gar keine Frage. Ich finde man hätte sie Titan Black nennen sollen und nicht die andere da, die gar nicht black ist ^^

ABer wer hätte 2012 gedacht, dass es noch 60-70% schnellere GPUs in 28nm geben, die kaum mehr verbrauchen

Aber wie bei allen Grafikkarten-Tests von CB gibt es auch hier einiges, was man hinterfragen kann. Die Leistungsratings (1600p und UHD) machen den Eindruck, als ob die Titan X fast genauso schnell wäre wie die 295X2. Doch wenn man sich die Einzeltests anguckt, vor allem auf anderen Seiten, dann ist die 295X2 noch immer ziemlich deutlich schneller. Hier zB

http://www.tomshardware.de/nvidia-geforce-gtx-titan-x-gm200-maxwell,testberichte-241762-3.html

oder hier

http://www.techpowerup.com/reviews/NVIDIA/GeForce_GTX_Titan_X/18.html

BF4, 295X2 22 bzw 25% schneller (1440p bzw 2160p)

FC4 295X2 32% bzw 58% schneller,

Metro LL 28% bzw 42% schneller,

Mittelerde 12 bzw 19% schneller,

Thief 11 bzw 39% schneller,

Tomb Raider 32 bzw 39% schneller

Ryse 28 bzw 40% schneller

Dragon Age Inquisition 25% bzw 22% schneller

Alien Isolation 20 bzw 38% schneller

Also knapp vorne sieht anders aus. Und dass sie mit 2 Hawaii GPUs gerade einmal ~50% schneller sein soll als eine 290X, kann auch irgendwie nicht sein...

Ich bin generell kein Freund von Leistungsratings, die sind doch nur für die jenigen, die zu faul sind sich ein eigenes Bild von der Leistung zu machen. Und wie man sieht, ist die Aussagekraft wirklich gering. Es kann immer wieder 1-2 Spiele geben, in denen manche GPUs unterirdisch performen, was die Gesamtleistung in so einem Rating entscheidend beeinflussen kann. Die meisten Reviewer machen keine Gesamtperformance-Diagramme, warum könnt ihr nicht darauf verzichten? Oder zumindest deutlich machen, dass diese nicht unbedigt der realen Leistung entsprechen?

Und wie wäre es mal mit ein paar aktuelleren Spielen? Wie viele sind denn da aus dem vergangenen Jahr? 3? Das ist doch lächerlich...Weiterhin FC3 statt FC4, weiterhin CoD Ghosts statt AW, immer noch AC4 statt AC Unity, kein Dragon Age, kein Dying Light, kein Ryse, kein Evolve. Oder liegt das etwa daran, dass man weiterhin nur die neue Karte testet und alle anderen Werte, die mit veralteten Treibern entstanden sind, einfach übernommen werden? Danach sieht es nämlich aus

Also das und die Tatsache, dass die Leistungsratings auf älteren Spielen basieren, macht sie noch weniger brauchbar.

Außerdem verstehe ich den Sinn der 4xAA 2160p Benchmarks nicht. 1. 4xAA UND 2160p ist dann doch etwas absurd übertrieben und 2. praktisch mit jeder Karte unspielbar. Und vielleicht solltet ihr die Benchmarkszene in Crysis 3 wechseln? Wenn man selbst mit ner TItanx selbst in 1080p keine 60 fps erreicht... Eine typische Spielszene ist das sicher nicht.

Was mich überrascht ist die schlechte Skalierung der Maxwell Architektur. Der GM200 ist ganze 203mm² größer als der GM204, hat 50% mehr SPs, ist aber in 1600p (wo Spiele noch gut spielbar sind) nur ca. 30-35% schneller. Bei 50% mehr Recheneinheiten hatte ich mit mindestens 40% mehr Leistung gerechnet.

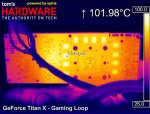

Außerdem könnte man als Minuspunkt die glühend heißen Speicherchips auf der Rückseite der Karte erwähnen können. 102²C ist schon heftig:

Und der Preis ist natürlich wieder einmal jenseits von Gut und Böse. Aber diesmal verstehe ich ihn überhaupt nicht. Damals hieß es ja noch, tralala günstig für semiprofisionelle Zwecke und blabla mit Abstand die schnellste. Jetzt ist sie aufgrund der sehr geringen DP Leistung für Profis nicht wirklich zu gebrauchen und mit Fiji kommt demnächst ein Chip, der in etwa gleich schnell, wenn nicht schneller ist. Für ein paar Hundert € weniger. Ist man bei Nvidia echt der Meinung, der Preis sei aufgrund des völlig überdimensionierten Speichers angemessen?