Hallo,

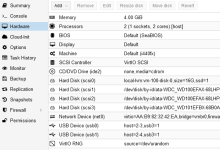

ich betreibe hier einen, zugegebenermaßen ziemlich schwachen kleinen Proxmox "Server" (AMD A4-5000 APU mit 8 GB Ram, 750 GB HDD für Proxmox + VMs, 2x3 TB Datenplatten).

Die Datenplatten sind grundsätzlich unabhängig von Proxmox. Ich habe sie einfach per SAMBA als Netzwerklaufwerke freigegeben, sie werden aber in Proxmox nicht genutzt. Da sie schon vorher voll waren, habe ich sie per NTFS eingebunden.

Zusätzlich hatte ich noch zwei 3 TB Platten in meinem Gaming PC und habe je zwei Platten 1:1 als Backup gespiegelt.

Eine der 3 TB Platten hat nun aufgegeben, ehrlich gesagt sind die Daten aber auch nicht wirklich wichtig, ein 1:1 Backup ist definitiv nicht nötig, hatte die Platten aber halt über.

Ich überlege das Ganze nun umzugestalten und ggf. die 3 TB Platten aus meinem Gaming PC zu verbannen.

Was ich gerne hätte: die drei 3 TB Platten im Proxmox Server, als ein übergreifendes Volume mit 6 TB nutzbar und einem Laufwerk für Parität. Performance ist nicht wichtig, der Zugriff erfolgt praktisch nur über WLAN. Disk Spindown muss möglich sein, da Zugriff auf die Daten nur selten erfolgt. Zudem möchte ich es gerne in Proxmox einbinden, um z.B. Backups der VMs in Proxmox direkt dort ablegen zu können.

Im Gaming PC werden dann nur noch die wirklich wichtigen Daten gesichert.

Wie würdet ihr das lösen?

1. ZFS direkt unter Proxmox mit RaidZ-1 Konfigurationen. Hätte ich grundsätzlich das beste Gefühlt mit aufgrund der nativen Unterstützung, aber ich ja zwangsläufig formatieren und habe aktuell keinen Speicher zum Auslagern.

2. früher habe ich, allerdings im Windows PC, mal Snapraid genutzt. Zusammen mir mergefs sollte damit auch ein übergreifendes Volume möglich sein. Allerdings weiß ich nicht, ob das auch mit NTFS funktioniert unter Proxmox/Debian?Wenn nicht gibt es aus meiner Sicht keinen Vorteil ggü. 1.

3. etwas ganz anderes?

Was meint ihr dazu?

Gruß

Fabian

ich betreibe hier einen, zugegebenermaßen ziemlich schwachen kleinen Proxmox "Server" (AMD A4-5000 APU mit 8 GB Ram, 750 GB HDD für Proxmox + VMs, 2x3 TB Datenplatten).

Die Datenplatten sind grundsätzlich unabhängig von Proxmox. Ich habe sie einfach per SAMBA als Netzwerklaufwerke freigegeben, sie werden aber in Proxmox nicht genutzt. Da sie schon vorher voll waren, habe ich sie per NTFS eingebunden.

Zusätzlich hatte ich noch zwei 3 TB Platten in meinem Gaming PC und habe je zwei Platten 1:1 als Backup gespiegelt.

Eine der 3 TB Platten hat nun aufgegeben, ehrlich gesagt sind die Daten aber auch nicht wirklich wichtig, ein 1:1 Backup ist definitiv nicht nötig, hatte die Platten aber halt über.

Ich überlege das Ganze nun umzugestalten und ggf. die 3 TB Platten aus meinem Gaming PC zu verbannen.

Was ich gerne hätte: die drei 3 TB Platten im Proxmox Server, als ein übergreifendes Volume mit 6 TB nutzbar und einem Laufwerk für Parität. Performance ist nicht wichtig, der Zugriff erfolgt praktisch nur über WLAN. Disk Spindown muss möglich sein, da Zugriff auf die Daten nur selten erfolgt. Zudem möchte ich es gerne in Proxmox einbinden, um z.B. Backups der VMs in Proxmox direkt dort ablegen zu können.

Im Gaming PC werden dann nur noch die wirklich wichtigen Daten gesichert.

Wie würdet ihr das lösen?

1. ZFS direkt unter Proxmox mit RaidZ-1 Konfigurationen. Hätte ich grundsätzlich das beste Gefühlt mit aufgrund der nativen Unterstützung, aber ich ja zwangsläufig formatieren und habe aktuell keinen Speicher zum Auslagern.

2. früher habe ich, allerdings im Windows PC, mal Snapraid genutzt. Zusammen mir mergefs sollte damit auch ein übergreifendes Volume möglich sein. Allerdings weiß ich nicht, ob das auch mit NTFS funktioniert unter Proxmox/Debian?Wenn nicht gibt es aus meiner Sicht keinen Vorteil ggü. 1.

3. etwas ganz anderes?

Was meint ihr dazu?

Gruß

Fabian