Kagee

Lt. Junior Grade

- Registriert

- Feb. 2005

- Beiträge

- 428

Ich suche derzeit nach einer Synchronisationslösung für mein Heimnetz. In diesem Thread wurde eine schöne Liste mit Tools gepostet, aber so richtig passt keine davon. Ich bin aber auch offen für Vorschläge eventuell eine Dinge am Ist-Zustand zu ändern. "Hauptproblem" ist die Verschlüsselung die ich einsetze. Aber der Reihe nach. Folgendes ist die Situation:

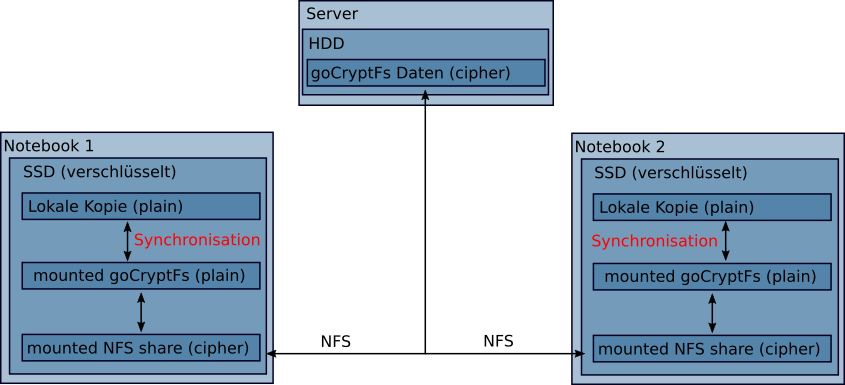

Ich habe einen Server, der Kubuntu ausführt und in dem die Massenspeicher verbaut sind. Daneben gibt es zwei Notebooks im Netzwerk, auf denen auch ein Debian-Linux läuft. Der Server gibt ein Benutzerlaufwerk per NFSv4 frei, auf das beide Notebooks zugreifen. Dieses share beinhaltet aber ein GoCryptFs-System, welches nur auf den (verschlüsselten) Notebooks entschlüsselt wird. Daher kennt der Server keinerlei Inhalte, sonder kann maximal die Timestamps der einzelnen verschlüsselten Dateien sehen. Der Server Backupt dieses Dateisystem auf andere Laufwerke.

Nun zu meinem Problem: Wenn zwei Notebooks auf dieselben Dateien zugreifen, kann es ja passieren, dass zwischen zwei Server-Syncs beide Notebooks dieselbe Datei bearbeiten und somit zwei neue Stände erzeugen, die einen Konflikt verursachen. Prinzipiell benutzt man ja für sowas SVN o.ä. In meinem Szenario wären die ganzen Datei-Vergleichs-Features ja aber hinfällig, weil der Server die Daten ja gar nicht einsehen kann. Jeglicher Vergleich von Inhalten kann also nur auf den Notebooks stattfinden.

Gibt es eine Software, die ich auf den Notebooks ausführen kann, die das managen kann? In meiner Vorstellung müsste auf den Notebooks irgendwo (interne Datenbank oder in den Verzeichnissen selbst) hinterlegt werden mit welchem Timestamp die Datei vom Server geholt wurde. Wenn zum Zeitpunkt des Rückspielens dieser nicht mehr übereinstimmt, müsste die ältere der beiden "neuen" Versionen irgendwo hin kopiert werden.

Edit: Eine Übersicht über die Topologie:

Ich habe einen Server, der Kubuntu ausführt und in dem die Massenspeicher verbaut sind. Daneben gibt es zwei Notebooks im Netzwerk, auf denen auch ein Debian-Linux läuft. Der Server gibt ein Benutzerlaufwerk per NFSv4 frei, auf das beide Notebooks zugreifen. Dieses share beinhaltet aber ein GoCryptFs-System, welches nur auf den (verschlüsselten) Notebooks entschlüsselt wird. Daher kennt der Server keinerlei Inhalte, sonder kann maximal die Timestamps der einzelnen verschlüsselten Dateien sehen. Der Server Backupt dieses Dateisystem auf andere Laufwerke.

Nun zu meinem Problem: Wenn zwei Notebooks auf dieselben Dateien zugreifen, kann es ja passieren, dass zwischen zwei Server-Syncs beide Notebooks dieselbe Datei bearbeiten und somit zwei neue Stände erzeugen, die einen Konflikt verursachen. Prinzipiell benutzt man ja für sowas SVN o.ä. In meinem Szenario wären die ganzen Datei-Vergleichs-Features ja aber hinfällig, weil der Server die Daten ja gar nicht einsehen kann. Jeglicher Vergleich von Inhalten kann also nur auf den Notebooks stattfinden.

Gibt es eine Software, die ich auf den Notebooks ausführen kann, die das managen kann? In meiner Vorstellung müsste auf den Notebooks irgendwo (interne Datenbank oder in den Verzeichnissen selbst) hinterlegt werden mit welchem Timestamp die Datei vom Server geholt wurde. Wenn zum Zeitpunkt des Rückspielens dieser nicht mehr übereinstimmt, müsste die ältere der beiden "neuen" Versionen irgendwo hin kopiert werden.

Edit: Eine Übersicht über die Topologie:

Zuletzt bearbeitet: