Hallo Zusammen,

seit vielen Jahre verfolge ich hier schon die Community, aber bisher wusste ich nicht so recht, ob ich da was sinnvolles beitragen kann.

Aber da ich im Internet nichts gefunden habe, wo jemand diese Kombo schonmal versucht hat, dachte ich schreibe ein bisschen was dazu.

Kleine Einleitung:

Normalerweise ist mein 2. PC immer die Hardware, die im Main PC rausfliegt, ich denke dieses System haben viele.

Irgendwann kam ich zufällig mal in GPU-Z in die Sektion rein, wo dran steht ob resizable-bar funktioniert und ich war überrascht, das bei Board und CPU kompatibel dranstand. (B450 Mainboard)

(muss wohl bei irgend einem BIOS update dazugekommen sein)

Ich wollte immer schonmal aus purer Neugierde ne ARC ausprobieren, aber das scheiterte immer daran, das ich die in den Main-PC hätte einbauen müssen und den wollte ich jetzt nicht unbedingt downgraden

Naja Arc 770 16GB bestellt, alte 1080ti raus, DDU durchlaufen lassen und auf der Intel Seite ne weile nach dem Treiber gesucht.

Ehrlich, ich hab schon übersichtlichere Downloadportale erlebt. (#Hust# AMD/Nvidia)

Und ähm... funktioniert wunderbar.

(Natürlich gleich mal die Farbe auf rot stellen )

)

Bin selber etwas überrascht, aber bis auf die Tatsache, das bei Tempest Rising Schienen nicht gerendert werden und es aussieht als würden die Züge über den normalen Boden fahren, läuft die Karte bisher ohne Probleme.

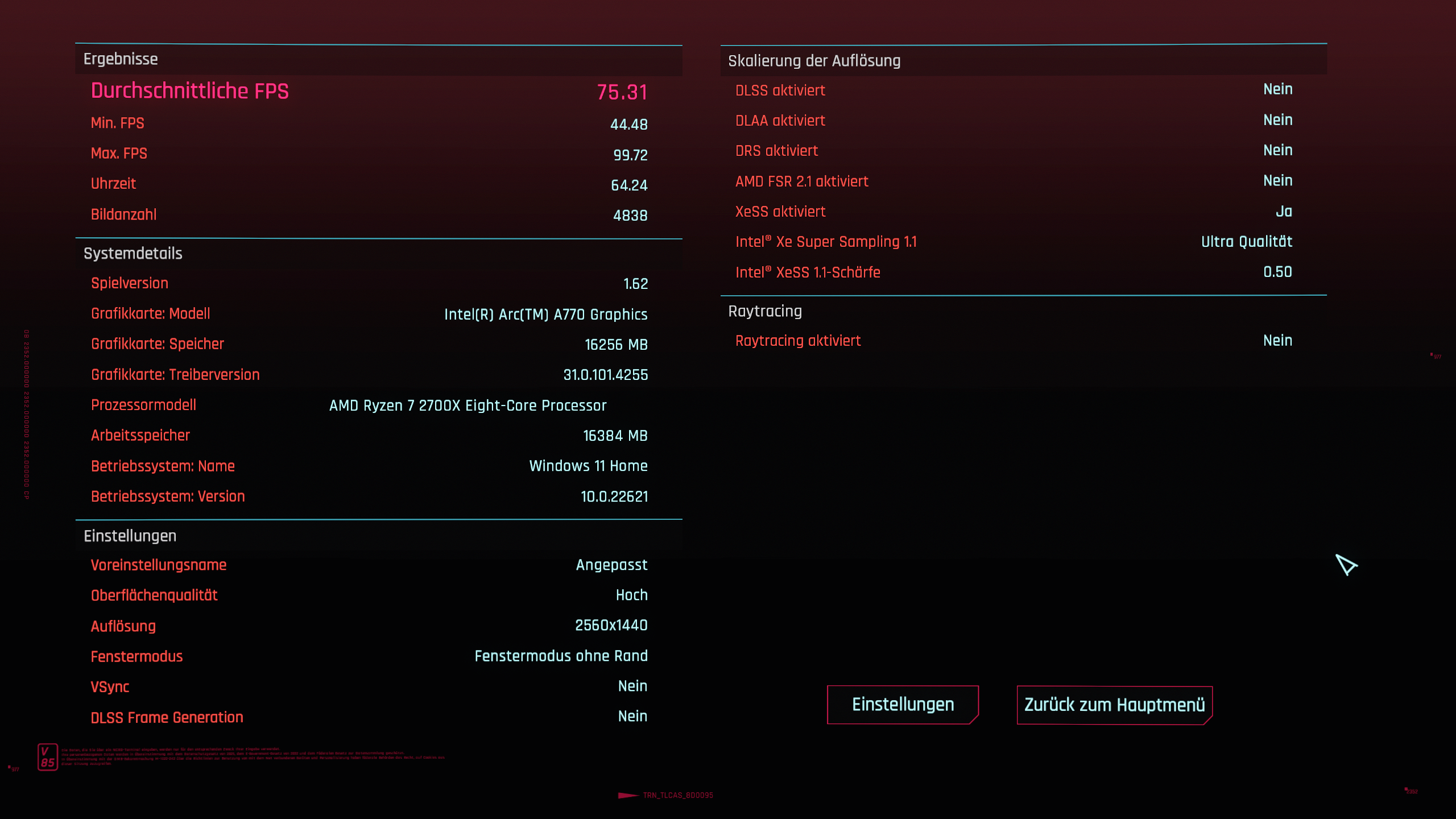

Selbst Cyberpunk 1440p schafft sie gut:

(Das ist hier ein wilder mix an Settings und kein Preset. Ist also nicht vergleichbar mit anderen Benchmarks)

Selbst wenn ich RT Reflektionen anschalte sinds dann noch ca 45 FPS.

Irgendwie interessant, das auch wenn der 2700X von Intel offiziell nicht supported ist, der entscheidende Faktor wirklich nur ReBar zu sein scheint und solange das System das hat ist alles easy.

Hab noch nie für nen 2. PC irgendwelche Hardware gekauft, ist ja normalerweise eher die Zweitverwertung aus dem Main PC.

Aber hat auch was, auf der ersten "Mainstream" Gaming Grafikkarte zu zocken die Intel jemals produziert hat.

(Ich weis da gabs schon frühere Versuche, aber das waren ja nicht gerade normale consumer Produkte)

Naja was denkt Ihr so, wird das noch was mit den Intel Karten?

Ich finde bisher siehts ganz gut aus und wenn man sieht wie schwer sich selbst ein Gigant wie Intel tut, sieht man erstmal wie schwierig es ist da einzusteigen.

Ist noch kein Meister vom Himmel gefallen und ich hoffe sie bleiben am Ball. Das wird schon.

na dann bin mal weg, cya.

seit vielen Jahre verfolge ich hier schon die Community, aber bisher wusste ich nicht so recht, ob ich da was sinnvolles beitragen kann.

Aber da ich im Internet nichts gefunden habe, wo jemand diese Kombo schonmal versucht hat, dachte ich schreibe ein bisschen was dazu.

Kleine Einleitung:

Normalerweise ist mein 2. PC immer die Hardware, die im Main PC rausfliegt, ich denke dieses System haben viele.

Irgendwann kam ich zufällig mal in GPU-Z in die Sektion rein, wo dran steht ob resizable-bar funktioniert und ich war überrascht, das bei Board und CPU kompatibel dranstand. (B450 Mainboard)

(muss wohl bei irgend einem BIOS update dazugekommen sein)

Ich wollte immer schonmal aus purer Neugierde ne ARC ausprobieren, aber das scheiterte immer daran, das ich die in den Main-PC hätte einbauen müssen und den wollte ich jetzt nicht unbedingt downgraden

Naja Arc 770 16GB bestellt, alte 1080ti raus, DDU durchlaufen lassen und auf der Intel Seite ne weile nach dem Treiber gesucht.

Ehrlich, ich hab schon übersichtlichere Downloadportale erlebt. (#Hust# AMD/Nvidia)

Und ähm... funktioniert wunderbar.

(Natürlich gleich mal die Farbe auf rot stellen

Bin selber etwas überrascht, aber bis auf die Tatsache, das bei Tempest Rising Schienen nicht gerendert werden und es aussieht als würden die Züge über den normalen Boden fahren, läuft die Karte bisher ohne Probleme.

Selbst Cyberpunk 1440p schafft sie gut:

(Das ist hier ein wilder mix an Settings und kein Preset. Ist also nicht vergleichbar mit anderen Benchmarks)

Selbst wenn ich RT Reflektionen anschalte sinds dann noch ca 45 FPS.

Irgendwie interessant, das auch wenn der 2700X von Intel offiziell nicht supported ist, der entscheidende Faktor wirklich nur ReBar zu sein scheint und solange das System das hat ist alles easy.

Hab noch nie für nen 2. PC irgendwelche Hardware gekauft, ist ja normalerweise eher die Zweitverwertung aus dem Main PC.

Aber hat auch was, auf der ersten "Mainstream" Gaming Grafikkarte zu zocken die Intel jemals produziert hat.

(Ich weis da gabs schon frühere Versuche, aber das waren ja nicht gerade normale consumer Produkte)

Naja was denkt Ihr so, wird das noch was mit den Intel Karten?

Ich finde bisher siehts ganz gut aus und wenn man sieht wie schwer sich selbst ein Gigant wie Intel tut, sieht man erstmal wie schwierig es ist da einzusteigen.

Ist noch kein Meister vom Himmel gefallen und ich hoffe sie bleiben am Ball. Das wird schon.

na dann bin mal weg, cya.