Hot Chips: Riesige Chips von IBM & Intel und ein Monster von Cerebras

Groß und noch größer heißt es zur Konferenz Hot Chips. IBMs Power 9 AIO sowie Spring Crest von Intel finden dabei aber ihren Meister in einem für Künstliche Intelligenz entwickelten Produkt, das den größten bisher gefertigten Chip hervorbringt, der die Größe eines iPads aufweisen soll.

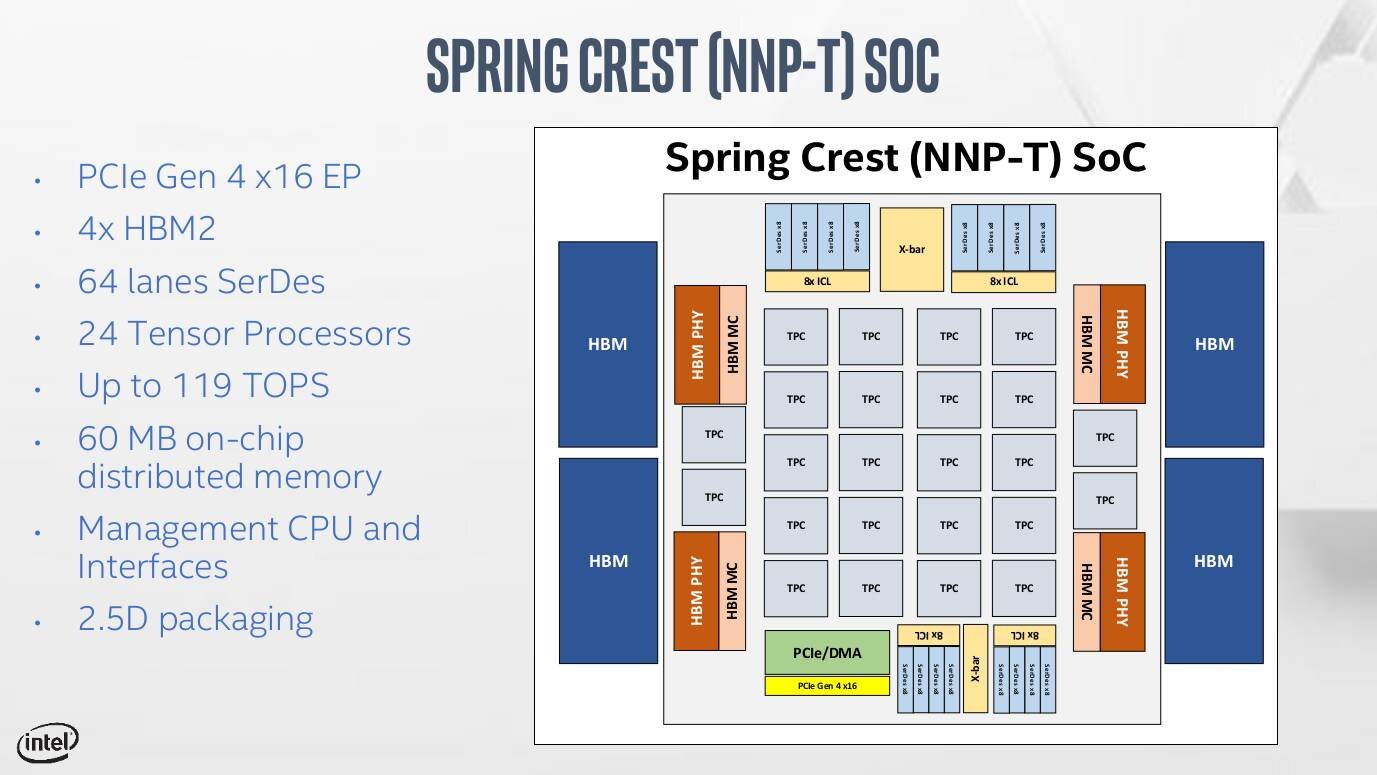

Intels Training-Chip kommt von TSMC

680 mm² Die-Fläche auf einem 1.200 mm² Interposer, so sieht Intels bereits bekannter Ansatz für Spring Crest aus. Die interessante Note dabei: Die Fertigung übernimmt TSMC in 16 nm, die das 27-Milliarden-Transistoren-Monster mit guten Yields bereitstellen soll. Im kommenden Jahr sollen die ersten Lösungen des NNP-T getauften Produkts (früher NNP-L) verfügbar werden und gegen Nvidias Lösungen im Markt des Maschinellen Lernens für das sogenannte Training antreten.

Vor Power 10 kommt von IBM Power 9 AIO

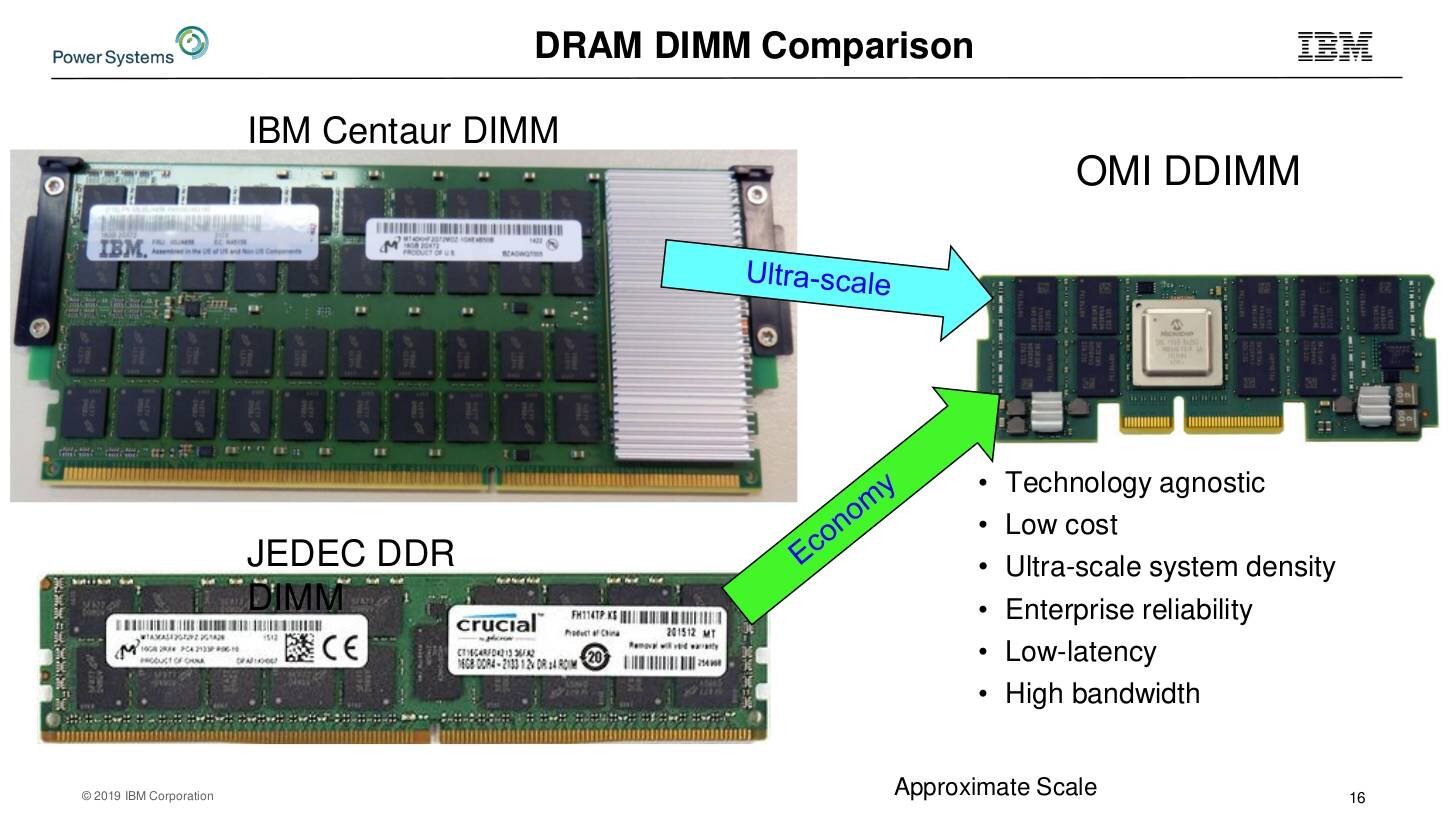

IBM hat zur Hot Chips keinen Power 10 im Gepäck – der kommt laut Roadmap im Jahr 2021 – sondern die nächste Ausbaustufe des Power 9. Die 728 mm² große Variante Advanced IO (AIO) erfährt die größten Anpassungen beim Speicherinterface. Das neue Open Memory Interface (OMI) sorgt mit einem 16-Kanal-Speicherinterface für im Serverbereich bisher noch nicht dagewesene Bandbreite von über 650 GB/s. OMI-DIMMs sind neu und sehr speziell, doch das hat Big Blue bisher noch nie von eigenen Wegen abgehalten, wenngleich der Marktanteil von Power weltweit auf nur noch 0,2 Prozent gesunken ist. Ein OMI-kompatibler Controller soll als Alternative dafür sorgen, dass auch weiterhin normale DDR-DIMMs genutzt werden können.

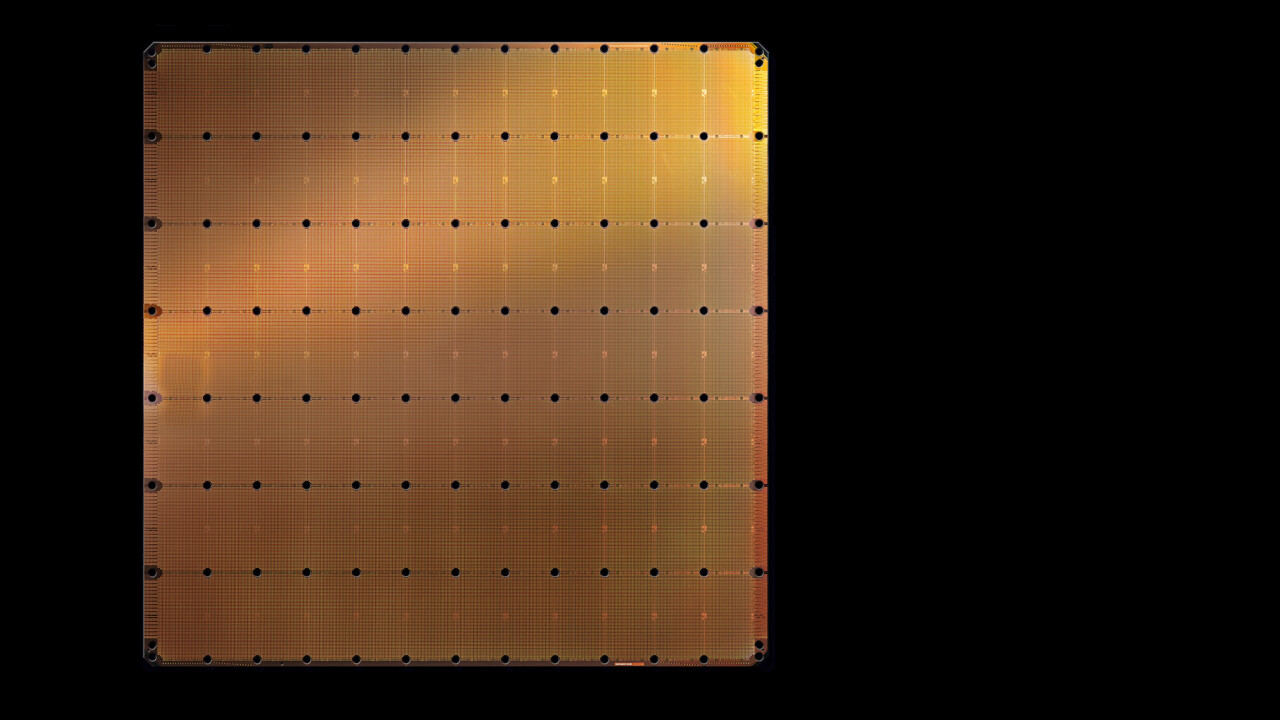

Ein Chip pro Wafer: Das Monster von Cerebras

Den unbestritten interessantesten Auftritt machte das Startup Cerebras. Sie zeigten einen Chip mit Kantenlängen von 21,5 cm – dies ist kein Schreibfehler. Von diesem 46.225 mm² großen Chip, der 1,2 Billionen Transistoren besitzt, lässt sich exakt ein einziger von einem 300-mm-Wafer ziehen – auch hier kommt TSMCs 16-nm-Fertigung zum Einsatz. Heraus kommen so 400.000 spezielle AI-Cores und satte 18 GByte an SRAM als schneller Speicher, das alles soll über ein Mesh-Interconnect miteinander kommunizieren.

Das laut Analysten wohl vermutlich Hunderttausende wenn nicht gar Millionen US-Dollar kostende System mit diesem Chip braucht zudem eine komplett eigene Infrastruktur. Hier bleibt abzuwarten, wie dies in Zukunft aussehen wird. Gern werden innovative Startups, die auf solchen Konferenzen ihre Produkte erstmals präsentieren, von größeren Firmen aufgekauft, die das Know-How dann in ihr Portfolio mehr oder weniger umfangreich integrieren.