- Registriert

- Okt. 2007

- Beiträge

- 1.437

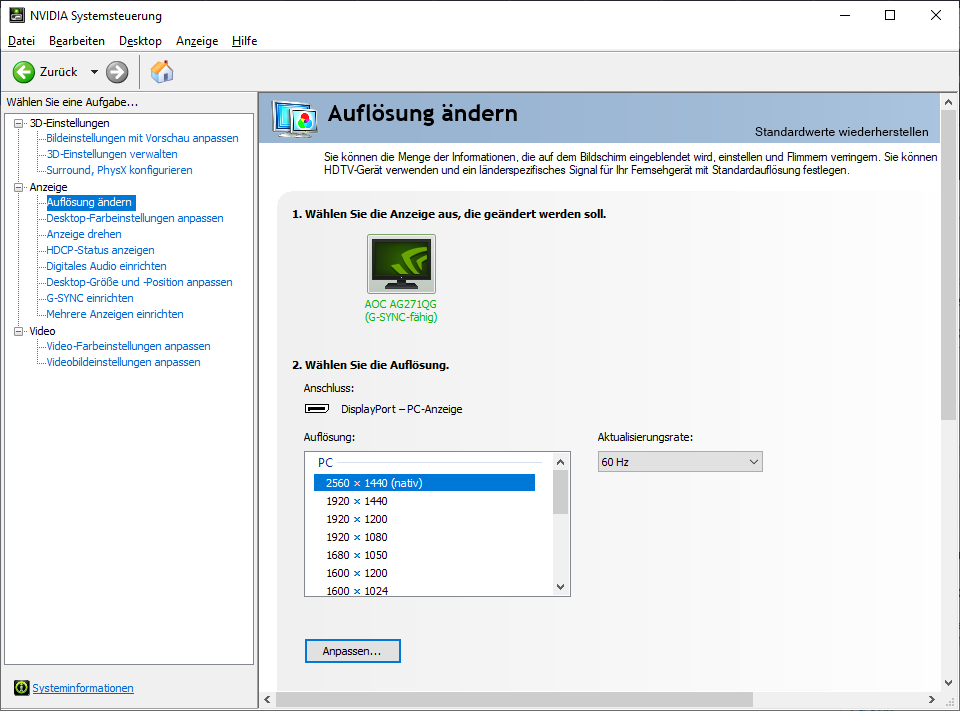

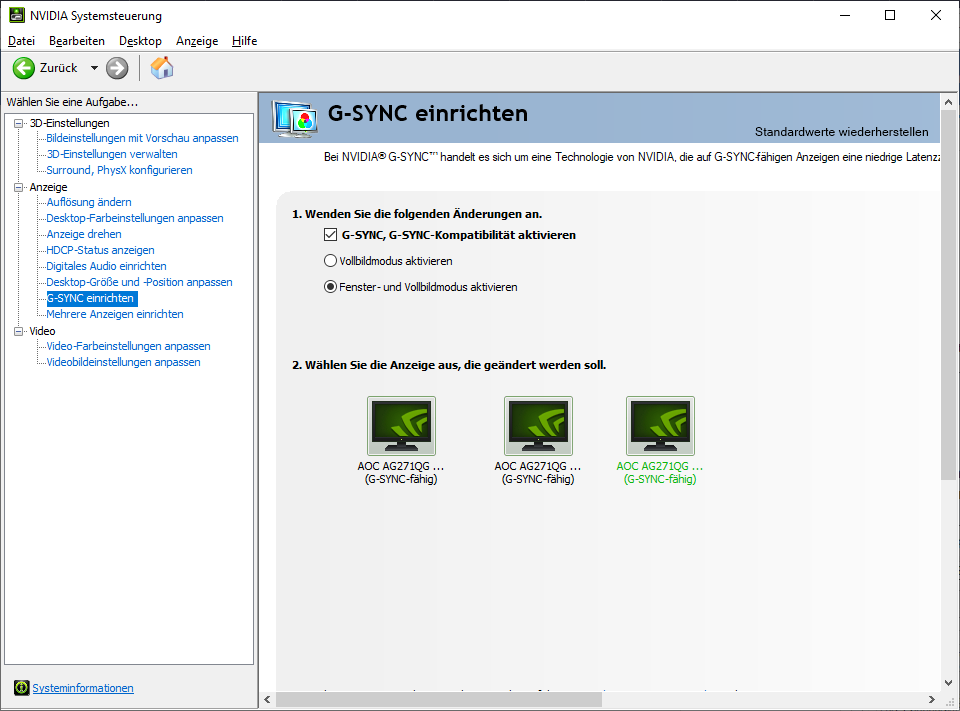

So ich habe nun endlich die NVIDIA Systemsteuerung wieder gefunden. Rechtsklick auf Desktop und ab geht's.

Auch mit drei Bildschirmen @ 1440p und 60 Hz als auch mit einem TFT mit 1440p @ 60 Hz (nach Hard Reboot) kommt die MSI 3090 nie unter 49/50°C und die Lüfter der Grafikkkarte hören NIE auf zu drehen. Gibt es hier noch mehr MSI 3080 / 3090 Karten Besitzer mit ähnlichen Problem? Das ist mega nervig wenn man ein unhörbares System hat und plötzlich röschelt da eine Grafikkarte die ganze Zeit.

Sonstige Ideen? Hätte noch ne Aorus 3090 Master zum Abholen ready aber die hat nur 2 Stromanschlüsse und nachdem was ich bisher gesehen habe, ist die unter Last wohl nicht leiser als die MSI Gaming Trio X.

Wie kontaktiert man MSI am besten? Per E-Mail oder sind die über Twitter etc. auch kompetent?

edit

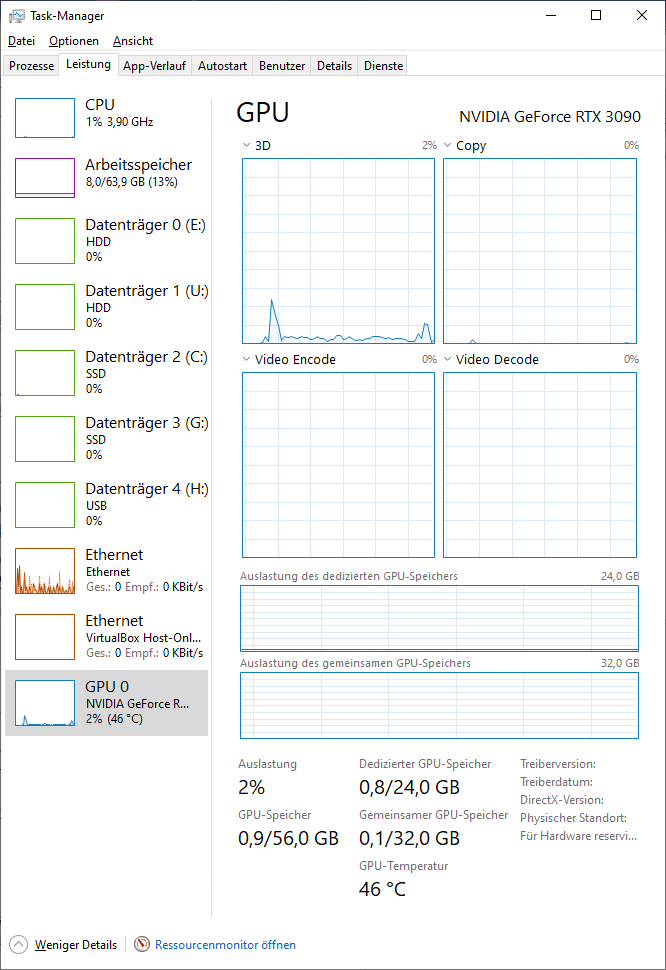

Gerade Posting abgeschickt und zack ist Ruhe. LOL. Die Grafikkarte ist nämlich auf 47°C bzw. mittlerweile 46°C gedropped. Alles eben mit nur einem TFT @ 1440p und 60 Hz. Ich werde mir mal den Trick von oben angucken Nvidia Inspector und Power Saving Tool angucken und schauen ob man die Lüfterkurve anzupassen kannst. WTF. Wenn das klappt bleibt die Gaming X Trio. Lautstärke unter Last ist gerade noch erträglich.

Und nochmal edit

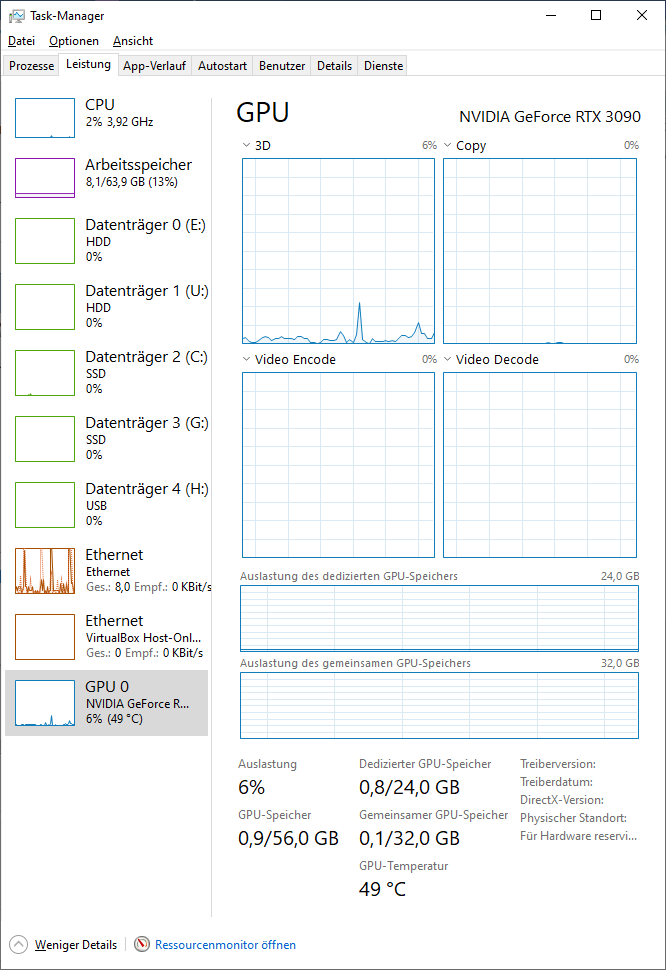

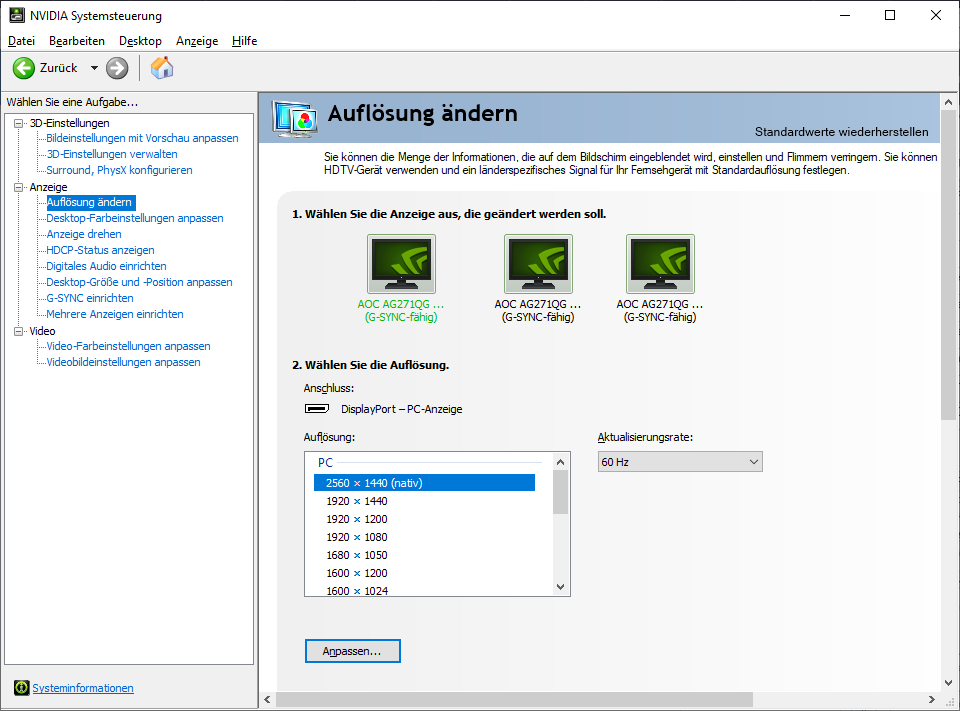

Nachdem ich nun die anderen beiden Monitore erst nach dem Start von Windows angeschlossen habe, kommt die Karte nun im Browser über 50°C aber die Lüfter drehen trotzdem nicht auf. Verstehe einer MSI und Nvidia... Ok, Fehler gefunden. Alle drei Bildschirme standen auf 60 Hz. Hier die Screens mit 3 TFTs @ 1440p 60 Hz.

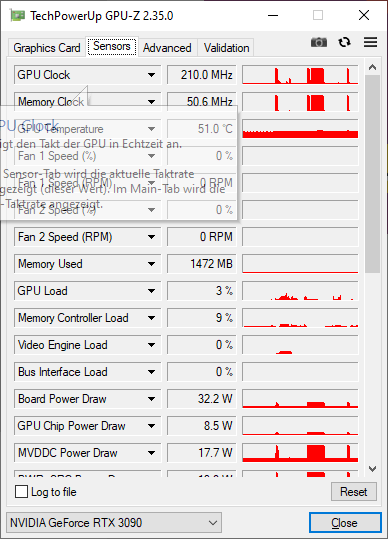

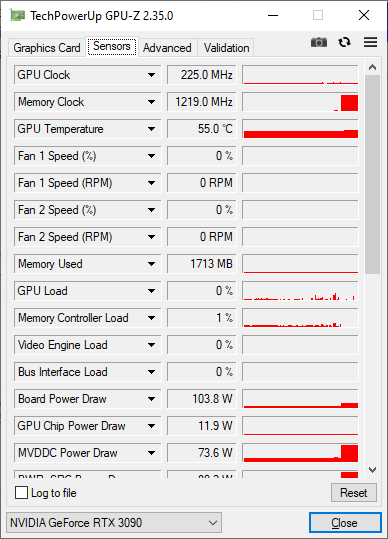

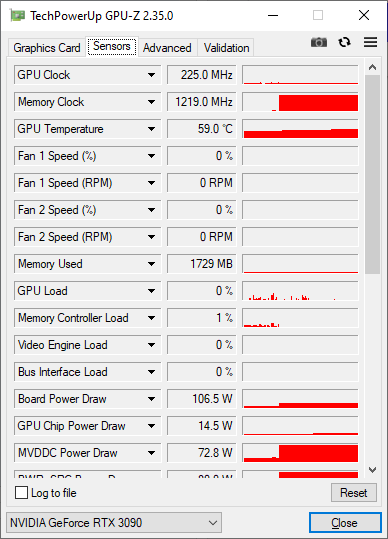

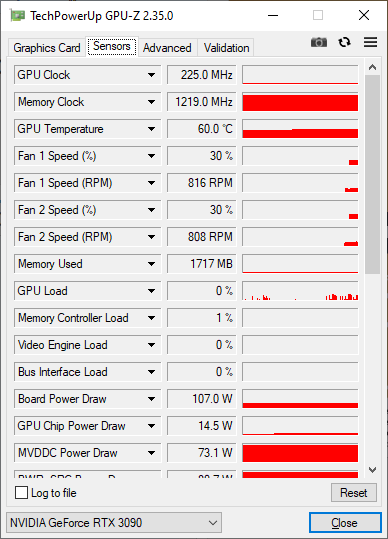

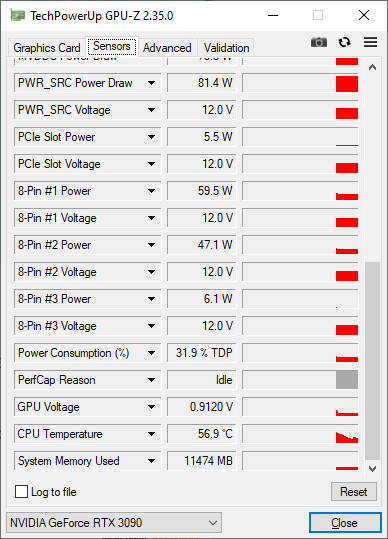

So, jetzt wird es spanned. Eben alle 3 TFTs auf 144 Hz gestellt und zack taktet der Speicher erstmal von 50 Mhz auf 1219 Mhz und die Temperatur steigt auf 55°C und jetzt sogar 59°C. Ok, jetzt ist die Karte sogar bei 60°C angekommen und zack drehen die Graka Lüfter auf. Heißt das Board Power Draw eigentlich das die Karte jetzt erstmal 106 W IDLE auf dem Desktop frisst? Ich hätte wohl doch das Titanium NT nehmen sollen. Ich schick meine Stromrechnung an MSI. ;D

Sorry, hatte die GPU geschlossen. Hier noch die restlichen Daten mit 3 TFTs @ 1440p und 144 Hz auf DEM DESKTOP!!!

Auch mit drei Bildschirmen @ 1440p und 60 Hz als auch mit einem TFT mit 1440p @ 60 Hz (nach Hard Reboot) kommt die MSI 3090 nie unter 49/50°C und die Lüfter der Grafikkkarte hören NIE auf zu drehen. Gibt es hier noch mehr MSI 3080 / 3090 Karten Besitzer mit ähnlichen Problem? Das ist mega nervig wenn man ein unhörbares System hat und plötzlich röschelt da eine Grafikkarte die ganze Zeit.

Sonstige Ideen? Hätte noch ne Aorus 3090 Master zum Abholen ready aber die hat nur 2 Stromanschlüsse und nachdem was ich bisher gesehen habe, ist die unter Last wohl nicht leiser als die MSI Gaming Trio X.

Wie kontaktiert man MSI am besten? Per E-Mail oder sind die über Twitter etc. auch kompetent?

edit

Gerade Posting abgeschickt und zack ist Ruhe. LOL. Die Grafikkarte ist nämlich auf 47°C bzw. mittlerweile 46°C gedropped. Alles eben mit nur einem TFT @ 1440p und 60 Hz. Ich werde mir mal den Trick von oben angucken Nvidia Inspector und Power Saving Tool angucken und schauen ob man die Lüfterkurve anzupassen kannst. WTF. Wenn das klappt bleibt die Gaming X Trio. Lautstärke unter Last ist gerade noch erträglich.

Und nochmal edit

Nachdem ich nun die anderen beiden Monitore erst nach dem Start von Windows angeschlossen habe, kommt die Karte nun im Browser über 50°C aber die Lüfter drehen trotzdem nicht auf. Verstehe einer MSI und Nvidia... Ok, Fehler gefunden. Alle drei Bildschirme standen auf 60 Hz. Hier die Screens mit 3 TFTs @ 1440p 60 Hz.

So, jetzt wird es spanned. Eben alle 3 TFTs auf 144 Hz gestellt und zack taktet der Speicher erstmal von 50 Mhz auf 1219 Mhz und die Temperatur steigt auf 55°C und jetzt sogar 59°C. Ok, jetzt ist die Karte sogar bei 60°C angekommen und zack drehen die Graka Lüfter auf. Heißt das Board Power Draw eigentlich das die Karte jetzt erstmal 106 W IDLE auf dem Desktop frisst? Ich hätte wohl doch das Titanium NT nehmen sollen. Ich schick meine Stromrechnung an MSI. ;D

Sorry, hatte die GPU geschlossen. Hier noch die restlichen Daten mit 3 TFTs @ 1440p und 144 Hz auf DEM DESKTOP!!!

Zuletzt bearbeitet: