Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Readspeed degradation 2022 kein Thema mehr ? Von wegen ! MP510 -> 14MB/s ! 980pro auch nicht ohne Probleme...

- Ersteller BigKid1973

- Erstellt am

- Registriert

- Sep. 2016

- Beiträge

- 59

Mich gruselt es auch jedes mal :-)

Auf der anderen Seite fragt man sich manchmal auch ob Simples SSD Tool oder GPU Tool jetzt 1GB download haben muss und alles blitzt blinkt und animiert sein muss...

Auf der anderen Seite fragt man sich manchmal auch ob Simples SSD Tool oder GPU Tool jetzt 1GB download haben muss und alles blitzt blinkt und animiert sein muss...

MrHeisenberg

Banned

- Registriert

- Okt. 2022

- Beiträge

- 1.713

Ich glaube ich habe ein ähnliches Problem mit meiner WD SN850 (2 TB).

Das Kopieren einer 1,3 GB großen Datei von der WD SSD auf eine andere SSD ging mit 140-150 MB/s vonstatten. Habe die Datei dann nochmal überschrieben, das ganze nochmal gemacht und siehe da, die Datei wird nahezu instant übertragen.

Das Kopieren einer 1,3 GB großen Datei von der WD SSD auf eine andere SSD ging mit 140-150 MB/s vonstatten. Habe die Datei dann nochmal überschrieben, das ganze nochmal gemacht und siehe da, die Datei wird nahezu instant übertragen.

- Registriert

- Sep. 2016

- Beiträge

- 59

Bench das dochmal mit dem SSD ReadSpeedChecker (siehe mein Eingangspost)...

Corpus Delicti

Commander

- Registriert

- Nov. 2016

- Beiträge

- 2.208

MrHeisenberg schrieb:Das Kopieren einer 1,3 GB großen Datei von der WD SSD auf eine andere SSD ging mit 140-150 MB/s vonstatten. Habe die Datei dann nochmal überschrieben, das ganze nochmal gemacht und siehe da, die Datei wird nahezu instant übertragen.

Sicher das die Datei nicht von Windows im Ram gecached wurde, genug RAM vorausgesetzt?

Teeschlürfer

Ensign

- Registriert

- Nov. 2019

- Beiträge

- 149

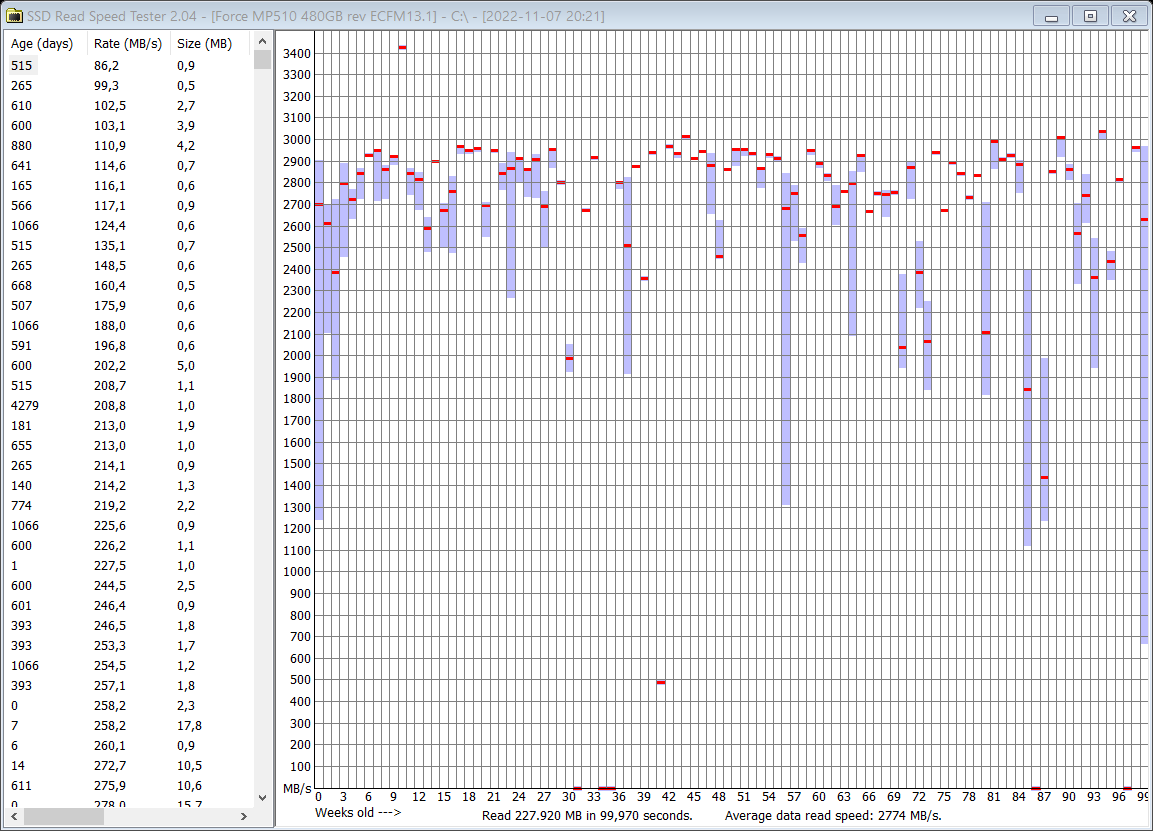

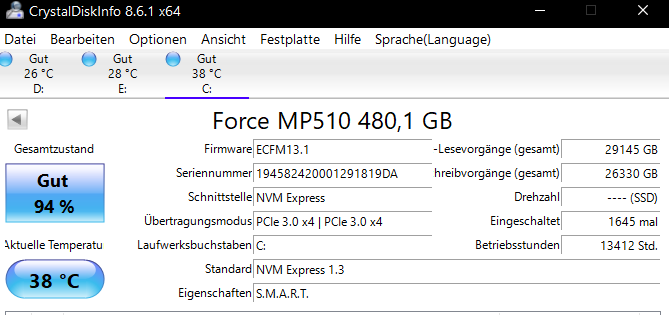

Meine MP510 hat so scheint es keine extremen Werte. Werde diese allerdings nicht zum testen mit MyDefrag bearbeiten, da Systemplatte. Auf einen Neuinstall habe ich wenig lust falls was schief läuft.

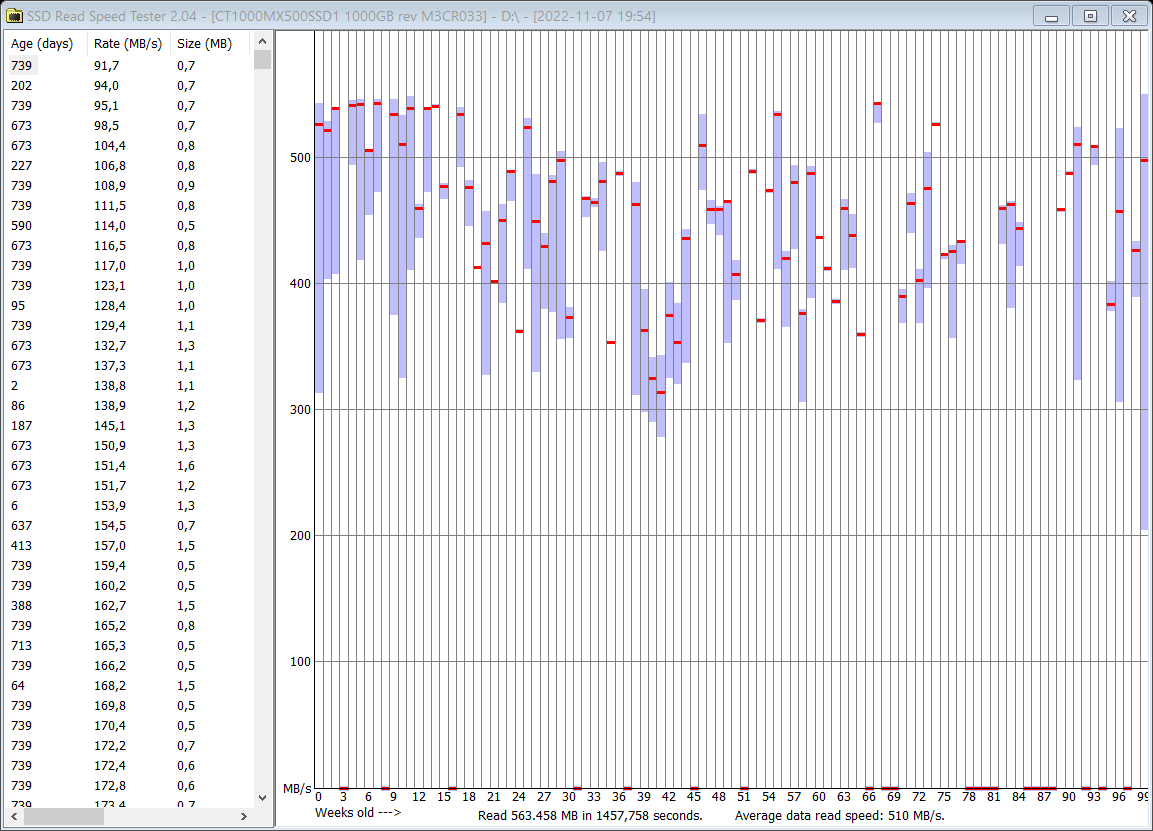

Aus spaß wurde auch eine MX500 getestet, scheint gut soweit.

Aus spaß wurde auch eine MX500 getestet, scheint gut soweit.

MP510, die Systemplatte. Seit Dez. 2019 im Einsatz.

CrystalDiskInfo

MX500, Spieleplatte. Seit August 2020 verbaut.

CrystalDiskInfo

MX500, Spieleplatte. Seit August 2020 verbaut.

- Registriert

- Sep. 2016

- Beiträge

- 59

Scheint mir auch nicht nötig... Deine Daten sind absolut im Rahmen...

Deine MP510 ist auch wieder eine andere Baureihe als zB meine... Erkennt man an der Firmware...

Ich weiss bisher nur von Platten der Baureihe mit der Firmware 12.x die betroffen sind...

Nicht betroffen scheinen Firmware 13.x und 22.x...

Speziell die MP510 ist ne echte Wundertüte... Da wurde alles Mögliche an Speichern verbaut...

Und jede mit ner eigenen Firmware...

Deine MP510 ist auch wieder eine andere Baureihe als zB meine... Erkennt man an der Firmware...

Ich weiss bisher nur von Platten der Baureihe mit der Firmware 12.x die betroffen sind...

Nicht betroffen scheinen Firmware 13.x und 22.x...

Speziell die MP510 ist ne echte Wundertüte... Da wurde alles Mögliche an Speichern verbaut...

Und jede mit ner eigenen Firmware...

Zuletzt bearbeitet:

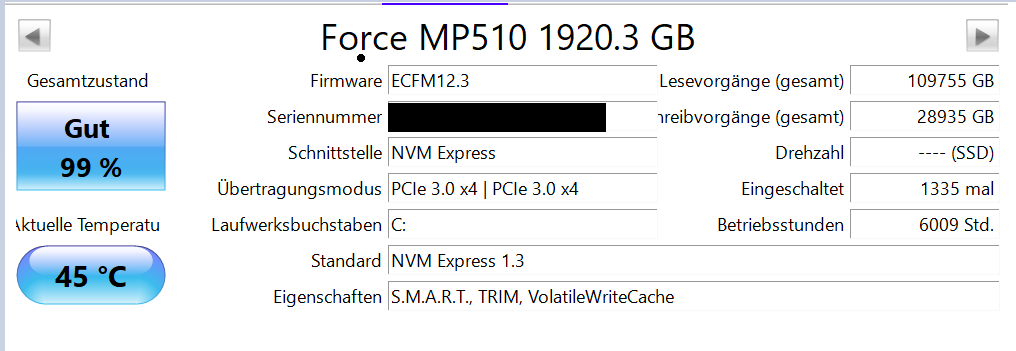

Ich habe das System 2020 neu aufgesetz. Bei mir scheint das Neuschreiben (DiskFresh) keinen grossen Unterschied zu machen. Antivirus war aus. Ich habe es noch mit zwei neueren SSDs (2TB) mit FW 22.7 gemacht und dort wie erwartet auch keinen Unterschied gesehen. Ich werde bei Gelegenheit noch bei zwei anderen PCs testen, wo ich die 1TB und 0.5TB Versionen verbaut habe.

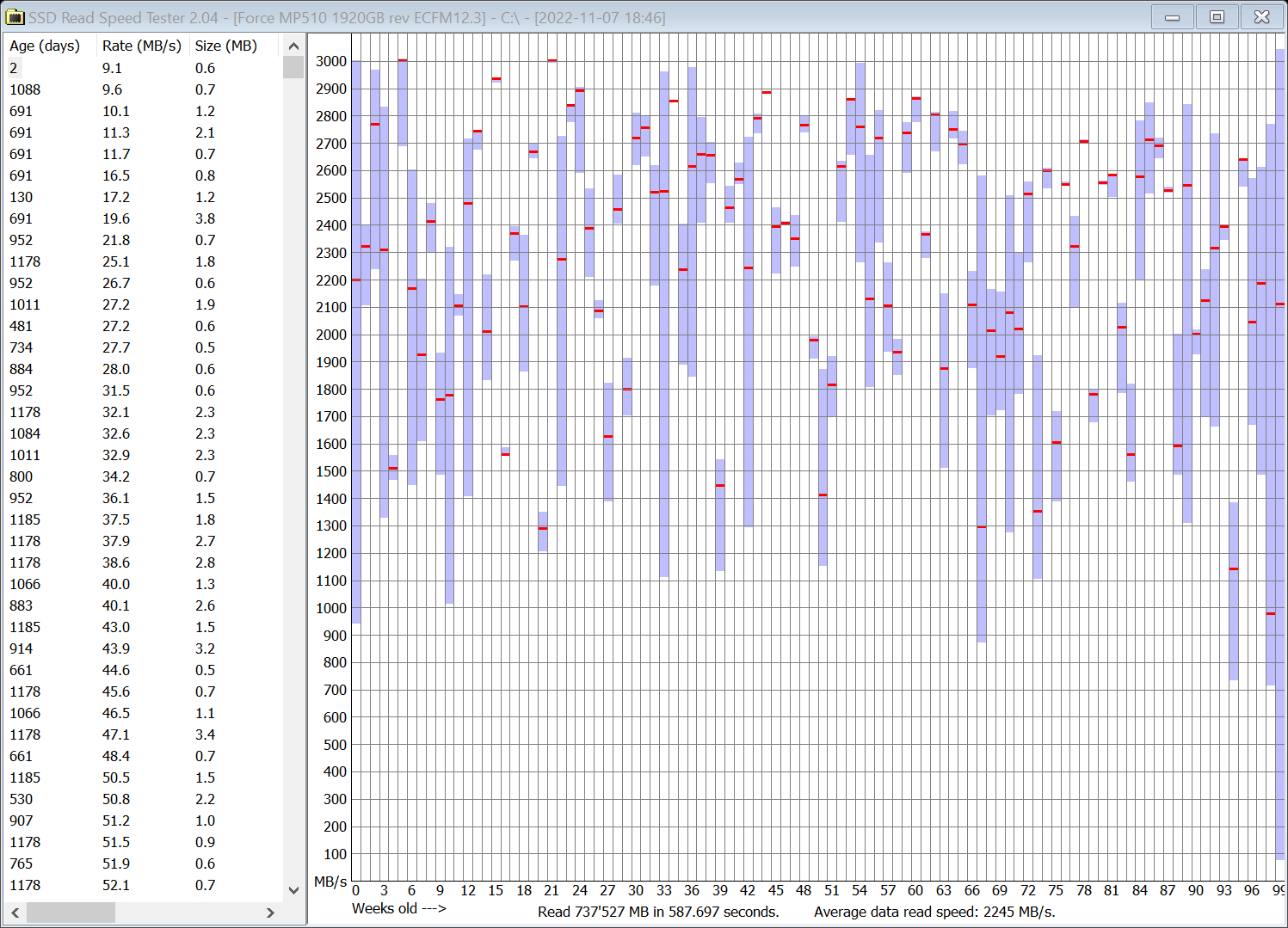

Vorher:

Vorher:

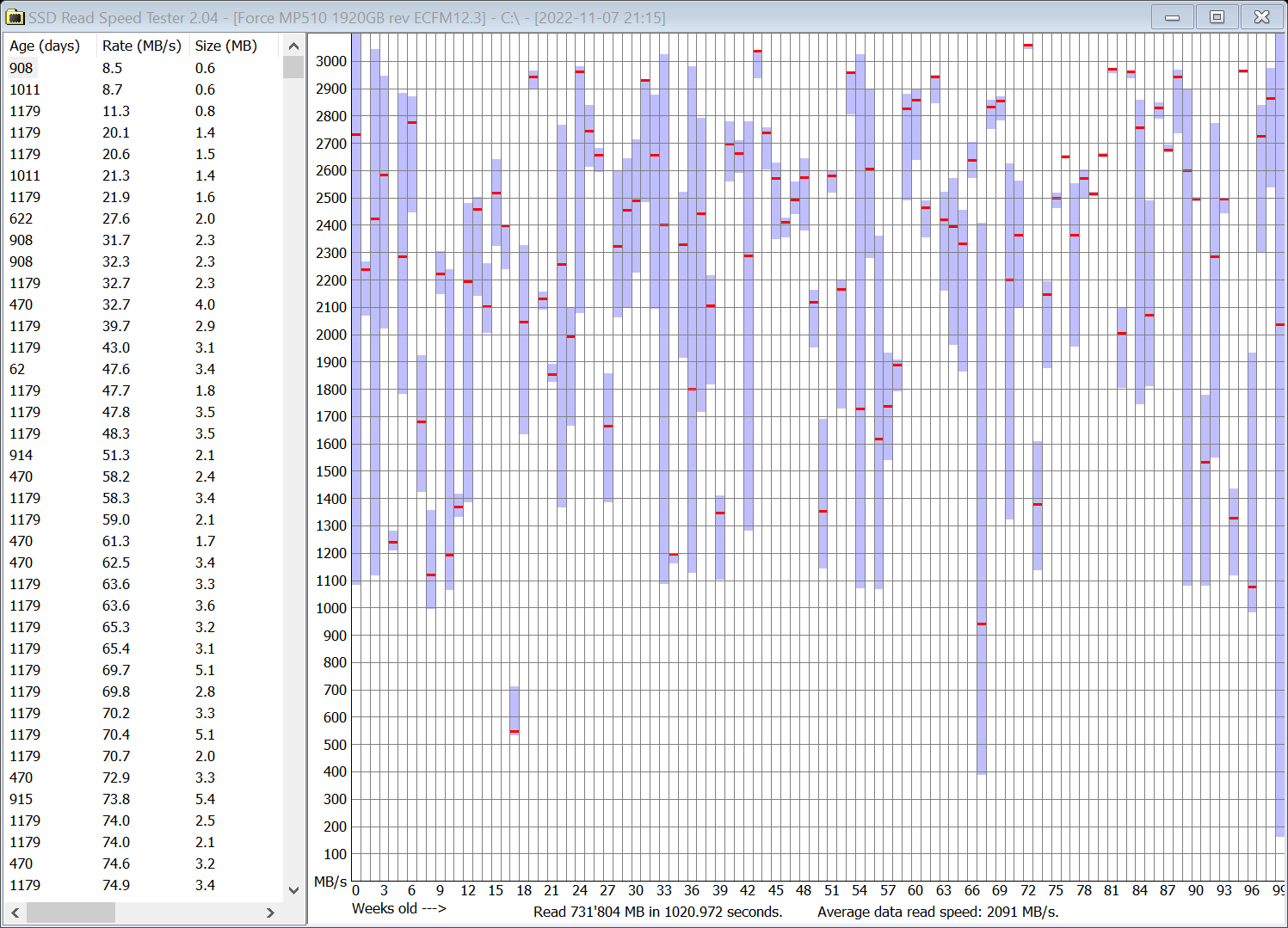

Nachher:

Nachher:

- Registriert

- Sep. 2016

- Beiträge

- 59

Spannend - ich kenne mittlerweile neben meiner eine weitere 1TB MP510 die das Problem zu zeigen scheint mit der 12er Firmware.

Deine scheint es nicht zu haben aktuell - ist aber ne 2TB Version. Wobei 2GB/s auch recht weit von erreichbaren 3GB/s sind…

Wann hast du Platte neunaufgesetzt? Eher Ende 2020 oder Anfang?

Deine scheint es nicht zu haben aktuell - ist aber ne 2TB Version. Wobei 2GB/s auch recht weit von erreichbaren 3GB/s sind…

Wann hast du Platte neunaufgesetzt? Eher Ende 2020 oder Anfang?

Das war eher Anfang 2020. Die 2GB/s sind nicht berauschend. Ich weiss aber auch nicht, was Windows im Hintergrund noch so macht (Suchindexerstellung o.Ä.). Die zwei SSDs mit FW 22.7 haben etwa 2.7GB/s, enthalten aber v.a. Spieledateien.

Wird interessant, was die kleineren Versionen zeigen. Die habe ich aber nicht bei mir im Haus. Kann also noch etwas dauern.

Grundsätzlich nervt mich das Phänomen, da ich viele MP510 verbaut habe, u.a. in meinem NAS 2 x 0.5TB als (Read-)Cache.

Wird interessant, was die kleineren Versionen zeigen. Die habe ich aber nicht bei mir im Haus. Kann also noch etwas dauern.

Grundsätzlich nervt mich das Phänomen, da ich viele MP510 verbaut habe, u.a. in meinem NAS 2 x 0.5TB als (Read-)Cache.

MrHeisenberg

Banned

- Registriert

- Okt. 2022

- Beiträge

- 1.713

Zuletzt bearbeitet:

- Registriert

- Sep. 2016

- Beiträge

- 59

Vielen Dank ! Für eine komplette Beweisführung müsste man jetzt noch schauen ob es mit Refresh zB durch myDefrag besser wird (das halte ich für fast Garantiert)

Wir missbrauchen myDefrag hier um durch das komplette umeinanderschieben aller Blöcke (daher auch Profil Data-Disk Monthly) einen Rewrite aller Blöcke zu erzwingen…

Wenn es danach besser wird hat das nix mit der Sortierung zu tun sondern damit dass der Controller davor Probleme mit den gealterten Blöcken hatte - da gibts dann fast keine andere Erklärung mehr für…

Ergänzung ()

Die Verteilung der Blöcke ist bei SSDs ziemlich egal und Defrags eigentlich völlig unnötig…NameHere schrieb:@SNSPD lass mal MyDefrag noch ein mal laufen. Hatte bei mir es 2 mal laufen lassen, nach dem ich gesehen habe das Blöcke noch verteilt waren. Kannte ich noch aus alten Defrag Zeiten.

Windows Defender kann den Vorgang auch behindern.

Wir missbrauchen myDefrag hier um durch das komplette umeinanderschieben aller Blöcke (daher auch Profil Data-Disk Monthly) einen Rewrite aller Blöcke zu erzwingen…

Wenn es danach besser wird hat das nix mit der Sortierung zu tun sondern damit dass der Controller davor Probleme mit den gealterten Blöcken hatte - da gibts dann fast keine andere Erklärung mehr für…

Zuletzt bearbeitet:

MrHeisenberg

Banned

- Registriert

- Okt. 2022

- Beiträge

- 1.713

Ich hatte es gestern mit einer Datei getestet und die Leserate lag dort bei 140-150 MB/s.BigKid1973 schrieb:Vielen Dank ! Für eine komplette Beweisführung müsste man jetzt noch schauen ob es mit Refresh zB durch myDefrag besser wird (das halte ich für fast Garantiert)

Nach dem ich sie manuell überschrieben habe, war die Leserate wieder höher, was aber vermutlich einfach am Windows Cache lag.

Heute habe ich die selbe Datei nochmal kopiert und die Leserate lag bei 500-600 MB/s (die Ziel SSD war eine Sata, also limitierte hier der Port).

- Registriert

- Sep. 2016

- Beiträge

- 59

Ein kompletter Refresh und Prüfung mit SSDReadSpeedChecker würde halt helfen das zu Dokumentieren... Eventuell schaffen wir es dass die Medien die Fälle mal aufnehmen... Je mehr Daten/Fälle wir dann hätten um so besser... Den das wiederum könnte die Hersteller dazu bewegen sich der Sache wirklich anzunehmen...

(Das Installationverzeichnis vom ReadSpeedChecker behalten :-) er legt dort nicht nur die Screenshots ab sondern auch die Messwerte als CSV Datei - einmal mit und einmal ohne Filenamen).

(Das Installationverzeichnis vom ReadSpeedChecker behalten :-) er legt dort nicht nur die Screenshots ab sondern auch die Messwerte als CSV Datei - einmal mit und einmal ohne Filenamen).

- Registriert

- Sep. 2016

- Beiträge

- 59

Kurzes Update: Ich habe myDefrag (Details im OP) im Selbstversuch auf meine Systempartition (C losgelassen. Keine Probleme. (Leichter Geschwindigkeitsgewinn auch hier - aber mir gings mehr darum zu sehen ob das Gefahrlos geht…)

losgelassen. Keine Probleme. (Leichter Geschwindigkeitsgewinn auch hier - aber mir gings mehr darum zu sehen ob das Gefahrlos geht…)

Zuletzt bearbeitet:

Mit euren Erkentnissen lockt ihr keinen Hersteller aus der Deckung. Die SSD macht ja genau das was sie soll. Wenn Zellen degradieren werden die verschiedenen Stufen der Fehlerkorrektur aktiv und am Ende werden die korrekten Daten zurückgegeben. Und wie herausgestellt wurde, ist das auch nur bei alten Daten der Fall und nicht bei neu geschriebenen, also genau das was technisch zu erwarten ist. Sicher könnte man diskutieren ob die Algorithmen die für einen automatischen Refresh sorgen sinnvoll parametrisiert sind, aber auch das wird zu nichts führen, da die Nutzungsmuster der SSDs sehr individuell sind zwischen den Usern. Es gibt viel zu viele Parameter die da reinspielen um pauschale Aussagen treffen zu können ob das Verhalten in einen bestimmten Fall jetzt normal oder abnormal war.

Und kein einziger Hersteller verspricht irgendwelche steady state Datenraten. Es wird mit Datenraten geworben die von leeren Devices Fresh out of the Box erreicht werden. Es geht einzig und alleine darum für diesen Fall gute Datenraten vorzuweisen und auch die üblichen Testportale kratzen nicht mal ansatzweise an Dauertests die aufzeigen könnten wie sich die SSDs im Dauereinsatz schlagen. Das wäre super interessant, ist aus technischer Sicht aber auch nicht trivial, da diese Tests sehr viel Zeit erfordern die die Testportale mit ihren vom Hersteller bereitgestellten Testmuster gar nicht haben.

Eigentlich ist es eine recht absurde Situation. Im Consumerbereich wird einmal Crystal Disk Mark ausgeführt, manchmal etwas mehr und das wars und im NetCom/Industrial Bereich wird Wochen/Monatelang eine umfangreiche Qualifikation gefahren um sich einen Eindruck zu schaffen ob das Modell geeignet ist für den angedachten Zweck. Größer könnten die Unterschiede kaum sein. Und genau das Thema dieses Threads hier ist ein Punkt, wo sich Hersteller sehr stark unterscheiden. Diese Alterung, welche im Consumerbereich hauptsächlich über die Zeit kommt, kann man auch wunderbar mit Hitze provozieren, nur hat kein normaler User und auch keins der üblichen Testportal eine passende Klimakammer zur Verfügung.

Ich persönlich habe wenig Hoffnung das wir im Consumerbereich mal wirklich Tests sehen welche eine SSD komplett charakterisieren. Lohnt sich von den Kosten einfach nicht.

Und kein einziger Hersteller verspricht irgendwelche steady state Datenraten. Es wird mit Datenraten geworben die von leeren Devices Fresh out of the Box erreicht werden. Es geht einzig und alleine darum für diesen Fall gute Datenraten vorzuweisen und auch die üblichen Testportale kratzen nicht mal ansatzweise an Dauertests die aufzeigen könnten wie sich die SSDs im Dauereinsatz schlagen. Das wäre super interessant, ist aus technischer Sicht aber auch nicht trivial, da diese Tests sehr viel Zeit erfordern die die Testportale mit ihren vom Hersteller bereitgestellten Testmuster gar nicht haben.

Eigentlich ist es eine recht absurde Situation. Im Consumerbereich wird einmal Crystal Disk Mark ausgeführt, manchmal etwas mehr und das wars und im NetCom/Industrial Bereich wird Wochen/Monatelang eine umfangreiche Qualifikation gefahren um sich einen Eindruck zu schaffen ob das Modell geeignet ist für den angedachten Zweck. Größer könnten die Unterschiede kaum sein. Und genau das Thema dieses Threads hier ist ein Punkt, wo sich Hersteller sehr stark unterscheiden. Diese Alterung, welche im Consumerbereich hauptsächlich über die Zeit kommt, kann man auch wunderbar mit Hitze provozieren, nur hat kein normaler User und auch keins der üblichen Testportal eine passende Klimakammer zur Verfügung.

Ich persönlich habe wenig Hoffnung das wir im Consumerbereich mal wirklich Tests sehen welche eine SSD komplett charakterisieren. Lohnt sich von den Kosten einfach nicht.

- Registriert

- Sep. 2016

- Beiträge

- 59

Nein - die SSD macht meiner Ansicht nach so eben NICHT was sie soll...

Die Firmware/der Controller SOLLTE einen Refresh machen um der Alterung entgegen zu wirken.

Er SCHEINT es aber bei verschiedenen Modellen nicht zu tun bzw. nicht gut genug was befürchten lässt, dass es auch bei einer verbauten Platte in Betrieb irgendwann zu einem Datenverlust kommt... Lange vor Ablauf der TBW.

Wenn der Durchschnitt über die ganze Platte bei 10MB/s angekommen ist und einzelne Files eine Zugriffszeit von mehreren Sekunden haben - dann darf man sich IMHO Sorgen machen. Zumal der Controller anscheinend nicht einmal DANN auf die Idee kommt nen Refresh zu machen !

Und eigentlich ist das Problem spätestens seit der 840 EVO von Samsung bekannt (und Samsung hat damals nach einem Jahr rummdocktern an der Firmware auch eine Lösung gebracht). Und auch dort war es der "Druck" der Öffentlichkeit - es geht also schon.

Und ob der User erwarten muss, dass eine Platte die mit 3GB/s (oder mehr) beworben wird nach 1-2 Jahren nur noch mit 500MB/s und nach einem weiteren Jahr nur noch mit 10MB/s zugreifen kann - das bezweifle ich. Die Formulierung "bis zu" schützt nicht mehr vor jeder Frechheit ;-)

Das solche Probleme immer wieder erst vom Enduser bemerkt werden zeigt imho auch, dass nicht einmal die Hersteller saubere Langzeittests laufen haben...

Die Firmware/der Controller SOLLTE einen Refresh machen um der Alterung entgegen zu wirken.

Er SCHEINT es aber bei verschiedenen Modellen nicht zu tun bzw. nicht gut genug was befürchten lässt, dass es auch bei einer verbauten Platte in Betrieb irgendwann zu einem Datenverlust kommt... Lange vor Ablauf der TBW.

Wenn der Durchschnitt über die ganze Platte bei 10MB/s angekommen ist und einzelne Files eine Zugriffszeit von mehreren Sekunden haben - dann darf man sich IMHO Sorgen machen. Zumal der Controller anscheinend nicht einmal DANN auf die Idee kommt nen Refresh zu machen !

Und eigentlich ist das Problem spätestens seit der 840 EVO von Samsung bekannt (und Samsung hat damals nach einem Jahr rummdocktern an der Firmware auch eine Lösung gebracht). Und auch dort war es der "Druck" der Öffentlichkeit - es geht also schon.

Und ob der User erwarten muss, dass eine Platte die mit 3GB/s (oder mehr) beworben wird nach 1-2 Jahren nur noch mit 500MB/s und nach einem weiteren Jahr nur noch mit 10MB/s zugreifen kann - das bezweifle ich. Die Formulierung "bis zu" schützt nicht mehr vor jeder Frechheit ;-)

Das solche Probleme immer wieder erst vom Enduser bemerkt werden zeigt imho auch, dass nicht einmal die Hersteller saubere Langzeittests laufen haben...

Zuletzt bearbeitet:

W

Wechsler

Gast

Die Samsung SSD 840 Basic war eine der ersten TLC-SSDs und die erste, wo die Kundschaft dann auch Read Degradation bemerkt hat.Aeropony schrieb:Yep! Hab hier eine Samsung 840 Basic mit 500GB, die nach 1,5 Jahren im Schrank

die Hälfte ihrer Files einfach "vergessen" hat

Übrigens definiert die JEDEC für Client-SSDs nur ein 1 Jahr Retention. Das heißt, die Daten dürfen danach weg sein.

Zuletzt bearbeitet von einem Moderator:

Viel Spaß, wenn nach einem Jahr dein Windows nicht mehr startet, weil eine länger nicht upgedatete Bibliotheksdatei nicht mehr lesbar ist. Hier geht es nicht um SSDs, die jahrelang im Schrank liegen, worauf sich die Retention Time bezieht, sondern um täglich im Einsatz befindliche Datenträger. Und auf denen lagern nun mal zum größten Teil Daten, die zwar immer wieder gelesen, aber nicht ständig - oder überhaupt nie - neu geschrieben werden. Systeminstallation, Programmdaten, Fotosammlung, Office-Dokumente, spielt ja keine Rolle. Eine im laufenden Betrieb befindliche SSD muss solche Daten zur jederzeitigen Verwendung vorhalten können. Dazu gibt es die Firmware, die unter Berücksichtigung der Eigenheiten des verwendeten Speichers alles Notwendige tun muss. Einige können es offenbar nicht ohne gewaltige Einschränkung. Das zu thematisieren und davor zu warnen ist auf jeden Fall wichtig.

Aber zum Glück haben wir noch einen funktionierenden Markt mit mehreren Anbietern. Drittanbieter mit ihrem nicht vorhersehbaren Sammelsurium aus NAND, Controller und Firmware von den Resterampen der jeweiligen Hersteller mag man ja guten Gewissens eh nicht in Erwägung ziehen. Bei mir ist aber vorerst auch WD raus aus der Kaufliste. Nicht nur die Blue 3D macht ja - wie bei mir selbst - offenbar Probleme, sondern auch die SN850, diesem Thread nach zu urteilen. Meine Samsung- (840 Pro, 860 Evo, 980 Pro) und Crucial-SSDs (M550, MX500) habe ich unter verschärfter Beobachtung, bisher ohne Beanstandung.

Aber zum Glück haben wir noch einen funktionierenden Markt mit mehreren Anbietern. Drittanbieter mit ihrem nicht vorhersehbaren Sammelsurium aus NAND, Controller und Firmware von den Resterampen der jeweiligen Hersteller mag man ja guten Gewissens eh nicht in Erwägung ziehen. Bei mir ist aber vorerst auch WD raus aus der Kaufliste. Nicht nur die Blue 3D macht ja - wie bei mir selbst - offenbar Probleme, sondern auch die SN850, diesem Thread nach zu urteilen. Meine Samsung- (840 Pro, 860 Evo, 980 Pro) und Crucial-SSDs (M550, MX500) habe ich unter verschärfter Beobachtung, bisher ohne Beanstandung.