pipip schrieb:

aylano

Bitte nicht soviel Worte xD Die leute hier sind Balken gewohnt xD

Kleiner Spaß am Rande.

Der war gut.

Wobei Quotes auch sowas sind wie Balken und so versuche ich es mit vieln Quotes nachzugestalten.

Weiteres glaube ich gibt es auch ein Art Grenze. Wenn ein Notebook 5 std Akku laufzeit hat, ist das wahrscheinlich für 90 % der Leute ausreichend. Denn viele sind nicht solange unterwegs mit dem notebook oder sitzen gar 5 std am stück vor dem kasterl.

Ich bin nicht der Meinung.

Akku-Zeit kann man nicht genug krieg.

Zwar mag man vielleicht mit 5 Stunden auskommen, aber dann gehts sich auch nur mehr ein Film von 2-3 Stunden und sonst nichts aus und das wäre viel IMO zu wenig.

Gerade Ultrabooks haben nur 5 Stunden.

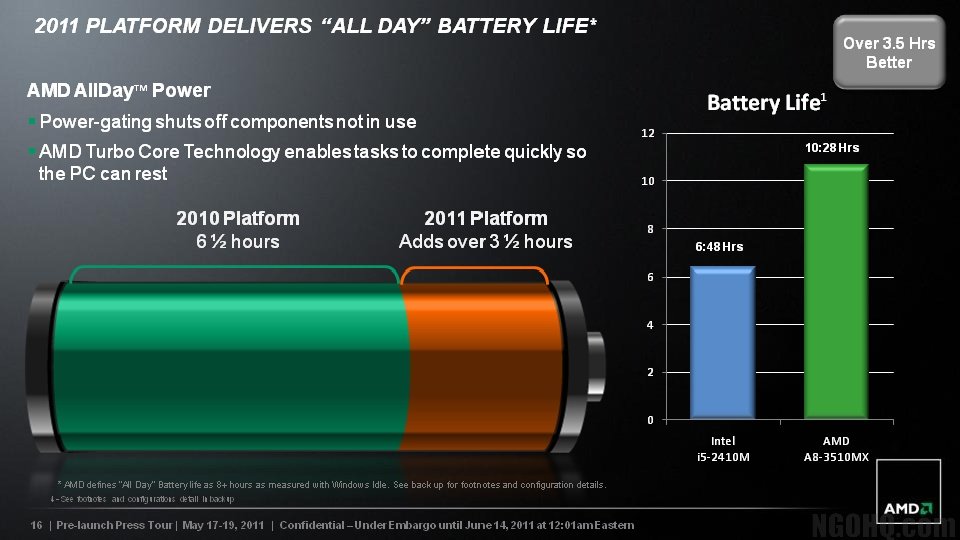

Ich finde 12 Stunden wichtig. Da man 8 Stunden Tippen kann, sowie noch Akku-Zeitreserven für Höhere Auslastungen (Kurzvideos, Simulation, Game usw) hat.

Übrigens, 12 std ist sicherlich idle. Eventuell kann man dann mit einem core und einem nicht deaktivierten teil der igp wirklich lange Filme schauen und Surfen.

Siehe letzte Folien.

Ralf555 schrieb:

Ohne genauere Angaben wertlos.

Es steht in 1) "Batterie life calculations are based on 62Wh battery-pack at 98 Utilization"

Ist zwar Punkt 1 und nicht 5, aber es hört sich für alle Tests an.

AMD nutzt für solche Angaben schon seit Jahren 57-62Wh-Akkus und die Angaben wurden immer eingehalten.

Und zwar mit Notebooks mit onbaord-GPUs bzw. iGPUs und mit gutstromsparoptimierten Komponenten/Konfigurationen.

Bei Notebook-Check konnte der bestoptimierte die Angaben noch so 20-25% überbieten, während nicht-stromoptimierte natürlich deutlich drunter waren. Aber das ist bei Intel genauso.

Ohne Angaben auf welches Modell das sich genau bezieht, ebenfalls wertlos. Zumal sich das auf die GPU bezieht. Die 50% sollten es aber schon sein, um sich ein Polster zu schaffen. AMD hat nicht differenziert, welcher Trinity 50% mehr GPU Power bekommt. Das kann genauso gut der A4 sein. Interessanter wäre es beim A8 Topmodell gegen Topmodell.

Wenn ich im Satz davor nur Akku-Zeit spreche und im Satz danach, sowie im ganzen Absatz es um Akku-Zeit geht, dann sollte man irgendwie mitbekommen, dass der eine Satz mit einer Zahl ohne erwähnung von Zeit oder Akku eventuell auch um Akku-Zeit handelt.

Nein, das ist nicht falsch. Trinity kann maximal mit den Dualcore Modellen der 35W Klasse konkurrieren, mehr ist nicht drin. Wobei Trinity immer noch deutlich das das Nachsehen haben wird im CPU Bereich.

Ohne Argument ist eine Aussage wertlos.

Vorallem, wenn man es nochmal wiederholt.

Warum sollte Trinity nicht gegen Ivebridge @ 17-TDP konkurrieren können, wenn ersteres mit Quad daherkommt und zweiteres mit Dual-Core?

Der Quad kann mit etwas geringerem Takt auch leichter / tiefer gevoltet werden, während höhere Takt etwas mehr Spannung brauchen und somit früher an die TDP-Grenzen kommen könnte könnte könnte (=Theorie ; Praxis sehen wir später)

Mit dieser Art (Quad-Core vs. Dual-Core @ 25 & 35W-TDP) konnte AMD schon eine ähnlich gute Effizienz & Performance erreichen, obwohl sie genauso eine Fertigungsstruktur (1 Fullnode) sowie Fertigungs-Technologie (3D) hinten nach war.

Dieser muss sich Haswell stellen. Meist ist immer dann vom Nachfolger die Rede, wenn das kommende oder aktuelle Produkt nichts taugt.

Dann muss ja Intel immer schlechte Produkte haben, wenn sie ihre übernächsten Produkte auf den Roadmaps zeigen.

Erstens, war @ CES 2012 nie die Rede vom Trinity-Nachfolger.

Zweitens, ist es logisch, dass die nächste APU immer die aktuelle GPU-Technologie bekommt.

Drittens, wird Haswell erst so richtig interessant, wenn Intels MIC in die iGPU eingeführt wird.

Intel soll erst mit Ive-Bridge sowohl DX11 als auch OpenCL bei iGPUs (bis jetzt wird nur die CPU angesprochen) eingeführt werden.

AMD ist halt momentan die einzige Firma, die eine führende CPU und GPU-Technologie hat. Und je mehr die CPU & GPU in Fusion zusammenwächst sowie immer mehr Programme OpenCL nutzen, desto besser wird die Gesamtperformance.

PS: Mit "führende" ist auch Platz 2 gemeint, da es ja mit ARM & MIPS & Co noch andere CPU- sowie GPU-Technologien (PowerVP & Mali & Co) gibt.

2012 ist für Intel bzw. x86 (somit auch AMD) sowieso ein ziemlich entscheidendes Jahr. Denn dann sieht man, welchen Einfluss ARM (unter anderem auch wegen Windows 8) auf den Billig-Notebook & -Desktop markt hat, sowie die Leistung von Intels Larrabee dann tatsächlich ist. Und Nvidias Fusion-Konkurrenz a la Denver kommt ja dann --- öh --- okay AFAIK nicht 2012 aber immerhin auch 2013.

Ralf555 schrieb:

In den entsprechenden Threads wird davon gesprochen oder wenn der Kontext passt. Bei aylano passt das überhaupt nicht. Er fabuliert von Trinity und bringt urplötzlich den Nachfolger ins Spiel, der schon jetzt in den Olymp gehoben wird mit Aussagen wie verdammt interessant, obwohl quasi noch gar nichts bekannt ist. IB kannst Du rausnehmen, das wäre analog zu Trinity. Trinity und Ivy Bridge kommen als nächstes, zu einer GCN APU wäre Haswell passend.

Ich wäre vorsichtig, wenn man den Sinn einiger !!! Textpassagen nicht richtig lesen konnte.

Ich schrieb, dass der Trinity interessant wird und SoC & GCN wurde schon bekannt gegeben.

Das sind 2 bedeutende Schritte.

Erstens, ein SoC (wie übrigens Intel)

Zweitens, integration von GCN, was eben seit ATI-Kauft entwickelt wurde.

Ich finde beides sehr interessante Technologie. Ersteres im Bezug auf Akku-Zeit.

Ob der Trinity-Nachfolger besser als Haswell wird, hast du dir dazugedichtet. Vorallem schrieb ich nicht umsonst Off-Topic.

Mit interessant nahm ich Bezug auf die Technologie!!!

Wie sich beides dann auf Akku & Performance/Effizienz auswirkt sowie Haswell wird, weiß ich nicht und deshalb sagte ich auch nichts dazu.