Gösn schrieb:

Kann beides nicht miteinander laufen gibt es nur entweder oder?

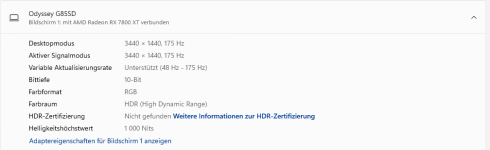

Es gibt sowohl HDR8 als auch HDR10 sowie HDR12.

Wenn es seitens des Monitor unterstützt wird, wovon ich ausgehe, liegt es womöglich an der Bandbreite des zu übertragenden Kabels.

Ist es HDMI? Dann achte auf die Kabelqualität oder wechsele zu das weniger komplexe DisplayPort, insofern der Montor diese Option nicht ausschließlich per HDMI bereitstellt.

Meine Top-Empfehlung unter den Preis-/ Leistungssiegern ist das

Stouchi 3m HDMI Kabel 8K 4K 120Hz Ultra HD 48 Gbit/s HDMI 2.1.

Dieses Kabel garantiert die Bandbreite für 3840x2160 @60Hz in 10-Bit. Das ist keine Selbstverständlichkeit. Die meisten Strippen taugen bloß für 30Hz, auch wenn sie mit angeblichen 60Hz werben, was sie in der Regel innterhalb des ersten Jahres noch zu liefern imstande sein können, doch sobald die anodische Oxidation in zu weit vorangeschrietten ist, sorgen sie nur noch für eine weniger taugliche Spezifikation oder für ein ständig ausfallendes Signal. Ein gutes Kabel muss der Anforderung, um diese es wirbt, für ein paar Jahre lang gewachsen sein. Nicht umsonst kosten die empfohlenen Derivate ein kleines Sümmchen.

Bei den Adaptern sieht es noch viel schlimmer aus. Ich kann sofort sagen, all das, was um 10 Euro oder so um sich wirbt, kann man für 3840x2160 @60Hz in 10-Bit vergessen: Es taugt nur für 3840x2160 @30Hz in 8-Bit; wobei ich auch mein Modell da habe, das diese Spezifikation in 10-Bit hinlegen kann, nämlich der

MK-5749 von deleyCON. Wer einen DisplayPort-to-HDMI-Adapter wünscht, der die 3840x2160 @60Hz garantieren kann, ist mit mit dem folgenden HAMA-Adapter genau richtig, wenngleich der Preis eine abschreckende Wirkung hat:

https://www.hama.com/de/de/video-ad...4K058OziqmSjBQm1itYYwdstJuWF4HyfOM-UArkHqpIDV

Leider sind die 10-Bit nur dann möglich gewesen, wenn ich die Verbindung von einem Kabel per HDMI auf DisplayPort herstellte, also von HDMI auf HDMI über eine Zwischenschritt per DisplayPort. Direkt von DisplayPort auf HDMI habe ich bislang nur die 8-Bit erhalten. Das kann der der Modulation des LVDS-Protokolls auf das TMDS-Signal bedingt sein.

Ich bestellte mir einst diesen Adapter:

https://www.ebay.de/itm/388330686680

Das gelieferte Modell entspricht nicht dem aus der Abbildung, sondern ähnelt dem HAMA-Adapter auf geradezu täuschender Weise — was ich durchaus für positiv hervorhebe.

Bis auf die Aufschrift, diese der HAMA-Adapter mit sich bringt, fällt auf den ersten Blick nur ein Unterschied auf: Der Kabelmantel besteht aus einem gesleevten Geflecht, was mich von der Optik her durchaus mehr anspricht, auch wirkt der Mantel am Knicken nicht so steif wie sein HAMA-Pendant, jedoch, und kommen wir auf das wirklich Wichtige zu sprechen, die Signalstärke: Das maximal Mögliche, was ich aus diesem Adapter beziehen konnte, waren 3840x2160 @30Hz in 8-Bit.