Weißt Du was mein großes Problem bei der Sache ist? Ich hab keine gute Idee wie man nachgucken kann, ob AES-NI in ZFS benutzt wird (vielleicht hat hier ja jemand anders ne Idee dazu). Den einzigen Ansatz den ich hätte ist halt stumpf im

OpenZFS-Quelltext ein

logging reinzupatchen das ne Nachricht rausschickt, wenn AES-NI benutzt wird.

Das ist aber kein völlig trivialer Ansatz. Den muss man sich zumindest zutrauen. :-)

Was sonst dann halt bleibt ist von außen draufzugucken und dann seine Schlüsse draus zu ziehen.

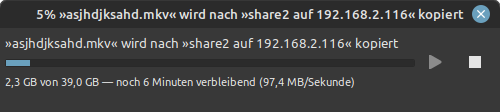

Dummerweise gibts auch bei benutzten AES-NI einen Impact auf den Datendurchsatz und auch auf den CPU Load.

Ich hab aber leider keine Erfahrung ZFS und CPUs aus der Klasse des Celeron J4115

Spontan würde ich sagen, das die Prozessorauslastung zu weit noch oben geht. Kann aber auch gut sein, das sie für eine solche CPUs sogar noch halbwegs im Rahmen des Normalen liegt.

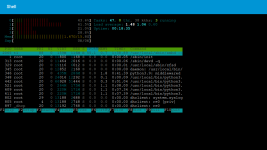

Was mir übrigens bei Deinem

htop aufgefallen ist, das Samba (

/usr/sbin/smbd) viel CPU-Zeit in Anspruch nimmt. Das verfälscht natürlich die Messungen. Ich weiß jetzt nicht, ob Du Deinen Test übers Netzlaufwerk gemacht hast oder so. Falls ja: Mach das nicht. Mach den lieber direkt auf der True Scale Maschine. Zum Beispiel mit sowas wie

dd so a-la

dd if=/dev/zero of=/path/to/testfile bs=10M count=1000

Statt mit

htop drauf zu gucken kann man auch sowas wie

perf nehmen. Da kriegt man dann ne differenzierte Ausgabe die auch in-kernel-Aufrufe aufschlüsselt:

perf top

(ich hab keine Ahnung ob

perf bei TrueNAS Scale schon drauf ist; aber soweit ich weiß ist das ein angepasstes Debian ; dann könnte

apt install linux-perf funktionieren)