dogio1979

Admiral

- Registriert

- Aug. 2006

- Beiträge

- 7.311

Hallo,

ich würde gern mal eure Meinung zu folgenedem Thema wissen und eine Diskussion dazu anstoßen.

Wird der klassische prozessor, wie es ihn heute gibt weiterhin aktuell sein, wird er möglichwweise mit der GPU verschmelzen oder wird die "CPU" Bestandteil einer "GPU".

Heute wo die neue Grafikkartengeneration auch Aufgaben vom Prozessor zugewiesen bekommen kann und Grafikkarten in vielen Bereichen mehr Rechenleistung bringen als herkömmliche Prozessoren scheint der Gedanke nicht so abwegig.

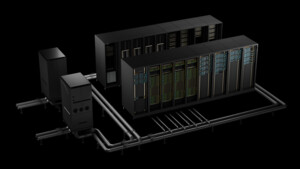

Unterstrichen wird dies ja zb. von der Workstation-Lösung namens Tesla von nVidia.

Dazu kommt ja noch, dass mit alltäglichen Anwendungen ein Prozessor heute schon lange nicht mehr ausgelastet werden kann. Hohe Prozessorleistung macht sich doch nur noch bei Grafik- und Videoberabeitung, 3D-Rendering und ähnlichen Programmen bemerkbar, die alle vermutlich aber auch über eine GPU laufen könnten, was sie teilweise ja auch schon tun.

Baut nVidia womöglich irgendwann Prozessoren? War dies der wahre Grund der Übernahme von ATi durch AMD?

Gruß

ich würde gern mal eure Meinung zu folgenedem Thema wissen und eine Diskussion dazu anstoßen.

Wird der klassische prozessor, wie es ihn heute gibt weiterhin aktuell sein, wird er möglichwweise mit der GPU verschmelzen oder wird die "CPU" Bestandteil einer "GPU".

Heute wo die neue Grafikkartengeneration auch Aufgaben vom Prozessor zugewiesen bekommen kann und Grafikkarten in vielen Bereichen mehr Rechenleistung bringen als herkömmliche Prozessoren scheint der Gedanke nicht so abwegig.

Unterstrichen wird dies ja zb. von der Workstation-Lösung namens Tesla von nVidia.

Dazu kommt ja noch, dass mit alltäglichen Anwendungen ein Prozessor heute schon lange nicht mehr ausgelastet werden kann. Hohe Prozessorleistung macht sich doch nur noch bei Grafik- und Videoberabeitung, 3D-Rendering und ähnlichen Programmen bemerkbar, die alle vermutlich aber auch über eine GPU laufen könnten, was sie teilweise ja auch schon tun.

Baut nVidia womöglich irgendwann Prozessoren? War dies der wahre Grund der Übernahme von ATi durch AMD?

Gruß