@ciapal:

Genau das ist aber oftmals eben das Problem - selbst 3GB VRAM werden eben heute mehr als oft zur Bremse:

Erkläre mir einfach mal bitte wie es zu den Ergebnissen des aktuellen CB-Benchmark Parcours kommt (im Vergleich zu den Releasetests):

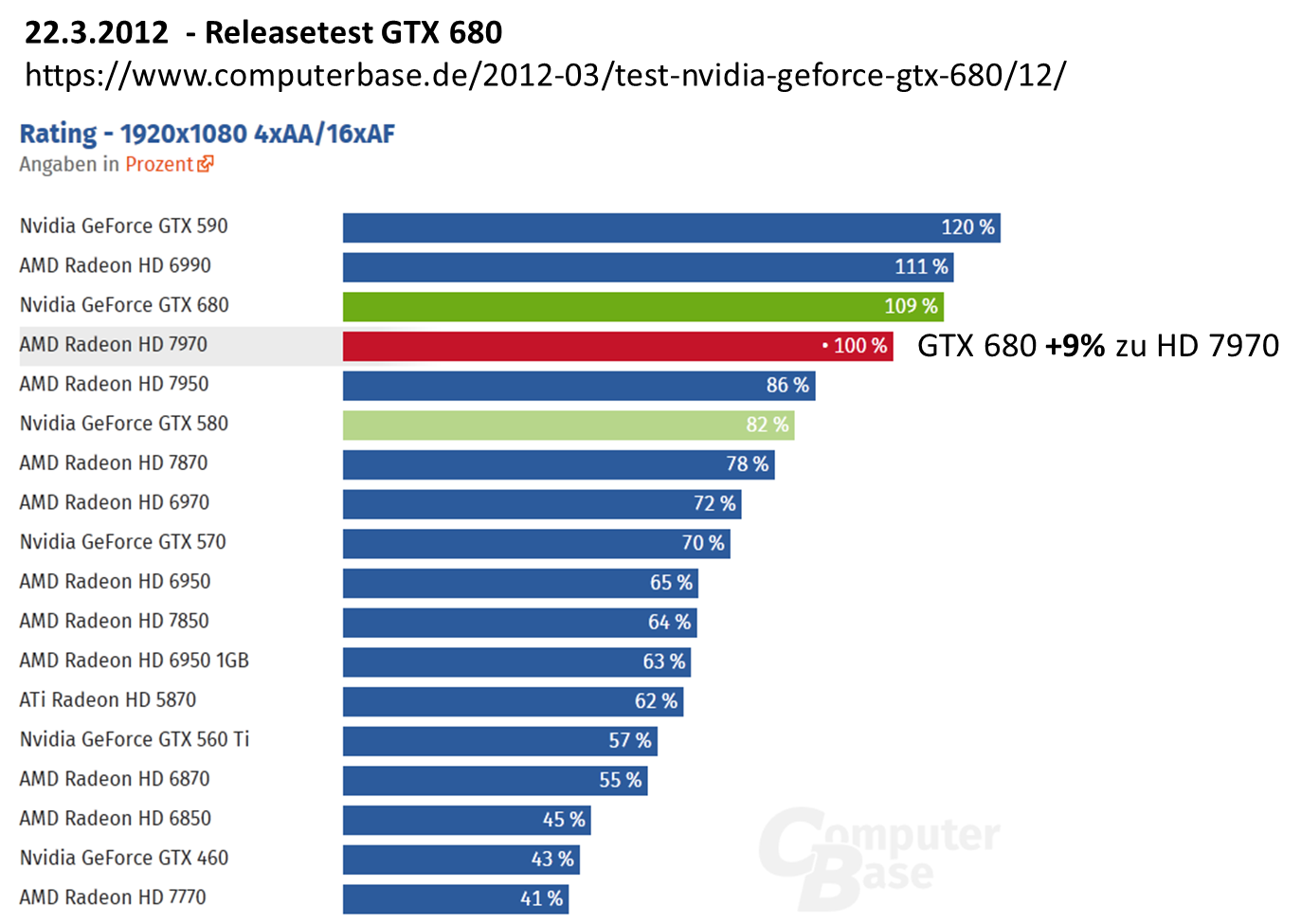

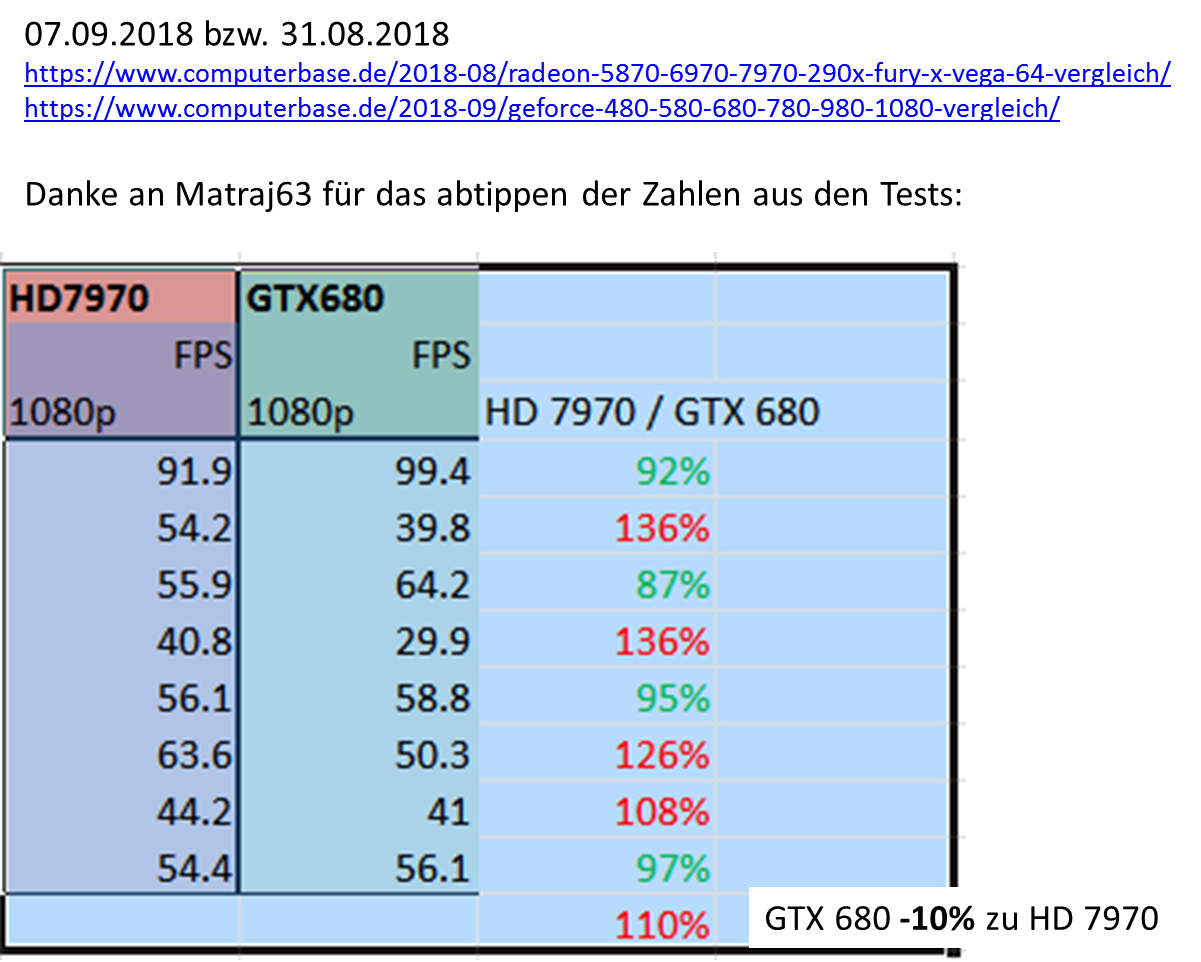

GTX680 vs HD7970 (2GB VRAM vs 3GB VRAM):

Aus +9% werden -10% mit z.T. deutlichen einbrüchen in mehr als der Hälfte der getesten Games.

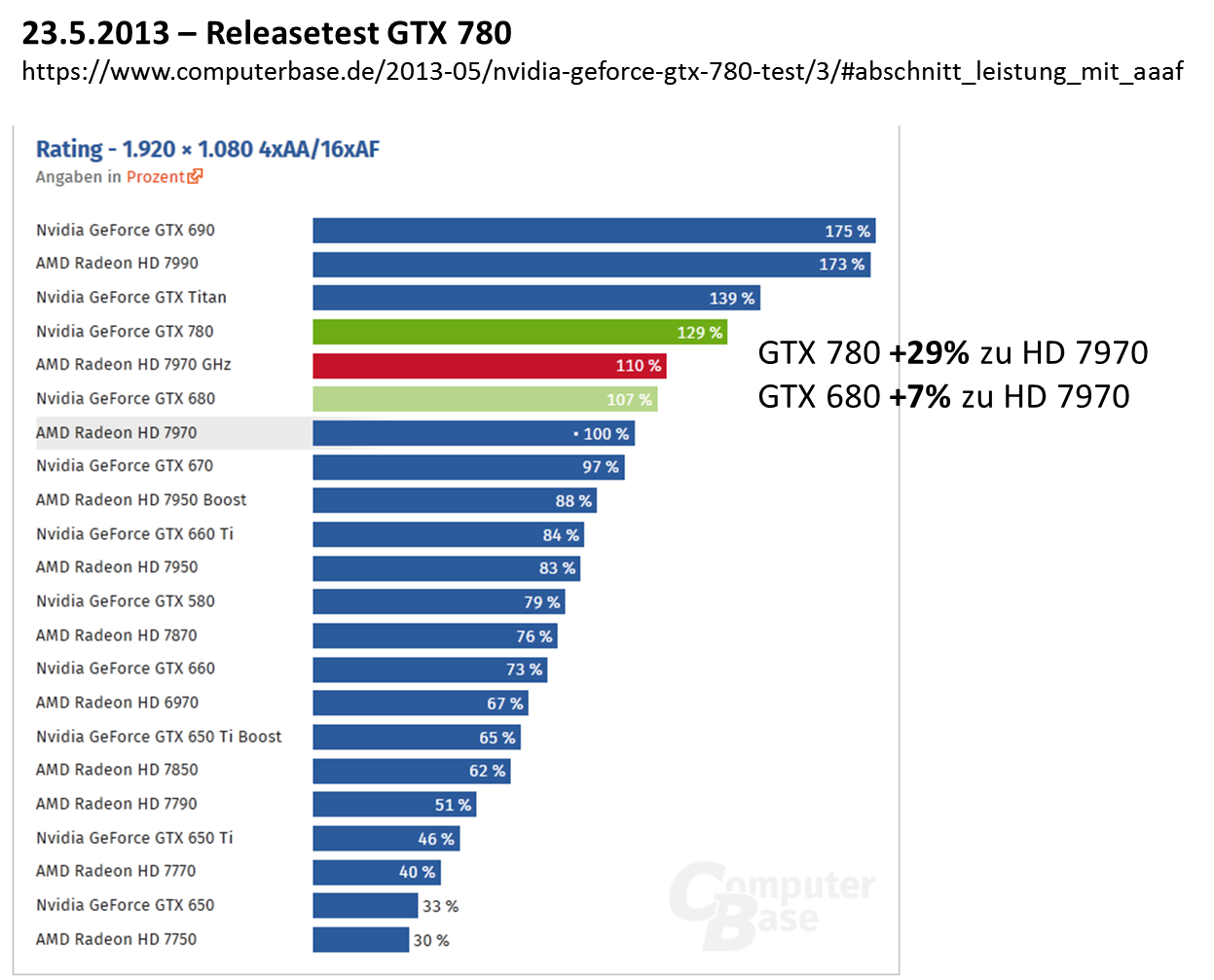

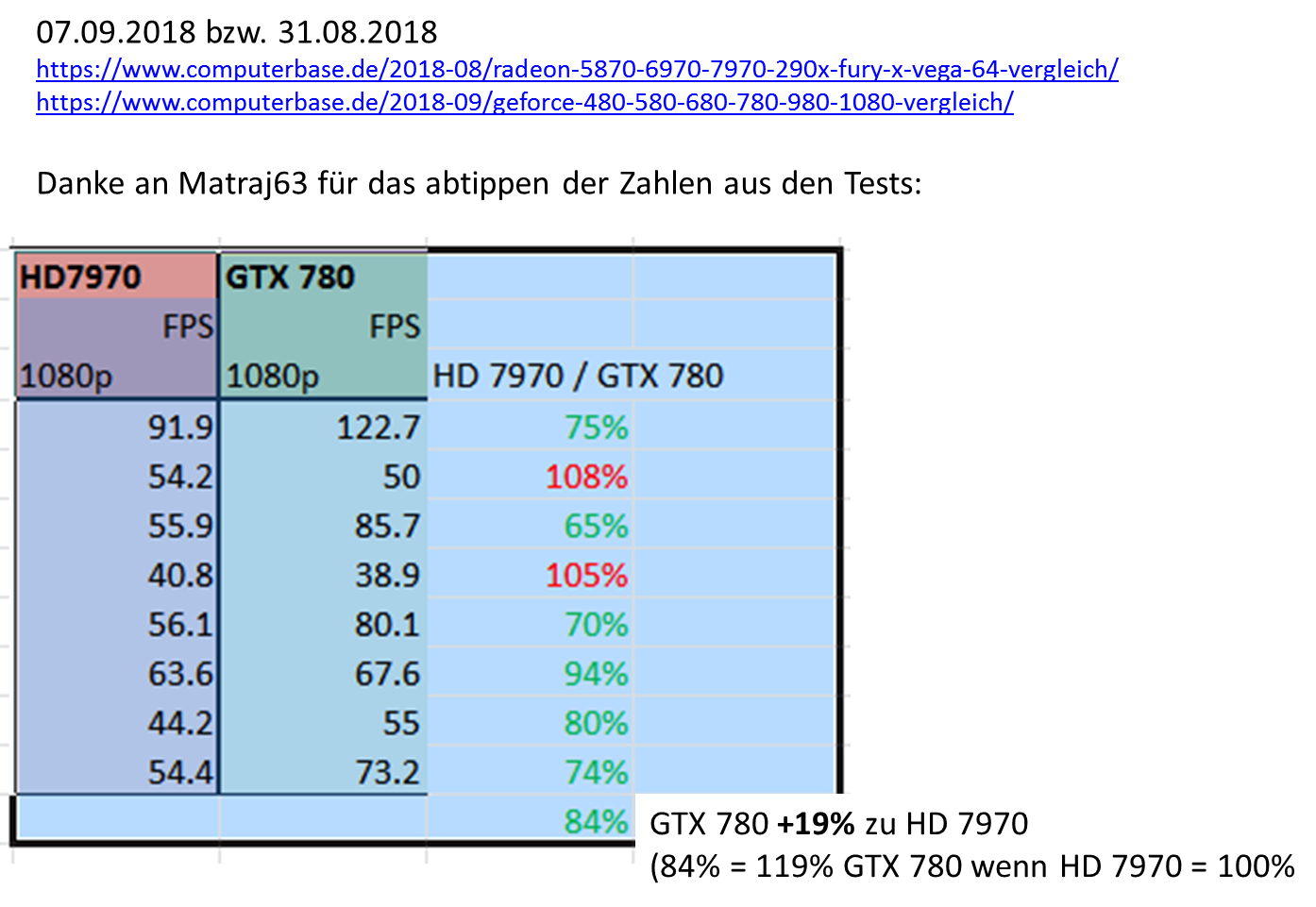

GTX 780 vs HD 7970 (3GB vs 3GB):

Aus +29% wurden in nur 5 Jahren nur mehr +19% Vorsprung....beachtlich und das obwohl BEIDE hier 3GB VRAM haben. Die 7970 hat also 10% "Defizit" aufgeholt.

Eine 780 Ti war im aktuellen Testfeld leider nicht mit drin - aber eine 780 können wir als "Referenz" mal nehmen. Eine 780 Ti hat genauso wie die 780 3GB VRAM.

Wenn der VRAM also "limitiert" bricht eine 780 genauso ein wie eine 780 Ti.

Also schauen wir mal:

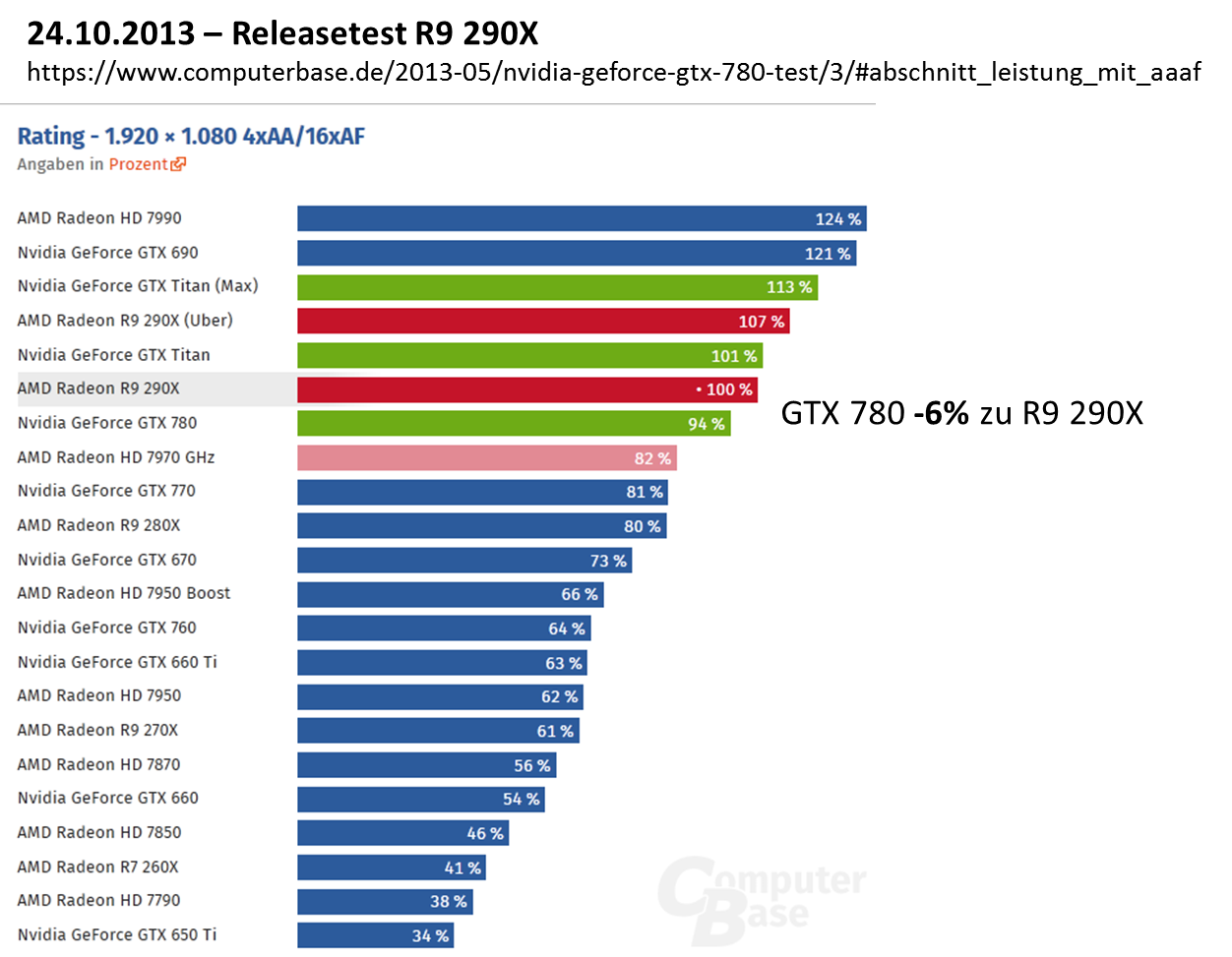

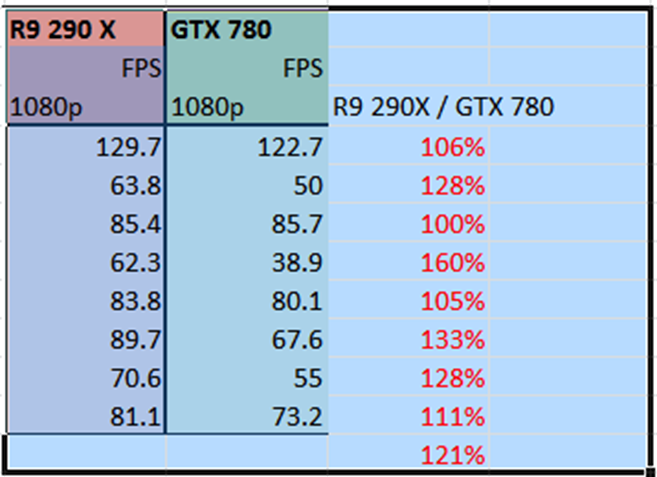

780 vs R9 290X (3GB vs 4GB):

Die R9 290X ist Stand HEUTE also im SCHNITT 21% schneller - Zum Release waren es gerade mal 6% !

EDIT: Wir sehen in 1 Game stand heute geht eine 3GB Karte von damals einfach nur unter. In weiteren 3 sind die 3GB ebenfalls schon deutlich zu knapp und die Karte ist ~30% Langsamer als die 4GB 290X (die zu release ca gleichschnell war wie die 780). nur in 3 der Spiele ist die Performance noch in etwa so wie damals /EDIT.

Bitte sehr erklär mir mal die Ergebnisse der aktuellen Generationenvergleichstest.

Die AMD-Karten, insbesondere die mit "mehr VRAM" als ihre jeweiligen Gegenparts altern eben DEUTLICH langsamer. Grund ist "mehr VRAM". Denn heute brauchts oft schon mehr als 4GB dass es gut läuft und die Rohleistung ist eben oftmals für FullHD selbst mit den 5 Jahre Alten Karten "ausreichend" wenn der VRAM eben nicht ausgeht!

Das eine 290x besser gealtert ist als 780Ti stimmt auch nicht.

Wenn beide OC sind und der Vram nicht zur bremse wird ist die karte auch heute noch sehr gut augestellt gegen 290X und verweist sie nicht gerade selten auf platz 2

Genau das ist aber oftmals eben das Problem - selbst 3GB VRAM werden eben heute mehr als oft zur Bremse:

Erkläre mir einfach mal bitte wie es zu den Ergebnissen des aktuellen CB-Benchmark Parcours kommt (im Vergleich zu den Releasetests):

GTX680 vs HD7970 (2GB VRAM vs 3GB VRAM):

Aus +9% werden -10% mit z.T. deutlichen einbrüchen in mehr als der Hälfte der getesten Games.

GTX 780 vs HD 7970 (3GB vs 3GB):

Aus +29% wurden in nur 5 Jahren nur mehr +19% Vorsprung....beachtlich und das obwohl BEIDE hier 3GB VRAM haben. Die 7970 hat also 10% "Defizit" aufgeholt.

Eine 780 Ti war im aktuellen Testfeld leider nicht mit drin - aber eine 780 können wir als "Referenz" mal nehmen. Eine 780 Ti hat genauso wie die 780 3GB VRAM.

Wenn der VRAM also "limitiert" bricht eine 780 genauso ein wie eine 780 Ti.

Also schauen wir mal:

780 vs R9 290X (3GB vs 4GB):

Die R9 290X ist Stand HEUTE also im SCHNITT 21% schneller - Zum Release waren es gerade mal 6% !

EDIT: Wir sehen in 1 Game stand heute geht eine 3GB Karte von damals einfach nur unter. In weiteren 3 sind die 3GB ebenfalls schon deutlich zu knapp und die Karte ist ~30% Langsamer als die 4GB 290X (die zu release ca gleichschnell war wie die 780). nur in 3 der Spiele ist die Performance noch in etwa so wie damals /EDIT.

Bitte sehr erklär mir mal die Ergebnisse der aktuellen Generationenvergleichstest.

Die AMD-Karten, insbesondere die mit "mehr VRAM" als ihre jeweiligen Gegenparts altern eben DEUTLICH langsamer. Grund ist "mehr VRAM". Denn heute brauchts oft schon mehr als 4GB dass es gut läuft und die Rohleistung ist eben oftmals für FullHD selbst mit den 5 Jahre Alten Karten "ausreichend" wenn der VRAM eben nicht ausgeht!