Hallo zusammen,

kurz die Ausgangssituation:

Meine Partnerin ist selbstständig und muss grundsätzlich auch von ihrer Arbeitsstelle aus auf die Daten zugreifen.

Aktuell ist es so gelöst, dass die Daten auf ihrem Laptop gespeichert sind und sobald sie sich zu Hause einloggt auf das NAS synchronisiert werden.

Grundsätzlich würde ich gerne bei ihrer Arbeitsstelle ein Offsite Backup , zumindest der sonstigen Daten, einrichten weiß aber nicht wie man das am besten angeht.

Wie würdet ihr das angehen?

Gruß

Fabian

kurz die Ausgangssituation:

- Proxmox System im heimischen Netzwerk mit 2x3 TB Datenplatten

- Netzwerkspeicher wird aktuell per einfacher SMB Freigabe von einer Debian VM, zu der die beiden 3 TB Platten durchgereicht sind, nur im heimischen Netzwerk bereitgestellt

- Großteil der Daten sind statische Mediendaten, ca. 400 GB sind sonstige Daten (Persönliche Daten, Backups der VMs/CTs etc.)

- Verlust der Mediendaten wäre verschmerzbar - die restlichen Daten sind wichtig

- VMs und Container werden alle drei Tage per Proxmox Snapshot gesichert

- Grundsätzlich greifen zwei Windows PCs auf das NAS zu, die von einer anderen Proxmox VM per UrBackup einmal die Woche gesichert werden

- Fritzbox 7490 zu Hause + 1&1 "Fritzbox" bei der Arbeitsstelle meiner Frau

- die zwei 3 TB Platten werden einmal monatlich auf externe Platten gespiegelt

- die Backups der VMs werden zusätzlich bei jedem Start auf meinen Desktop PC gesichert

Meine Partnerin ist selbstständig und muss grundsätzlich auch von ihrer Arbeitsstelle aus auf die Daten zugreifen.

Aktuell ist es so gelöst, dass die Daten auf ihrem Laptop gespeichert sind und sobald sie sich zu Hause einloggt auf das NAS synchronisiert werden.

Grundsätzlich würde ich gerne bei ihrer Arbeitsstelle ein Offsite Backup , zumindest der sonstigen Daten, einrichten weiß aber nicht wie man das am besten angeht.

Wie würdet ihr das angehen?

- ich möchte nicht mit externen Festplatten hin und her pendeln

- demnach müsste mein NAS über Internet erreichbar sein

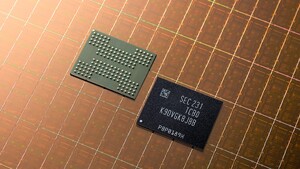

- was müsste bei meiner Frau für Hardware hingestellt werden? Reicht eine einfache SSD an der 1&1 Fritzbox oder lieber ein fertiges NAS?

Gruß

Fabian