refskegg

Lt. Junior Grade

- Registriert

- Mai 2021

- Beiträge

- 279

Hi Leute,

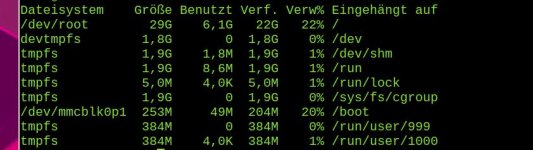

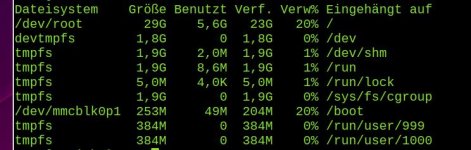

ich hab schon eine Weile meinen RaspberryPi 4 als Pihole mit local DNS im Heimnetz installiert. Funktioniert auch alles einwandfrei. Es läuft auf einer 32GB SD-Karte das Image von SemperVideo (SV-Pihole). Pi und Pihole sind auf neustem stand (gerade nochmal Updates durchlaufen lassen).

Was ich nur nicht verstehe ist, dass er mir ständig anzeigt (und das schon seit Monaten), dass mein Disk Shortage fast voll ist!? Ich hab schon diverse Workarounds, die ich so im Internet gefunden habe gemacht, aber nichts hat geholfen. Da ich mich nicht gut mir Linux auskenne, wüsste ich auch nicht, wo ich da jetzt ca. ansetzen muss oder was das überhaupt aussagt und welche Folgen das hat.

Vielen Dank schon mal.

ich hab schon eine Weile meinen RaspberryPi 4 als Pihole mit local DNS im Heimnetz installiert. Funktioniert auch alles einwandfrei. Es läuft auf einer 32GB SD-Karte das Image von SemperVideo (SV-Pihole). Pi und Pihole sind auf neustem stand (gerade nochmal Updates durchlaufen lassen).

Was ich nur nicht verstehe ist, dass er mir ständig anzeigt (und das schon seit Monaten), dass mein Disk Shortage fast voll ist!? Ich hab schon diverse Workarounds, die ich so im Internet gefunden habe gemacht, aber nichts hat geholfen. Da ich mich nicht gut mir Linux auskenne, wüsste ich auch nicht, wo ich da jetzt ca. ansetzen muss oder was das überhaupt aussagt und welche Folgen das hat.

Vielen Dank schon mal.