AT0 scheint eindeutig auf KI ausgelegt zu sein. Mehr Rohleistung, VRAM und Bandbreite sind genau das was dafür notwendig ist. Gaming profitiert teilweise auch davon, aber weniger. Mehr ALUs per CU dürfte die Auslastung beim Gaming senken, genauso wie der Wegfall des Infinity-Caches. Wenn aber nun hochpreisige KI-Karten und Gaming-Karten sich den selben Chip teilen, bekomen Gamer dadurch vielleicht etwas "mehr Chip für's Geld" als es bei einer reinen Gaming-Karte der Fall gewesen wäre. Das würde wohl auch den großen Sprung von AT0 zum nächstkleineren Chip erklären, denn die großen Varianten dürften für KI vorbehalten bleiben. Für Gaming gibt es dann Varianten mit 64-84 CUs mit 256-384Bit SI.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Radeon-Gerüchte: So könnten die Navi-5-Chips mit UDNA aussehen

- Ersteller DevPandi

- Erstellt am

- Zur News: Radeon-Gerüchte: So könnten die Navi-5-Chips mit UDNA aussehen

kristwi

Lt. Commander

- Registriert

- Sep. 2014

- Beiträge

- 1.099

Ich schaue Benchmarks von Computerbase keine Ahnung wo du schaust. 😂LikeHike schrieb:in BF6 wird die 9700XT deutlich geschlagen, in Hellblade 2 ebenfalls. Musst du dir deinen Kauf schönreden oder warum schreibst du sowas? Die 9700XT schlägt in der Regel nichtmal eine 5070 TI. Die hier zum Konkurrenten zur 5080 aufzubauen ist absurd.

In einigen neuen Spielen ist die 5080 gleichauf mit der 9070xt - ist so.

- Registriert

- März 2025

- Beiträge

- 660

Ebenfalls hier.kristwi schrieb:Ich schaue Benchmarks von Computerbase keine Ahnung wo du schaust. 😂

BF6 haben wir je nach Auflösung in Rasterizer Unterschiede von 7%, 18% oder 13%.

Man ist iemlihc genau gleichauf mit der 5070 TI, dem echten Konkurrenten.

Die 9070XT ist kein Konkurrent zur 5080. Ganz einfach. Es gibt immermal Ausreißer, diese sind aber genau das. Ausreißer.

Zuletzt bearbeitet:

Wichelmanni

Lt. Junior Grade

- Registriert

- Dez. 2008

- Beiträge

- 306

Ich weiss nicht. vor den Kopfstossen würde ich das noch nicht mal nennen. Manchmal ist es technologisch einfach richtig alte zöpfe abzuschneiden. Windows z.b. ist wa se sist, weil es das nicht konzequent genug tut. Es gibt Firmen die immer noch veraltete Win 95 Systeme laufen haben, weil es das ja noch tut. Das Sicherheitslücken, absolut veraltete Software usw ein Produktiv wie Sicherheits Problem darstellen, dass sieht man da nicht.NoNameNoHonor schrieb:Sehe ich auch so, Gerüchte sind möglich, aber müssen nicht wahrscheinlich sein.

Außerdem, da AMD RDNA3 Käufer durch die Nichtbenutzbarkeit von FSR4 (unter Windows) ziemlich hart vor den Kopf gestoßen hat, würde ich es mir dreimal mehr überlegen, überhaupt nochmal eine AMD Karte zu holen.

Und bei AMD ist es ekinfach möglich, dass ein Mitziehen der alten Karten das neue Segment nur ausbremst, weil man Resoucen in etwas steckt, was einfach nur gerade so Kompatible ist. Ich will jetzt nicht behaupten, dass es so ist, aber manchmal muss man veränderungen einfach komplett durchziehen um nach vorne zu kommen und altes alt sein lassen. Und mir ist es lieber AMD konzentriert seien resoucen nach vorne, statt auf die vergangenheit. Sonst sehe ich nicht wirklich die chance, dass AMD NVidia Markanteile abnimmt. Den der Neukunde entscheidet das und der will Entwicklung sehen um zum Kauf gebracht zu werden.

Das Argument kann man natürlich auch drehen udn sagen,. wer lange Supportet der ist interessanter für jemanden der lange die Grafikkarte hält, aber wenn das ingesammt die Entwicklung ausbremst, dann sehe ich das auch als benachteiligend für den Kunden.

Sun_set_1

Commodore

- Registriert

- Sep. 2008

- Beiträge

- 4.173

@LikeHike Die 9070XT ist ne Top-Karte, für den Preis. Aber kein genereller Konkurrent zur 5080.

Zur 5070 ti - und genau hier schlägt sie sich auch gut. Inwieweit die PT-Schwäche durch den Treiber und RR behoben werden kann bleibt abzuwarten, ich vermute aber dass hier noch was kommen wird. Das macht sie dann immer noch nicht zum 5080 Konkurrenten aber vllt final zum besseren Gesamtpaket als die 5070 ti.

Bedenkt man aber Stromverbrauch und DIE Größe muss man wirklich feststellen, dass AMD architektonisch näher an NVIDIA ist, als manche glauben mögen.

(Der DIE der 9070XT ist kleiner als der der 5070ti. Nicht viel, aber immerhin)

Zur 5070 ti - und genau hier schlägt sie sich auch gut. Inwieweit die PT-Schwäche durch den Treiber und RR behoben werden kann bleibt abzuwarten, ich vermute aber dass hier noch was kommen wird. Das macht sie dann immer noch nicht zum 5080 Konkurrenten aber vllt final zum besseren Gesamtpaket als die 5070 ti.

Bedenkt man aber Stromverbrauch und DIE Größe muss man wirklich feststellen, dass AMD architektonisch näher an NVIDIA ist, als manche glauben mögen.

(Der DIE der 9070XT ist kleiner als der der 5070ti. Nicht viel, aber immerhin)

Nighteye

Lt. Commander

- Registriert

- Okt. 2013

- Beiträge

- 1.511

Darf ich dich erinnern.Cabranium schrieb:Gerüchte die erst in ca 1,5 Jahre aktuell werden könnten

RDNA 2 kam 4Q 2020

RDNA 3 kam 4Q 2022

RDNA 4 war verspätet und wurde nachweißlich verschoben für einen stärkeren Launch.

Wenn wir Glück haben hat diese Verschiebung keine Auswirkungen auf den normalen Release Zyklus was die Entwicklung im Labor und Tapeouts angeht.

Also mit etwas glück haben wir ende 2026 schon die neue Radeon gen wie üblich.

Mit Pech 1Q 2027 da wäre ich dann bei dir das es nichts bringt jetzt viel zu Spekulieren.

Ja das Problem hatte AMD bei der Architektur vor RDNA.Limit schrieb:AT0 scheint eindeutig auf KI ausgelegt zu sein. Mehr Rohleistung, VRAM und Bandbreite sind genau das was dafür notwendig ist. Gaming profitiert teilweise auch davon, aber weniger.

GCN hieß diese. Und da hatte AMD ständig einen Driveroverhead und Probleme die Shader vernünftig auszulasten.

Folgen war: Eine Ineffizientere Architektur als Nvidia obwohl AMD fast ein Jahrzehnt lang versucht hat das beste daraus zu machen und alles zu Optimieren was geht.

Daher bin ich recht Spektisch was die neue Next gen Radeon betrifft.

@ElliotAlderson

Ich verstehe nicht wieso so viele die RTX 5080 hier verteidigen.

Nvidia ist schon Super Mega Ultra Reich, hat fast 90% Marktanteil richtiger GPU,s auf Steam.

Dein Username und Bild suggerieren mir dass du Mr.Robot (Elliot) magst.

Er war extrem gegen Großkonzerne. Also eigentlich müsstest du für den Underdog Radeon sein und nicht immer pro Nvidia

Wollt ihr keinen Gesunden Markt mit gesunden Konkurrenten für bessere Preise oder warum verteidigt ihr die Geforce Karten immer so vehement ?

Da sind mal 2 Benchmarks wo eine RX9070XT mit der RTX 5080 mithalten kann, und es wird sich aufgeregt.

Dabei ist das Thema doch klar.

Die Rohleistung der RTX 5080 ist natürlich überlegen.

Die RTX 5080 ist ein Monster mit viel mehr Recheneinheiten und schluckt dem entsprechend auch mehr.

Raytracing kann sie besser, aber bei sehr CPU Lastigen Spielen ist die RX9070XT schonmal ganz schön gut an ihr dran, vor allem in den 1% lows, wegen dem bekannten Nvidia Driveroverhead.

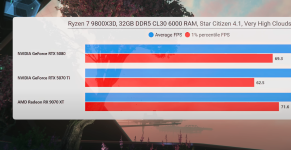

Es gibt wegen diesem Driveroverhead sogar beispiele wo die RX9070XT eine RTX 5090 schlägt. (Anhang 1)

Sogar in Star Citizen ist eine RX9070XT schneller in den 1% lows als eine RTX 5080 (Anhang 2)

Folglich ist die RX9070XT extrem viel besser in preis Leistung. Jeder vernünftige Mensch greift daher eher zur RX9070XT wie auch Mindfactory zeigt.

Für den normalen Zocker der auf das Geld achtet, macht die Radeon mehr Sinn.

Klar wenn man jetzt Bonze ist und nicht aufs Geld achten muss so wie viele Nvidia User hier, Go RTX 5080.

Oder gehört man zu Menschen die evtl mehr machen als nur Zocken (Game Design), oder ausgerechnet Spiele Zocken wo DLSS 4 notwendig ist und FSR 4 keine Option, ist Nvidia besser.

Aber für alle anderen reicht doch die Radeon locker und man spart viel Geld.

Für den Markt wäre es besser, wenn mehr Arcs und Radeons verkauft werden.

Gerade Arcs brauchen viel mehr Erfolg damit wir einen 3ten Konkurrenten auf den Markt bekommen.

Das ist besser für uns alle.

Anhänge

- Registriert

- Juli 2021

- Beiträge

- 3.798

Das Problem ist, dass für RDNA 5 / UDNA zwar nicht von AMD, aber durch die Gerüchteküche bereits vor einem Jahr die ersten "Gerüchte" aufkamen, dass AMD bei RDNA 4 nur noch mit den notwendigen Entwicklern weiter macht und RDNA 5 / UDNA priorisiert und diese damit "zeitiger" auf den Markt kommt. Hier war dann Anfang 2026 bis Mitte 2026 im Gespräch.gartenriese schrieb:Der Hype-Cycle für AMD fängt aber früh an dieses mal, die aktuelle Generation ist gerade mal ein halbes Jahr alt

Eigentlich hat AMD bereits die 12.288 ALUs schon bei RDNA 3 gehabt, weil hier die Vec32-ALUs zwei "Flanken" haben - Dual-Issue. Ein X und ein Y-Befehl können als VLIW2-Verpackt zur gleichen Zeit ausgeführt werden.zeedy schrieb:Naja das mit 12k ALUs glaub ich nicht.

Wenn UDNA die Dual-Issue-Fähigkeit behält, dann wären wir sogar bei 24.576 Shader. Gleichzeitig gibt es bei 96 CU mit 128/256 Shadern wieder ein Problem und das wäre die Anzahl an Tasks, die die GPU benötigt.

Wenn es bei den Vec32 bleibt, dann braucht jede CU 4 Wave32-Befehle, die ganze GPU am Ende 384 Tasks/Threads/Workgroups, nennt es wie ihr wollt. Klar, eine RTX 5090 ist da mit 680 solcher Gruppen noch weit voraus, nur die Auslastung wird damit schwerer. Wie gut das alles dann skaliert?

Jetzt kommt es halt darauf an, was AMD hier gemacht hat und wer was wie meint. Es gibt da ein paar Szenarien:zeedy schrieb:Wahrscheinlich sind WGPs gemeint, die ja quasi Dual CUs sind.

1. Baut AMD die WGP zu neuen CU um, wird es interessant, was sich alles von WGP zur neuen CU ändert. Es wird sehr schwer dann wirklich schon Leistungsprognosen zu machenb.

2. AMD benennt die WGP zu CU um, auf der Basis kann man zumindest hypothetische Spiele betreiben.,

3. Die Gerücht, dass die neuen CU 128 Shader haben sind falsch, auch dann kann man eine Prognose betreiben.

Es gibt noch einen weiteren Faktor, denn wir hier beachten müssen: N2 oder N3.zeedy schrieb:Mit 12k ALUs wäre die GPU irresponsibly fast wie Jensen sagen würde.

Käme der Chip in N3 oder N2, wäre es theoretisch durchaus möglich, dass AMD durchaus einen "großen" Chip umsetzt. Der GB202 hat grob 800mm², mit den üblichen Faktoren, dass die Dimensionen pro Achse um 30 % schrumpft. In N3 wären wir bei 400 mm² und 200 mm². ACHTUNG DAS IST EINE VEREINFACHTE RECHNUNG!

Ein fiktiver AT-0 mit 192 CU könnte also irgendwas zwischen 200 - 400 mm² haben, von der Chipgröße her würde das passen. NUR werden weder 400 mm² noch die 200 mm ² in N3 sowie N2 wirklich günstig. Bei dem, was aktuell an Kosten rumgeistert, wären die Kosten pro Chip ähnlich hoch wie bei N4/4N wie für die GB202. Ist jetzt allerdings nur Überschlagen! Also nicht so ernst nehmen.

Das Ziel einer RTX 5090 bei "zwei" Fertigungsschritten ist nicht unrealistisch. Ich finde das alles allerdings auch eher utopisch.

Steht und fällt mit dem Prozess.zeedy schrieb:Mindestens doppelt so schnell wie die 9070XT und damit viel schneller als die 5090. Bei den Leistungssteigerungen der letzten Generation ist von solchen Sprüngen nicht auszugehen, gerade in Relation zur Leistungsaufnahme.

Wobei man da schon sagen muss, dass das für die RDNA 4 durchaus ein Achtungserfolg ist, dass man so schnell ist wie die RTX 5060 Ti.DaHell63 schrieb:Hier ist die RX 9070XT doch fast so schnell wie eine RTX 5060Ti...

Ich bin an der Stelle gespannt, was mit Shader Model 6.9 da noch kommt und wie RDNA 4 von SER und OMM profitieren kann.

Wer allerdings Pathtracing-Titel spielen will und das auch bei 4K, sollte auf jeden Fall eine RTX 5070 Ti oder 5080 kaufen, kein aktuelles Wenn und Aber.

Wobei man an der Stelle sagen muss, gerade in Cyberpunk 2077 Pathtracing - im Gegensatz zur 7900 XTX - kein Ding der Unmöglichkeit für die RX 9070 XT ist. Gut, in 4K muss man bei FSR 4 dann "Ultra-Preformance" aus wählen, damit man 60 fps hat, jedoch kann man bei 1440p auf Balanced gehen.mesohorny schrieb:Vernünftiges Pathtracing (wie z.B. in CP2077) ist so mit das Erstaunlichste, was die letzten Jahre so kam, der Unterschied zu "normalem" Raytracing ist gewaltig und genau dort macht sich dann eine Nvidia Karte auch bezahlt.

Klar, RTX 5080/4090 sind da in 4K eher bei Balanced/Preformance - also eine bis zwei Stufen höher angesiedelt. Möglich ist es allerdings. Bildqualität dank des DLSS3.5 "Denoisers" kann ich jetzt nicht vergleichen. Die ist allerdings dank DLSS 3.5 besser. Kann nur kein Vergleich ziehen wie viel besser.

Nighteye

Lt. Commander

- Registriert

- Okt. 2013

- Beiträge

- 1.511

Das wäre ja mal eine Mega tolle überraschung. Ähnlich Positiv wie damals das schnelle folgen von RDNA 2 auf RDNA 1 innerhalb eines Jahres.DevPandi schrieb:AMD bei RDNA 4 nur noch mit den notwendigen Entwicklern weiter macht und RDNA 5 / UDNA priorisiert und diese damit "zeitiger" auf den Markt kommt. Hier war dann Anfang 2026 bis Mitte 2026 im Gespräch.

Würde dann auch erklären was die Ingenieure die ganze zeit gemacht haben zwischen 2022 und RDNA 4 Release 2025

Erklärt das auch diesen höheren Driveroverhead bei Nvidias High End Karten ?DevPandi schrieb:Gleichzeitig gibt es bei 96 CU mit 128/256 Shadern wieder ein Problem und das wäre die Anzahl an Tasks, die die GPU benötigt.

Wenn es bei den Vec32 bleibt, dann braucht jede CU 4 Wave32-Befehle, die ganze GPU am Ende 384 Tasks/Threads/Workgroups

eine RTX 5090 ist da mit 680 solcher Gruppen noch weit voraus, nur die Auslastung wird damit schwerer.

Ich hab schon geahnt das der Driveroverhead bei der neuen Radeon auch ansteigen wird.

So wie sich das bei deiner Erklärung liest, ist das wohl gesichert.

Also quasi CCN in Neu.

Sollte nicht so schlimm sein. TSMC ist ja dennoch günstig genug, das Nvidia noch extrem viel Umsatz macht, obwohl Nvidia jetzt nicht so viel teurer ist wenn man sich jetzt zb die RTX 5070ti preise anschaut.DevPandi schrieb:NUR werden weder 400 mm² noch die 200 mm ² in N3 sowie N2 wirklich günstig. Bei dem, was aktuell an Kosten rumgeistert, wären die Kosten pro Chip ähnlich hoch wie bei N4/4N wie für die GB202.

Also Radeon könnte trotz der Chip Kosten bessere Preis Leistung als eine RTX 5070ti anbieten ohne Verlust durch TSMC zu machen.

Mich wundert eher wieso 4nm noch so Teuer ist. Nvidia nutzt den Prozess ja schon seit 2022.

Wobei im Nachhinein, ist RDNA 4 jetzt garnicht so ein großer Wurf wie ich erst dachte.DevPandi schrieb:Wobei man da schon sagen muss, dass das für die RDNA 4 durchaus ein Achtungserfolg ist

Misst man den Fortschritt pur an der Effizienz.

Da war der Sprung RDNA 1 -> RDNA 2 größer.

Und der Sprung RDNA 2 -> RDNA 3 auch.

ThePlayer

Captain

- Registriert

- Aug. 2011

- Beiträge

- 3.874

Also wer das immer noch glaubt und jetzt drei Generationen in folge enttäuscht ist. Hat doch eh nicht mehr alle Tassen im Schrank.Dende236 schrieb:Oh man.. das kann doch, mit den Gerüchten, nur in die Hose gehen.

Schon wieder höher, schneller, weiter.

Und am Ende sind wieder alle enttäuscht, wenn's keine doppelte 5090 Leistung zum halben Preis geben wird🙄

Die Gerüchte klingen schon sehr spannend. Mal gucken was am Ende wirklich Sache ist.

Was mich interessieren würde wann diese neuen Chips kommen. Ende 2025 oder Ende 2026, oder irgendwann dazwischen?

Und was kommt dann von Nvidia? Werden die bei der Leistung einen Sprung nach vorne machen oder kommt da nur sowas wie RTX50x0???

Hoffe das AMD bei der nächste Generation Nvidia bis zur 6090 Paroli bieten kann.

Würde mir aber wünschen das Intel endlich mal aus dem Arsch kommt und wirklich als Konkurrenz gegen AMD und Nvidia auftritt. Man stelle sich vor drei Firmen die sich gegenseitig druck machen. Das würde sich sicherlich auch bei den Preisen bemerkbar machen.

Nighteye

Lt. Commander

- Registriert

- Okt. 2013

- Beiträge

- 1.511

DevPandi schrieb:"Gerüchte" aufkamen, dass AMD bei RDNA 4 nur noch mit den notwendigen Entwicklern weiter macht und RDNA 5 / UDNA priorisiert und diese damit "zeitiger" auf den Markt kommt. Hier war dann Anfang 2026 bis Mitte 2026 im Gespräch.

Eine Frage dazu an dich Pandi.Nighteye schrieb:RDNA 2 kam 4Q 2020

RDNA 3 kam 4Q 2022

RDNA 4 war verspätet und wurde nachweißlich verschoben für einen stärkeren Launch.

Wenn wir Glück haben hat diese Verschiebung keine Auswirkungen auf den normalen Release Zyklus was die Entwicklung im Labor und Tapeouts angeht.

Also mit etwas glück haben wir ende 2026 schon die neue Radeon gen wie üblich

Wenn nächsten Sommer (2026) die neuen Radeons kommen sollen.

Glaubst du der Rhythmus bleibt dann auch für die Zukunft ?

Also Quasi, RDNA 6 / UDNA 2 ab Sommer 2028 ?

Wäre ja hammer

Ich frage mich nur, wie das dann mit Nvidia sein wird.

Der Launch der RDNA 4 wurde ja absichtlich verzögert durch AMD damals. (Karten waren schon in Kartons usw)

Aber die RTX 5000 welche auch sehr viel später kam als normal, wurde ja nicht verzögert.

Denkst du Nvidia könnte es dennoch schaffen RTX 6000 schon nächsten Sommer zu bringen, oder eher wie üblich ende 2026 ?

(RTX 3000 2020, RTX 4000 2022, RTX 5000 hätte 2024 kommen müssen, kam aber erst 2025)

Dann hätte Radeon ein halbes Jahr zuerst neue Technik auf den Markt.

Würde Radeon gut tun.

ThePlayer

Captain

- Registriert

- Aug. 2011

- Beiträge

- 3.874

Aber wenn ich mir vorstelle das RDNA4 auch einen Bigchip mit 96 CUs hätte. Dann wäre doch locker mehr Leistung drin als eine 5080 bietet. Eventuell hätte es für die 5090 gereicht. bei UDNA1 oder wie die nächste Gen heißen soll, werden doch 96 CUs mehr als die 5090 leisten können.DevPandi schrieb:An die 5080 bei immer „neueren“ Spielen kommt die RX 9070 XT schon ran.

Die Leistung zwischen 5080 und 5090 für die nächste Generation halte ich für möglich. Eine RTX 5090 Killer für 1000 $ werden wir pessimistisch gesehen weder von AMD noch NVIDIA sehen.

Bin jedenfalls gespannt wie die nächste Gen bei beiden aussieht.

Du unterstellst hier also gezielter Betrug, ohne Beweise sagst du damit das es die Leute die ihm diese Informationen geleakt haben nicht gibt, bzw müsste ich bei der einen Info überhaupt schauen unter welchem grade an Sicherheit er es gepostet hat, er hat seine Infos bewusst gekenntzeichnet zwischen sehr "confident" und weniger...DevPandi schrieb:wenn MLID jhetzt da mit aufspringt, zeigt das mal wieder, das er sehr kreativ im erfinden war.

Aber ich finde es hart jemand ohne Beweise Betrug vor zu weisen, was soll er tun die Leaker doxen um zu beweisen das er echt von Leuten OEMs oder von AMD intern bekommen hat? Es kann ja sein das ihm auch Leute bewusst falsch infos geleakt haben... wobei ja 99% der Sacher die er gepostet hat wohl stimmen, das bei nem Leak nicht 100% der Infos stimmen werden ganz genau davon ist eh aus zu gehen.

Ich wäre vorsichtig Leuten (zumindest moralisch, da es keinen Geschädigten gibt vielleicht nicht juristisch) defakto Betrug vor zu werfen, da hätte ich dann doch gerne Beweise und der Beweis ist nicht ob seine Infos stimmen, der Beweis wäre wenn man nachweisen könnte das es keine Leaker gab die ihm diese Infos gaben.

Es gibt sogar einen Hinweiß darauf das er die Sachen geleakt hat er weiß ganz genau das so ähnlich wie bei ram man meistens Multiplicatoren wie 1,5 2x 2,5 etc hat weil man einfach doppelte Mengen von CCDs oder irgendwas benutzt.

Wenn er also ne Shaderzahl frei erfunden hätte mit den 154 wäre das zu dem nächstkleineren ein 2,40625 Faktor, da musst schon sehr kreativ sein sowas frei zu erfinden. Das deutet darauf das ihm jemand die Info so gegeben hat, das kein Beweis, aber ein Hinweis und ein Beweis das er lügt und frei erfindet gibt es gar nicht.

Zuletzt bearbeitet:

An der Stelle wollte ich die RX 9070XT nicht schlecht reden. Aber eine RTX 5080 zum halben Preis gibt es eben nicht...wie von manchen probangiert.DevPandi schrieb:Wobei man da schon sagen muss, dass das für die RDNA 4 durchaus ein Achtungserfolg ist, dass man so schnell ist wie die RTX 5060 Ti.

Da helfen Cherrys auch nicht weiter und wird dadurch wahrer.

Ansonsten muss man auch das RTX 5060Ti Beispiel zählen lassen.

Die Statistik ist Dumm, Nvidia kann nicht kontrollieren ob Leute z.B. in Singapur ne Grafikkarte oder 2 als Privatmensch kaufen oder um sie direkt nach China zu schicken...TheInvisible schrieb:Der "Fehltritt" beschert Nvidia gerade einen gaming Quartalsrekord...

Nighteye

Lt. Commander

- Registriert

- Okt. 2013

- Beiträge

- 1.511

Hier im Thread wurden schon locker 5 "Cherrys" gezeigt.DaHell63 schrieb:eine RTX 5080 zum halben Preis gibt es eben nicht...wie von manchen probangiert.

Da helfen Cherrys auch nicht weiter und wird dadurch wahrer.

Du musst zu geben, es ist schon etwas viel. Gerade bei CPU lastigen games, oder wenn man keinen 9800X3D hat, sonderen schwächere CPU,s kommt die RX9070XT immer öfter an die RTX 5080 ran, zumindest in den 1% lows.

Da gibts über 10 Beispiele die ich finden könnte. Und ich denke mal der Average RX9070 Käufer hat nicht unbedingt immer einen 9800X3D sondern auch mal einen R5 5600X oder R5 7600X oder 5700X3D oder gar alten Intel der 12th oder 11th Gen. Und da sehen wir ja sogar eine RX9070 ohne XT schon eine RTX 5090 überholend. (Siehe mein Bild Oben im ersten Anhang)

Ich übersetz deinen Text malblackiwid schrieb:

MLID ist hammer und wir Lieben ihn