Nighteye schrieb:

Erklärt das auch diesen höheren Driveroverhead bei Nvidias High End Karten ?

Die Thematik ist an der Stelle etwas komplizierter und es sind da auch zwei verschiedene Paarschuhe. Um die Problematik von GCN als auch jetzt bei der RTX 4090 und RTX 5090 zu verstehen, müsste man etwas tiefer in die Materie einsteigen.

Nighteye schrieb:

Nein, ich kann das an der Stelle nur sehr stark "vereinfacht" machen - es ist nur das Prinzip im Groben:

Jeder Pixel eines Bildes ist ein Thread auf der GPU. Diese Pixel/Threads kannst du anhand bestimmter Informationen zusammen fassen, zum Beispiel anhand des Shaders (Programm), so werden die Threads gruppiert und diese Gruppen werden auf der GPU ausgeführt. Nvidia mag Gruppen von 32, AMD jetzt auch, davor waren es Gruppen von 64.

Um die GPU also perfekt auszulasten, müssen genug solcher Gruppen zusammen kommen. Du brauchst also bei einer RTX 4090/RTX 5090 bei 128/170 SM pro SM 4 dieser Gruppen, damit die Karte "perfekt" ausgelastet wird.

Das ist etwas anderes als ein Treiber-Overhead. Und noch mal: Das ist jetzt massiv vereinfacht und soll nur das Grundproblem veranschaulichen!

Nighteye schrieb:

Glaubst du der Rhythmus bleibt dann auch für die Zukunft ?

Also Quasi, RDNA 6 / UDNA 2 ab Sommer 2028 ?

Ehrlich: Keine Ahnung. Kann sein, muss nicht sein.

blackiwid schrieb:

Du unterstellst hier also gezielter Betrug,

Nein, ich unterstelle keinen gezielten Betrug, es ist allerdings interessant, was manche Menschen hinein interpretieren.

blackiwid schrieb:

ohne Beweise sagst du damit das es die Leute die ihm diese Informationen geleakt haben nicht gibt

Auch das habe ich nicht geschrieben. Die Frage ist nur, welche Informationen haben MILD, Kepler und Co aus ihrer Quelle bekommen und was ist Interpretation von Ihnen und welchen Wissenstand wird darauf angewendet und wird auch was falsch interpretiert.

Das ist genauso, wie ich jetzt Leistungseinschätzungen für eine fiktive 10080XT vornehme und überlege wo sie landen könnte. Das passiert Anhand der Informationen, die bekannt sind und das was man noch dazu interpretieren muss.

Und hier kommt jetzt noch dazu, dass jetzt sogar jemand drittes - hab ich das jetzt richtig mit bekommen - versucht die Leaks von Kepler und MLID in Einklang zu bringen und warum die beiden doch irgendwie stimmen und beide Recht haben.

Ob das jetzt alles stimmt, werden wir eh erst wissen wenn es kommt. Rein fiktiv

DaHell63 schrieb:

An der Stelle wollte ich die RX 9070XT nicht schlecht reden. Aber eine RTX 5080 zum halben Preis gibt es eben nicht...wie von manchen probangiert.

Da helfen Cherrys auch nicht weiter und wird dadurch wahrer.

Ansonsten muss man auch das RTX 5060Ti Beispiel zählen lassen.

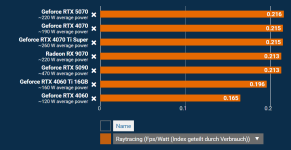

Ich hab dir doch gar nicht unterstellt, dass du die RX 9070 XT damit schlecht redet. Nur angemeckert, dass es für die RX 9070 XT ein Erfolg ist, dass man hier mit auf dem Level der 5060 Ti ist und dass Pathtracing in Cyberpunk 2077 auf der 9070 XT sogar "möglich" ist, im Gegensatz zur 7900 XTX davor.

DaHell63 schrieb:

Da helfen Cherrys auch nicht weiter und wird dadurch wahrer.

Im Endeffekt kommt es bei sowas am Ende auch immer auf die Spiele- und Szenenauswahl an und welches Bild man da erzeugen will.

Dazu - Achtung, rein hypothetisch - kommt es halt auch, wie sich vielleicht modernere Spiele mit der Zeit ab jetzt verhalten. Es kann sein, dass RDNA 4 die neusten UE5-Iterationen besser liegen als Blackwell und daher die RX 9070 XT in den Spielen stärker abschneidet, während man bei anderen Spielen hinten an liegt.

Wer dann immer die neusten UE5-KRacher spielt, könnte dann mit der RX 9070 XT besser bedient sein. Wer wiederum PT-Spiele spielen will, greift dann besser zur RTX 5080 zur Zeit.

Und am Ende: Für ein umfassendes Bild einer Karte, sollte man eh immer mehr als ein Benchmark betrachten.

Quidproquo77 schrieb:

Es geht vielmehr um die ständige Pauschalisierung zu Blackwell, denn rein die Fakten betrachtend müsste man RDNA4 als "Fehltritt" interpretieren, denn insgesamt ist man bei Featureset, Leistung, Effizienz ja weiterhin unterlegen, lediglich nicht mehr so viel wie damals.

Echt jetzt? Dein ganzer Beitrag und deine Aufregung funktioniert an der Stelle nur, wenn du das Wort "enttäuschend" durch "Fehltritt" ersetzt und damit eine vollkommen andere Diskussionsebene startest. Und selbst da kann man noch genug Interpretationen auf machen. Bist du es nicht, der sich oft - und teilweise auch zurecht - über fehlende Differenziertheit aufregt und eigentlich ein vollumfängliches Bild erwartet?

Über die psychologischen Hintergründe zu Markentreue und Co fange ich an der Stelle nicht an, das würde jetzt den Kontext final sprengen.